虚实融合技术是视频增强三维虚拟地理场景的关键环节之一[1-3],对于减少GIS虚拟场景和真实视频图片间视觉差异,实现视觉感官虚实无缝结合,并提高真实沉浸式视觉体验具有重要作用[4-6]。

近年来,国内外学者对视频与三维虚拟场景的融合方法进行了大量的研究,主要分为基于视频投影的虚实融合方法[7-9]、基于视频图像变形的虚实融合方法[10]以及基于视频图片重建的虚实融合方法[11]3大类。其中,基于视频投影的虚实融合方法因无须人工干预和离线融合[12]、不需为被投影的纹理预先指定顶点纹理且场景还原真实度高等优势[13-14],成为三维场景虚拟融合中最常用的方法[15-16]。文献[17]提出以实时视频流作为纹理投影到模型上的方法,使用纹理映射方法计算模型表面的颜色;文献[8]基于纹理投影思想,提出了增强虚拟环境(augmented virtual environment, AVE)系统。考虑到视频投射到三维虚拟场景建筑物时,未顾及建筑物之间的遮挡,导致视频图像投到目标建筑后面其他物体的问题,文献[1]对投影纹理算法改进,提出了顾及场景深度的投影纹理算法,即首先遍历场景,选择需融合的渲染对象,然后进行视频与场景的融合。该方法极大提升了融合效果,使视频图像更真实的融入三维虚拟场景。基于该方法,文献[2]提出基于GIS的视频监控体系结构,并在AVE系统的基础上提出了视频图像与三维模型表面纹理的透明度融合。

已有基于视频投影的虚实融合方法,在三维场景动态漫游时,通常需要对用户视角下场景内所有渲染对象进行遍历,来筛选出需要与拍摄视频进行融合的对象(以下简称融合对象)。一般来说,用户视角下渲染对象的数量可达几百到几千个不等,因此依次遍历渲染对象导致融合过程耗时长、效率不高,如文献[2]提出视频投影方法适用于最多包含4~5个视频的三维场景虚拟融合。为此,本文提出了一种顾及拓扑关系的多路视频与三维GIS场景融合的对象快速确定方法,通过建立视频与三维场景的拓扑关系模型,有效提高融合对象的快速定位及其融合效率。

1 相关工作基于视频投影的虚实融合方法是指利用投影纹理技术将视频帧图像投影到三维场景中[18],类似于在三维GIS场景中添加一个幻灯片投影仪,使用框架地理参考信息对其进行定位和定向,然后将图像投影到场景中的对象上[19]。文献[2]充分考虑三维场景建筑物遮挡等问题,改进投影纹理算法,提出了顾及场景深度的投影纹理算法。融合视频与三维GIS场景的流程主要分为两个步骤:①摄像头拍摄范围内,场景中需融合渲染对象的确定;②三维场景中视频图像的投影[20]。

在第1步确定摄像头拍摄范围内场景中的融合对象时,囿于已有方法不记录视频相机与场景中渲染对象的拓扑模型信息,当三维场景动态变化时,无论视角范围内新场景与上一个场景有无重叠,均须重新遍历并计算新视角场景内每一个视频相机与场景中渲染对象的拓扑关系,从而完成深度纹理的更新。而一般新场景用户视角下渲染对象的数量可达几千不等,每一次场景的变化均需重复上述遍历过程,导致现有方法整体处理过程计算代价昂贵、耗时长、效率差。

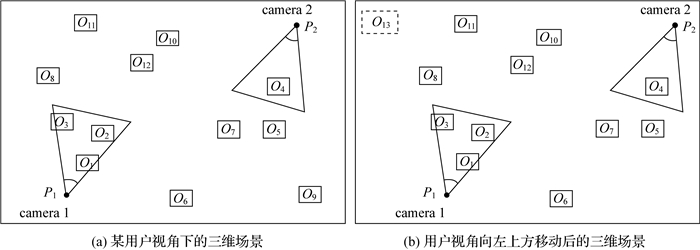

如图 1所示,camera 1与camera 2分别为两个真实世界摄像头设备在三维虚拟场景中对应的视频相机对象,O1—O13为场景中所有需要被渲染对象,其中O1—O4为需要与摄像头拍摄视频融合的对象。现有方法中,由于camera 1与camera 2没有与三维场景中的渲染对象建立拓扑关系模型,当用户视角由(a)场景动态变化至(b)场景时,将无法得知摄像头camera1和camera2要融合对象是否发生变化。此时,虽然场景中视频相机对象camera1和camera2可见范围内的渲染对象均未发生变化,但现有方法中并没有一种机制能将这个结果告知视频相机对象,导致必须重新依次遍历场景(b)中所有的渲染对象与视频摄像头拍摄范围的空间关系,即O1—O8及O8—O13所有渲染对象与两个视频相机的拓扑关系(如图 1所示),筛选出拍摄范围内需融合对象。假设判断一个对象与视频相机空间关系的时间为T,即使场景动态变化时需进行融合的对象与上一帧场景没有变化,且仅有O13为新加入场景的对象,但现有方法仍需要耗费2×12×T的时间去确定要融合的对象。面对真实场景中的几百甚至几千个渲染对象时,其计算代价及时间成本更高。

|

| 图 1 用户视角移动的三维场景 Fig. 1 Illustration of a 3D scene in which the user's FOV is moving |

2 一种多路视频与三维GIS场景融合的对象快速确定方法

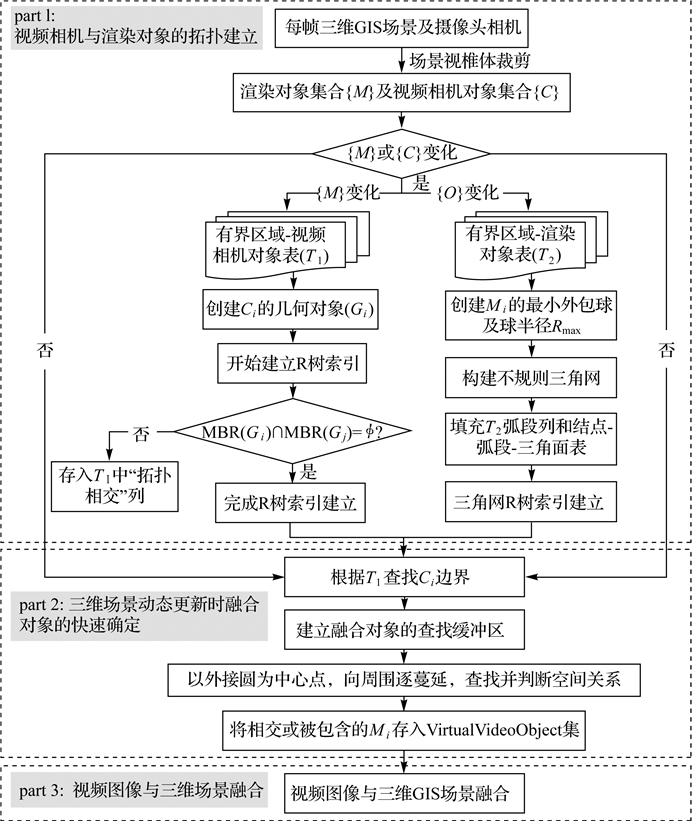

提升摄像头视频与三维GIS场景的融合效率,关键在于渲染融合对象的快速确定。本文首先基于GIS视频监控体系结构及顾及场景深度的投影纹理算法[2],借鉴空间网络模型理论,分别对视频相机对象、渲染对象两类数据构建准确描述数据之间拓扑特征的空间模型;然后在构建两类数据拓扑特征的前提下,运用拓扑关系和场景视锥体动态裁剪剔除相结合方法,降低视频对象拍摄范围内融合对象的筛选时间,从而实现快速融合。与文献[2]的方法相比,在三维场景动态加载时,本文通过R树索引构建了被渲染对象与视频相机的拓扑模型,保证三维GIS场景与监控影像的实时与快速高效融合。图 2为本文快速融合方法的流程图,主要步骤包括3部分:①视频摄像头与渲染对象的拓扑建立;②三维场景动态更新时融合对象的快速确定;③视频图像与三维场景融合。

|

| 图 2 本文方法流程 Fig. 2 Flowchart of the proposed method |

2.1 视频摄像头与渲染对象的拓扑建立 2.1.1 拓扑关系模型表达

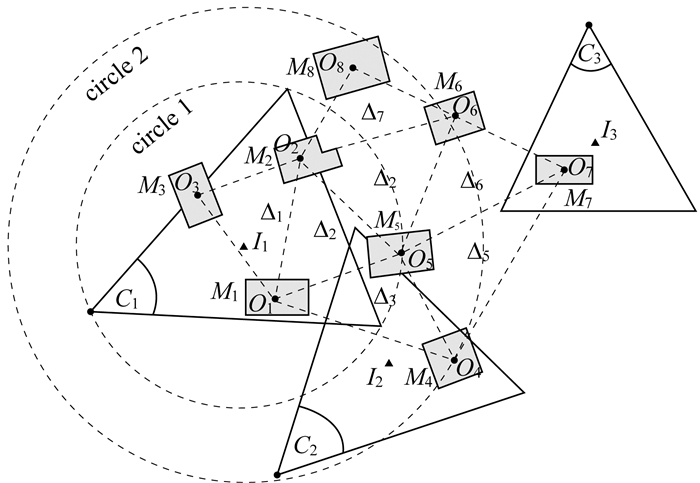

本文通过增加视频相机对象和渲染对象拓扑信息,实现利用拓扑关系加快二者的空间拓扑关系判断。根据研究对象特征及空间网络模型理论,将空间区域划分为有界空间和联系通道两种类型[21],其中视频相机对象及场景内建筑物等属于有界空间,视频相机、渲染对象在空间中的联系可视为联系通道。视频相机、渲染对象各自组成的拓扑网络与交通道路网有着众多相似之处。借鉴地理信息系统中的拓扑网络原理,可将空间中的联系通道抽象为空间弧段,有界空间退化为点,形成由弧段和结点组成的网络模型,如图 3所示。

|

| 图 3 空间拓扑要素类型 Fig. 3 Schematic diagram of spatial topology element types |

点元素主要用于描述网络模型上的结点,由有界空间退化而成,应用时可由有界空间的边界信息获得,在场景中渲染对象与视频图像融合时可代表有界空间,如图 3中的C1(视频相机对象)和M1(场景渲染对象)。

弧段元素是指结点与结点之间的连接线,按照一定规则将所有结点连接并组成一个拓扑网络模型,主要作用是能够快速查询到拓扑网络中某一结点的周围结点信息。

视频相机拓扑网络和渲染对象拓扑网络都是由点、弧段所组成,因此网络拓扑关系可表示为以下方面:

(1) 包含关系。包含关系表达了结点、弧段之间的包含关系,主要有:①视频对象结点代表的有界区域包含渲染对象拓扑网络中的一个或多个结点,如图 3中的C1与M1;②渲染融合对象结点代表的有界区域包含视频对象结点,一般情况下,摄像头拍摄范围比某一三维物体的空间范围要大,因此,该类包含关系很少出现。

(2) 相交关系。相交关系表达了结点、弧段之间的相交关系,主要有:①视频对象结点代表的有界区域与渲染对象拓扑网络中的一个或多个结点代表的有界区域相交,如图 3中的C1和M2、M3;②视频对象结点代表的有界区域与另一视频对象结点代表的有界区域相交,如图 3中的C1和C2。

(3) 结点与弧段的关联关系。弧段是由两端的端点(即结点)连接而成,表达了结点与哪些弧段相连接,如图 3中的弧段M1—M2,其关联关系中蕴含了网络拓扑关系。

2.1.2 视频摄像头与融合对象的拓扑关系模型动态构建依据上述拓扑关系模型的表述,将视频相机对象退化为结点,并将每个孤立的结点按照网络拓扑规则进行自动连接,分别形成视频相机拓扑网络和渲染对象拓扑网络。

以图 3为例,空间拓扑关系可以表达为:

(1) 有界区域-视频相机对象表。有界区域具体是指摄像头拍摄范围,一般将其简化为一个二维平面的三角形,如图 3中的对象C1。有界区域仅包含一个由该有界区域退化成的结点。表 1表达了有界区域和结点的这种关系,同时还记录了实体与结点的关联、与该结点属于拓扑相交关系的结点。

| 视频相机实体 | 有界区域 | 结点 | 边界信息 | 拓扑相交 |

| VideoObject1 | C1 | I1 | ∂C1 | C1, C2 |

| VideoObject2 | C2 | I2 | ∂C2 | C1, C2 |

| VideoObject3 | C3 | I3 | … | … |

(2) 有界区域-渲染对象表。有界区域具体是指渲染对象的轮廓,一般是不规则多边形,如图 3中的一个建筑物对象M1。对于细长形状的道路,按照一般建筑物的长度或宽度将其逻辑分割为几个部分,也就是一个道路实体对象可能对应多个有界区域。有界区域仅包含一个由该有界区域退化成的结点,表 2表达了有界区域和结点的这种关系。

| 渲染对象实体 | 有界区域 | 结点 | 边界信息 | 弧段 |

| RenderObject1 | M1 | O1 | ∂M1 | (O1, O2), (O1, O3), (O1, O4),(O1, O5), … |

| RenderObject2 | M2 | O2 | ∂M2 | (O2, O1), (O2, O3), (O2, O5), (O2, O6), (O2, O8) |

| | | | | |

(3) 结点-弧段-三角面表。如表 3所示,一条弧段由两个结点连接而成,而一个结点有可能与多个弧段相连,如表 2所示,与结点相连接的弧段明确了该结点相邻的结点。弧段-三角面:一个三角面由三条弧度连接而成,即一条弧段组成一个或多个三角面。

三维场景动态漫游时,场景视椎体内的视频相机对象或渲染对象也是在不断变化的。本文依据上述表达的空间拓扑关系及关联关系,将分别建立动态的场景视锥体内渲染对象和视频相机对象的拓扑网络模型。

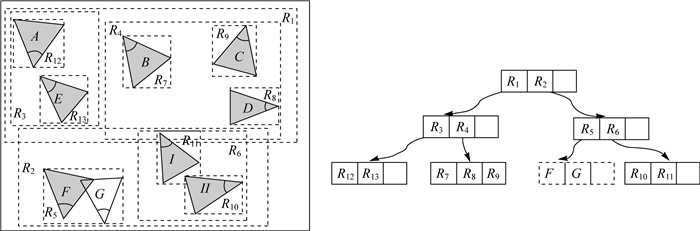

(1) 视频相机对象的拓扑模型构建。首先,通过有界区域-视频相机对象表获取边界信息∂C,根据多边形边界信息建立几何体对象;然后,统一对这些几何对象建立R树索引(图 4),主要利用目标空间对象的最小外包矩形插入至R树结构中完成快速的空间分割,在插入过程中,判断最小外包矩形是否重叠,重叠则进一步找出边界重叠的几何体对象(如图 4中视频相机VideoObjectf和VideoObjectg的几何体对象F和G)[22],也就是说若一个索引方格中存在两个不可分割的几何体对象,则对应的视频相机对象互为拓扑相交(Cf∩Cg),填充到有界区域-视频相机对象表(表 1)拓扑相交列中。

|

| 图 4 摄像头实体分布及R树索引构造 Fig. 4 Video object distribution and R-tree index construction |

(2) 渲染对象的网络拓扑模型构建。首先,创建所有的渲染对象的最小外包球,得到其中最大的外包球半径Rmax;然后,按照距离排序法构建不规则三角网,并将与结点关联的弧段填充到有界区域-渲染对象表(表 2),将不规则三角网中的结点、边、三角面填充到表 3中;最后,以三角面为单元对整个不规则三角网进行R树索引构建。

此外,三维场景动态漫游的情况下,为了保证场景视锥体内视频相机对象和渲染对象的拓扑关系模型的正确性和实时性,需分别统计当前帧的视频相机对象、渲染对象与上一帧相比的变化,若发生变化,则重新建立拓扑网络模型。

2.2 三维场景动态更新时融合对象的快速确定本文试图通过建立动态拓扑网络模型来快速查询三维场景视锥体内与视频相机相交或被包含的渲染对象,从而提高三维场景与视频的融合效率[23-24]。因此,与文献[2]的融合方法不同,本文方法在融合前会根据视频相机对象和渲染对象的拓扑网络模型,快速确定视频相机拍摄范围内的渲染对象,即融合对象。在定义视频对象的数据结构时,存储其拓扑相关的渲染对象及信息。伪代码描述如下:

ClassVirtualVideoObject

{

double x, y, z; //位置

double title, roll, head; //姿态

doublenear, far; //可见范围

TopologyNode*node; //拓扑网络模型中的结点

void*pRenderObjects[]; //融合对象集合

}

依据文献[25]空间理论的区域关系,融合对象的快速确定主要步骤如下(见图 3):

(1) 依次遍历场景视锥体内视频相机对象为当前视频对象(VideoObjecti),并获取其对应拓扑模型的结点信息(Ci)。

(2) 根据有界区域-视频相机对象表,确定VideoObjecti的边界信息∂Ci。为保证查找的完整性,以∂Ci的外接圆(如图 3中circle 1)半径与Rmax之和作为查找融合对象的缓冲区(如图 3中circle 2)。设已完成融合对象确定的视频相机结点Cn(Cn内部记为Cno),若Ci与Cn为相离关系,则Cn拓扑包含的融合对象(记为{M}∈Cio)必然不会被Ci包含,公式表达为({M}∈Cio)∀(┐C(Ci, Cn))⇒{M}∉Cno。

(3) 根据空间一致性原则,利用渲染对象构成的拓扑网络模型和R索引,快速查询缓冲区中心点Pi所在的三角面,然后以该三角面为中心向周围逐阶蔓延,基于结点-弧段-三角面表和有界区域-渲染对象表,依次获取三角面上结点的边界信息,并与相机对象的边界信息进行空间关系判断。

(4) 判断视频相机对象Ci与渲染对象Ms的空间关系。若Ci的融合对象集{M}(可能是已存储记录的信息)中存在Ms,则跳过,继续判断下一个渲染对象。若Ci与Ms包含或相交(Ms∈Cio∨Ms∩Cio),则确定Ms为融合对象。同时,在完成三角面的3个结点判断后,继续其周围一阶邻居的判断;若某三角面上所有的渲染对象与视频相机对象均相离,则停止判断该三角面的一阶邻居。

(5) 依次判断,直到所有空间拓扑关系判断停止,表明该视频相机对象完成融合对象的确定;然后将所有的融合对象{M}存储记录到该视频相机对象的VirtualVideoObject中,供下一步的视频图像与三维GIS场景融合渲染使用。

2.3 视频图像与三维GIS场景的融合在建立和更新视频对象后,视频图像与三维GIS场景进行融合渲染,主要包括两个步骤:视频相机遮挡测试与视频图像与场景融合,视频帧图像以投影纹理的方式与点、线、面、地形、模型等渲染对象在着色器中融合渲染。本文的主要创新点在于融合对象的快速确定,且基于投影纹理的融合法研究相对成熟,以下将简要描述融合对象选取后与三维GIS场景的融合。

对于视频相机作遮挡测试,依据视频对象中存储的监控摄像头的位置、姿态(方位角、俯仰角、翻滚角)、最近可视距离、最远可视距离等参数,创建一个属于视频对象的深度相机。其中深度相机下挂载的渲染对象集合全部来源于本文方法已构建好的视频对象虚拟小场景。由于三维GIS虚拟场景的动态调度和漫游导致虚拟小场景中渲染对象不断变化,深度相机下挂载的渲染对象也会随之变动,但当虚拟小场景不存在更新时,本文方法中深度相机不需要作遮挡测试。

视频图像与场景融合时,为达到视频增强三维GIS场景的目的,除了将场景中的渲染对象(点、线、面、地形、模型等)的顶点、法线、静态纹理等数据传递给渲染流水线外,还应将相交或被包含视频对象的深度图、掩膜纹理、视频纹理等资源一并传递给着色器[26],并最终在着色器中利用投影纹理算法合成融合结果。

3 试验与分析 3.1 试验数据与环境依托中国测绘科学研究院研制的NewMap软件平台,嵌入本文提出的顾及拓扑关系的多路视频与三维GIS场景的快速融合方法,以滕州市市区的地形、模型及监控视频数据为例对本方法进行效果验证。其中,高程数据来源于SRTM,经纬度范围为(35.023 55°N—35.127 44°N,117.078 35°E—117.203 68°E),水平分辨率为90 m,竖直分辨率为0.1 m。影像数据来源于国际科学数据服务平台陆地卫星(Landsat)遥感影像数据,区域内的模型数据为人工精细建模以及单体化后的倾斜摄影模型,总数据量为8.20 GB。该区域共有监控视频1269个,其中在100 m2范围内有5个及以上监控视频摄像头聚集的区域为46个。试验的硬件环境为CPU E3-1535M v5 @ 2.90 GHz,内存16.0 GM,显卡NVIDIA Quadro M2000M。图 5为部分三维GIS场景中与视频的融合效果图。

|

| 图 5 融合效果可视化 Fig. 5 Visualization of video fusion result |

3.2 试验结果与分析 3.2.1 效率验证

为验证本文方法在视频与三维GIS场景融合时的效率,设置多条步行漫游路线(其中,步速为1.5 m/s,步幅为0.65 m),开展本文方法与文献[2]方法在同一环境下的融合耗时对比分析。文献[2]建议三维GIS场景中被同时渲染的视频数量应限制在4~5以内。因此,本文设置固定监控摄像头数量为1、3、5的3条漫游路线,对比随着三维GIS场景不断变化,本文方法与已有方法视频与三维场景融合耗时,结果见表 4。

| 摄像头数量 | 漫游时刻/s | 融合对象数量 | 视野内渲染对象数量 | 耗时对比/ms | 效率提升/(%) | |||

| 融合对象筛选耗时 | 融合总耗时 | 融合对象筛选耗时 | 总耗时 | |||||

| 1 | 0.0 | 140 | 991 | 6.871 | 14.624 | 6.871 | 14.624 | 0.00 |

| 2.0 | 153 | 2114 | 0.568 | 17.473 | 10.382 | 27.287 | 35.97 | |

| 4.0 | 68 | 1628 | 0.197 | 15.325 | 8.360 | 23.488 | 34.75 | |

| 6.0 | 216 | 1135 | 1.035 | 14.364 | 6.105 | 19.434 | 26.09 | |

| 8.0 | 101 | 653 | 1.582 | 10.630 | 4.775 | 14.994 | 23.15 | |

| 3 | 0.0 | 382 | 1055 | 11.052 | 21.745 | 24.630 | 35.323 | 38.44 |

| 2.0 | 257 | 863 | 1.390 | 13.521 | 22.405 | 34.536 | 60.85 | |

| 4.0 | 630 | 1206 | 1.027 | 16.562 | 24.995 | 40.530 | 59.14 | |

| 6.0 | 459 | 1328 | 4.176 | 17.812 | 25.630 | 39.266 | 54.64 | |

| 8.0 | 485 | 967 | 9.005 | 18.253 | 22.631 | 31.880 | 42.74 | |

| 5 | 0.0 | 364 | 713 | 6.105 | 15.503 | 25.047 | 34.445 | 54.99 |

| 2.0 | 392 | 1100 | 2.108 | 17.420 | 28.300 | 43.612 | 60.06 | |

| 4.0 | 453 | 921 | 2.635 | 16.841 | 26.502 | 40.708 | 58.63 | |

| 6.0 | 286 | 1315 | 1.415 | 19.249 | 31.620 | 49.454 | 61.08 | |

| 8.0 | 501 | 1084 | 2.370 | 18.054 | 26.271 | 41.955 | 56.97 | |

表 4中,针对摄像头数量一致,但三维GIS场景中对象数量不同的情况,其融合对象筛选耗时统计如图 6所示。由图可以明显看出,在场景中视频摄像头数量固定的情况下,随着三维GIS虚拟场景中渲染对象的增加,文献[2]方法在遍历筛选融合对象的耗时、融合总耗时均与场景内渲染对象数量呈显著正相关,而本文方法所用时间与场景中所有对象个数无关,耗时较为均衡,在整体融合效率上均显著高于现有方法。

|

| 图 6 现有方法与本文方法融合耗时对比 Fig. 6 Time consuming comparison between the existing method and the proposed method |

由表 4和图 6可以看出,在三维GIS场景内渲染对象大致相等时,文献[2]方法在遍历筛选融合对象的耗时,随着视频摄像头数量的增多而增加,而本文方法所用时间与摄像头数量无关,耗时较为均衡,效率较高。表 4中效率提升值表示为现有方法融合耗时与本文方法耗时的差值与现有方法融合耗时的比值。可以明显看出,本文方法在整体融合效率显著高于文献[2]方法,当视频摄像头数量分别为1、3与5时,融合效率分别平均提高24%、51%与58%,最高可达60%,充分说明了三维场景中摄像头越多,场景越大,本文方法的优越性越显著。

3.2.2 优越性效率验证当摄像头超过5个以后,文献[2]方法融合效率难以适应,而本文方法融合效率优越性明显。在同一环境下的对比结果见表 5。

| 摄像头数量 | 本文方法筛选融合对象耗时/s | 本文方法融合帧率/(帧/s) | 传统方法筛选融合对象耗时/s | 传统方法融合帧率/(帧/s) |

| 6 | 9.413 | 37 | 43.325 | 18 |

| 8 | 13.835 | 29 | 56.240 | 13 |

| 10 | 19.500 | 20 | 69.356 | 10 |

在有视频融合时,三维场景的漫游帧率一般为20~60帧/s,由表 5可知,当视频摄像头数量大于5时,在三维GIS场景动态更新漫游时,现有方法的融合帧率均低于20帧/s,低于正常的漫游速率,当摄像头为10个时,现有方法融合帧率仅为10帧/s,而本文方法直至在摄像头数量达到10时,其融合帧率为20帧/s,与正常漫游帧率相等,可见本文方法相较于现有方法,可高效适用于三维GIS场景中不超于10个视频摄像头的情况。

为更直观地显示本文方法的优越性,对现有方法与本文方法在漫游(漫游环视某6个摄像头的区域)过程固定时刻的融合效果进行可视化对比,如图 7所示。

|

| 图 7 同一时刻下现有方法与本文方法融合效果可视化对比 Fig. 7 Visual comparison between the results of the proposed method and the current method at the same time |

由图 7可知,在同一时刻下,相比现有方法,本文方法可更快地进行视频与三维GIS场景的融合。如图 7(b)所示,在漫游时刻为3.5 s时,本文方法可对三维GIS场景中的6个视频摄像头完成虚实融合,而现有方法仅完成了3个视频与三维场景的融合,充分证明了本文方法在融合效率的优越性。

3.2.3 稳健性验证综上所述,均证明了在正常路径漫游时,本文方法在遍历筛选融合对象及整体融合效率均显著优于现有方法。但这主要是由于在正常漫游过程中,三维场景的变化是具有连续性和过渡性,新三维场景相比上一帧场景会有比较多的重复对象,使得新增加需要处理的对象较少,因此本文方法比现有方法效率高。但若用户突然转换视角,新场景下大多数渲染对象都是新加入场景可见范围的,本文方法是否不适用或效率低于现有方法。为验证方法在极端情况的稳健性,选取具有5个摄像头的区域对融合耗时进行对比,结果见表 6。

| 场景对象数量 | 场景中更新的对象数量 | 需融合对象数量 | 本文方法融合耗时/ms | 现有方法融合耗时/ms |

| 640 | 628 | 135 | 30.623 | 33.526 |

| 895 | 830 | 116 | 35.705 | 41.692 |

| 1260 | 1227 | 214 | 43.158 | 48.763 |

由表 6可知,即使在出现视角骤变的极端情况,场景中需更新的对象与场景中对象数量相似,本文方法在融合对象筛选及融合总耗时上仍略优于现有方法,充分证明了本文方法在视频与三维GIS融合的稳健性。

4 结论与讨论现有基于视频投影的虚实融合方法,在三维场景动态更新时,囿于需要对用户视角下新场景内所有渲染对象进行遍历,存在摄像头范围内需融合对象查找获取效率较差,导致融合过程耗时长、计算代价高等问题。为此,本文提出了一种顾及拓扑关系的多路视频与三维GIS场景融合的对象快速确定方法,通过建立视频与三维地图的拓扑关系,以及与视频拓扑相关的三维虚拟小场景,在融合时无需对视角范围内每一个对象进行依次遍历,有效提高快速融合的效率。通过试验验证和对比分析,可得出结论如下:

(1) 本文方法查找需融合对象消耗的时间与三维场景中所有渲染对象和摄像头数量无关,耗时较为均衡,整体融合效率均显著高于现有方法,且三维场景中摄像头与场景渲染对象越多,本文方法在视频与三维GIS场景融合的优越性越显著。

(2) 突破现有方法摄像头不超过5个的融合瓶颈。本文方法可在漫游速率为20~40帧/s时,准确并高效地实现5~10个视频摄像头与三维GIS场景的融合。

(3) 针对场景突然转换视角、新场景所有对象均发生变化的极端情况,本文方法仍适用,且效率略高于现有方法,具有良好的稳健性。

视频与三维GIS场景融合是未来发展的一个重要方向,融合对象的选取效率及融合畸变校正均对高效高质量的融合至关重要。本文主要侧重前者融合对象选取效率的提升,并未过多地涉及后续的畸变校正,在融合结果可视化方面可能会存在一定的变形。总体而言,本研究提出的快速确定融合对象的方法可为后续大场景或多摄像头情况下高效融合渲染提供保障。未来研究中,在提升效率的基础上,将重点考虑摄像头虚拟相机相对于三维GIS场景的位置和姿态等内外方位元素,充分顾及视频影像成像模型(如焦距估计、畸变校正、各类摄像头的CCD尺寸等),提高虚拟相机标定的精确性,从而提升虚实融合渲染效果。

| [1] |

MILOSAVLJEVIĆ A, DIMITRIJEVIĆ A, RANČIĆ D. GIS-augmented video surveillance[J]. International Journal of Geographical Information Science, 2010, 24(9): 1415-1433. DOI:10.1080/13658811003792213 |

| [2] |

MILOSAVLJEVIĆ A, RANČIĆ D, DIMITRIJEVIĆ A, et al. Integration of GIS and video surveillance[J]. International Journal of Geographical Information Science, 2016, 30(10): 2089-2107. |

| [3] |

PAN Chengwei, CHEN Yisong, WANG Guoping. Virtual-real fusion with dynamic scene from videos[C]//Proceedings of 2016 International Conference on Cyberworlds (CW). Chongqing: IEEE, 2016: 312-325.

|

| [4] |

JIAN Hongdeng, LIAO Jingjuan, FAN Xiangtao, et al. Augmented virtual environment: fusion of real-time video and 3D models in the digital earth system[J]. International Journal of Digital Earth, 2017, 10(12): 1177-1196. DOI:10.1080/17538947.2017.1306126 |

| [5] |

DECAMP P, SHAW G, KUBAT R, et al. An immersive system for browsing and visualizing surveillance video[C]//Proceedings of the 18th ACM International Conference on Multimedia. Firenze: ACM, 2010: 371-380.

|

| [6] |

周凡. 视频影像增强虚拟三维场景的注册与渲染方法研究[J]. 测绘学报, 2019, 48(6): 801. ZHOU Fan. Research on registration and rendering method of video to enhance 3D scene[J]. Acta Geodaetica et Cartographica Sinica, 2019, 48(6): 801. DOI:10.11947/j.AGCS.2019.20180315 |

| [7] |

SAWHNEY HS, ARPA A, KUMAR R, et al. Video flashlights: real time rendering of multiple videos for immersive model visualization[C]//Proceedings of the 13th Eurographics Workshop on Rendering. Pisa, Italy: ACM, 2002: 157-168.

|

| [8] |

NEUMANN U, YOU S Y, HU J H, et al. Augmented virtual environments (AVE): dynamic fusion of imagery and 3D models[C]//Proceedings of 2003 IEEE Virtual Reality. Los Angeles, CA: IEEE, 2003: 61-67.

|

| [9] |

DE HAAN G, PIGUILLET H, POST F H. Spatial navigation for context-aware video surveillance[J]. IEEE Computer Graphics and Applications, 2010, 30(5): 20-31. DOI:10.1109/MCG.2010.64 |

| [10] |

HU Jinhui. Integrating complementary information for photorealistic representation[D]. Los Angeles: University of Southern California, 2009.

|

| [11] |

周颐, 孟明, 吴威, 等. 基于视频模型的虚拟现实视频融合系统[J]. 系统仿真学报, 2018, 30(7): 2250-2557. ZHOU Yi, MENG Ming, WU Wei, et al. Virtual-reality video fusion system based on video model[J]. Journal of System Simulation, 2018, 30(7): 2550-2557. |

| [12] |

WANG Y, KRUM D M, COELHO E M, et al. Contextualized videos: combining videos with environment models to support situational understanding[J]. IEEE Transactions on Visualization and Computer Graphics, 2007, 13(6): 1568-1575. DOI:10.1109/TVCG.2007.70544 |

| [13] |

马原野, 赵刚, 何彬. 3D GIS与多视频融合系统的设计与实现[J]. 计算机应用与软件, 2012, 29(6): 109-112, 117. MA Yuanye, ZHAO Gang, HE Bin. Design and implementation of a fused system with 3DGIS and multiple-videos[J]. Computer Applications and Software, 2012, 29(6): 109-112, 117. |

| [14] |

DE HAAN G, SCHEUER J, DE VRIES R, et al. Egocentric navigation for video surveillance in 3D virtual environments[C]//Proceedings of 2009 IEEE Symposium on 3D User Interfaces. Lafayette, LA: IEEE, 2009.

|

| [15] |

CORRAL-SOTO E R, TAL R, WANG Langyue, et al. 3D town: the automatic urban awareness project[C]//Proceedings of 2012 Ninth Conference on Computer and Robot Vision (CRV). Toronto: IEEE, 2012: 433-440.

|

| [16] |

MOWER J E. Creating and delivering augmented scenes[J]. International Journal of Geographical Information Science, 2009, 23(8): 993-1011. DOI:10.1080/13658810802001313 |

| [17] |

HSU S, SAMARASEKERA S, KUMAR R, et al. Pose estimation, model refinement, and enhanced visualization using video[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Hilton Head Island: IEEE, 2000: 488-495.

|

| [18] |

SEGAL M, KOROBKIN C, VAN WIDENFEL T R, et al. Fast shadows and lighting effects using texture mapping[J]. ACM SIGGRAPH Computer Graphics, 1992, 26(2): 249-252. DOI:10.1145/142920.134071 |

| [19] |

简洪登, 范湘涛. 基于GLSL的多重视频纹理映射与融合[J]. 计算机工程与设计, 2014, 35(11): 3873-3878. JIAN Hongdeng, FAN Xiangtao. Multiple video texture mapping and fusion based on OpenGL shading language[J]. Computer Engineering and Design, 2014, 35(11): 3873-3878. DOI:10.3969/j.issn.1000-7024.2014.11.032 |

| [20] |

GHADIRIAN P, BISHOP I D. Integration of augmented reality and GIS: a new approach to realistic landscape visualisation[J]. Landscape and Urban Planning, 2008, 86(3-4): 226-232. DOI:10.1016/j.landurbplan.2008.03.004 |

| [21] |

王行风, 汪云甲. 一种顾及拓扑关系的室内三维模型组织和调度方法[J]. 武汉大学学报(信息科学版), 2017, 42(1): 35-42. WANG Xingfeng, WANG Yunjia. Organization and scheduling of indoor three-dimensional geometric model based on spatial topological relation[J]. Geomatics and Information Science of Wuhan University, 2017, 42(1): 35-42. |

| [22] |

龚俊, 朱庆, 章汉武, 等. 基于R树索引的三维场景细节层次自适应控制方法[J]. 测绘学报, 2011, 40(4): 531-534. GONG Jun, ZHU Qing, ZHANG Hanwu, et al. An adaptive method for 3D city model based on extended 3D R-tree[J]. Acta Geodaetica et Cartographica Sinica, 2011, 40(4): 531-534. |

| [23] |

朱庆, 陈兴旺, 丁雨淋, 等. 视觉感知驱动的三维城市场景数据组织与调度方法[J]. 西南交通大学学报, 2017, 52(5): 869-876. ZHU Qing, CHEN Xingwang, DING Yulin, et al. Organization and scheduling method of 3D urban scene data driven by visual perception[J]. Journal of Southwest Jiaotong University, 2017, 52(5): 869-876. DOI:10.3969/j.issn.0258-2724.2017.05.005 |

| [24] |

CHEN C F, BOLAS M, SUMA E. Real-time 3D rendering using depth-based geometry reconstruction and view-dependent texture mapping[C]//Proceedings of ACM SIGGRAPH 2016. Anaheim, CA: ACM, 2016: 213-227.

|

| [25] |

CLARKE B L. A calculus of individuals based on "connection"[J]. Notre Dame Journal of Formal Logic, 1981, 22(3): 204-218. DOI:10.1305/ndjfl/1093883455 |

| [26] |

LEWIS P, FOTHERINGHAM S, WINSTANLEY A. Spatial video and GIS[J]. International Journal of Geographical Information Science, 2011, 25(5): 697-716. DOI:10.1080/13658816.2010.505196 |