地面机器人可以携带大量的载荷,在环境中有着很好的互动性和自主性,越来越多地用于搜索和救援等需要强大导航能力的情况[1]。但是,由于工作空间的限制,地面机器人视角低,采集数据范围较小、效率低,且往往需要人工控制预先进行环境感知,在一些复杂未知或人难以到达的区域,地面机器人难以独自进行环境感知,因此难以实现自主运动。空中机器人具有视角优势,能够快速进行大范围区域环境感知,因此结合空中机器人的优势实现空地协作,可以很好地提高地面机器人在有挑战的未知区域中进行自主建图和导航的效率和能力。

空地机器人协作通常是用来解决大型室外环境中的导航问题[2-3],这些方法依赖于或者部分依赖于GPS等外部定位方式,无法应用于室内环境和GPS无法覆盖的户外区域。为降低对GPS的依赖问题,一些空中机器人使用QR码[4]、视觉标记[5-6]或边缘检测[7]来跟踪地面机器人, 或者使用轮廓信息来判别地面目标[8],还有的工作使用地面机器人上的摄像头跟踪飞行机器人上的led灯来进行协作[9-10],这些方法虽然不依赖于外部定位,但是通常都是其中一个机器人执行整个感知过程,并指导另一个机器人完成任务[11],地图不是由多个机器人不断更新,规划器也无法适应新的数据,难以在具有挑战的未知区域中很好地工作。其他的工作诸如文献[12—13],两个机器人都使用了摄像头来感知环境,并通过视觉特征或者视觉标志实现相对定位,但是该方法假设环境提供了合适的纹理,在少、弱纹理等环境中难以工作。

相比于这些方法,本文的协同建图导航方法不依赖于GPS等外部定位方式,提出一种结合点、线特征和显著闭合边界的新颖无人机视觉SLAM方法,在少、弱纹理等环境中实现精准自主定位,并获得包含精确地面障碍物信息的初始全局地图;地面机器人利用全局地图规划全局路径,在移动过程中利用激光传感器对初始地图进行更新,并不断重新规划路径,以适应地图中获取的新数据,因此地图是由空地机器人共同感知和更新,结合了两种机器人不同视角的优势更好地感知周围环境。

现有的视觉SLAM主要分为两种方法,一种是特征点法,即通过提取图像的特征点进行匹配来完成SLAM过程,如PTAM[14]、ORB-SLAM[15],这些方法完全依赖于提取的特征点,但是在低纹理环境中,通常很难找到足够数量的可靠点特征,因此工作场景有限;另一种是直接法,是直接利用像素信息来进行SLAM过程,如DSO[16]、LSD-SLAM[17],这些方法在光照和视角变化时会有很大的误差,不适用无人机平台,且工作地点受限。现有的基于边缘特征的视觉SLAM方法中,如Edge-SLAM[18]、Edge-based VO[19],边缘特征对物体信息有更好的表达,但是由于SLAM依赖于成对一致性,提取的边缘特征稳健性与准确性较低,因此该种方法虽然建图效果好,定位和建图精度较低。

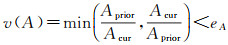

因此本文结合点、线特征和显著闭合边界,提出一种新颖的无人机视觉SLAM方法。该方法由4个线程组成:双目视觉里程计、显著闭合边界跟踪、建图及闭环线程,如图 1所示。该方法中,无人机利用一种点、线特征结合的双目视觉SLAM方法,即PL-SLAM[20]来进行无人机自主定位和稀疏的建图。该方法对光照不敏感,且在少、弱纹理环境例如地面、墙面等,即使点特征稀少,也能够依赖线特征进行很好的工作,因此本文方法定位效果比只用点特征的方法更为稳健,同时对计算平台要求小,适合用于载荷有限的无人机平台。但是仅通过该方法只能获得由点、线特征组成的稀疏地图,无法完整表示出障碍物区域,对于之后的自主定位和导航造成不小的阻碍。因此本文构建一个显著闭合边界跟踪的线程,实时检测并跟踪场景中的显著闭合边界,结合边界信息获得包含完整障碍物区域的全局地图。

|

| 图 1 主要流程 Fig. 1 The main flow chart |

因此总体而言本文的贡献如下:

本文提出一种基于无人机视觉SLAM的协同建图与导航方法,利用无人机协助地面机器人快速构建环境模型,提高地面机器人在未知和具有挑战性的区域中建图和导航的能力。

构建一个实时的显著闭合边界检测和跟踪的线程,提出一种结合点、线特征和显著闭合边界的新颖无人机视觉SLAM方法,在少、弱纹理等环境中实现精准自主定位的同时,获得精确的环境全局地图。

本文协同建图与导航方法的主要流程如图 1所示。

1 本文方法 1.1 协同建图与导航方法的主要流程本文提出一种协同建图与导航方法,首先利用无人机空中视角以及摄像头信息丰富的优势,基于视觉SLAM方法快速进行大范围环境感知,为地面机器人提供初始全局地图,地面机器人在对环境有初步感知的情况下,规划全局路径,可以无须人工操作,在该区域内自主导航移动前往目标点,考虑到无人机空中视角制得的地图会忽略掉许多空中未看到的物体,制得的地图还不够精细,同时机器人行进过程中周围环境可能会发生变化,如出现无人机建图时不存在的障碍物或者物体发生了移动,这些情况会影响地面机器人在有图情况下自主导航的效果,极大地增加了与障碍物发生碰撞的可能性,因此在移动过程中,会利用激光传感器对无人机建的地图进行更新,实现空地机器人利用不同传感器协同进行环境感知,保证效率的同时也获得更多信息。地面机器人在移动中对地图进行更新的同时,不断对局部路径进行连续重新规划,以适应地图中获取的新数据,整个方法减少人为的参与,极大提高地面机器人自主导航的能力。

1.2 基于无人机视觉SLAM的初始全局地图构建在本文中,初始的全局地图是无人机构建并传递给地面机器人的,之后地面机器人在移动过程再进行更新。本文使用一种不受数据关联影响的地图表示方式,占据栅格地图(occupancy grid map)[21]来近似环境。占据栅格的基本思想是将环境地图表示为均匀间隔的二进制随机变量字段,每个二进制随机变量表示环境中该位置处是否存在障碍物。该地图不同于通常的矢量地图,可以描述环境中的障碍物和自由空间,是目前机器人实现自主导航与路径规划最常用的地图表示形式。因此,本文的建图概念是指构建可用于机器人自主运动的占据栅格地图。

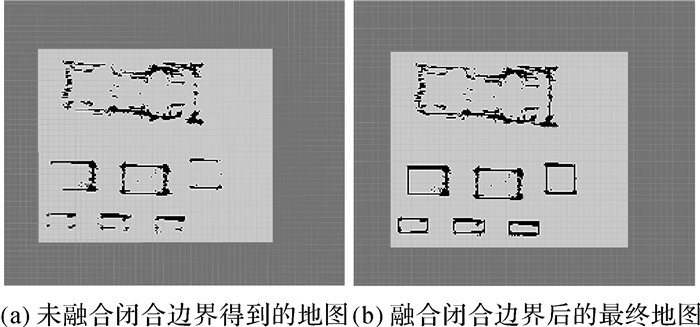

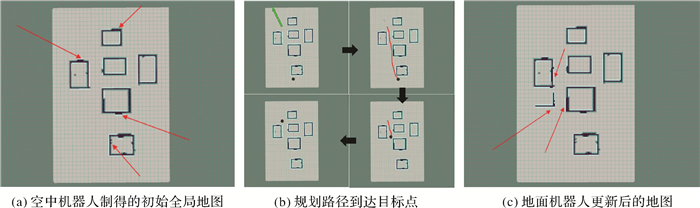

无人机在飞行过程中利用一种点、线特征结合的视觉SLAM方法(即PL-SLAM[20])进行自主定位和稀疏的建图,这种方式在少、弱纹理等环境中实现精准定位,但是获得的地图只部分包含地面物体信息,难以用于初始地面机器人的定位导航,如图 6(a)所示。考虑到空中视角下地面障碍物在二维上大多可以用闭合边界进行表示,为有效确定障碍物区域,本文加入一个显著闭合边界跟踪线程,实时检测并跟踪场景中的显著闭合边界,对建图过程进行补充,在保证高定位精度的同时快速获得包含障碍物完整信息的地图,如图 6(b)所示,补充后地图可以很好地用于地面机器人初始的全局路径规划。

|

| 图 6 建图结果对比 Fig. 6 Comparison of mapping results |

本文的视觉SLAM方法采用贝叶斯深度滤波器[22]估计特征点、线段点和轮廓点的深度,滤波器中的值会不断更新直到收敛才会用于建图,可以获得较为精确的深度信息,因此利用无人机视觉SLAM获得的是三维点云形式的地图,之后利用深度信息以及障碍物区域是闭合的条件判断障碍物区域和可通行区域,并将三维点云映射到二维,构建地面机器人可以直接用于定位导航的占据栅格地图,将该地图作为初始全局地图分享给地面机器人进行初始全局规划。通过这种方式用无人机代替地面机器人对环境进行快速的初始感知,使得地面机器人在开始无须人为操作的情况下自主前往目标点。

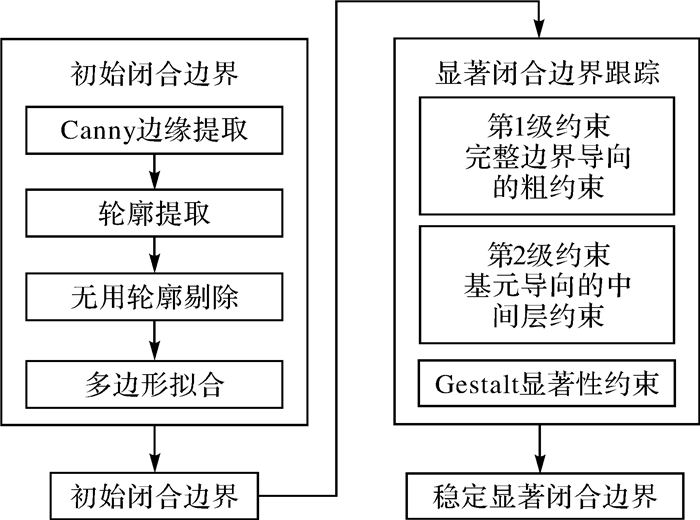

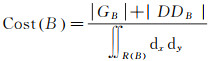

1.3 显著闭合边界跟踪线程 1.3.1 线程的主要流程为了优化建图效果,得到包含完整障碍物区域、可以用于地面机器人自主定位与导航的地图,本文构建了该线程。在该线程中,首先会进行边缘提取和基于拓扑分析的轮廓检测,去除大量无用轮廓的干扰,之后从中提取闭合边界,作为初始边界进行边界跟踪,最后结合稳定的闭合边界优化建图效果。这种方式有如下几个优点:

(1) 考虑到空中视角下地面障碍物在二维上大多可以用闭合边界进行表示,融合显著闭合边界可以很好表达地面障碍物信息。

(2) 当提取到初始边界时进行跟踪,跟踪中的稳定边界用于优化建图效果,不需要在每帧都进行检测,减轻了计算负担。

(3) 对于闭合边界会在多帧之间进行跟踪直到稳定,避免了在某帧某一视角下提取边界效果过好或过差所造成的误差。

整个线程的主要流程如图 2所示。

|

| 图 2 线程主要流程 Fig. 2 The main flow chart of the thread |

1.3.2 初始闭合边界的构建

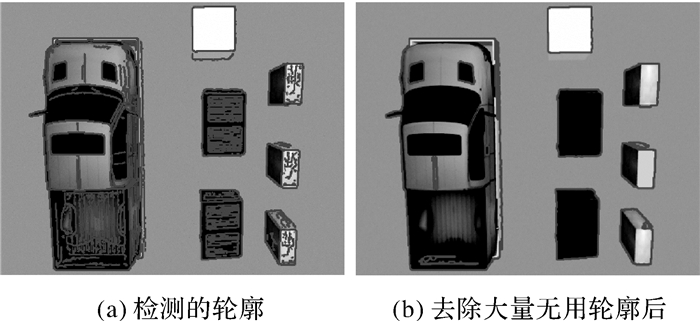

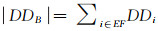

在该线程中,首先用Canny[23]算子进行边缘提取,采用Canny算子是考虑精度与运行速度的一个很好的折中方法。对于得到的边缘图,采用一种基于拓扑分析和轮廓树表达的轮廓检测方法[24]获得场景中的轮廓,将基于拓扑分析得到的轮廓间包含关系组织成轮廓树,树的节点变量与轮廓连接,表示出轮廓的不同层次信息,将母轮廓与子轮廓的关系表示出来。选择轮廓树最上层母轮廓得到相邻轮廓中最外围轮廓,排除掉物体边界内轮廓的干扰,通过这一步可以去除大量无用轮廓的干扰,如图 3所示。

|

| 图 3 轮廓检测与干扰轮廓去除 Fig. 3 Contour detection and interference contour removal |

对于处理后的轮廓图,采用多边形拟合提取闭合多边形边界,大部分物体甚至圆形物体均可用多边形逼近,因此多边形拟合可以得到很好的提取效果,拟合算法基于道格拉斯-普克算法(Douglas-Peucker algorithm)实现。

1.3.3 显著闭合边界跟踪对于提取到的闭合边界,会作为初始的闭合边界,基于一种使用感知分组和形状初始的实时显著闭合边界跟踪方法[25]进行跟踪。主要思想是结合初始边界形状信息和Gestalt显著性[26]并顺序连接每个帧中的一组边缘片段来跟踪视频序列中的闭合边界。

初始边界形状约束采用两级约束[25],第1级约束是完整边界导向的粗约束,例如周长和面积变化,该级约束限制除了精细结构之外的显著形状变化。第2级约束是基元导向的中间层约束,例如边缘片段和线段的曲率、方向、长度和距离属性,这级约束对形状变化提供了更强的限制。

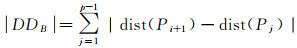

第1级约束主要采用面积和边长限制来减少搜索空间并提高跟踪的稳健性

(1)

(1)

(2)

(2)

式中,v(P)和v(A)是边长和面积的变化;Pprior和Pcur是初始和当前闭合边界的边长;Aprior和Acur是初始和当前边界包围的区域面积;eP和eA分别代表周长和面积变化约束。

为了结合当前帧的Gestalt显著性和初始形状信息,基于第2级约束定义一个闭合边界B的分组代价函数

(3)

(3)

式中,

(4)

(4)

式中,p为边缘片段像素数量;Pj为片段像素数组的第j个像素;dist(Pj)是初始形状的距离变换图[28]上的对应值。

在显著闭合边界跟踪过程中,将多帧间稳定不变的边界作为稳定显著闭合边界,用于优化建图效果。同时,将稳定闭合边界分解为由多边形角点构成的点特征和每条边构成的线特征,将这些特征输入到视觉里程计过程中,作为提取到的点、线特征进行处理,特征处理及描述子计算方法与PL-SLAM[20]一致,再进入建图线程,由于所计算的特征描述子具有视角不变性和稳健性,特别是边界角点特征可以较好地表示不同视角中的同一个物体,结合表示无人机运动的帧间变换矩阵,可以在建图时较好地消除由于视角变化带来的影响,构建出障碍物完整区域边界。

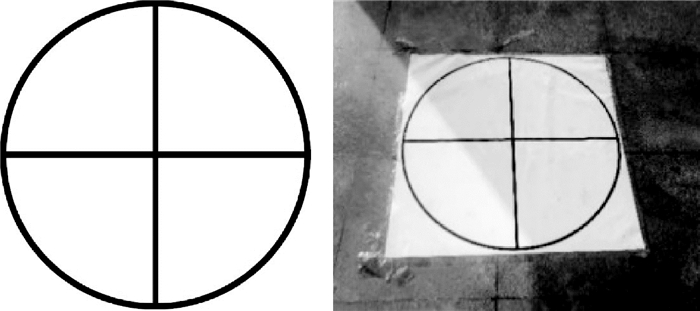

1.4 地面机器人初始定位获得全局地图后,地面机器人需要在启动的时候知道在地图中的位置,也就是完成初始定位,这就需要给定一个初始化坐标,再根据全局地图完成初始定位。本文中采用视觉标靶[29]的方式实现,在实际的试验过程中,会在试验场景中放置一个无人机飞行过程中可以明显看到的视觉标志,标志如图 4所示。该标志是由一个圆包围一个十字组成,标志背景是白色的,无人机通过识别这个标记,确定出其圆心在最终的地图中的位置,作为初始化的位置和全局地图共同分享给地面机器人。

|

| 图 4 视觉标志 Fig. 4 Visual marker |

1.5 地面机器人导航规划与地图更新

地面机器人会搭载激光传感器,使用无人机分享的数据在全局地图中进行初始定位,初始定位和移动过程中的定位均基于自适应蒙特卡洛算法(adaptive Monte Carlo localization,AMCL)实现,AMCL是移动机器人二维环境下的概率定位系统,针对已有的二维占据栅格地图使用粒子滤波器跟踪机器人的位姿,是当前机器人有图情况下自主定位效果最好的算法之一,本文方法建的精确地图可以确保实现高效精准的初始定位。在指定终点后,采用Dijkstra算法规划出一条到终点的全局路径,在机器人根据全局路径移动到终点过程中,搭载的激光传感器会对无人机建的初始全局地图进行更新,地面机器人的建图算法是gmapping算法[30],更新的地图格式同样是占据栅格地图(occupancy grid map),因此地图的获取和更新是空地机器人利用各自不同的传感器共同完成的:无人机利用双目摄像头,地面机器人利用激光传感器。gmapping算法会先利用传感器获得的数据利用粒子滤波在地图中进行初始定位,基于初始定位的位置进行地图的构建,本文将无人机分享的初始定位点作为gmapping算法的初始点,并结合粒子滤波进行初始定位,将坐标系对齐,因此gmapping算法的地图与无人机获得的初始占据栅格地图是统一的初始坐标,并进行了坐标系的对齐,可以直接利用gmapping算法对无人机建的地图进行不断更新。同时地面机器人在行进过程中采用动态窗口法(dynamic window approach, DWA)对局部路径进行连续的重新规划,根据附近的障碍物进行避障路线规划,全局规划器也会定期自动重新启动,从当前位置重新规划全局路径,以适应地图中获取的新数据,避免了因为无人机视角未发现或者环境发生变化导致机器人发生碰撞。使得地面机器人无须人过多参与的情况下,能够快速地在未知环境中自主运动。

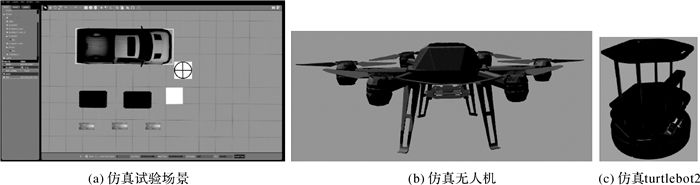

2 试 验 2.1 仿真试验仿真试验中试验场景可以自由设置,不用受限于器材设备和环境的限制,同时所有物体的参数和位置均有精准的真值,可以进行定量的评价,因此设置了仿真试验。本文利用Gazebo[31]仿真环境软件构建需要的试验环境,添加垃圾桶、汽车、大方块等多种地面障碍物,根据真实环境设置了摩擦力、重力等因素,所以几乎保证试验结果和真实场景一致,最终搭建的试验场景如图 5(a)所示。无人机的仿真模型采用的是ETH苏黎世联邦理工学院的ASL Lab(自动化系统实验室)设计的neo11无人机,如图 5(b)所示。无人机搭载其设计的双目摄像头,仿真地面机器人模型采用ROS[32]中自带的turtlebot2仿真模型,如图 5(c)所示。计算平台采用配置有Intel Core i7-7700 (4 cores @2.80 GHz) with 8GB RAM的计算机。

|

| 图 5 仿真试验 Fig. 5 Simulated experiment |

试验过程中无人机在8 m的空中飞行,同时实时采集双目影像数据,因为无人机空中视角带来的大范围感知能力,因此飞行总长度为5 m,即可完成地面障碍物信息初始全局地图的构建,建图的面积约8.9 m×9.5 m=84.55 m2。飞行过程中利用双目影像数据获得全局地图并进行视觉标靶确定初始化的坐标。为了证明本文方法可以高效快速获得全局地图,让地面机器人在相同场景利用gmapping算法进行建图,时间对比见表 1。对比得出本文方法节省大量时间,可以用无人机代替地面机器人快速实现对于环境的初步感知。

| 建图方法 | 所用传感器 | 所用时间 |

| 本文方法 | 双目摄像头 | 约2 min |

| 地面机器人建图 | 激光传感器 | 约10 min |

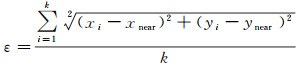

为了对生成的占据栅格地图进行定量的评价,对生成的地图与地面groundtruth地图之间进行误差分析,使用基于k-最近邻概念的性能度量方法[33]。将算法的结果进行二值化,使用图像处理工具将二值化地图与相应的地面groundtruth进行精确对齐,使用knnsearch确定地面groundtruth的每个占据单元格到生成地图中最近单元格的距离,最后将获得的所有距离总和除以地面groundtruth中占据单元数量。如式(5)所示

(5)

(5)

式中,ε为度量误差;xi、yi为第i个单元格的坐标;xnear、ynear为距离第i个单元格最近的单元格的坐标;k为占据单元格总数量。

图 6(a)是未融合显著闭合边界只采用点、线特征结合的方式(即PL-SLAM)得到的占据栅格地图,图 6(b)是融合闭合边界之后的地图。表 2是定量评价的结果对比。对比得出本文的显著边界跟踪线程对视觉SLAM建图效果有很大提升,得到包含完整障碍物闭合边界信息、可以用于地面机器人自主定位和导航的全局地图。

| 建图方法 | 误差值 |

| PL-SLAM方法 | 4.283 3 |

| 本文融合闭合边界后的方法 | 3.377 9 |

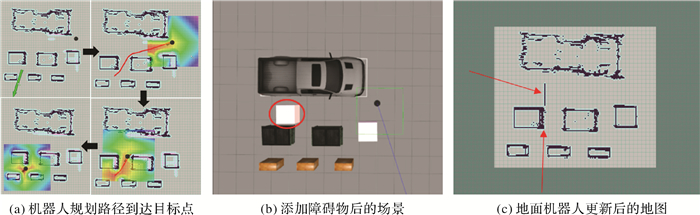

地面机器人基于无人机创建的全局地图和视觉标靶的结果完成初始定位,规划到指定终点的全局路径,前往终点的过程中,地面机器人对全局地图进行更新,路径规划器也会进行连续的重新规划,以适应地图中获取的新数据。如图 7(a)所示,黑色原点为机器人当前位置,绿色箭头非箭头端是指定的终点位置,箭头方向表示到达终点时机器人的方向,红色实线表示规划到终点的全局路线,彩色渲染图表示机器人行进过程中局部规划路径时考虑的范围。机器人开始移动后,在场景中加了一个障碍物,该障碍物在无人机建图时不存在,加障碍物后的场景如图 7(b)所示,红色圆框内为新加障碍物。在机器人沿着全局路径前往终点的过程中,对无人机建的地图进行更新,并且不断重新规划路径确保地面机器人避开障碍物且高效地到达终点,整个过程如图 7(a)所示。到达终点后更新得到的新地图如图 7(c)所示,红色箭头所指位置可以看出对于新加入的障碍物进行了建图,对初始地图中结果进行了补充。

|

| 图 7 地面机器人试验过程 Fig. 7 Ground robot experiment process |

2.2 真实试验

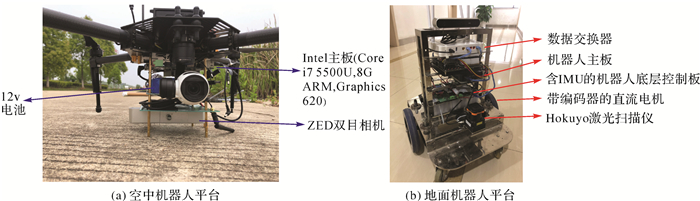

本文真实试验平台基于大疆经纬M100无人机,在无人机上自主设计构建空中机器人平台,如图 8(a)所示。平台搭载了Intel主板(配置为Core i7 5500U,8GB ARM,Graphics620)、12V电池以及ZED双目相机,地面机器人为轮式机器人平台如图 8(b)所示。平台搭载了Hokuyo二维激光扫描仪、机器人主板、数据交换器等。试验中通过802.11ac无线接口传输的远程信号构建无线局域网,实现空地机器人之间的通信。

|

| 图 8 机器人平台 Fig. 8 The robot platform |

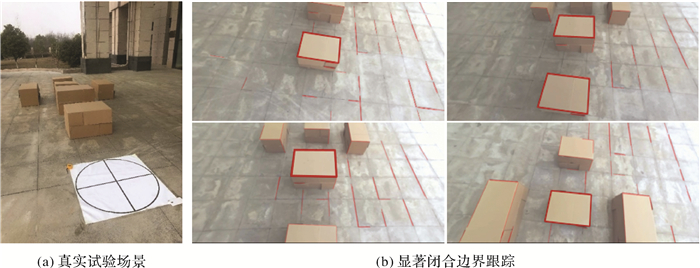

真实试验中采用了不同大小的纸箱作为地面障碍物,将一个大的圆形十字标作为之后地面机器人初始定位的位置,也是无人机起飞的位置,试验场景如图 9(a)所示。试验场景中只有视觉标志、纸箱以及地面,纹理稀少,场景开阔,对于通常的视觉SLAM来说是一个不小的挑战。对于采用纸箱作为地面障碍物有以下几点考虑:

|

| 图 9 真实试验 Fig. 9 Real experiment |

(1) 纸箱上纹理稀少,可以证明本文方法在少、弱纹理环境中工作的高稳健性。

(2) 纸箱的边长固定且已知,可以用来对建的地图进行一定的定量评价。

无人机在空中以3 m左右的高度飞行,飞行过程中实时采集并处理ZED相机获取的双目影像,工作过程中另一线程会并行检测并跟踪显著闭合边界,如图 9(b)所示,将获得的稳定边界加入建图线程中,最终的地图如图 10(a)所示。可以看出本文方法很好地构建出了初始全局地图,地图中障碍物主要都是由显著闭合边界的结果获得,由于箱子上只能产生少量稳定的点、线特征,所以如果只采用点、线特征结合的方式,最终地图中只能建稀少的点、线特征,如图 10(a)中红色箭头所示,其余都是融合显著闭合边界后得到的结果。

|

| 图 10 地面机器人试验过程 Fig. 10 Ground robot experiment process |

利用无人机构建的全局地图,实现地面机器人自主定位和导航避障的过程,如图 10(b)所示,图中黑色原点为机器人当前位置,绿色的箭头非箭头端是指定的终点位置,箭头方向表示到达终点位置时机器人的方向,绿色实线表示规划到终点的全局路线,最终地面机器人成功到达终点。真实试验地面机器人到达终点后更新得到的新地图如图 10(c)所示,红色箭头所指位置可以看出对于新加入的障碍物进行了建图,对初始地图中结果进行了补充。

3 结 论本文提出了一种基于无人机视觉SLAM的协同建图与导航方法,利用无人机空中视角带来的大范围环境感知能力,协助地面机器人快速构建环境模型,创建了一个实时的显著闭合边界检测和跟踪线程,极大提升了空中机器人建图的效果。地面机器人根据无人机分享的初始全局地图和初始定位规划到目标点的全局路径,在移动的过程中,会不断更新地图数据,且局部路径也会进行连续的重新规划,确保地面机器人无须人为过多参与就能够快速在未知环境中实现自主的运动。为了验证本文方法的可行性和先进性,分别进行了仿真试验和真实试验,并进行了精度评价,证明了本文方法的可行性和创新性。目前在复杂的实际场景中工作效果还需提升,例如障碍物分布密集、地面高低起伏等情况下效果不佳,同时构建的是二维的占据栅格地图,因此实现的是二维平面上的导航。未来工作主要立足于在更为复杂的真实场景中进行试验,研究融合激光雷达、IMU等多传感器和构建三维占据栅格地图,完成更为高级的任务。

| [1] |

BUTZKE J, GOCHEV K, HOLDEN B, et al. Planning for a ground-air robotic system with collaborative localization[C]//Proceedings of 2016 IEEE International Conference on Robotics and Automation (ICRA). Stockholm, Sweden: IEEE, 2016: 284-291. 10.1109/ICRA.2016.7487146

|

| [2] |

KELLY A, STENTZ A, AMIDI O, et al. Toward reliable off road autonomous vehicles operating in challenging environments[J]. International Journal of Robotics Research, 2006, 25(5-6): 449-483. DOI:10.1177/0278364906065543 |

| [3] |

HSIEH M A, COWLEY A, KELLER J F, et al. Adaptive teams of autonomous aerial and ground robots for situational awareness[J]. Journal of Field Robotics, 2007, 24(11-12): 991-1014. DOI:10.1002/rob.20222 |

| [4] |

MUEGGLER E, FAESSLER M, FONTANA F, et al. Aerial-guided navigation of a ground robot among movable obstacles[C]//Proceedings of 2014 IEEE International Symposium on Safety, Security, and Rescue Robotics (2014). Hokkaido, Japan: IEEE, 2014: 1-8. 10.1109/SSRR.2014.7017662

|

| [5] |

HARIK E H C, GUÉRIN F, GUINAND F, et al. UAV-UGV cooperation for objects transportation in an industrial area[C]//Proceedings of 2015 IEEE International Conference on Industrial Technology (ICIT). Seville, Spain: IEEE, 2015: 547-552. 10.1109/ICIT.2015.7125156

|

| [6] |

HEPPNER G, ROENNAU A, DILLMANN R. Enhancing sensor capabilities of walking robots through cooperative exploration with aerial robots[J]. Journal of Automation Mobile Robotics and Intelligent Systems, 2013, 7(2): 5-11. |

| [7] |

GARZÓN M, VALENTE J, ZAPATA D, et al. An aerial-ground robotic system for navigation and obstacle mapping in large outdoor areas[J]. Sensors, 2013, 13(1): 1247-1267. DOI:10.3390/s130101247 |

| [8] |

刘毅, 车进, 朱小波, 等. 空地机器人协同导航方法与实验研究[J]. 电子技术应用, 2018, 44(10): 144-148. LIU Yi, CHE Jin, ZHU Xiaobo, et al. The navigation method and experimental research of air-ground robot cooperation[J]. Application of Electronic Technique, 2018, 44(10): 144-148. |

| [9] |

RUDOL P, WZOREK M, CONTE G, et al. Micro unmanned aerial vehicle visual servoing for cooperative indoor exploration[C]//Proceedings of 2008 IEEE Aerospace Conference. Big Sky, MT: IEEE, 2008: 1-10. 10.1109/AERO.2008.4526558

|

| [10] |

FAESSLER M, MUEGGLER E, SCHWABE K, et al. A monocular pose estimation system based on infrared LEDs[C]//Proceedings of 2014 IEEE International Conference on Robotics and Automation (ICRA). Hong Kong, China: IEEE, 2014: 907-913. 10.1109/icra.2014.6906962

|

| [11] |

谷丰, 王争, 宋琦, 等. 空地机器人协作导航方法与实验研究[J]. 中国科学技术大学学报, 2012, 42(5): 398-404. GU Feng, WANG Zheng, SONG Qi, et al. Theoretical and experimental study of air-ground cooperative navigation[J]. Journal of University of Science and Technology of China, 2012, 42(5): 398-404. DOI:10.3969/j.issn.0253-2778.2012.05.008 |

| [12] |

FANKHAUSER P, BLOESCH M, KRVSI P, et al. Collaborative navigation for flying and walking robots[C]//Proceedings of 2016 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Daejeon, South Korea: IEEE, 2016: 2859-2866. 10.1109/IROS.2016.7759443

|

| [13] |

刘盛, 陈一彬, 戴丰绩, 等. 空地正交视角下的多机器人协同定位及融合建图[J]. 控制理论与应用, 2018, 35(12): 1779-1787. LIU Sheng, CHEN Yibin, DAI Fengji, et al. Collaborative localization and fusion mapping of multi-robots under the orthogonal view of open space[J]. Control Theory & Application, 2018, 35(12): 1779-1787. |

| [14] |

KLEIN G, MURRAY D. Parallel tracking and mapping for small AR workspaces[C]//Proceedings of the 6th IEEE and ACM International Symposium on Mixed and Augmented Reality. Nara, Japan: IEEE, 2007: 225-234. 10.1109/ISMAR.2007.4538852

|

| [15] |

MUR-ARTAL R, MONTIEL J M M, TARDÓS J D. ORB-SLAM:a versatile and accurate monocular SLAM system[J]. IEEE Transactions on Robotics, 2015, 31(5): 1147-1163. DOI:10.1109/TRO.2015.2463671 |

| [16] |

ENGEL J, KOLTUN V, CREMERS D. Direct sparse odometry[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(3): 611-625. DOI:10.1109/TPAMI.2017.2658577 |

| [17] |

ENGEL J, SCHÖPS T, CREMERS D. LSD-SLAM: large-scale direct monocular SLAM[C]//Proceedings of the 13th European Conference on Computer Vision. Zurich, Switzerland: Springer, 2014: 834-849. 10.1007/978-3-319-10605-2_54

|

| [18] |

MAITY S, SAHA A, BHOWMICK B. Edge slam: edge points based monocular visual slam[C]//Proceedings of 2017 IEEE International Conference on Computer Vision Workshops. Venice, Italy: IEEE, 2017: 2408-2417. 10.1109/ICCVW.2017.284

|

| [19] |

JOSÉ TARRIO J, PEDRE S. Realtime edge-based visual odometry for a monocular camera[C]//Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile: IEEE, 2015: 702-710. 10.1109/ICCV.2015.87

|

| [20] |

GOMEZ-OJEDA R, MORENO F A, ZUÑIGA-NOËL D, et al. PL-SLAM:a stereo SLAM system through the combination of points and line segments[J]. IEEE Transactions on Robotics, 2019, 35(3): 734-746. DOI:10.1109/TRO.2019.2899783 |

| [21] |

岳伟韬, 苏婧, 谷志珉, 等. 占据栅格地图的最佳栅格大小与地图精度[J]. 机器人, 2020, 42(2): 199-206. YUE Weitao, SU Jing, GU Zhimin, et al. The best grid size and map accuracy for occupancy grid map[J]. Robot, 2020, 42(2): 199-206. |

| [22] |

VOGIATZIS G, HERNÁNDEZ C. Video-based, real-time multi-view stereo[J]. Image and Vision Computing, 2011, 29(7): 434-441. DOI:10.1016/j.imavis.2011.01.006 |

| [23] |

CANNY J. A computational approach to edge detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1986, PAMI-8(6): 679-698. DOI:10.1109/TPAMI.1986.4767851 |

| [24] |

SUZUKI S, BE K A. Topological structural analysis of digitized binary images by border following[J]. Computer Vision, Graphics, and Image Processing, 1985, 30(1): 32-46. DOI:10.1016/0734-189X(85)90016-7 |

| [25] |

QIN Xuebin, HE Shida, ZHANG Zichen, et al. Real-time salient closed boundary tracking using perceptual grouping and shape priors[C]//Proceedings of the 28th British Machine Vision Conference. London: BMVC, 2017. 10.5244/C.31.12

|

| [26] |

WERTHEIMER M. Untersuchungen zur Lehre von der Gestalt. Ⅱ[J]. Psychologische Forschung, 1923, 4(1): 301-350. |

| [27] |

STAHL J S, WANG Song. Edge grouping combining boundary and region information[J]. IEEE Transactions on Image Processing, 2007, 16(10): 2590-2606. DOI:10.1109/TIP.2007.904463 |

| [28] |

FELZENSZWALB P F, HUTTENLOCHER D P. Distance transforms of sampled functions[J]. Theory of Computing, 2012, 8(1): 415-428. DOI:10.4086/toc.2012.v008a019 |

| [29] |

FALANGA D, ZANCHETTIN A, SIMOVIC A, et al. Vision-based autonomous quadrotor landing on a moving platform[C]//Proceedings of 2017 IEEE International Symposium on Safety, Security and Rescue Robotics (SSRR). Shanghai, China: IEEE, 2017: 200-207. 10.1109/SSRR.2017.8088164

|

| [30] |

GRISETTI G, STACHNISS C, BURGARD W. Improved techniques for grid mapping with rao-blackwellized particle filters[J]. IEEE Transactions on Robotics, 2007, 23(1): 34-46. DOI:10.1109/TRO.2006.889486 |

| [31] |

TAKAYA K, ASAI T, KROUMOV V, et al. Simulation environment for mobile robots testing using ROS and Gazebo[C]//Proceedings of the 20th International Conference on System Theory, Control and Computing (ICSTCC). Sinaia, Romania: IEEE, 2016: 96-101. 10.1109/ICSTCC.2016.7790647

|

| [32] |

QUIGLEY M, CONLEY K, GERKEY B P, et al. ROS: an open-source robot operating system[C]//ICRA Workshop on Open Source Software. Kobe, Japan: [s.n.], 2009. http://citeseerx.ist.psu.edu/viewdoc/download;jsessionid=672E1A316620349797E62F69B610F7C3?doi=10.1.1.637.7432&rep=rep1&type=pdf

|

| [33] |

SANTOS J M, PORTUGAL D, ROCHA R P. An evaluation of 2D SLAM techniques available in robot operating system[C]//Proceedings of 2013 IEEE International Symposium on Safety, Security, and Rescue Robotics (SSRR). Linkoping, Sweden: IEEE, 2013: 1-6. 10.1109/SSRR.2013.6719348

|