2. 武汉大学时空数据智能获取技术与应用教育部工程研究中心, 湖北 武汉 430079;

3. 中国科学院大地测量与地球物理研究所, 湖北 武汉 430079

2. Engineering Research Center of Space-Time Data Capturing and Smart Application, the Ministry of Education of P. R. C., Wuhan University, Wuhan 430079, China;

3. State Key Laboratory of Geodesy and Earth's Dynamics, Institute of Geodesy and Geophysics of CAS, Wuhan 430077, Chinat

随着城市化的快速进程,城市地下空间的开发与利用愈加受到重视和关注。精准、高效地探测城市地下空间目标,摸清其类型与分布是保障城市地下空间安全的前提和关键。城市地下空间目标既有大量的人工构筑物(如地铁、管廊等),又有复杂的潜在病害(如空洞等)。以摄影和激光扫描为主的测绘手段不具有穿透性,因此无法有效探测城市地下空间目标的形态和分布。探地雷达(ground penetrating radar,GPR)具有高效、无损、可穿透性、成像分辨率高等特点,被广泛运用于地球物理勘探[1]、建筑物质量检测、道路桥梁检测、隧道质量检测、地下目标探测分类等[2]。由于地下目标形态的复杂性、潜在病害的多样性以及空间分布的未知性,对GPR图像的解析仍主要依赖于人机交互,而该方式无法满足大范围城市地下空间探测普查的需求。

目前针对GPR数据的地下目标探测方法主要分为两类,即传统机器学习方法与深度学习方法。传统机器学习方法包括基于霍夫变换提取双曲线特征检测法[3-4]、基于模板匹配的双曲线特征检测法[5-6]、基于特征的梯度方向直方图(histogram of oriented gradients, HOG)和基于哈尔特征学习算法[7-8]等。基于霍夫变换提取双曲线特征检测法受限于处理和离散化大量参数而导致的巨大计算量。基于模板匹配的双曲线特征则需要手工设计大量参数刻画不同的目标特征。而基于特征的梯度方向直方图和基于哈尔特征学习算法的GPR图像地下目标检测方法的自动化和准确率需要进一步提高。近年来,基于深度学习的光学图像目标检测取得了突破性进展[9-12]并在遥感图像识别领域逐渐普及[13-14]。在GPR图像目标检测方面,针对具有双曲线回波特征的地下目标检测,有学者提出了基于FASTER RCNN深度学习方法[15]。虽然无须手工刻画目标特征且检测精度上显著提高,但该类方法与传统GPR目标检测方法一致,通常依赖GPR影像中定位提取双曲线回波特征,实现管道[3-8, 16]、地雷[17]等单类地下目标的识别与提取。城市道路地下目标分布未知且复杂多样,现有方法无法精准定位和提取地下埋藏的多类目标,且时效性难以满足城市道路埋藏物调查对检测效率、目标种类与提取精度方面的实际需求。

针对以上问题,本文提出一种车载探地雷达城市道路地下多目标实时探测方法,分析并确定了GPR影像中7类可识别的城市道路地下空间典型目标(即:雨水井,电缆,稀疏、密集钢筋网,金属、非金属管,空洞),并根据其反射信号特征,创建了典型城市道路GPR地下目标样本库。通过迁移学习的方法,使用扩容后的数据精调已在ImageNet等[18-20]大型数据集上训练后的预训练权重,实现端到端的实时精确检测。

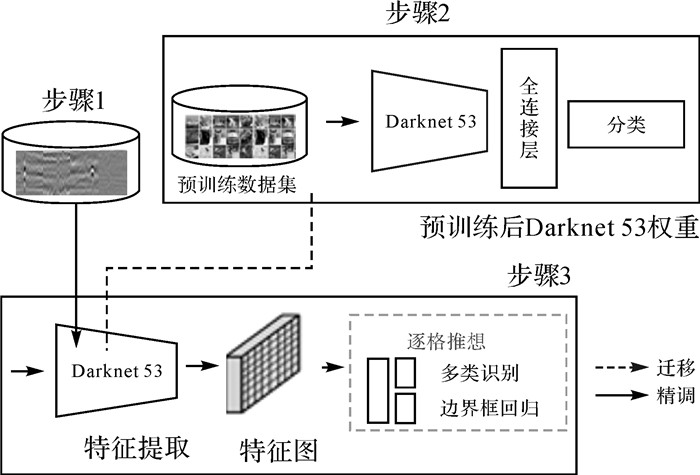

1 基于深度学习的GPR图像地下目标探测本文提出的基于深度学习的GPR图像地下目标探测方法的流程如图 1所示,该方法的关键步骤包括:

|

| 图 1 卷积神经网络GPR图像地下目标检测框架 Fig. 1 Target detection from GPR imagery based on convolutional neural network |

(1) 构建地下目标样本数据集。主要通过人机交互的方式完成地下目标样本标注并进行数据增容,完成地下目标标准数据集的构建。

(2) 采用联合训练机制训练卷积神经网络,联合ImageNet数据集、COCO数据集、PASCAL VOC数据集训练Darknet-53[21]卷积神经网络,获得预训练神经元参数集合。

(3) 训练与推想(Inference)卷积神经网路。采用迁移学习方法,先冻结网络前50层参数集,使用GPR标注数据集训练网。

(4) 网络精调(Fine-tune)51—53层网络权重参数,获得GPR图像地下目标提取卷积神经网络第一阶段参数集,后解冻前50层参数集进行全层训练,训练出可以实时预测多个边界框位置及多个类别的模型。最后载入网络训练后的模型,进行前向传播,推想获得测试数据集中地下目标的位置与类别信息。

1.1 构建地下目标训练数据集针对城市地下空间的几类典型目标(如雨水井、电缆等)训练样本数量不足的问题,本文基于实测的车载GPR图像,利用albumentations[22]库增加实测GPR图像的样本,同时顾及GPR图像的分辨率和地下目标的特征,对GPR图像进行增强、随机裁剪、小角度旋转、模糊化和镜像翻转等处理,从而获得足够的样本对卷积神经网络进行训练。表 1为城市地下空间7类典型目标波形特征表。样本标注过程以表中列举的波形特征作为依据。

| 样本 | 类别 | 特征 |

|

雨水井 | 自顶而下,波形杂乱,黑白相间,与周围波形比较具有突变性 |

|

稀疏钢筋网 | 有黑白相间同相轴,抛物线状,反射强度弱于金属管,成群离散分布 |

|

密集钢筋网 | 黑白相间条状,存在密集波形条纹,反射强度弱于金属管和空洞,连续条状分布 |

|

空洞 | 黑白相间的干涉条纹,与周围波形比较具有突变性,较为平滑且模糊 |

|

金属管 | 抛物线顶部为管线位置,可以清楚看到白色、黑色、白色相间,单曲线回波特征明显 |

|

非金属管 | 抛物线顶部为管线位置,可以清楚看到白色、黑色、白色相间,双曲线回波特征明显 |

|

电缆 | 自上而下,一系列非常明显且有规律的抛物线形多次回波特征明显 |

1.2 地下目标检测骨干网络

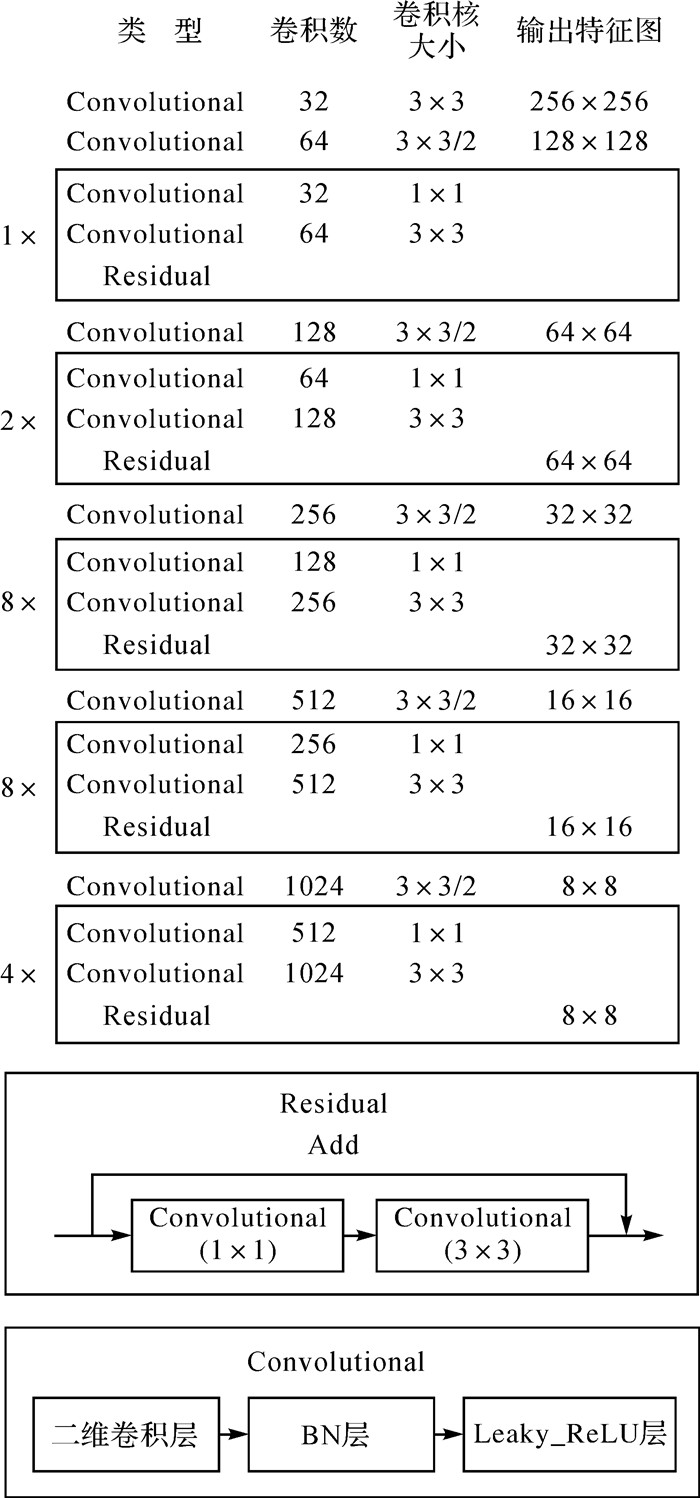

Darknet-53兼顾网络复杂度与检测准确率,与常用的目标检测特征提取网络VGG-16[23-24]相比不仅运算量更少、模型更轻量且有更强的特征提取能力。图 2展示了Darknet-53的结构。它由连续的3×3和1×1卷积核组成,在充分提取图片特征的情况下减少了网络参数量。借鉴Resnet思想加入残差(Res)块以解决网络因层数较深而导致的梯度弥散或者梯度爆炸的现象[23],将传统深层神经网络的逐层训练调整为逐阶段训练。除此以外,各卷积层后都接有Batch_Normalize(BN)层[25]和LeakyReLU层[26],简化计算量的同时加速收敛,并且防止模型过拟合。

|

| 图 2 Darknet-53网络结构 Fig. 2 Darknet-53 network |

1.3 神经网络训练与推想

本文的网络训练方法遵循YOLO v3[21]提出的网络训练方法,网络使用由k均值聚类得到的锚框(anchor box)来辅助预测边界框,并且训练逻辑回归分类器预测每个边界框的对象分数。每个框可以预测边界框包含的多个类别。神经网络直接对GPR图像进行卷积后形成特征图,并对特征图逐格预测地下目标位置和概率。算法核心在于将地下目标检测问题转化为回归问题,实现了端到端(end to end)的检测。

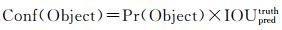

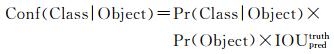

输入GPR图像后,经CNN卷积形成N×N的特征图(feature map),由于YOLO v3的多层检测,N的取值分别为13、26、52。如果目标的中心落在某个网格单元中,那么该网格单元就负责推理该目标。本文方法中设置每个网格单元都会预测3个边界框,如原始框架一样,则每个边界框输出12个预测结果,即x、y、w、h,置信度和7个条件类别概率。(x,y,w,h)是通过原始预测结果计算出来的绝对坐标,x、y表示边界框的中心相对于图片边界的值,w、h则是边界框的长、宽。置信度计算公式为

(1)

(1)

如果真实标签框(ground truth)的中心不落在该单元格,则置信度为零。否则,置信度分数等于预测框与真实标签框之间的交并比(IOU)。另外,每个格网预测了7个条件类别概率Pr(Class|Object),这些概率是以网格单元包含目标为条件。每个框特定类别的置信度计算公式如下

(2)

(2)

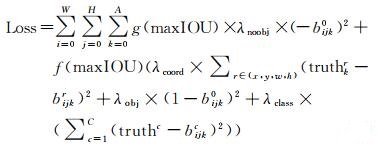

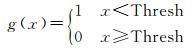

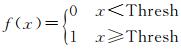

本文使用输出和实际N×N×(2×5+7)维向量的平方和误差作为损失函数优化参数,在计算损失函数时为了加强对小目标的检测引入λcoord=(2-truthwtruthh)修正坐标误差,而λobj和λclass均设置为1使得模型在训练中可以收敛。最终的loss函数为

(3)

(3)

(4)

(4)

(5)

(5)

损失函数主要分为3大部分, 坐标损失、置信度损失及分类损失。损失函数中maxIOU表示该cell预测的框与真值框的最大IOU,Thresh为预先设置的阈值0.6。bijk0为预测框体的置信度,truthkr和bijkr分别表示真实框体的坐标和预测框体的坐标,最后truthc和bijkc则分别表示真实框体的类别和预测框体的类别。Loss依旧沿用YOLO v1采用SSE(the sum of squares due to error)计算。

YOLO v3算法设计中采用多标记分类,从而强化了边界框包含多类别的能力。通常一个目标往往只落在一个网格单元中,然而一些大目标或接近多个网格单元的边界的目标能被多个网格单元预测。YOLO v3之前的YOLO算法只能为每个目标预测一个边界框,因此模型极可能会发生漏检现象。与YOLO9000[27]不同,YOLO v3摒弃了对于提升网络检测多目标性能具有一定局限性的softmax函数[21],而是使用单独的逻辑分类器进行多标签预测,并且在训练过程中,使用了二元交叉熵损失计算类别损失。

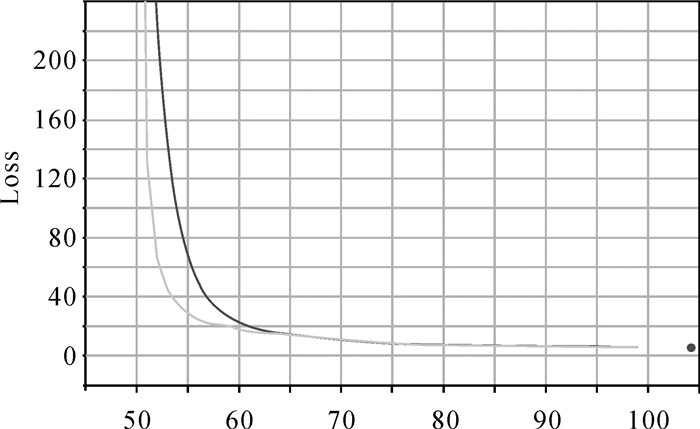

本文方法使用Adam[28]替代了传统随机梯度下降(stochastic gradient descent, SGD)优化算法。与深度学习其他优化算法类似,在训练数据的基础上反向传播后迭代地更新神经网络权重,是一种参数自适应学习率的方法。由图 3中loss下降曲线可知,在训练数据集上经过约85个epochs迭代训练后loss值不再变化,最终得到稳定模型,在Keras上Loss稳定值约为5。

|

| 图 3 Loss值曲线图 Fig. 3 The line chart of Loss value |

地下目标检测的步骤是先对输入的GPR图像进行特征图的提取,后逐格网判断其中是否含有地下目标。与网络训练过程前向传播相同,输入的GPR图像中地下目标只需要进行一次预测,即可得到每张图像中可能目标的边界框和每个框的目标类别及其概率,后根据预先设置的阈值提炼预测结果。根据实际情况,本文将IOU阈值设置为0.3,置信度阈值设置为0.5。

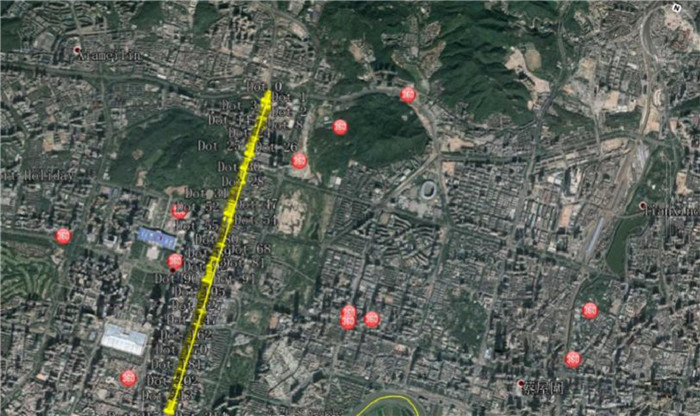

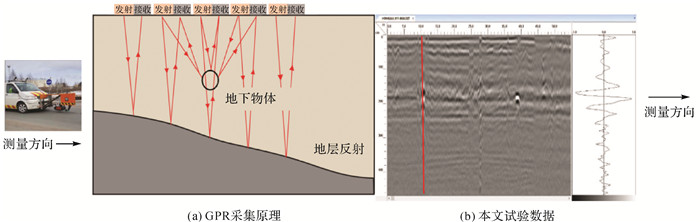

2 GPR图像地下目标探测试验与分析为验证本文方法的有效性,分别利用SIR-30车载GPR系统采集的深圳市彩田路中往返两条路线的GPR数据进行试验验证(图 4)。GPR采集原理如图 5(a)所示,本次试验数据样例如图 5(b)所示,其中右侧单点波形对应红线标注位置。GPR采集频段、采集范围与场景类别见表 2。为了保证模型收敛而不过拟合,本文对数据进行了增容,增容后保证loss收敛于一个合适范围。表 3展示了专家解译的样本数量和数据增容后的样本数量。

|

| 图 4 SIR-30车载雷达深圳市测试路段(谷歌地球) Fig. 4 SIR-30 vehicle radar Shenzhen test section(Google Earth) |

|

| 图 5 SIR-30车载雷达工作原理及样例 Fig. 5 Working principle and sample of SIR-30 vehicle-borne radar |

| 仪器型号 | 天线中心频率/MHz | 地点 | 场景类别 | 采集长度/km | 扫描方式 |

| SIR-30 | 400 | 深圳彩田右车道 | 城市 | 4.52 | 车载连续 |

| SIR-30 | 400 | 深圳彩田左车道 | 城市 | 4.66 | 车载连续 |

| 类别 | 数量 | |

| 人工解译 | 增容后 | |

| 雨水井 | 57 | 570 |

| 电缆 | 32 | 581 |

| 金属管 | 42 | 571 |

| 非金属管 | 17 | 246 |

| 稀疏钢筋网 | 87 | 264 |

| 致密钢筋网 | 92 | 307 |

| 空洞 | 162 | 494 |

| 总计 | 489 | 3033 |

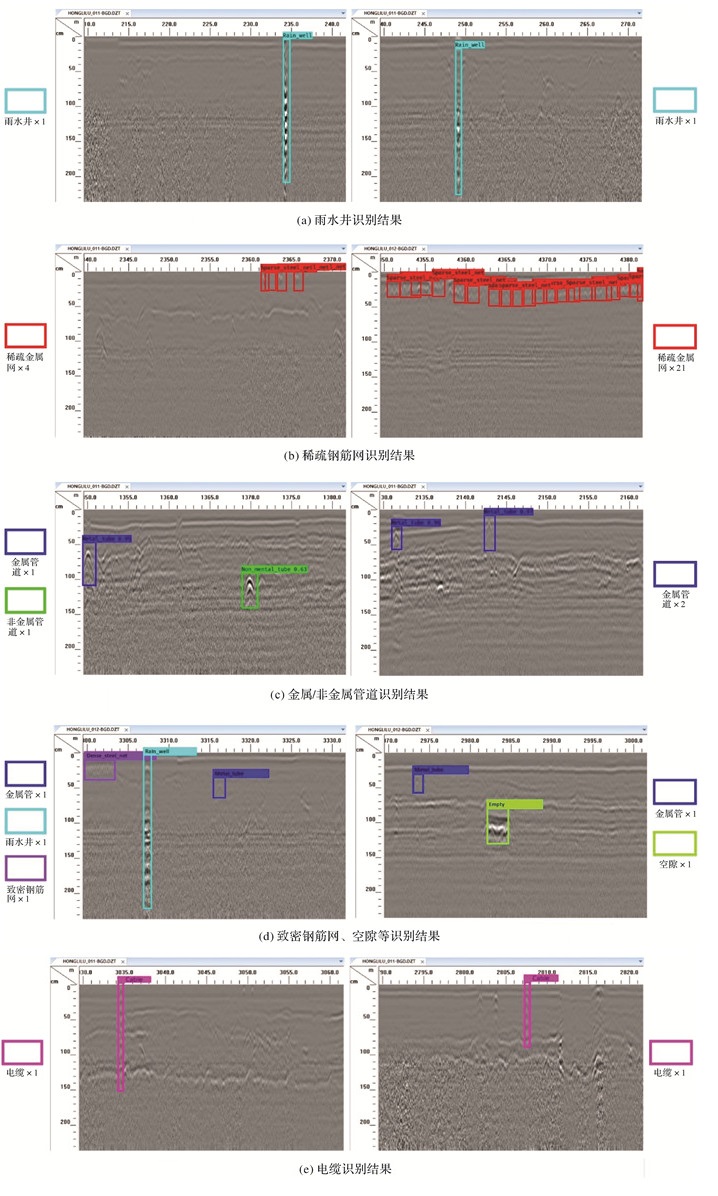

2.1 地下目标探测结果

本文的测试数据为SIR-30车载探地雷达系统以400 MHz频率获取的深圳市数据。图 6为训练后的神经网络识别GPR波形图像数据中雨水井、稀疏/密集钢筋网、桥梁、金属/非金属管道、电缆等目标的试验结果。深度学习预测结果表明,本文提出的方法能够根据GPR图像对地下目标的类型与位置进行准确的探测与定位。

|

| 图 6 GPR图像地下目标识别结果 Fig. 6 Underground target detection from GPR imagery |

2.2 地下目标探测结果评价

在地下目标探测的分类任务中,通常利用准确率(precision)和召回率(recall)这两项指标对网络模型的性能表现进行衡量,并且计算F1 score来综合评价precision和recall。在分类任务中,准确率表示被正确识别分类目标占总目标的比例。而召回率表示在某类别目标最终被划分到该类目标的比例。准确率体现了模型对影像中背景的区分能力,准确率越高说明检测模型对复杂背景的区分能力越强。召回率体现了模型对GPR影像中目标的检索能力,召回率越高说明检测模型对地下目标的探测能力越强。F1 score是两者的综合表达,其分值越高,说明分类模型在高召回的基础上有高精度,即模型越稳健。3个指标的计算公式如下

(6)

(6)

(7)

(7)

(8)

(8)

式中,TP表示正确探测到的目标数量;FP表示未被探测到的目标数量;FN表示错误探测到的目标数量。表 4列出了深圳彩田试验区内一条长距离道路下的GPR图像目标检测结果。

| 类别 | 指标 | ||

| 召回率 | 精度 | F1值 | |

| 雨水井 | 0.912 | 0.954 | 0.932 |

| 电缆 | 0.923 | 0.857 | 0.889 |

| 金属管 | 0.852 | 0.920 | 0.885 |

| 非金属管 | 0.833 | 0.833 | 0.833 |

| 稀疏钢筋网 | 0.942 | 0.867 | 0.903 |

| 密集钢筋网 | 0.969 | 0.839 | 0.900 |

| 空洞 | 0.816 | 0.816 | 0.816 |

| 均值 | 0.892 | 0.869 | 0.880 |

实际的试验结果表明本文设计的深度学习方法的最终recall、precision、F1 score的均值在85%以上。3项指标的综合评价可以看出本文设计的深度学习方法对于GPR图像地下目标探测与缺陷检测十分有效。实际场景测试结果表明:该方法可对车载GPR图像进行以上7类地下目标的实时探测与定位,在试验平台(GTX1080)上检测速度可达16帧/s,满足实际工程实时检测需要。

2.3 与其他GPR目标探测方法对比本文选用3种其他GPR目标探测方法与本文方法进行对比,包括两种传统方法,即模板匹配算法[5]与HOG+SVM[7], 一种深度学习方法,即Faster RCNN[15]。

由于传统方法仅能完成单目标识别,为保证试验对比公平性,采用金属管类别对4种方法的召回率、精度、F1值、耗时进行统计。对比结果见表 5。对比传统方法,深度学习的方法(Faster RCNN,本文方法)取得了较大的领先,F1达到88%以上水平,传统方法分别为77%与69%。在耗时方面,深度学习类方法也领先于传统方法一个数量级。其中Faster RCNN取得了最优的F1值,相较于本文方法有0.7%的提升。但其在检测时间上却是本文方法的近5倍,难以做到实时检测,且在实际训练中更加耗时。检测效率对道路检测来说是极其重要的,所以相对于Faster RCNN,本文方法更具实际使用价值。

| 方法 | 指标 | |||

| 召回率 | 精度 | F1值 | 耗时/s | |

| 模板匹配算法 | 0.64 | 0.762 | 0.695 | 6.42 |

| HOG+SVM | 0.733 | 0.827 | 0.777 | 1.55 |

| Faster RCNN(Resnet50) | 0.854 | 0.933 | 0.892 | 0.27 |

| 本文方法(Darknet53) | 0.852 | 0.920 | 0.885 | 0.06 |

3 结论

为解决城市道路地下多目标高效精准探测问题,本文提出一种车载探地雷达城市道路地下多目标实时探测方法,并通过城市道路GPR数据验证了方法的检测能力,证实通过GPR数据深度学习手段进行地下多目标检测的可行性。本文方法克服了传统单一地下目标检测的局限,通过7类地下目标波形特征人工制作GPR影像数据集进行训练,使用图像增容和迁移学习联合方法对参数进行微调,最终实现了可端到端实时精确检测地下多目标的检测模型。模型检测结果证明了深度学习方法对GPR影像中地下多类目标进行检测的有效性,相比于传统方法在GPR影像地下单目标检测上的性能,本文的深度学习方法在检测效率和性能上更具优势。目前,本文的方法仅探测到目标的类别与位置,下一步将结合地下目标的结构信息(埋深、面积、长宽比等)构造特征空间,并使用随机森林提取这些特征用于辅助判断目标类别,从而进一步提升探测质量。

| [1] |

张恩泽.探地雷达在城市工程勘察中的应用研究[D].淮南: 安徽理工大学, 2017. ZHANG Enze. Ground penetrating radar (GPR) application in urban engineering survey research[D]. Huainan: Anhui University of Science and Technology, 2017. http://cdmd.cnki.com.cn/Article/CDMD-10361-1017187176.htm |

| [2] |

WAI-LOK LAI W, DÉROBERT X, ANNAN P. A review of ground penetrating radar application in civil engineering:a 30-year journey from locating and testing to imaging and diagnosis[J]. NDT & E International, 2018, 96(6): 58-78. |

| [3] |

WINDSOR C G, CAPINERI L, FALORNI P. A data pair-labeled generalized Hough transform for radar location of buried objects[J]. IEEE Geoscience and Remote Sensing Letters, 2014, 11(1): 124-127. |

| [4] |

LI Wentao, CUI Xihong, GUO Li, et al. Tree root automatic recognition in ground penetrating radar profiles based on randomized Hough transform[J]. Remote Sensing, 2016, 8(5): 430-445. DOI:10.3390/rs8050430 |

| [5] |

SAGNARD F, TAREL J P. Template-matching based detection of hyperbolas in ground-penetrating radargrams for buried utilities[J]. Journal of Geophysics and Engineering, 2016, 13(4): 491-504. DOI:10.1088/1742-2132/13/4/491 |

| [6] |

TERRASSE G, NICOLAS J M, TROUVÉ E, et al. Automatic localization of gas pipes from GPR imagery[C]//Proceedings of the 2016 24th European Signal Processing Conference. Budapest, Hungary: IEEE, 2016: 1235-1248.

|

| [7] |

TORRIONE P A, MORTON K D, SAKAGUCHI R, et al. Histograms of oriented gradients for landmine detection in ground-penetrating radar data[J]. IEEE Transactions on Geoscience and Remote Sensing, 2014, 52(3): 1539-1550. DOI:10.1109/TGRS.2013.2252016 |

| [8] |

MAAS C, SCHMALZL J. Using pattern recognition to automatically localize reflection hyperbolas in data from ground penetrating radar[J]. Computers & Geosciences, 2013, 58(8): 116-125. |

| [9] |

GOODFELLOW I, BENGIO Y, COURVILLE A. Deep learning[M]. Cambridge, MA: MIT Press, 2016.

|

| [10] |

何海威, 钱海忠, 谢丽敏, 等. 立交桥识别的CNN卷积神经网络法[J]. 测绘学报, 2018, 47(3): 385-395. HE Haiwei, QIAN Haizhong, XIE Limin, et al. Interchange recognition method based on CNN[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(3): 385-395. DOI:10.11947/j.AGCS.2018.20170265 |

| [11] |

余东行, 郭海涛, 张保明, 等. 级联卷积神经网络的遥感影像飞机目标检测[J]. 测绘学报, 2019, 48(8): 1046-1058. YU Donghang, GUO Haitao, ZHANG Baoming, et al. Aircraft detection in remote sensing images using cascade convolutional neural networks[J]. Acta Geodaetica et Cartographica Sinica, 2019, 48(8): 1046-1058. DOI:10.11947/j.AGCS.2019.20180471 |

| [12] |

董志鹏, 王密, 李德仁, 等. 遥感影像目标的尺度特征卷积神经网络识别法[J]. 测绘学报, 2019, 48(10): 1285-1295. DONG Zhipeng, WANG Mi, LI Deren, et al. Object detection in remote sensing imagery based on convolutional neural networks with suitable scale features[J]. Acta Geodaetica et Cartographica Sinica, 2019, 48(10): 1285-1295. DOI:10.11947/j.AGCS.2019.20180393 |

| [13] |

GONG Jianya, JI Shunping. Photogrammetry and deep learning[J]. Journal of Geodesy and Geoinformation Science, 2018, 1(1): 1-15. |

| [14] |

FAN Dazhao, DONG Yang, ZHANG Yongsheng. Satellite image matching method based on deep convolutional neural network[J]. Journal of Geodesy and Geoinformation Science, 2019, 2(2): 90-100. |

| [15] |

PHAM M T, LEFÉVRE S. Buried object detection from B-scan ground penetrating radar data using Faster-RCNN[C]//Proceedings of 2018 IEEE International Geoscience and Remote Sensing Symposium. Valencia, Spain: IEEE, 2018.

|

| [16] |

CHRISTOFF N, MANOLOVA A, JORDA L, et al. Morphological crater classification via convolutional neural network with application on MOLA data[C]//Proceedings of 2018 Advances in Neural Networks and Applications. St. Konstantin and Elena Resort, Bulgaria: VDE, 2018.

|

| [17] |

LAMERI S, LOMBARDI F, BESTAGINI P, et al. Landmine detection from GPR data using convolutional neural networks[C]//Proceedings of the 2017 25th European Signal Processing Conference (EUSIPCO). Kos, Greece: IEEE, 2017: 508-512.

|

| [18] |

RUSSAKOVSKY O, DENG Jia, SU Hao, et al. ImageNet large scale visual recognition challenge[J]. International Journal of Computer Vision, 2015, 115(3): 211-252. DOI:10.1007/s11263-015-0816-y |

| [19] |

EVERINGHAM M, ESLAMI S M A, VAN GOOL L, et al. The PASCAL visual object classes challenge:a retrospective[J]. International Journal of Computer Vision, 2015, 111(1): 98-136. |

| [20] |

CHEN Xinlei, FANG Hao, LIN T Y, et al. Microsoft COCO captions: data collection and evaluation server[EB/OL]. (2019-02-20)[2019-06-02]. http://cocodataset.org/.

|

| [21] |

REDMON J, FARHADI A. YOLOv3: an incremental improvement[EB/OL]. (2018-04-24)[2019-06-02]. https://github.com/pjreddie/darknet.

|

| [22] |

BUSLAEV A, PARINOV A, KHVEDCHENYA E, et al. Albumentations: fast and flexible image augmentations[EB/OL]. (2019-05-21)[2019-06-02]. https://github.com/albumentations-team/albumentations.

|

| [23] |

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[C]//Proceedings of the 3rd International Conference on Learning Representations.[S.l.]: ICLR, 2015.

|

| [24] |

戴玉超, 张静, PORIKLI F, 等. 深度残差网络的多光谱遥感图像显著目标检测[J]. 测绘学报, 2018, 47(6): 873-881. DAI Yuchao, ZHANG Jing, PORIKLI F, et al. Salient object detection from multi-spectral remote sensing images with deep residual network[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(6): 873-881. DOI:10.11947/j.AGCS.2018.20170633 |

| [25] |

IOFFE S, SZEGEDY C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]//Proceedings of the 32nd International Conference on Machine Learning.[S.l.]: ICML, 2015: 448-456.

|

| [26] |

CLEVERT D A, UNTERTHINER T, HOCHREITER S. Fast and accurate deep network learning by exponential linear units (ELUs)[C]//Proceedings of the 4th International Conference on Learning Representations.[S.l.]: ICLR, 2015: 375-387.

|

| [27] |

REDMON J, FARHADI A. YOLO9000: better, faster, stronger[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI: IEEE, 2017: 7263-7271.

|

| [28] |

KINGMA D P, BA J L. Adam: a method for stochastic optimization[C]//Proceedings of the 3rd International Conference on Learning Representations. San Diego, CA: ICLR, 2015: 6980-6992.

|