2. 武汉大学测绘学院, 湖北 武汉 430079

2. School of Geodesy and Geomatics, Wuhan University, Wuhan 430079, China

在城市环境中实现完全无人驾驶依赖于准确的环境感知算法,获取道路边界点是环境感知算法的重要任务[1]。精确的道路边界不仅为无人驾驶汽车提供安全的可通行区域,而且可以用于无人驾驶汽车的定位与建图[2]。

城市道路边界大部分(直道、弯道)具有全局连续性特征,结合多种局部特征,边界可以被稳健地探测到,已有多种方法达到了较好的效果。在这些方法中使用的传感器包括:单目摄像头[3-4]、单线激光雷达[5-6]及多线激光雷达[7]。多线激光雷达与其他传感器相比具有以下优点[8]:①相对于视觉传感器[9],对环境的光照变化不敏感;②能够实时、精确地获取车辆周围环境的3D信息。因此,多线激光雷达近年来被广泛应用于无人驾驶汽车的环境感知任务。目前,无人驾驶汽车上常用的多线激光雷达有16线、32线和64线3种,其中64线和32线激光雷达使用最多,公开的数据集大部分也是使用这两种激光雷达,如KITTI数据集[10]、NCLT数据集[11]等。随着激光测量技术的发展,16线激光雷达因为其有竞争力的价格被越来越多的车企、创业公司以及高校采用。实现适用于16线激光雷达的道路边界点提取算法,对推广无人驾驶技术有积极的意义。

国内外对基于多线激光雷达的道路边界点提取方法有深入的研究,目前主要研究成果分为两类:计算单一尺度空间特征的道路边界点提取方法[12-14]和计算多尺度空间特征的道路边界点提取方法[15-16]。第1类研究主要有:文献[12]将3D点云映射到2D栅格中,利用3种局部特征(栅格内高程差、相邻栅格梯度和法向量)提取道路边界栅格,获取道路边界点。栅格映射是道路边界探测中常用的方法,然而由于多线激光雷达获取的点云分布不均匀,导致许多栅格为空,浪费了存储和计算资源。此外,栅格尺寸大小的设置需要根据扫描数据的特性进行多次试验:栅格过大,容易丢失细节,损失探测精度;栅格过小,如果数据稀疏,常常探测不到道路边界点。文献[13]对路面点进行平面拟合,根据道路边界高度进而获取候选道路边界点,最后通过对候选道路边界点进行曲线拟合获得道路边界点。该方法基于道路边界高度特征进行道路边界点的提取,但是由于道路边界特征多样性(草丛路边、石头路边)和路内障碍物遮挡,很难建立固定模型对道路边界进行准确、可靠的识别。文献[14]首先根据光线传播方法对点云进行分割得到多个部分,然后采用滑动窗口方式逐线提取道路边界点。该方法主要根据道路边界点之间空间特征与非道路边界点之间空间特征的区别,提取道路边界点。该方法仅考虑点之间空间特征而忽略了道路趋势信息,容易将非道路边界点识别为道路边界点,方法精确率不高。第2类是计算多尺度空间特征的道路边界点提取方法,目前研究主要有:文献[15]在利用基于滑动窗口的光线传播方法将道路分割成多个部分后,先利用最小二乘拟合平面模型计算大尺度空间特征,随后计算点与点之间的小尺度空间特征,进而提取道路边界点。文献[16]首先利用小尺度空间特征选取后续道路边界点,再利用候选道路边界点进行道路边界拟合,对候选道路边界点进行滤波,提取道路边界点。第1类方法通过计算单一尺度空间特征提取道路边界点,计算速度快但提取道路边界点的精确率较低。第2类方法兼顾了计算大中尺度和小尺度空间特征的优点,但选择的大中尺度和小尺度空间特征,对道路边界点的提取结果会造成较大影响。

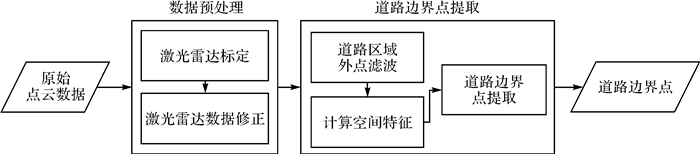

基于以上分析,本文提出一种道路空间特征和测量距离相结合的道路边界点提取方法:通过计算多种空间特征,结合激光雷达测量距离,能够准确稳定地从16线激光雷达获取的稀疏点云中提取道路边界点。由于汽车多行驶在城市环境中,本文着重探究城市环境下结构化道路边界点的提取。图 1为本文道路边界点提取方法流程。

|

| 图 1 本文道路边界点提取方法流程 Fig. 1 The workflow of road curb points extraction method proposed in this paper |

1 数据预处理

利用16线激光雷达进行道路边界点提取,首先需要对激光雷达获取的数据进行预处理。预处理步骤包括16线激光雷达的标定和数据修正。

本文所采用的16线激光雷达从上至下共有16根扫描线,竖直角度跨度为-15°~15°,竖直角度分辨率为2°,每根扫描线对应的竖直角度见表 1。16线激光雷达的其他参数为:水平角度跨度为360°,水平角度分辨率为0.2°;扫描频率为10 Hz;测距精度为±3 cm,最小测程为0.5 m,最大测程为150 m。

| laser ID | θi/(°) | laser ID | θi/(°) | laser ID | θi/(°) |

| 0 | -15 | 6 | -9 | 12 | -3 |

| 1 | 1 | 7 | 7 | 13 | 13 |

| 2 | -13 | 8 | -7 | 14 | -1 |

| 3 | 3 | 9 | 9 | 15 | 15 |

| 4 | -11 | 10 | -5 | - | - |

| 5 | 5 | 11 | 11 | - | - |

1.1 16线激光雷达标定

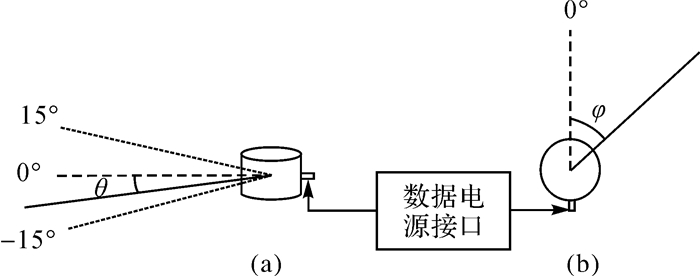

16线激光雷达原始数据为每个激光点的测量距离dist、水平角度φ和垂直角度θ(图 2),为了将原始激光点pis(disti,φi,θi)统一到车体的载体坐标系piv(xi,yi,zi)中,需要对安装后的16线激光雷达进行标定。

|

| 图 2 16线激光雷达侧视图和俯视图 Fig. 2 Side view and top view of 16-ray LiDAR |

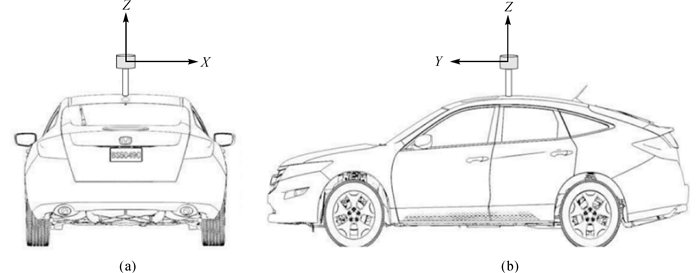

车辆正前方为载体坐标系Y轴正方向,车辆右侧为X轴正方向,载体坐标系原点为激光雷达中心。16线激光雷达安装在车辆顶部,安装后激光雷达与车辆保持水平,如图 3所示。因为本文未使用其他传感器进行边界点提取,且在安装上确保了激光雷达与车体保持水平,本文描述的16线激光雷达标定消除了激光雷达球坐标水平0°方向与载体Y轴方向之间的夹角∂。本文采用的标定方法参考了文献[17—20]。

|

| 图 3 16线激光雷达安装示意 Fig. 3 Installation diagram of 16-ray LiDAR |

本文中激光雷达的标定原理为:根据同名点在激光雷达坐标系的坐标和载体坐标系下的坐标计算夹角∂。具体步骤为:①将载体驶入有明显标志物的标定场地,在该场地内可以获取标志物在载体坐标系下的坐标;②保存16线激光雷达数据,获取标志物在激光雷达坐标系下的坐标;③计算旋转平移矩阵,并转为欧拉角,获得夹角∂。

16线激光雷达测量得到的激光点原始数据pis(disti,φi,θi)通过式(1)转换得到激光点在载体坐标系下的坐标piv(xi,yi,zi)

(1)

(1)

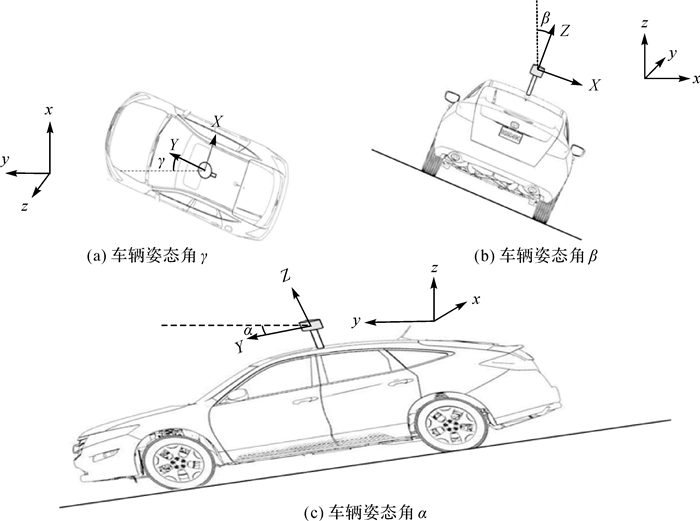

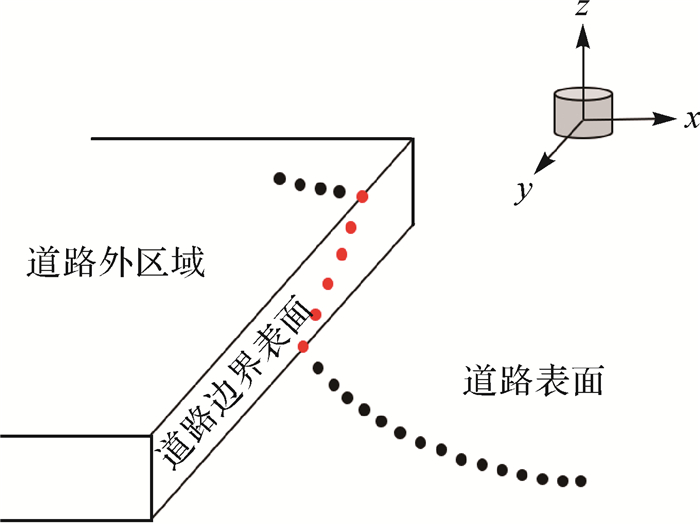

16线激光雷达测量数据修正主要包括以下方面:首先,在激光雷达的一个扫描周期内,无人驾驶汽车的移动使得激光雷达原点的位置发生显著位移,如果不修正无人驾驶汽车行驶过程中对测量数据的影响,会使得在一个扫描周期内的同一条激光线上的测量点出现局部扭曲;其次,在一个扫描周期内,汽车的姿态变化也会对道路边界检测产生较大影响。为了保证道路边界检测的准确性,必须对16线激光雷达测量的原始数据进行修正。图 4展示了车辆姿态角γ、β和α。

|

| 图 4 扫描周期内车辆姿态变化 Fig. 4 Schematic of vehicles posture changing under vehicle motion condition |

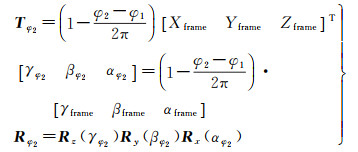

16线激光雷达扫描一帧所需要的时间较短,可以认为同一帧内车辆的位置和姿态(位姿)变化近似线性变化,因此一帧内每一时刻车辆的位姿可以通过前后两帧车辆的位姿插值获得。通过无人驾驶汽车上的传感器可以获得每一帧的位置变化量(Xframe,Yframe,Zframe)和姿态变化量(γframe,βframe,αframe),当前帧的位姿与上一帧的位姿相减获得位姿变化量。每一帧中每一时刻的位姿变化量可通过线性插值获得,将位姿变化量进行转换可得到矫正车辆移动的平移向量T和旋转矩阵R。假设当前帧的起始水平旋转角为φ1,多线激光雷达扫描到φ2时,Tφ2和Rφ2通过式(2)获得

(2)

(2)

获得平移向量和旋转矩阵后,16线激光雷达在水平角度φ2测量得到的原始数据经过转换,获得的载体坐标系下的点piv经过式(3)纠正,可得到矫正后的点piv′

(3)

(3)

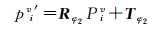

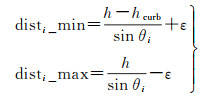

16线激光雷达数据修正结果如图 5所示。

|

| 图 5 16线激光雷达数据修正 Fig. 5 16-ray LiDAR data correction |

2 道路边界点提取

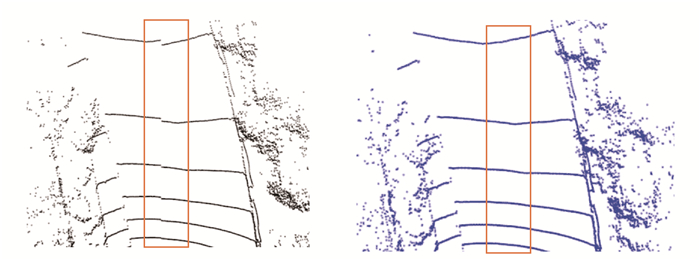

图 6展示了结构化道路属性信息,基于多线激光雷达的道路边界点提取即在点云中提取红色扫描点。本文采用多种空间特征,并结合道路边界点的测量模型提出了一种适用于16线激光雷达数据的道路边界点提取算法。

|

| 图 6 结构化道路属性信息 Fig. 6 Structured road geometry description |

2.1 基于大尺度空间特征的道路外区域点滤波

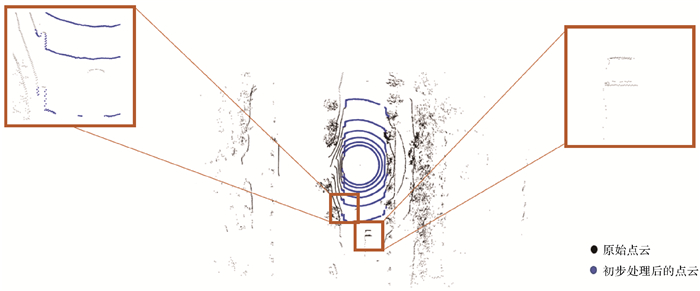

为了保证道路边界点提取方法的实时性和精度,首先对原始点云进行初步处理,去除大量道路外区域的点。初步处理过程如下:选用RANSAC算法进行平面拟合[21]获得平面模型参数,设定高程阈值为0.25 m,将所有点代入平面模型中,保留低于高程阈值的点。RANSAC算法是从一组含有噪声的数据中正确估计数学模型参数的迭代算法。该算法步骤如下:①随机选取可以估计出模型的最小数据集;②计算模型参数;③将所有数据代入模型,计算内点(符合当前模型的数据)数目;④比较当前模型和之前推出的最好的模型的内点数量,记录最大内点数的模型参数和内点数;⑤重复①—④步,直到迭代结束或当前模型符合迭代终止条件。RANSAC算法可以从包含道路外区域点的点云中,精确估计道路平面模型参数。相对于利用最小二乘方法获取道路平面模型参数,RANSAC算法具有更强的稳健性[22]。处理结果如图 7所示,初步处理剔除了大部分道路外区域点,在保留点中存在着部分非道路边界点。后续步骤中通过计算小尺度空间特征,逐步剔除非道路边界点,最后提取到正确的道路边界点。

|

| 图 7 初步处理后的结果 Fig. 7 The result of preliminary process |

2.2 基于小尺度空间特征和测量距离的道路边界点提取

16线激光雷达扫描得到的道路边界点存在很多不同于道路表面点的空间特征,例如道路边界点高度高于道路表面点、同条扫描线中道路边界点之间的水平距离大于道路表面点之间的水平距离以及道路边界点之间的高度变化较大等。本文基于每条扫描线中点与点之间空间特征,并结合道路边界点的测量模型,设计了4种指标来提取道路边界点,如图 8所示。

|

| 图 8 小尺度空间特征 Fig. 8 Interpretation of small-scale spatial features |

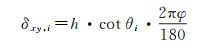

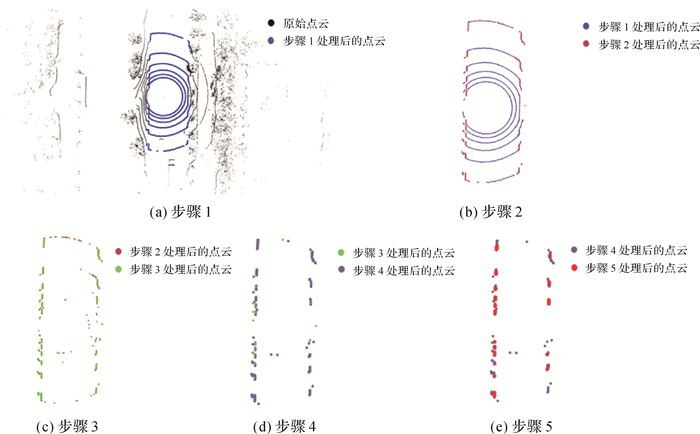

(1) 水平连续性指标:相邻两点间的水平距离阈值δxy, i

(4)

(4)

式中,h为16线激光雷达安装高度(本文中h=2 m);θi为16线激光雷达中Laser ID为i对应的激光线的垂直角度;φ为水平角度分辨率(在本文中φ=0.2)。如果激光扫描在道路边界上,得到的点之间的水平距离大于δxy, i。

(2) 垂直连续性指标:相邻两点间的高度阈值δz,δz设置为固定值(本文中δz=0.02 m)。

(3) 测量距离:最小距离阈值disti_min和最大距离阈值disti_max

(5)

(5)

式中,h_curb为道路边界高度(本文中设置为0.15);ε为测量误差,根据16线激光雷达的参数得知,ε=0.03 m。如图 8所示,当16线激光雷达扫描到道路边界最下方时,达到测量到道路边界的最大距离,当16线激光雷达扫描到道路边界最上方时,达到测量到道路边界的最小距离。因此测量距离也可以作为一个空间特征加以利用,进而提取道路边界点。

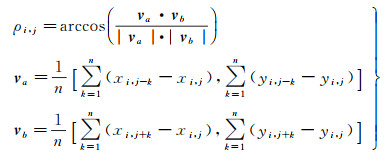

(4) 相邻点构成的水平面向量夹角ρi, j

(6)

(6)

式中,va和vb是同时起始于点Pi, j(指Laser ID为i条激光线中的第j个点)的两个在xy平面的向量;n指相邻点的数目(在本文中n=10),从Pi, j向前或先后n个点,由这些点计算出平面向量。如图 8中A和B两点,此时n=2,点A位于道路边界表面,起始于A点的两个向量vaA和vbA的夹角度数近似180°,点B位于道路表面,起始于B点的两个向量vaB和vbB夹角度数小于180°。本文根据这个特性来提取道路边界点,方法如下。

输入:Laser ID为0、2、4、6、8、10的激光测量的点云P1,迭代次数K,阈值t,阈值δz

输出:道路边界点P2

步骤1:利用RANSAC算法得出最优平面模型,计算P1中点Pi, j1(第i条激光中第j个点)与最优平面的距离di, j,如果di, j < t,保留Pi, j1。

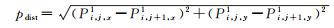

步骤2:对每条激光线中满足步骤1的所有点Pi, j1,计算相邻点的水平欧氏距离pdist,判断水平连续性

(7)

(7)

如果pdist < δxy, l,保留Pi, j1。

步骤3:对满足步骤2的所有点Pi, j1,计算垂直偏差ΔZ,判断垂直连续性

(8)

(8)

如果ΔZ>δz,保留Pi, j1。

步骤4:对满足步骤3的所有点Pi, j1,从原始数据中获取测量距离disti, j,判断是否测量距离在检测道路边界的合理范围内。如果disti, j∈ [disti_min disti_max],保留Pi, j1。

步骤5:对满足步骤4的所有点Pi, j1,从P1中找到其在同一条激光线中的前后n个相邻点,构成水平面上的向量,通过公式计算向量夹角。在道路边界表面上的点,从该点出发构成的水平面上的向量之间的夹角近似180°。在试验中发现,将夹角阈值设置为160°能取得较好的效果。如果Pi, j1的夹角大于160°,则将该点加入P2。

图 9展示了本文提出的道路边界点提取方法的流程以及每一步处理完的效果。从步骤1到步骤5,每次都对候选的道路边界点进行了筛选,直到提取出道路边界点。

|

| 图 9 各步骤处理结果 Fig. 9 The results of each step |

3 试验及结果分析

为了充分评价本文提出的道路边界点提取方法表现,试验选择包含典型交通场景的城区道路环境作为试验区域,5种道路边界点提取方法同本文中提出的道路边界点提取方法进行比较,这5种方法为文献[12]、文献[13]、文献[14]、文献[15]、文献[16]中的方法。

试验区域为典型的城市交通场景(图 10),道路长度为5 km。该区域包括直道、“T”形路口和“Y”形路口场景,场景中存在大货车、小汽车、自行车和人等主要交通参与者。试验平台为吉利电动车,采集数据时车辆的行驶速度为40 km/h。总计采集数据本文16线激光雷达测量数据2400帧,选取了不连续的80帧作为验证道路边界点提取方法性能的数据集(直道场景50帧,“T”形路口场景和“Y”形路口场景各15帧),并对获取数据中的道路边界点进行人工标注。每帧16线激光雷达数据包含约3万个点。

|

| 图 10 试验场景 Fig. 10 The experimental scene |

3.1 评价指标

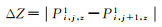

本文评价道路边界点提取方法性能的指标参考了机器学习中评价分类器性能的指标。在机器学习中,对于二分类问题常用的评价度量是精确率和召回率[23]。精确率表示判断为正例的例子中,真正为正例的比例;召回率表示所有正例中,被判断为正例的比例。在评价多个分类器性能时,可能存在某个分类器召回率很高,精确率很低,另一个分类器精确率很高,召回率很低,此时仅使用单一的性能度量,不能很好地评价分类器性能。为了解决如何判断分类器性能的问题,文献[24]设计了一些综合考虑精确率和召回率的性能度量,例如F1得分,它是精确率和召回率的调和值。因此本文选用精确率Precision、召回率Recall以及F1得分作为评价道路边界提取方法的指标,3种指标可通过式(9)计算得到

(9)

(9)

式中,TP为道路边界点提取方法识别正确的道路边界点数目;FP为道路边界点提取方法识别错误的道路边界点数目;FN为道路边界提点取方法未提取到的边界点数目。

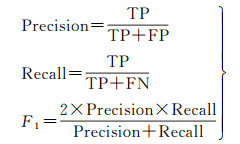

3.2 试验结果分析表 2列出了5种现有道路边界点提取方法和本文方法在每种场景下的平均评价指标结果和标准差及3种场景的总平均结果。

| Mean± Std | 直道 | “T”形路口 | “Y”形路口 | Mean | |

| 精确率 | 文献[12]的方法 | 0.396 0±0.053 9 | 0.426 2±0.115 0 | 0.303 2±0.035 4 | 0.375 1 |

| 文献[13]的方法 | 0.261 7±0.087 7 | 0.205 2±0.083 8 | 0.267 0±0.079 5 | 0.244 7 | |

| 文献[14]的方法 | 0.385 2±0.075 2 | 0.308 2±0.077 6 | 0.292 1±0.065 5 | 0.328 6 | |

| 文献[15]的方法 | 0.472 6±0.088 5 | 0.476 2±0.174 5 | 0.294 9±0.123 1 | 0.414 6 | |

| 文献[16]的方法 | 0.586 6±0.121 7 | 0.471 5±0.099 1 | 0.605 7±0.222 7 | 0.554 6 | |

| 本文方法 | 0.879 2±0.082 4 | 0.751 8±0.079 8 | 0.803 0±0.082 2 | 0.811 3 | |

| 召回率 | 文献[12]的方法 | 0.918 8±0.074 3 | 0.813 0±0.144 6 | 0.798 9±0.100 2 | 0.843 6 |

| 文献[13]的方法 | 0.970 5±0.050 6 | 0.870 3±0.119 6 | 0.930 5±0.046 6 | 0.923 8 | |

| 文献[14]的方法 | 0.622 4±0.088 4 | 0.453 3±0.146 1 | 0.551 3±0.125 3 | 0.542 3 | |

| 文献[15]的方法 | 0.621 5±0.142 5 | 0.580 9±0.147 3 | 0.434 6±0.149 6 | 0.545 7 | |

| 文献[16]的方法 | 0.556 6±0.156 6 | 0.326 6±0.177 5 | 0.457 2±0.144 3 | 0.446 8 | |

| 本文方法 | 0.885 3±0.077 3 | 0.818 0±0.107 1 | 0.838 6±0.103 5 | 0.847 3 | |

| F1得分 | 文献[12]的方法 | 0.551 1±0.057 0 | 0.543 5±0.102 0 | 0.438 2±0.044 1 | 0.510 9 |

| 文献[13]的方法 | 0.404 7±0.101 6 | 0.321 1±0.102 5 | 0.409 7±0.096 6 | 0.378 5 | |

| 文献[14]的方法 | 0.472 9±0.075 9 | 0.356 3±0.072 4 | 0.378 9±0.077 4 | 0.402 7 | |

| 文献[15]的方法 | 0.532 3±0.099 9 | 0.514 3±0.157 9 | 0.345 7±0.130 2 | 0.464 1 | |

| 文献[16]的方法 | 0.553 4±0.123 3 | 0.364 3±0.142 1 | 0.504 8±0.166 3 | 0.474 2 | |

| 本文方法 | 0.879 3±0.061 6 | 0.778 4±0.071 7 | 0.817 0±0.074 4 | 0.824 9 | |

由表 2可以看出,在精确率方面,本文提出的方法取得了最好的结果。因为文献[12]的方法、文献[13]的方法和文献[14]的方法是计算单一尺度空间特征的道路边界点提取方法,所以这3种方法在精确率上表现较差。文献[15]的方法和文献[16]的方法是计算多尺度空间特征的道路边界点提取方法,这两种方法相对于计算单一尺度空间特征的方法在准确率上有一定的提升。在召回率方面,计算大尺度空间特征可以从稀疏的16线激光雷达数据中保留更多的道路边界点,因此,文献[13]的方法获得了最高的召回率。但计算大尺度空间特征也保留了很多非道路边界点,需要结合其他空间特征对保留的点进行进一步筛选,否则会降低道路边界点提取方法的精确率。只计算单一空间特征是造成文献[13]的方法精确率最低的原因。本文方法结合了多尺度空间特征,同时考虑了道路边界点的测量模型,相对于现有道路边界点提取方法,在确保较好召回率的同时提升了精确率。F1得分是精确率和召回率的调和值,本文提出的方法以精确率和召回率为评价度量时,都取得了最好或较好的表现,所以F1得分高于其他方法。

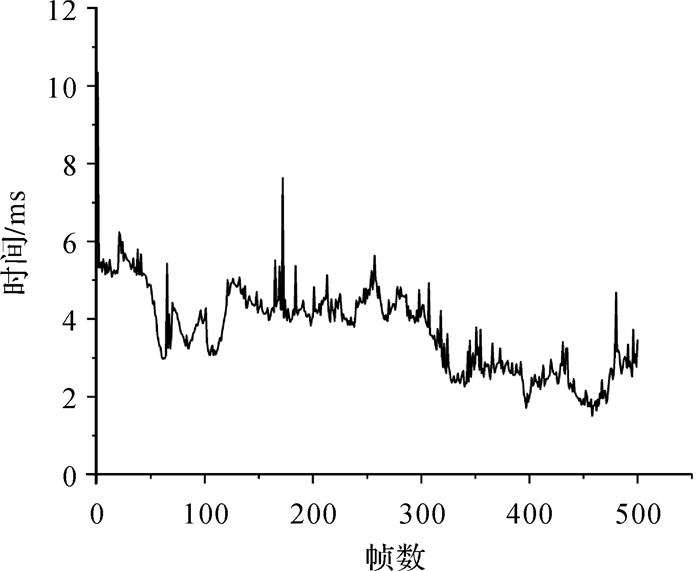

16线激光雷达扫描的频率通常设置为10 Hz[25],即0.1 s完成1帧点云的扫描。在0.1 s时间内,无人驾驶汽车的多个系统需要协同合作完成下一步决策,道路边界提取只是环境感知中比较重要的一个环节,因此,在0.01 s内完成道路边界点提取是比较合理的实时性要求[26]。本文提出的道路边界点提取方法对500帧点云的处理时间如图 11所示,其平均运行时间为3.713 ms,最大运行时间为7.894 ms,满足实时性要求。

|

| 图 11 本文算法处理500帧点云运行时间 Fig. 11 Runtime of curb points extraction with proposed algorithm for 500 frames |

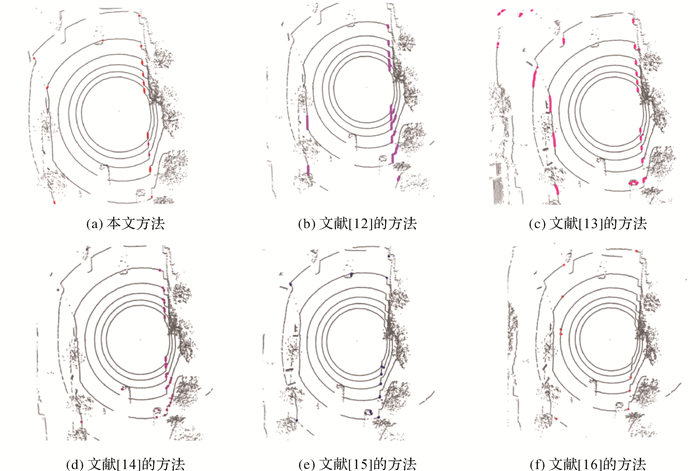

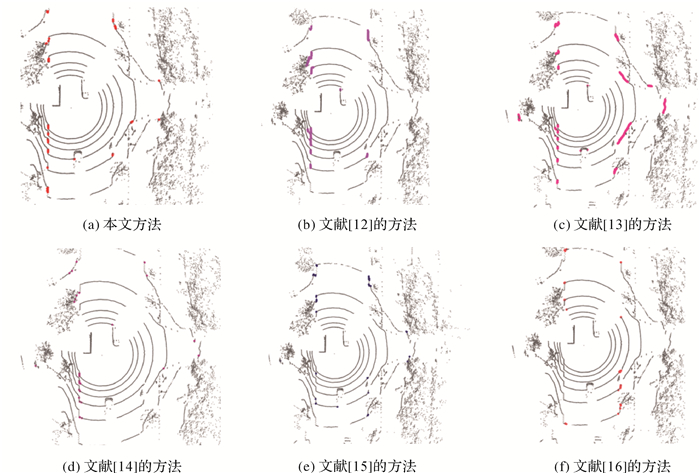

图 12、图 13和图 14分别展示了6种方法在不同场景下的边界点提取结果。

|

| 图 12 直道道路边界点提取结果 Fig. 12 The results of curb points extraction in straightaway |

|

| 图 13 “Y”形路口道路边界点提取结果 Fig. 13 The results of curb points extraction in Y-shape intersection |

|

| 图 14 “T”形路口道路边界点提取结果 Fig. 14 The results of curb points extraction in T-shape intersection |

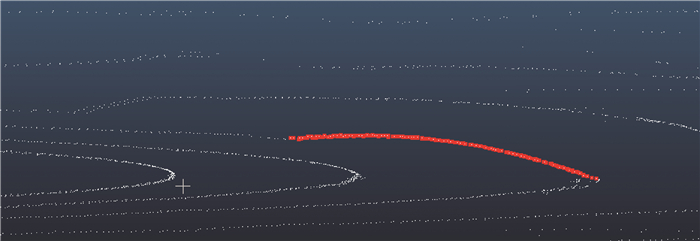

由图 12、图 13和图 14中可以看出,本文的方法相对于其他5种方法取得了较好的效果,但是存在部分不足。首先在不平整道路上,道路边界探测效果不佳,经过分析得出通过原始的测量距离筛选道路边界点依赖于局部相对平整的道路环境。其次对于扫描间隔紧凑的道路边界点没有取得较好的探测结果,该类边界点之间虽然存在一定的高度差,然而其点间高差和点间水平间距较小,与道路表面点近似,本文中设置的水平距离阈值和高差阈值不能很好地将其与道路表面点区分开,会将这类边界点识别为非道路边界点进而去除,如果将高差阈值和点间距阈值设置较小,可以保留扫描间隔紧凑的道路边界点,其夹角特征与其他道路边界点的夹角特征相同,结合测量距离,可以完成该类型道路边界点的提取。虽然将高差阈值和点间距阈值设置较小可以完成扫描间隔紧凑的道路边界点的提取,但也造成了道路表面点的错误识别,降低了算法的精确率。当扫描间隔紧凑的道路边界点不满足文中设置的水平距离阈值和高差阈值的情况下,考虑到该类边界点存在持续的高度增加或高度减少过程,结合测量距离阈值和起始于一点的水平向量夹角阈值,可以完成该类道路边界点的提取。

|

| 图 15 扫描间隔紧凑的道路边界点 Fig. 15 Compact road curb points |

4 结论

针对目前基于多线激光雷达的道路边界点提取方法在数据较稀疏的16线激光雷达数据中提取道路边界点精确率较低的问题,本文提出了一种稳健的道路空间特征和测量距离相结合的道路边界点提取方法,并在实际道路环境下进行了试验测试。试验结果表明,本文方法在数据稀疏的16线激光雷达数据中,能够准确提取出道路边界点。相对于现有方法,本文方法提高了精确率,并且能够满足无人驾驶汽车实时性要求。该方法在结构化道路环境下具有较好的稳健性,但是当道路边界不具有高程阶跃的特性时,会导致结果不稳定,下一步工作将研究多传感器融合以解决该问题。

| [1] |

陈慧岩, 熊光明, 龚建伟. 无人驾驶汽车概论[M]. 北京: 北京理工大学出版社, 2014. CHEN Huiyan, XIONG Guangming, GONG Jianwei. Introduction to self-driving car[M]. Beijing: Beijing Institute of Technology Press, 2014. |

| [2] |

闫利, 戴集成, 谭骏祥, 等. SLAM激光点云整体精配准位姿图技术[J]. 测绘学报, 2019, 48(3): 313-321. YAN Li, DAI Jicheng, TAN Junxiang, et al. Global fine registration of point cloud in LiDAR SLAM based on pose graph[J]. Acta Geodaetica et Cartographica Sinica, 2019, 48(3): 313-321. DOI:10.11947/j.AGCS.2019.20170716 |

| [3] |

WANG Y, DAHNOUN N, ACHIM A. A novel system for robust lane detection and tracking[J]. Signal Processing, 2012, 92(2): 319-334. DOI:10.1016/j.sigpro.2011.07.019 |

| [4] |

GOPALAN R, HONG T, SHNEIER M, et al. A learning approach towards detection and tracking of lane markings[J]. IEEE Transactions on Intelligent Transportation Systems, 2012, 13(3): 1088-1098. DOI:10.1109/TITS.2012.2184756 |

| [5] |

陈得宝, 赵春霞, 张浩峰, 等. 基于2维激光测距仪的快速路边检测[J]. 中国图象图形学报, 2007, 12(9): 1604-1609. CHEN Debao, ZHAO Chunxia, ZHANG Haofeng, et al. Quick road-boundary detection based on 2D laser rangefinder[J]. China Academic Journal Electronic Publishing House, 2007, 12(9): 1604-1609. DOI:10.3969/j.issn.1006-8961.2007.09.017 |

| [6] |

侯学勇, 刘士荣. 基于二维激光测距仪的道路可行区域提取[J]. 东南大学学报(自然科学版), 2011, 41(S1): 88-92. HOU Xueyong, LIU Shirong. Extraction of road feasible motion area with 2D Laser range finder[J]. Journal of Southeast University (Natural Science Edition), 2011, 41(S1): 88-92. |

| [7] |

ZHANG Wende. LiDAR-based road and road-edge detection[C]//Proceedings of 2010 IEEE Intelligent Vehicles Symposium. La Jolla, CA, USA: IEEE, 2010: 845-848.

|

| [8] |

YAN L, DAI J, TAN J, et al. Global fine registration of point cloud in LiDAR SLAM based on pose graph[J]. Journal of Geodesy and Geoinformation Science, 2020, 3(2): 26-35. DOI:10.11947/j.JGGS.2020.0203 |

| [9] |

ALY M. Real time Detection of Lane Markers in Urban Streets[J]. Computer Science, 2014, 7-12. |

| [10] |

GEIGER A, LENZ P, URTASUN R. Are we ready for autonomous driving? the KITTI vision benchmark suite[C]//Proceedings of 2012 IEEE Conference on Computer Vision and Pattern Recognition. Providence, RI, USA: IEEE, 2012: 3354-3361.

|

| [11] |

CARLEVARIS-BIANCO N, USHANI A K, EUSTICE R M. University of Michigan North Campus long-term vision and lidar dataset[J]. The International Journal of Robotics Research, 2016, 35(9): 1023-1035. DOI:10.1177/0278364915614638 |

| [12] |

ZHAO G, YUAN J. Curb detection and tracking using 3D-LIDAR scanner[C]//Proceedings of 2013 IEEE International Conference on Image Processing. Orlando, FL, USA: IEEE, 2013.

|

| [13] |

杨象军, 项志宇, 刘济林. 基于四线激光雷达的校园道路的检测与跟踪[J]. 传感器与微系统, 2013, 32(9): 134-138. YANG Xiangjun, XIANG Zhiyu, LIU Jilin. Detection and tracking of campus road based on four-line laser radar[J]. Transducer and Microsystem Technologies, 2013, 32(9): 134-138. |

| [14] |

ZHANG Y, WANG J, WANG X, et al. 3D LiDAR-based intersection recognition and road boundary detection method for unmanned ground vehicle[C]//Proceedings of 2015 IEEE International Conference on Intelligent Transportation Systems. Gran Canaria, Spain: IEEE, 2015: 499-504.

|

| [15] |

ZHANG Y, WANG J, WANG X, et al. Road-segmentation-based curb detection method for self-driving via a 3D-LiDAR sensor[J]. IEEE transactions on intelligent transportation systems, 2018, 19(12): 3981-3991. DOI:10.1109/TITS.2018.2789462 |

| [16] |

WANG G, WU J, HE R, et al. A point cloud-based robust road curb detection and tracking method[J]. IEEE Access, 2019, 7: 24611-24625. DOI:10.1109/ACCESS.2019.2898689 |

| [17] |

林辉. 基于车载多激光雷达的地图构建与障碍物检测[D]. 杭州: 浙江大学, 2017. LIN Hui. Map buidling and obstacle detection based on vehicle-mounted multiple LiDAR[D]. Hangzhou: Zhejiang University, 2017. |

| [18] |

CHEN S, LIU J, WU T, et al. Extrinsic calibration of 2D laser rangefinders based on a mobile sphere[J]. Remote Sensing, 2018, 10(8): 1176. DOI:10.3390/rs10081176 |

| [19] |

YIN D, LIU J, WU T, et al. Extrinsic calibration of 2D laser rangefinders using an existing cuboid-shaped corridor as the reference[J]. Sensors, 2018, 18(12): 4371. DOI:10.3390/s18124371 |

| [20] |

张海啸, 钟若飞, 孙海丽. 顾及平面特征的车载激光扫描系统外参数标定法[J]. 测绘学报, 2018, 47(12): 1640-1649. ZHANG Haixiao, ZHONG Ruofei, SUN Haili. External parameter calibration method of vehicle laser scanning system based on planar features[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(12): 1640-1649. DOI:10.11947/j.AGCS.2018.20170495 |

| [21] |

王力, 李广云, 张启福, 等. 激光扫描中平面拟合及坐标转换模型构建[J]. 测绘科学技术学报, 2012, 29(2): 101-104. WANG Li, LI Guangyun, ZHANG Qifu, et al. Plane fitting and transformation in laser scanning[J]. Journal of Geomatics Science and Technology, 2012, 29(2): 101-104. |

| [22] |

李孟迪, 蒋胜平, 王红平. 基于随机抽样一致性算法的稳健点云平面拟合方法[J]. 测绘科学, 2015, 40(1): 102-106. LI Mengdi, JIANG Shengping, WANG Hongping. A RABSAC-based stable plane fitting method of point clouds[J]. Science of Surveying and Mapping, 2015, 40(1): 102-106. |

| [23] |

周志华. 机器学习[M]. 北京: 清华大学出版社, 2016. ZHOU Zhihua. Machine Learning[M]. Beijing: Tsinghua University Press, 2016. |

| [24] |

GOODFELLOW I, BENGIO Y, COURVILLE A. Deep learning[M]. Boston: MIT Press, 2016.

|

| [25] |

ZAI D, LI J, GUO Y, et al. 3D road boundary extraction from mobile laser scanning data via supervoxels and graph cuts[J]. IEEE Transactions on Intelligent Transportation Systems, 2017, 19(3): 802-813. |

| [26] |

HUANG R, CHEN J, LIU J, et al. A practical point cloud based road curb detection method for autonomous vehicle[J]. Information, 2017, 8(3): 93. DOI:10.3390/info8030093 |