2. 武汉市自然资源和规划信息中心, 湖北 武汉 430014

2. Wuhan Natural Resources and Planning Information Center, Wuhan 430014, China

智能化测绘一直是测绘领域追求的技术目标,测绘数据获取与处理技术的自主化、实时化水平总体上决定了测绘技术解决问题的智能化水平和能力。前瞻智能时代孕育的科技巨变,智能技术将改变目前信息化测绘/数字化测绘“以人为中心”的方式,建立以自主化、实时化、泛在化、主流化为技术特征的“数据-信息-知识-智慧”的主动感知、实时认知和泛在智能决策技术体系,然而现在测绘数据获取和处理模式基本上是“人-机”协同、事后处理,无法满足智能化测绘阶段时空信息获取与应用需求。

近20年,移动测量技术走向成熟,特别是无人机测量、车载移动测量及背包移动测量,更是在泛在测量和位置服务的强势需求背景下,其技术和产品得到持续发展,在一定程度上解决了动态测量技术问题。从控制方式方面分析,目前移动测量依赖于人的控制或者预先编制程序控制,因此,属于程序控制的动态测量系统,缺乏满足未知测量环境和未知测量对象的自主适应能力,也就是说缺乏“智能”。

当今,智能科技正在深刻影响着人类生产和生活方式的变革,掀起了一场工程科技及智能设备制造的革命,期望为机器赋予人类感觉和思考能力,那么智能科技为移动测量带来的发展机遇是什么?“Gartner Top 10 Strategic Technology Trends 2019”报告将“自主设备”作为影响未来发展的第一项技术趋势预测,无人自主系统也将是移动测量的发展方向,将“类人智能”赋予移动测量技术体系,利用机器代替人并完成测量行为,无疑是智能化测绘的一个愿景目标,鉴于此认识,本文探究“测量机器人”的关键技术与发展方向。

1 测量机器人的内涵与组成 1.1 内涵测量机器人是指利用移动载体实现实时、自主目标测量的智能装备。具体讲,就是采用移动载体搭载多种传感器,按照任务定义,依赖自主导航,自主探测,自主获取并重建目标场景,自主实时完成场景分析,以及在线获取目标的位置信息。

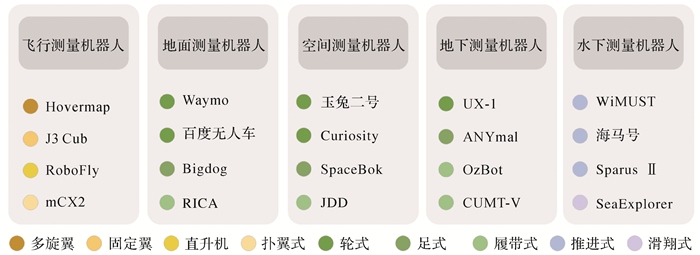

按照载体或用途,可将测量机器人分为多种类型。从需求角度分析,飞行测量机器人、地面测量机器人、地下测量机器人、水下测量机器人则更具有现实需求。

1.2 组成测量机器人系统一般由硬件层、感知层、决策层、服务层与运动控制系统5部分组成,其系统结构如图 1所示。硬件层包括移动平台、传感器模块、通信模块与计算模块,主要负责实现测量机器人的移动、数据采集与通信功能。感知层负责对传感器模块采集的各类数据进行分析,实现机器人的自主定位并建立对周围环境的认知,继而辅助决策层进行任务制定与相应的路径规划。决策层依据感知层的输出信息,结合实际测量任务需求进行作业规划,同时向运动控制系统传输指令。运动控制层在获取决策层提供的指令后,计算机器人的运动控制量,实现机器人精确稳定的运动。服务层根据既定测量任务的需求,通过综合处理硬件层、感知层和决策层提供的数据及分析结果,提供目标跟踪、场景制图和变化检测等测量服务。

|

| 图 1 测量机器人组成 Fig. 1 The composition of surveying robot |

(1) 硬件层。移动平台是测量机器人的硬件基础,主要负责搭载传感器、计算平台及通信模块等设备进行移动。根据运动方式的不同,可以将其主要分为飞行平台、地面移动平台及水下移动平台3大类。其中,飞行平台按照飞行方式的不同,延伸出了单旋翼、多旋翼、扑翼和固定翼等类型;地面移动平台按照行进方式的不同也出现了轮式、足式及履带式等类型;水下移动平台按照驱动方式的不同,可以分为推进式与滑翔式。不同平台运动类型的扩展和延伸,为测量机器人在多样化任务需求和复杂工作环境下的顺利作业提供了坚实的硬件支撑。

测量机器人通过移动平台搭载的传感器采集周围环境信息。测量平台的体积、载重和功率规格是有限制的,考虑到工作场景和精度、分辨率等预定义的测量任务需求,需要找到最适合的传感器和载体平台组合。测量机器人可以使用的传感器包括视觉相机、深度相机、激光雷达、GNSS、IMU、雷达和超声探测仪等,各类传感器的优劣势见表 1。

| 传感器类型 | 优势 | 缺点 |

| 相机 | ①不产生漂移 ②直接测量旋转与平移 ③可以获取色彩信息 |

①单目存在尺度不确定问题 ②受图像遮挡、运动物体干扰 ③容易受光照影响 |

| LiDAR | ①精度高、速度快 ②计算量小,实时性强 |

①价格昂贵 ②不适合恶劣的天气 |

| IMU | ①快速响应 ②不受成像质量影响 ③可估计绝对尺度 |

①存在零偏 ②低精度IMU积分位姿发散 ③高精度价格昂贵 |

| 超声波雷达 | ①能量消耗缓慢、传播距离远 ②测距方法简单,成本低 |

①分辨率低 ②不适用于高速运动 |

| 毫米波雷达 | ①抗干扰能力强 ②具有全天候、全天候能力 |

①不适用于静态对象 ②多重波段并存的环境下影响极大 |

| GNSS | ①全球统一的三维地心坐标 ②功能多,应用广 |

①存在GNSS信号失锁情况 ②刷新频率低 |

通信系统负责测量机器人与地面站、遥控器及其他测量机器人之间的通信,包括传输控制指令、传感器数据及地图信息等。测量机器人的通信功能可以通过Wi-Fi、5G、蓝牙、微波等技术手段实现。

(2) 感知层。感知层是测量机器人理解外部环境信息,掌握局部目标运动态势的功能模块,在获取多源传感器数据的基础上,通过对数据的分析、认知与表达,辅助决策层进行任务制定与相应的路径规划。根据职能的不同,感知层主要分为定位、识别与预测3个模块,其中定位模块的主要任务是借助传感器获取的信息,计算得出测量机器人在当前环境中的精确位置与运动状态。定位模块中通常使用多传感器融合技术保证定位结果的稳定、准确和实时性;场景识别模块根据多传感器获取的场景信息,进行场景分类、目标检测与语义分割,使测量机器人建立对周围环境的认知与理解。预测模块在定位与识别模块的基础上,通过分析场景中的动态目标,预测其未来多种可能的运动状态,为后续的决策规划提供可靠依据。

(3) 决策层。决策层的主要任务是根据感知层获取的场景信息,结合实际的测量任务,对任务进行可行性及风险性评估,决定下一步的作业模式并规划出最优的作业路线。按照职能不同,该层可以分为风险评估、路径规划、多机协同及外部协助4个模块。风险评估模块的主要任务是在顾及测量平台续航能力及软硬件运行情况等状态指标的前提下,依据周围场景信息,对任务的可行性及风险性进行评估,判断是否继续执行任务或是否申请外部协助。路径规划模块是在感知层获取的场景信息的基础上,结合测量任务的目标,根据移动平台的动力学模型规划出一条安全、光滑及符合动力学约束的最优作业路径并交由运动控制系统执行。多机协同模块的主要任务则是在集群联合作业的情况下,按照效率最大化的原则,对任务进行划分,并交由多个集群成员同时执行。而外部协助模块则是在复杂或极端情况威胁到测量任务与机器人安全性,决策层难以做出合理安全的决策时,申请外部人为协助,以避免任务失败或出现严重的作业事故。

(4) 服务层。服务层是测量机器人的测量功能最终实现与执行的部分,针对特定应用场景需求而形成对应的解决方案。其负责接收前3层的信息输入,基于测量任务的不同执行对应的数据处理算法,并根据任务的需求在必要时对决策层发出指令,保证测量任务的顺利执行。本文根据测量机器人应用场景与测量任务的需求将应用层的组成分为3大模块:场景制图、变化检测和目标监测。

其中,场景制图模块基于传感器采集的信息,通过相应算法对目标场景进行重建,并能够根据任务的需求对场景的关键目标进行重点识别与测量;变化检测模块能够将目标对象的当前观测结果与历史数据进行对比,发现其中变化的部分,并测量与估计变化的程度;目标监测模块可以根据任务需求对场景中的特定目标进行搜索,指挥测量机器人跟随目标对象并进行持续观测。

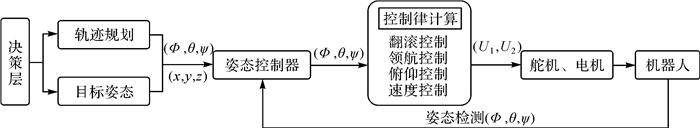

(5) 控制系统。机器人运动控制系统根据决策层提供的行动指令,通过姿态控制器和控制律设计模块解算出合适的舵机和电机控制量,转换成具体的PWM信号输出给硬件层。

在机器人运动控制系统中,姿态控制器用于增加机器人运动体轴方向的阻尼。机器人运动控制系统根据加速度计、陀螺仪、磁强计解算出的姿态角作为反馈,用预先设计好的控制律进行运算,计算出各个舵面和电机控制量后发送到舵机和电机,由舵机和电机驱动机器人运动。其中,舵机包括控制机器人运动姿态的舵机和任务舵机(拍照、开关等操作),电机驱动动力系统提供推力和拉力。机器人运动控制系统的具体流程如图 2所示。

|

| 图 2 机器人运动控制系统 Fig. 2 Robot motion control system |

2 难题与关键技术 2.1 难题

测量机器人属于光机电一体化智能复杂无人自主系统,是一个涉及测绘、导航与控制、电子、机械、高性能计算及人工智能的多学科交叉前沿研究领域。主要技术难题包括:

(1) 自主路径规划难题。主要面临如下问题:①算法适应性不强。当前很多路径规划算法只能在某些场景内取得很好的效果,当场景发生较大变化时,不能保证规划质量。②动态避障能力有限。目前的避障算法大多针对的是静态或低动态障碍物,对于拥有高动态障碍物或者多动态障碍物的工作场景并不能满足实时避障需求。③规划效率有待进一步提升。当前的路径规划算法大多是用于简单的移动任务,当面向复杂测量任务时,难以确保规划的有效性、实时性以及最优性。

(2) 智能场景感知理论难题。主要面临如下问题:①检测能力有限。场景理解算法对受到遮挡的物体或小物体的检测能力较弱,机器人的识别范围因此受限。②样本依赖程度高。基于深度学习的场景感知通常需要标注大量的样本,人工成本高,并且有时会遇到样本不平衡问题,而弱监督及无监督算法发展较为滞后。③动态学习能力不足。大多数感知算法都依赖于初始训练阶段生成的模型,缺少根据测量过程中获取的数据持续学习调整模型的能力。

(3) 实时自适应多机协同难题。目前主要面临以下两个问题:未知环境下的任务动态分配问题和面向测量任务的多机路径规划问题。这个问题涉及多个机器人自由度迭加所产生的高维组合空间优化、机器人静态和动态约束等技术难点,导致难以进行实时、合理的多机协同规划。

(4) 复杂智能处理的实时计算难题。无人测量系统往往存在载荷能力小,计算资源极其有限,而涉及的多源传感器数据的智能处理,均是当前发展阶段正在努力攻克的技术难题,那么在有限计算资源情况下,实现高可靠性的智能数据处理与信息提取,必须突破实时计算困难。

2.2 关键技术测量机器人的关键技术主要有定位与建图、场景识别、路径规划和多机协同等。其中,定位与建图技术用于确定机器人自身位姿,并建立周围环境的三维地图;场景识别技术负责为机器人提供场景感知与理解能力;路径规划技术旨在为机器人规划安全高效的移动测量路线;多机协同技术能够协调多台机器人共同作业,完成测量任务。

2.2.1 定位与建图GNSS技术通过无线电信号进行定位,能够确定全局坐标系下移动平台的位置和速度,在理想情况下定位精度可以达到厘米级,被广泛地应用于机器人领域[1]。但是由于测量机器人工作范围存在大量GNSS拒止环境,因此为了实现测量机器人在这些环境下的稳定定位,需要使用同步定位与建图(simultaneous localization and mapping,SLAM)技术。SLAM技术在构建环境地图的同时完成对机器人的定位,统一了定位与建图问题。

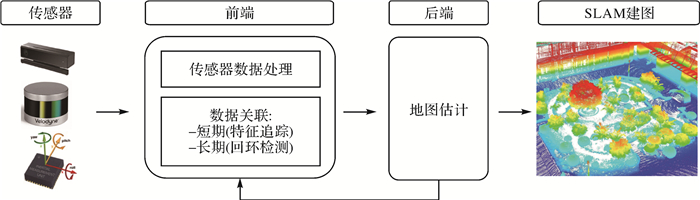

经典的SLAM技术框架如图 3所示,其系统主要由前端与后端组成,前端的任务是通过对传感器数据处理,建立数据关联,估计数据帧间的相对位姿变化,完成机器人的运动及局部地图的重建。而后端通过接收前端输送的关联数据,对其进行优化,估计整个系统的状态,并向前端提供反馈,以进行回环检测和验证,最终得到全局一致的轨迹和地图。根据使用的主要传感器不同,SLAM系统可以分为以下3种:基于激光雷达的SLAM、基于视觉的SLAM和多传感器融合SLAM。见表 2。

|

| 图 3 SLAM算法框架 Fig. 3 The framework of SLAM algorithm |

| 年份 | 解决方案 | 传感器 | 前端 | 后端 | 地图 | ||||

| 相机 | LiDAR | IMU | GNSS | UWB | |||||

| 2007 | MonoSLAM | √ | 特征点法 | 滤波 | 稀疏 | ||||

| 2007 | PTAM | √ | 特征点法 | 优化 | 稀疏 | ||||

| 2007 | Gmapping | √ | √ | 点云匹配 | 优化 | 2D | |||

| 2007 | MSCKF | √ | √ | 半直接法 | 滤波 | 稀疏 | |||

| 2010 | KartoSLAM | √ | √ | 点云匹配 | 优化 | 2D | |||

| 2011 | HectorSLAM | √ | √ | 点云匹配 | 优化 | 2D | |||

| 2011 | DTAM | √ | 直接法 | 优化 | 稠密 | ||||

| 2011 | Kinectfusion | √ | 直接法 | 滤波 | 半稠密 | ||||

| 2014 | LSD-SLAM | √ | 直接法 | 优化 | 半稠密 | ||||

| 2014 | LOAM | √ | 点云匹配 | 滤波 | 3D | ||||

| 2016 | SVO 2.0 | √ | 半直接法 | 优化 | 半稠密 | ||||

| 2016 | Cartographer | √ | √ | 点云匹配 | 优化 | 2D、3D | |||

| 2017 | DSO | √ | 直接法 | 优化 | 半稠密 | ||||

| 2017 | ORBSLAM2 | √ | 特征点法 | 优化 | 稀疏 | ||||

| 2017 | Bundlefusion | √ | 直接法 | 优化 | 稠密 | ||||

| 2018 | VINS-mono | √ | √ | 特征点法 | 优化 | 稀疏 | |||

| 2018 | Lego-Loam | √ | √ | 点云匹配 | 滤波 | 3D | |||

| 2018 | ICE-BA | √ | √ | 特征点法 | 优化 | 稀疏 | |||

| 2018 | Gomsf | √ | √ | √ | 特征点法 | 优化 | 稀疏 | ||

| 2019 | SuMa++ | √ | √ | 点云匹配 | 优化 | 3D | |||

| 2019 | VINS-Fusion | √ | √ | √ | √ | 特征点法 | 优化 | 3D | |

| 2020 | ORBSLAM3 | √ | 特征点法 | 优化 | 稀疏 | ||||

| 2020 | VIR-SLAM | √ | √ | √ | 特征点法 | 优化 | 3D | ||

| 2020 | VIRALFusion | √ | √ | √ | √ | 特征点法 | 优化 | 3D | |

基于激光的SLAM技术通过对不同时刻的点云进行匹配与优化,计算激光雷达相对运动的距离和姿态,实现对机器人的定位和建图[2]。激光SLAM研究在理论和工程上都比较成熟,具有制图精度高、稳定性强、不受外界光照影响等优点。基于视觉的SLAM技术主要是通过对连续的图像数据进行位姿估计和后端优化,完成定位并建立满足任务要求的地图。相较于激光雷达,摄像头的成本低、探测距离远,此外视觉传感器采集的图像信息比激光雷达扫描的信息丰富,可以提取目标纹理信息,有利于后期处理。但是,无论从适用场景、累计误差还是定位和建图精度等问题,激光和视觉传感器的单独使用都存在其局限性。基于多传感器融合的SLAM算法,利用卡尔曼滤波或图优化等技术对不同传感器的数据进行结合,实现多传感器之间的优势互补。常见的融合算法可以分为松耦合和紧耦合两大类。松耦合是指各传感器分别进行自身估计,然后对其位姿估计结果融合。相较于松耦合算法,紧耦合将各传感器的状态合并,共同构建观测和运动模型,消除了直接在位姿层面融合造成的信息损失,可以实现更高的定位和建图精度。因此,基于紧耦合的融合算法是目前多传感器SLAM研究的主流方向。

此外,随着深度学习技术的发展,其在特征提取、动态物体识别、观测值相似度计算等方面展现出的优势开始在SLAM研究领域受到重视。将深度学习技术应用于SLAM里程计、闭环检测或语义建图中的一个或多个环节,提高系统的准确率、计算效率及稳健性,已成为定位与制图技术的一大发展方向。

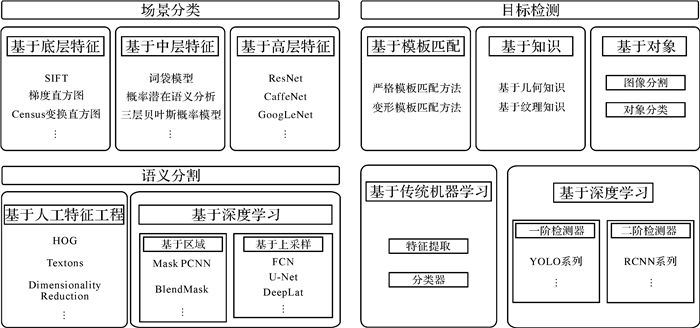

2.2.2 场景理解场景理解是对场景进行认知和推断的过程,是测量机器人可以自主完成测量任务的必要基础。如图 4所示,在所有场景理解任务中最常见的3类任务是场景分类、目标检测与语义分割。其中,场景分类负责判断机器人所在场景的类别,例如室内或室外环境,人工或自然环境,继而辅助定位模块切换不同的模式。目标检测负责识别场景中的关键对象,例如在电力巡线时识别电力设施,在隧道测量中识别裂隙等。语义分割负责依照不同目标区域类别对整个场景进行划分和标注,例如在土地调查中进行不同土地利用类型的划分。

|

| 图 4 场景理解分类 Fig. 4 The architecture of scenario understanding |

在场景分类领域,依据分类过程使用的不同特征,分类方法主要分为以下3类:基于底层特征的方法、基于中层特征的方法、基于高层特征的方法。基于底层特征的方法通常采用底层视觉属性特征形成的向量来描述图像,包括SIFT算法、梯度直方图、Census变换直方图等;基于中层特征的方法采用的是统计特征,介于底层特征与高级语义特征之间,通过对底层特征进行统计与分析得到,常用的中层特征有词袋模型、概率潜在语义分析和三层贝叶斯概率模型等;基于高层特征的方法通常基于深度学习框架,通过卷积神经网络进行场景分类,比较常见的深度学习框架有ResNet、CaffeNet和GoogLeNet等,这些经典的框架通常需要大量的样本训练网络参数,建立场景分类模型,达到分类的目的。

在目标检测领域,传统的检测方法主要分为以下4类:基于模板匹配的方法、基于知识的方法、基于对象的方法和基于传统机器学习的方法。基于模板匹配的方法通过人工标注或者样本学习的方式生成用于检测目标的模板,然后利用相似性测度判断目标与模板的相似性程度进行目标检测。根据采用的模板类型不同,该类方法又可以细分为严格模板匹配方法与变形模板匹配方法。基于知识的方法将目标的几何信息和上下文信息转换为形状、几何、空间关系及其他类型的规则用于检测目标。基于对象的方法主要包含分割和分类两个过程,首先根据人工设计准则将数据分割成多个同质区域,然后通过分类方法,根据每个区域的特征确定包含目标的所属类别。基于传统机器学习的方法主要包括特征提取,特征融合与降维,分类器分类等过程,通过训练样本数据自动建立目标检测模型。基于深度神经网络的算法主要分为两大类:二阶检测器与一阶检测器。二阶检测器首先生成一系列可能包含物体的候选框,然后再对每个候选框进行分类;一阶检测器在没有中间级的情况下同时生成目标的所在区域和类别信息。通常由于二阶检测器结构相比于一阶检测器更加复杂,其检测精度更高但是计算速度较慢。

在语义分割领域,传统的语义分割方法主要依赖于人工特征工程,常见的流程为首先将图像分割为图块或超像素,然后计算分割结果的特征,输入如随机森林、支持向量机等分类器中,预测中心像素的分类概率或每个像素的分类概率。基于深度学习的语义分割方法主要可以分为基于区域的语义分割方法和基于上采样的语义分割方法。基于区域的方法首先从图像中提取自由形态区域并描述它们,然后对这些提取的区域进行分类。在测试时,每个像素的预测值由包含该像素得分最高区域的预测值确定。基于上采样的方法通过设计一个上采样层把CNN网络经过卷积层和池化层的输出上采样到原图的大小,从而得到像素级的分类结果。常见的上采样算法有双线性插值法、反卷积法和反池化法等。此外,针对单个像素的预测噪声,研究者们通常使用条件随机场等方式进行平滑以提高精度。

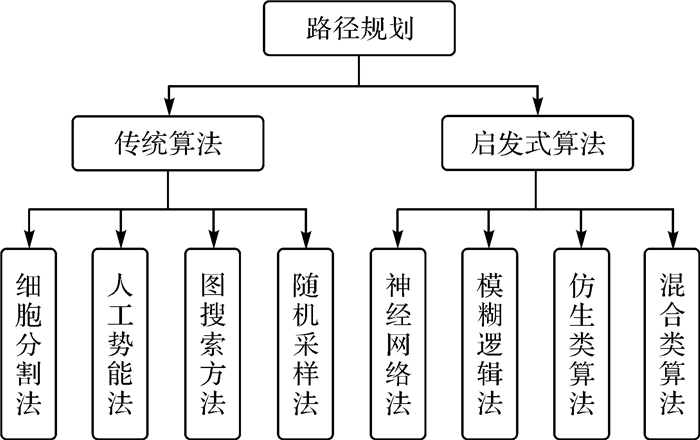

2.2.3 路径规划路径规划是测量机器人自主作业过程中非常重要的一环,其主要任务是根据测量任务需求,在静态或动态的测量区域内基于距离、能耗及安全性等指标寻找到一条符合动力学约束且无碰撞的最优或次优路线,以确保机器人能够安全的从起始位置到达目标位置[3]。根据对环境先验知识获取程度的不同,路径规划主要分为全局路径规划以及局部路径规划[4]两类。全局路径规划是指在测量区域环境信息保持不变且完全已知的情况下,预先规划出一条满足测量任务需求的最优路径。由于其对先验知识的依赖,难以在未知环境以及动态环境中工作。而局部路径规划不依赖于场景的先验信息,面向的是环境信息完全未知或者部分已知的测量场景,其主要借助传感器获取的局部环境信息并结合一定的探索策略进行路径规划,因此其适用范围更广。通常情况下,为了能够适应各种测量环境,测量机器人会采用全局规划和局部规划相结合的方式进行作业,通过全局规划算法确定大致的测量路线,同时采用局部路径规划算法对路径进行风险规避和优化提升。

|

| 图 5 测量机器人路径规划分类 Fig. 5 The classification of surveying robot path planning algorithms |

近几十年来,很多研究人员和学者对路径规划算法进行了深入研究,并提出了一系列优秀的路径规划算法,按照原理的不同可以将各种算法大致分为传统算法及启发式算法两大类,如图 6所示。下面简要阐述几种典型算法。

|

| 图 6 测量机器人研究进展 Fig. 6 Advanced research results of surveying robots |

(1) 传统算法。在人工智能技术发展以前,传统算法一直主导着机器人路径规划领域,其中典型的算法主要有以下几类:①细胞分割法。细胞分割法将机器人的搜索空间划分为不重叠的网格,通过不断遍历相邻网格并对包含障碍物的网格进行分割,最终搜索到一条从起始点到目标点的无碰撞路径。②人工势场法。其基本思想是利用目标和障碍物信息构建一个人工势场,通过势差产生的力引导机器人安全的向目标点运动。③基于图搜索方法。其主要思想是将机器人的工作空间分解为规则的网格单元并采用特定的扩展策略对不包含障碍物的网格进行扩展,最终搜索得到一条无碰撞的路径。④基于采样的算法。该方法通过随机采样技术对状态空间进行采样,通过对采样点的搜索扩展实现路径规划。目前主要分为PRM和RRT两大类。

(2) 启发式算法。虽然传统方法得到深入的发展并进行了广泛的应用,但是始终存在如路径最优性无法保证、容易陷入局部最小值和时间成本高等问题。为了解决这些问题,研究人员基于人工智能技术提出了启发式路径规划算法。

根据启发式规划算法的原理,可以将其分为以下几类:①神经网络类算法。该类算法利用深度学习技术,通过大量数据样本训练得到的规划模型,根据获取的环境信息生成行进路线。②模糊逻辑类算法。模糊逻辑通过模拟人脑根据经验总结实行模糊综合判断的能力,解决机器人在移动过程中遇到的不确定性干扰。③自然启发类算法。该类算法主要是受生物行为启发而提出的仿生类算法,主要有遗传算法、粒子群优化算法、蚁群算法等。④混合类算法。该类算法通过算法融合,弥补了单一算法的局限性,提高了路径规划算法的稳健性。

2.2.4 多机协同机器人多机协同是通过集群控制系统和集群智能系统协调控制多机器人运动,完成多机器人协同感知决策的技术。相较于单一机器人,多机器人协同技术可以提升机器人系统的作业效率和任务执行能力,以及拓展机器人系统的应用范围。集群机器人可携带多种类的传感器,传感器之间能够对目标进行全方位、多角度检测,相互配合弥补探测盲区,提高感知范围和精度;同时,在大地测量、气象观测以及抢险救灾、森林灭火等领域,多机器人携带分布式载荷可以完成单机器人无法完成的大规模任务。

通常,机器人多机协同系统的技术框架由3个部分组成:数据获取层、控制层与决策层。数据获取层通过机载传感器和集群的协作对任务区域进行探测。传感器获取与所需任务有关的原始数据,并将数据传输到计算模块。控制层利用集群协同编队控制技术对机器人运动路线进行规划控制;利用通信及组网技术保障机器人机组之间的信息交互,从而实现机器人集群的协同导航。多机器人控制层包括两个子阶段:感知阶段和规划阶段。感知阶段融合多传感器数据,通常使用数据挖掘或数据处理算法来实现对环境的理解;规划阶段利用感知信息来制定相应的执行任务。决策层通过既定算法按照效率最大化原则对任务进行划分,由多机器人同时执行,利用协同智能决策技术引导多机器人协作完成测量任务。

3 研究动向 3.1 研究现状“机器人”一词提出近百年,历次技术革命推动了机器人概念的延伸,自1954年世界上第一台机器人诞生以来,协助或取代人类工作则是不变的目标追求。

测量机器人相关技术的研究,可追溯至1949年,W·Grey Walter设计了能够感知光源并朝其运动,同时进行避障的机器人。在1966年至1972年间斯坦福研究院研制出了世界上第一台自主移动机器人Shakey。虽然Shakey只能解决机器人简单的感知、运动规划和控制问题,却是当时将人工智能(aritificial intelligence, AI)应用于机器人领域最为成功的研究平台。1979年,斯坦福大学人工智能实验室研制成功了Stanford Cart机器人,它通过立体视觉实现目标定位、避障和路径规划等功能,能够跟踪地面的白线进行运动。1986年,卡内基梅隆大学成功研发了具有里程碑意义的自动驾驶汽车NavLab-1,其通过激光测距雷达和可见光相机提供测距信息和图像信息。1996年,Omead Amidi等研发了第一架基于视觉里程计的自主无人直升机。该直升机利用影像信息进行定位、自稳和导航,并对地面目标进行跟踪。

步入21世纪后,针对测量机器人的研究和应用越来越普遍。2011年,美国太空总署(NASA)发射的Curiosity火星探测器,其导航与控制分系统利用导航相机拍摄的影像数据重建三维场景并同步计算火星车的位置和姿态信息,从而完成路径规划任务[5],代表了星表机器人导航与控制的最高水平。2012年,Kumar实验室研究了一种适用于多层建筑室内空间探索建图的飞行机器人。该机器人使用鹈鹕无人机作为飞行平台,上面搭载了二维激光扫描仪和RGBD相机作为传感器,并将采集到的点云和RGBD数据用机载处理器在线计算,从而实现无人机在室内空间的自主探索任务。该无人机不仅能完成单个房间的探索,还能自主穿越楼层,进而完成整个多层建筑的探索并获取其点云数据[6]。澳大利亚DATA61实验室研制了Hovermap无人机平台,可以通过自主飞行和旋转激光雷达获取GPS拒止环境中的高质量点云数据[7]。马德里理工大学开发了基于ARM的轻型低成本立体视觉预处理系统,用于无人机在室内空间的导航和测图[8]。俄勒冈州立大学将携带深度相机和光流相机的无人机用于室内场景建图,并提出一种有限电量和通信条件下多无人机协同探索算法[9]。瑞士苏黎世联邦理工大学提出了一种通用的自监督激光雷达测程估计方法,可以有效利用激光雷达数据,同时保持实时性能,并成功应用于足式、履带式和轮式机器人[10]。2020年,波士顿动力公司发布的spot2.0具备自主导航的能力,可以根据环境变化自动调整姿态,并能够实现多机协同。2015年10月,特斯拉推出了半自动驾驶系统Autopilot,是第一个投入商用的自动驾驶技术[11]。谷歌Waymo、通用汽车、Nuro等公司也在无人车领域进行了深入研究。

虽然国内对测量机器人技术的研究相较国外起步较晚,但同样也取得了一系列成果。2013年,我国首辆月球车玉兔号驶抵月球表面,承担月面自动巡视勘察和科学探测等任务[13]。玉兔号月球车配置了全景相机、测月雷达、红外成像光谱仪等传感器设备,具备场景感知和路径规划的能力。大疆M300RTK无人机将双目视觉和红外传感器同时引入到机身的6个面上,带来全六向环境感知及定位、避障能力,并可实现对动态目标的自主识别、定位和跟踪功能。浙江大学FAST实验室研制出了能够实现完全自主层次化决策的飞行机器人,并获得了国际空中机器人大赛第七代任务世界冠军[14]。香港科技大学机器人研究所在无人机自主导航和场景重建方面的应用也有较深的技术积累,其研制的猛禽无人机能快速自主地穿越树林和室内复杂环境[15]。武汉大学测绘学院重点研究了飞行测量机器人的自主导航和自主感知技术[16-17]。中国科学院沈阳自动化研究所研制的“云雀”自主飞行机器人具备自主起降、仿地飞行、动态避障等自主功能,首次实现了我国机器人化高海拔环境科考[18]。2017年,宇树科技研制了Laikago四足机器人,能够实现高精度的定位导航和高速高动态步态规划与平衡控制,代表了国内四足机器人的先进水平[19]。百度于2015年推出无人驾驶汽车,并在2018年第一次面向我国公众开放运营L4级的自动驾驶车辆[20]。

国内外研发的代表性的测量机器人如图 6所示。

3.2 研究方向围绕测量机器人发展需求,面向测绘遥感与导航等重点应用领域,需要集中突破自主导航与感知测量关键技术,形成测量机器人系统自主导航与感知测量共性技术,奠定产业化发展基础。主要研究方向包括:

(1) 自主导航与智能规划。利用惯性、卫星、视觉、激光雷达、声呐等综合导航技术,建立多场景适配、高度兼容性、智能切换的多传感器融合导航架构,解决有限计算资源下的实时快速处理、多源异质信息的自适应融合、多维故障的自主诊断与重构等瓶颈,适应多场景、大尺度、动态变化、非结构化复杂环境下的在线实时路径规划。

(2) 协同控制。测量机器人是一个多输入多输出的非线性系统,具有时变、强耦合和非线性的特点。运动控制技术是机器人的底层控制技术,满足不同的应用环境下自抗扰控制、自适应控制和模型预测控制等多种控制,对机器人机械运动部件的位置、速度等进行实时的控制管理,使其按照预期的运动轨迹和规定的运动参数进行运动,实现测量机器人精确运动控制。

(3) 自主环境感知和重建。利用多种传感器自主获取环境图像、点云、温度等信息,通过多源信息的自组织并实时重建测量环境。

(4) 场景理解与自主测量。以测量任务为驱动,融合二维影像、三维场景信息等多维度、多角度观测数据,通过训练获取知识,以认识和理解其自身、外界环境以及测量对象的问题,并按照测量对象的预先定义在线实时获取测量目标信息。

4 发展展望从目前的无人机、移动测量等自动化测量装备到类人智能测量机器人,需要攻克的关键技术还具有相当的难度,从技术的可行性分析,还需要经历共融测量机器人发展阶段,然后才能发展到类人测量机器人。共融机器人是指能与作业环境、自主适应复杂动态环境并协同作业的机器人,具有多模态感知及其自主协同作业的能力。共融测量机器人是指在卫星导航拒止环境、复杂测量环境及测量人员难以到达的环境下人机自主协同测量的机器人,核心在于测量环境自适应及人机自主协同能力。

纵观全球,美国工业互联网战略、欧盟火花计划、日本机器人新战略、中国制造2025战略等均将机器人产业视为科技强国战略的必争之地。随着智能化测绘时代的到来,现有测绘硬件装备集成度不够、自动化水平不足、作业能力有限的问题愈加突显,以测量机器人为代表的下一代测绘装备将成为测绘领域的卡脖子技术,严重制约着测绘地理信息产业的转型升级。美国测绘行业巨头天宝与波士顿动力建立战略联盟,开发出能在危险复杂环境下全自主作业的四足测量机器人,我国应提前布局,以先发优势占据测量机器人发展的制高点。

自主技术是推动地理信息产业装备及其应用走向智能化的基础和核心。自主无人机、自主驾驶、测量机器人等自主设备是先进国家地理信息产业领域竞相发展的技术制高点,决定这类自主设备智能化程度的核心是自主导航技术。按照智能化程度,导航可分为人机协同、自动、自主3类,目前总体上处于人机协同向自动导航的技术攻关和部分产业化的发展阶段,距离高度智能化自主设备要求的自主导航,还存在相当的差距,因此,从我国优先发展产业的角度以及决定未来地理信息产业核心竞争力技术角度考虑,重点发展自主导航关键技术及其产业化应用,特别是结合“北斗+ 5G”技术背景,发展SLAM及惯性导航等多模融合导航、在线实时自主路径规划、地理/位置智能与人工智能深度融合的在线感知分析决策、高精度三维导航电子地图实时群智更新等技术,形成一批自主导航核心技术。

测绘数据的获取能力及实时化智能处理水平决定了测绘科学的发展水平,人工智能与测绘装备研发相结合,无疑为我国研发智能化的测绘装备提供了的发展机遇,测量机器人是我国赶超世界高端测量装备水平的契机。

5 结语测绘数据获取以及从“数据-信息-知识”转化实现自主化、实时化,这是从数字化/信息化测绘到智能化测绘必须解决的理论和技术问题。测量机器人是解决智能化测绘中数据实时自主获取以及在线决策问题的新技术途径,是目前测量装备的一次质的提升。例如,从无人机测量系统发展到飞行测量机器人,这也将是未来高端测量装备竞争的一个热点。本文重点探讨了测量机器人的内涵与组成,剖析了其技术难点与关键技术,分析了测量机器人的研究方向,旨在引起测绘领域的共同关注,共同推进智能测绘技术的创新发展。

| [1] |

宁津生, 姚宜斌, 张小红. 全球导航卫星系统发展综述[J]. 导航定位学报, 2013, 1(1): 3-8. NING Jinsheng, YAO Yibin, ZHANG Xiaohong. Review of the development of global satellite navigation system[J]. Journal of Navigation and Positioning, 2013, 1(1): 3-8. DOI:10.3969/j.issn.2095-4999.2013.01.002 |

| [2] |

MOHAMED S A S, HAGHBAYAN M H, WESTER-LUND T, et al. A survey on odometry for autonomous navigation systems[J]. IEEE Access, 2019(7): 97466-97486. |

| [3] |

AGGARWAL S, KUMAR N. Path planning techniques for unmanned aerial vehicles: a review, solutions, and challenges[J]. Computer Communications, 2020, 149: 270-299. DOI:10.1016/j.comcom.2019.10.014 |

| [4] |

TORDESILLAS J, LOPEZ B T, HOW J P. FASTER: fast and safe trajectory planner for flights in unknown environments[C]//Proceedings of the 2019 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Macao, China: IEEE, 2019: 1934-1940.

|

| [5] |

GRIP H F, JOHNSON W, MALPICA C, et al. Modeling and identification of hover flight dynamics for NASA's mars helicopter[J]. Journal of Guidance, Control, and Dynamics, 2020, 43(2): 179-194. DOI:10.2514/1.G004228 |

| [6] |

SHEN Shaojie, MICHAEL N, KUMAR V. Autonomous indoor 3D exploration with a micro-aerial vehicle[C]//Proceedings of the 2012 IEEE international conference on robotics and automation. Saint Paul, MN, USA: IEEE, 2012: 9-15.

|

| [7] |

HRABAR S. A safer, more productive future for underground mines[J]. AusIMM Bulletin, 2019(2): 72-73. |

| [8] |

FU Changhong, CARRIO A, CAMPOY P. Efficient visual odometry and mapping for Unmanned Aerial Vehicle using ARM-based stereo vision pre-processing system[C]//Proceedings of the 2015 International Conference on Unmanned Aircraft Systems (ICUAS). Denver, CO, USA: IEEE, 2015: 957-962.

|

| [9] |

CESARE K, SKEELE R, YOO S H, et al. Multi-UAV exploration with limited communication and battery[C]//Proceedings of the 2015 IEEE International Conference on Robotics and Automation (ICRA). Seattle, WA, USA: IEEE, 2015: 2230-2235.

|

| [10] |

NUBERT J, KÖHLER J, BERENZ V, et al. Safe and fast tracking on a robot manipulator: robust MPC and neural network control[J]. IEEE Robotics and Automation Letters, 2020, 5(2): 3050-3057. DOI:10.1109/LRA.2020.2975727 |

| [11] |

DIKMEN M, BURNS C M. Autonomous driving in the real world: experiences with tesla autopilot and summon[C]//Proceedings of the 8th International Conference on Automotive User Interfaces and Interactive Vehicular Applications. New York, NY, USA: ACM, 2016: 225-228.

|

| [12] |

GRIP H F, JOHNSON W, MALPICA C, et al. Modeling and Identification of Hover Flight Dynamics for NASA's Mars Helicopter[J]. Journal of Guidance, Control, and Dynamics, 2020, 43(2): 179-194. DOI:10.2514/1.G004228 |

| [13] |

吴伟仁, 周建亮, 王保丰, 等. 嫦娥三号"玉兔号"巡视器遥操作中的关键技术[J]. 中国科学: 信息科学, 2014, 44(4): 425-440. WU Weiren, ZHOU Jianliang, WANG Baofeng, et al. Key technologies in the teleoperation of Chang & apos; E-3 "Jade Rabbit" rover[J]. Scientia Sinica (Informationis), 2014, 44(4): 425-440. |

| [14] |

YE Hongkai, ZHOU Xin, WANG Zhepei, et al. TGK-planner: an efficient topology guided kinodynamic planner for autonomous quadrotors[J]. IEEE Robotics and Automation Letters, 2021, 6(2): 494-501. DOI:10.1109/LRA.2020.3047798 |

| [15] |

ZHOU Boyu, PAN Jie, GAO Fei, et al. RAPTOR: robust and perception-aware trajectory replanning for quadrotor fast flight[J]. IEEE Transactions on Robotics, 2021(99): 1-18. |

| [16] |

CHEN Yu, YAN Li, XU Bo, et al. Multi-stage matching approach for mobile platform visual imagery[J]. IEEE Access, 2019(7): 160523-160535. |

| [17] |

DAI, YAN, LIU, et al. An offline coarse-to-fine precision optimization algorithm for 3D laser SLAM point cloud[J]. Remote Sensing, 2019, 11(20): 2352. DOI:10.3390/rs11202352 |

| [18] |

匿名. "云雀"翱翔在青藏高原上[J]. 少儿科技, 2020(11): 8. Anonymous. "Skylark" soaring on the Qinghai-Tibet Plateau[J]. Science and Technology for the Early Youth, 2020(11): 8. |

| [19] |

TANG Yujin, TAN Jie, HARADA T. Learning agile locomotion via adversarial training[C]//Proceedings of the 2020 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Las Vegas, NV, USA: IEEE, 2021: 6098-6105.

|

| [20] |

LIU Zongdai, LU Feixiang, WANG Peng, et al. 3D part guided image editing for fine-grained object understanding[C]//Proceedings of the 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, WA, USA: IEEE, 2020: 11333-11342.

|