2. 93114 部队, 北京 100089;

3. 北京理工大学信息与电子学院, 北京 100081;

4. 湖北工业大学计算机学院, 湖北 武汉 430068

2. Troops 93114, Beijing 100089, China;

3. School of Information and Electronics, Beijing Institute of Technology, Beijing 100081, China;

4. School of Computer Science, Hubei University of Technology, Wuhan 430068, ChinaAbstract

遥感图像匹配是遥感图像处理中的基础任务,是指通过空间变换将一幅图像映射至不同时相、不同角度、不同光照等条件下获取的同一场景的另一幅或多幅图像中,在该两幅或多幅图像之间建立空间对应关系的过程[1-2]。遥感图像匹配作为遥感图像拼接、融合、变化检测和目标定位等视觉处理与理解任务的核心基础,在自然灾害应急、损毁评估等领域发挥着重要作用[3]。随着遥感技术的高速发展,可见光、多/高光谱、红外、合成孔径雷达(SAR)、激光雷达等覆盖天空地不同平台的传感器不断涌现,为人类对地观测提供了多种数据源[4-5]。如何有效集成多传感器、多分辨率和多时相的遥感数据,对其进行深入处理分析,已成为现阶段遥感领域研究的热点与重点,而多模态遥感图像匹配则是其中迫切需要解决的核心问题之一。

多模态遥感图像匹配通常指不同传感器(如可见光和SAR传感器,可见光和红外传感器等)、不同成像平台(如卫星平台与航空平台、航空平台与地面车载平台等)之间的图像匹配,图像之间存在典型的“五差异”(成像特性差异、几何差异、尺度差异、视角差异、维度差异等的一种或几种)和“三不同”(不同环境、不同天气、不同天候等),给高精度匹配带来了极大的困难[6-8]。其难点主要表现为:①图像匹配的核心是要找到同名特征,但由于多模态图像特征异构,如何准确定义和描述同名特征,如何对同名特征进行表征是个难题;②多模态图像之间的同名特征很难提取,即使在不同视角和维度下提取到同名特征,也存在不完整、难对应的情况;③在特征表征和描述不完备情况下,很难定义有效的相似性测度来度量两个特征集间的相似性。

|

| 图 1 多模态数据 Fig. 1 Multi-modal data |

成像传感器的不断涌现和应用成像方式的各种变化给多模态遥感图像匹配带来持续不断的挑战,对其研究和应用是学术界和工业界持续关注的焦点之一。国内外众多研究机构(如武汉大学、电子科技大学、西北工业大学、西南交通大学、中国科学院、旷视研究院、洛桑联邦理工学院(EPFL)等)和学者提出了大量的多模态图像匹配方法[9-12]。关于图像匹配方法的大赛也如火如荼,如CVPR 2021 Image Matching、2020年“智箭·火眼”人工智能挑战赛等,这些比赛均受到了众多关注。从最初互信息(mutual information, MI)和相位相关(phase correlation, PC)方法被适用于多源遥感图像匹配[13-14],到许多学者通过设计改造特定的手工特征描述用于多模态图像匹配,再到深度学习技术被用来解决多模态图像匹配难题,多模态图像匹配技术在近几十年得到了长足的发展。目前的一些综述文献对图像匹配进行了分类整理[15],这些研究普遍认为图像匹配是一个复杂的综合处理过程,仅靠单一图像匹配算法无法解决所有的图像匹配问题[16-18],但是并未对多模态图像匹配理论和方法进行系统分析,也没有提出较为系统的解决方案。总体来说,尽管多模态图像匹配方法和应用都取得了很大进展,但是目前尚未出现一种普适性强、适用于所有情况的方法。

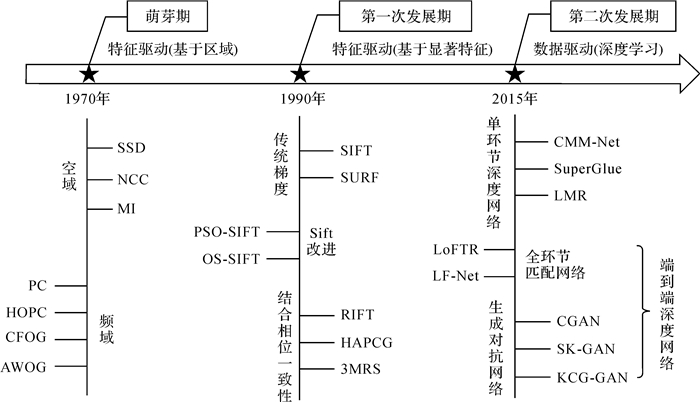

1 多模态图像匹配发展现状多模态图像匹配方法根据数据源角度可以分为:可见光与SAR图像匹配、可见光与红外图像匹配、红外图像与SAR图像匹配、可见光与多光谱图像匹配、遥感图像与GIS矢量匹配、遥感图像与视频数据匹配、遥感图像与三维点云匹配。根据传感器平台可以分为:卫星影像与航空影像匹配、航空影像与地面照片匹配、卫星影像与地面照片匹配[19]。一般认为,多模态图像匹配方法是在传统的图像匹配方法基础上发展起来的,可划分为基于特征驱动的匹配方法和基于数据驱动的匹配方法。以时间脉络为序,多模态图像匹配方法主要包括以下3个典型的发展阶段(图 2):

|

| 图 2 多模态图像匹配分类体系及发展脉络 Fig. 2 Multi-modal image matching classification system and development lineage diagram |

(1) 萌芽期(1970—1990年)。最初的图像匹配是利用相关系数实现,通过计算图像中选定的模板区域的相似性,从中构建图像之间的匹配关系。把图像信号最为相似的区域称为同名区域,同名区域的中心点称为同名点,这就是最初相关系数图像匹配基本原理,也称之为模板匹配(template matching),现有图像匹配方法基于模板匹配雏形发展而来。在该类匹配算法中常用的相似性度量函数包括差方和(SSD)、归一化互相关(NCC)、互信息(MI)和相位相关(PC)等[20-22]。最初学者们发现,一般SSD、NCC和PC受非线性灰度畸变的影响很大,难以应用于多模态图像匹配。互信息(MI)被证明在一定程度上能够抵抗非线性灰度畸变,能适用于多源图像匹配中,但具有较高计算量。

(2) 第一次发展期(1990—2015年)。主要以基于特征的匹配方法为主,通过从参考图像和待匹配图像中提取一些共同特征作为匹配基元,然后通过建立匹配基元之间的对应关系,求解变换模型参数,完成匹配。特征主要分为面特征、线特征和点特征。面特征主要是使用区域分割的方式得到的。线特征主要是提取图像边缘和纹理信息,包括LOG算子[23]、Canny算子[24]等。点特征是目前研究最多的一种,是根据某种策略在图像中提取一些具有一定不变性的点,然后使用某种描述方式,将该点附近的局部信息进行描述,其中包括Harris角点检测[25]、SIFT描述子[26]、SURF描述子[27]等。针对多模态图像许多学者提出了基于几何结构的特征描述,包括HAPCG和RIFT等描述子。与基于区域的匹配方法相比,基于特征的匹配方法并不直接作用于图像灰度,它表达了更高层的图像信息,这一特性使得基于特征的匹配方法对图像的灰度变化、图像变形及遮挡都有较好的适应能力,极大地扩展了图像匹配技术的适用范围。

(3) 第二次发展期(2015年至今)。随着深度学习的发展,众多深度学习网络结构(如卷积神经网络(CNN)、生成式对抗网络(GAN)等)在图像处理领域取得了较大的成功[28-30]。CNN中的卷积层具有强大的特征提取能力,在网络训练的过程中,通过监督信息和反向传播函数更新网络层参数,使得CNN对非线性畸变和噪声等具有较好的稳健性。GAN通过对抗训练的方式来使得生成网络产生的样本服从真实数据分布,为样本数据受限下的深度学习异源匹配提供了解决途径。深度学习为多模态图像匹配的研究提供了更多发展空间。

目前主流的多模态图像匹配方法主要分为特征驱动的匹配方法和数据驱动的匹配方法。特征驱动的匹配方法主要靠直觉和研究者的专业知识驱动,数据驱动的匹配方法主要依靠大量数据来学习建立及优化匹配模型。与数据驱动的匹配方法相比,基于特征的匹配方法在性能方面相对较差,适用于处理训练数据和测试数据为同一场景的图像,该方法大多针对某一难点或某一应用而设计,很难设计出普适性很强的描述符,其优点是不需要数据或者只需少量数据,计算时间较快。数据驱动的匹配方法性能更高,主要通过学习数据中的多样性,适用于不同的数据集和应用,但该方法参数的选择可能需要端到端的梯度下降法进行训练,需要大量的训练数据来保证其稳健性,计算时间相对较慢。由于深度学习技术的突出优势,深度学习和图像匹配的融合已逐步成为主流方法。

2 特征驱动的匹配方法特征驱动的匹配方法从原理上大体可分为基于区域的匹配算法和基于显著特征的匹配算法[31],也有学者为了减小多模态图像匹配的难度,结合一些先验知识辅助匹配过程[32]。

2.1 基于区域的匹配方法基于区域的匹配方法直接利用预设的模板窗口上的灰度信息作为基准进行匹配,通过定义一个相似性度量来计算模板窗口间的相似性,选择相似性最大的一对模板窗口作为匹配结果。由于基于区域的匹配是对图像模板区域的整体像素点信息进行分析处理,一般具有较高的匹配精度,但由于该图像匹配方法对成像条件、图像形变(特别是要求图像对具有极高的重叠度)及噪声极其敏感,同时具有较高的计算复杂度,从而限制了其应用能力。对基于区域的匹配方法进行细分又包含基于空间域的方法和基于变换域的方法。

(1) 基于空间域方法。经典的基于空间域的方法包括互相关法和互信息方法。互相关法通过计算模板图像和搜索窗口之间的互相关值,来确定匹配的程度,互相关最大的搜索窗口决定了模板图像在待匹配图像中的位置。归一化互相关系数曾被作为多模态匹配的测度,进行多源光学遥感图像匹配,并结合概率松弛算法和图像的金字塔数据结构作整体匹配,目的在于提高匹配的可靠性和速度[33]。最大互相关法曾被用于光学遥感图像匹配中,并在自动航海中成功得到应用[34]。在光学和SAR影像上,通过利用SAR图像局部灰度方差和灰度的乘积为匹配基元,光学图像局部灰度方差作为匹配基元,使用互相关作为相似度,同样也得到较理想的匹配结果[35]。虽然互相关法对遥感图像的匹配具有有效性和准确性,但是互相关法对图像间的灰度差异比较敏感,特别是非线性的灰度差异,很难用于辐射差异较大的多模态遥感图像的匹配[7]。互信息方法最早是由文献[36]提出的,它起源于信息论,是一种统计相关性测量方法,广泛应用于医学图像的匹配。由于互信息能够较好地抵抗图像间的灰度差异,互信息已逐渐被用于遥感图像匹配。文献[37]将互信息方法与互相关方法用于小波分解后的遥感图像匹配,并对这两种方法在匹配精度与对噪声的敏感程度上进行了比较,试验证明互信息方法的匹配精度要高于互相关方法,且对噪声有更好的稳健性。虽然基于互信息的匹配方法能够较好地抵抗图像间的灰度差异,但其计算量较大,限制了互信息在遥感图像匹配领域的广泛应用。

(2) 基于频域方法。基于频域的匹配方法主要指基于傅里叶变换的匹配方法,它的基本思路是图像的平移、旋转、仿射等变换在上述变换中都有相应的体现[38-39]。相位相关法通过利用傅里叶变化,在频域进行相位匹配从而达到图像匹配的方法,是一种最常用的基于傅里叶变换的匹配方法,它曾被应用到多源图像匹配中[40-41]。但在图像模糊的情况下,该类方法中的傅里叶变化计算消耗呈指数增长,匹配效果不佳。为了达到更高效的傅里叶变换计算效果,文献[42]提出快速傅里叶匹配方法(FFT),该方法同样被用于光学和激光雷达的配准中[42]。最近一些研究发现,多模态图像之间存在相似的几何结构和形态特征,可通过捕获该特征的相似性从而达到多模态图像精确匹配的目的。于是,有学者开始利用相位一致性保留图像的几何结构特征来用于多模态图像匹配中。相位一致性直方图(HOPC)特征描述符[43]通过相位一致性强度和方向信息替代梯度信息构建的描述符,在多模态图像匹配上取得了良好的性能。然而HOPC是在稀疏采样网格中进行表征的,因此难以捕捉图像中详细的结构信息。定向梯度通道特征(CFOG)[44]在基于HOPC的基础上,以逐像素的方式构建描述符,增强了对图像细节结构的描述能力,同时利用三维快速傅里叶变换(3DFFT)技术定义基于频域特征表示的相似度度量,提高了匹配效率。在CFOG的基础上,角度加权方向梯度(AWOG)描述子[45]将梯度值分布到两个最相关的方向上,并使用三维相位相关作为相似度度量,显著提高了匹配性能。虽然这些基于相位特征的匹配方法在多模态图像匹配上展示出优良的匹配效果,且具有在一定程度上抵抗噪声和非线性辐射差异的稳健性,但它也存在一些局限性,对尺度和旋转变化没有不变性,同时计算量也相对较大。

2.2 基于显著特征的匹配算法基于显著特征的图像匹配方法弥补了基于灰度特征匹配方法的不足,在对存在仿射变换、投影变换的图像对之间的匹配也具有很好的效果。同时,由于基于显著特征的匹配算法不是针对整幅图像进行匹配,而是在图像中提取出一系列具有代表性的特征,然后将两图像间的特征进行匹配,这样就使得算法复杂度大大降低,匹配速率较快。在一些对实时性要求较高的应用中,通常都使用基于显著特征的图像匹配算法。基于显著特征的匹配核心结构包括特征检测、特征描述和特征匹配等方面。

(1) 特征检测。基于显著特征的匹配方法首先需要提取图像间的局部特征,并对这些特征进行对应的描述。在图像匹配领域中,根据特征的物理结构可将特征分为点特征、线特征和面特征,其中点特征是目前研究较为成熟、应用最为广泛的一种特征。近几十年来,点特征检测算法得到了快速发展,出现了众多的特征检测算子。文献[46]提出了利用灰度方差提取点特征的算子。在此之后,相继涌现出了Harris[25]和SUSAN[47]等众多特征点检测算子。随着图像尺度空间理论的成熟,出现了一系列具有尺度不变性的特征点检测算子。文献[48]首先发现Laplacian of Gaussian(LoG)算子能够很好地进行特征点尺度定位。随即Difference of Gaussian(DoG)检测算子[49]被提出,该算子近似于LoG,而且速度更快。为了抵抗图像间的仿射形变,学者们相继提出了仿射不变性的特征点检测算子,如Harris-affine[50-51]等。另外,为了满足实时匹配的需求,在SUSAN算子的基础上利用机器学习方法加速,一种快速的特征点检测方法—FAST算子[52]被提出。AGAST特征检测算法[53]则是通过进一步改进FAST算子,进一步地提高了计算效率。由于以上的特征点检测算子具有较好的稳定性,它们在图像匹配领域中得到了广泛的应用[54]。

相较于点特征,线特征往往包含着更多的结构信息,通常被用于检测图像边缘和纹理结构,在成像条件变化或成像模式变化时都能保持一定的稳定性,因此适合用于异源遥感影像的配准。边缘和轮廓特征一般通过边缘检测算子得到,经典的光学影像边缘检测算子有Canny算子[24]和Sobel算子[55]等,但这些经典梯度边缘检测算子对乘性噪声非常敏感。为了克服这一缺陷,学者们提出了考虑边缘方向性的均值比检测器,如ROA[56]和ROEWA[57]等,这些算子能有效抵抗乘性噪声带来的影响。一些学者通过将线特征和点特征结合运用于多模态图像匹配过程中。文献[24]通过边缘检测的方式来提取影像的结构特征,并在该特征结构图上提取显著特征点。文献[58]通过构建相位一致性计算最大力矩图来检测边缘结构特征点。这些算法都显著地提高了特征检测的重复率,并成功地应用于多模态影像的匹配,但这些算法通常对图像的噪声和尺度较为敏感。

面特征是影像中最为稳定的特征,也是包含信息最多的特征。面特征通常是指具有高对比度的一定大小的闭合区域在影像上的投影,如湖泊、水库、河流、建筑物、森林和阴影等,一般通过影像分割算法得到。经典的影像分割方法包括阈值分割法、聚类法和区域生长与合并法等。经典的分割方法多用于可见光、红外等影像分割,对于SAR影像来说,其分割技术所面临的最大问题是其固有斑点噪声对影像的严重影响,使得常规光学影像分割技术难以直接应用于SAR影像并取得好结果。随着各学科许多新理论和方法的提出,学者们也提出了许多结合一些特定理论、方法和工具的分割技术,主要包括基于水平集分割方法、基于马尔可夫随机场模型(MRF)的分割方法、基于多尺度的分割方法、基于数学形态学的分割方法、基于神经网络的分割方法、基于语义的分割方法等。文献[59]提出利用光学影像与SAR影像共有区域特征进行影像配准的方法,该方法首先提取影像的边缘特征并采用数学形态学方法得到封闭轮廓进而得到闭合区域,并把区域重心作为区域控制点,得到配准变换参数,从而实现光学与SAR影像的配准。文献[60]在水平集框架下,通过映射函数将SAR影像特征和光学影像特征结合,构造能量泛函模型,并采用水平集方法求解曲线演化方程,在进行影像分割的同时实现光学与SAR影像的配准。

(2) 特征描述。特征检测之后,需要对特征进行描述,使其具有较高的区分度,满足后续图像匹配的需要。文献[26]首次提出的SIFT(scale invariant feature transform)算法,该算法的描述子是诸多局部特征描述子中应用最广和最闻名。由于SIFT描述子同时对旋转、尺度和光照变化等影响因素都具有优秀的稳健性,成为图像匹配领域一项里程碑式的工作[61]。然而,SIFT描述子是基于局部梯度信息构建的,受非线性辐射差异影响较大,难以直接用于多模态图像匹配,尤其是极端视角情况。针对多模态图像匹配,PSO-SIFT算法[62]在SIFT的基础上改进了描述子的构建形式,通过优化图像梯度的计算方法,从而提高了描述子对灰度差的稳健性,并引入了一种增强匹配策略,通过结合特征点的多方面信息匹配来提高正确匹配点的数量。OS-SIFT[63]考虑到SAR图像和光学图像的固有特性,利用多尺度指数加权平均比率和多尺度Sobel算子计算SAR图像和光学图像的一致梯度来构建对异源图像更稳健的描述子,从而有效提升算法的抗辐射畸变。在基于区域匹配中相位相关算法的启发下,许多学者将相位相关的理念用于特征描述的过程,辐射变化不敏感特征变换(RIFT)[64]的描述符便是通过结合相位一致性和最大索引图构建得来,该描述符不仅能够有效抵抗非线性辐射差异,同时也有着较好的抗尺度变化和图像旋转能力。一种顾及各向异性加权力矩与绝对相位方向的异源影像匹配算法(HAPCG)[65]利用各向异性滤波进行影像非线性扩散求解得到各向异性加权力矩图,并将相位一致性梯度与对数极坐标描述模板相结合来构建一种绝对相位方向梯度直方图作为描述符,该描述符能够保证较为稳健地实现异源遥感影像匹配。这些多模态匹配算法的特征描述子大都具有较为优秀的抗非线性辐射差异,能够有效应用于多模态图像匹配过程中,但这些描述子往往是针对某一实际需求专门设计而来,适用性往往不够广泛。

(3) 特征匹配。在特征匹配过程中,通常需要构建某种匹配准则衡量特征描述符间的相似程度,实现多模态遥感图像之间正确匹配点对的识别,以计算对应的几何变换模型参数。经典的匹配准则包括归一化互相关系数、余弦相似度、欧氏距离等[66]。但是,以上匹配准则的不足在于他们的性能严重依赖特征描述符的准确性。一旦构建的描述符不精确,就易形成错误匹配点对。而不同传感器图像特征点描述符的构建易受非线性辐射差异影响,这将导致所得描述符的准确性降低。此时,采用传统的匹配准则将会造成特征点的错误匹配。考虑到几何结构属性受辐射差异影响较小的特点,相关学者将结构特征融入相似性测度的构建中。文献[67]利用具有光照和对比度不变性的相位一致性模型构建了一种描述几何结构相似性的匹配测度—相位一致性方向直方图,成功地应用于多模态图像的匹配。在此基础上,文献[68]将非线性扩散模型融入几何结构特征相似性测度的构建中,提高了匹配的正确率。文献[69]结合张量方向平行度和梯度互信息提出了一种相似度准则TOM(tensor orientation and mutual information),对非线性强度变化和噪声具有较好的稳健性。

2.3 先验信息辅助匹配经过多年的研究,众多学者逐渐达成共识:遥感图像的很多处理(包括匹配、分割、检测、提取等)需要高层知识的介入才能得到彻底的解决。受限于人脑和视觉理论研究,多年来遥感图像匹配一直停留在“图像数据”这个层面。比较经典的利用知识进行图像匹配的方法是借助先验信息,利用先验信息来有效抵抗多模态图像匹配中非线性畸变和几何形变等因素带来的影响,例如成像参数信息、DEM数据信息等,利用这些信息去引导或验证匹配,从而提高匹配的准确性。高精度POS数据等先验信息通常被作为辅助信息用来解决视角和尺度变化造成的匹配难题。在特征点匹配之前对影像进行全局几何纠正,整体上消除或降低影像几何变形的影响,再采用传统特征描述和匹配方法进行特征点匹配[70-72]。

利用地理语义知识来辅助进行图像匹配是另一种常用方法,比如利用GIS数据中的分类信息,或者对图像上的建筑、水体、道路等地方事先进行语义信息提取。文献[73]在无人机图像与卫星图像匹配上利用道路信息,解决高空城市场景匹配定位的问题。通过利用U-net网络提取图像语义信息,结合该信息来提高匹配精度。虽然利用语义信息能够提升算法稳健性,但同样局限了算法的应用场景,在语义缺失场景下难以部署。

3 数据驱动的匹配方法数据驱动的匹配方法就是利用深度学习技术从大量训练数据中学习构建匹配的模型,许多学者尝试将其应用于解决多模态匹配难题[74]。相较于特征驱动的方法,数据驱动的方法基于深度学习对深层特征有着优越的学习和表达能力,在图像匹配问题上崭露头角并取得了初步成效[75],能够直接从包含相同或相似结构内容的图像对中学习到像素级别的匹配关系,并且能够更好地适应非线性辐射和噪声等因素带来的影响。基于数据驱动的方法可分为两类:一类为通过构建神经网络结构替换部分匹配环节,可称为单环节深度网络;另一类为构建端到端的神经网络结构完全替换图像匹配的整个过程,称为端到端深度网络。端到端的网络同时也可以用于图像的预处理过程,就是通过图像合成、风格迁移等技术,根据不同模态图像的成像特性,对不同模态的图像进行风格转化,用于扩充多模态图像数据集或直接转换成同模态图像形式进行匹配[7, 15]。

(1) 单环节深度网络。单环节深度神经网络仅替换部分匹配环节,该种方式往往更加灵活,可根据不同的需求结合其他各具优势的结构构建完整的匹配模型。许多学者通过深度学习从图像中检测更精确可靠的特征点集、学习每个特征点的主要方向或主要尺度及其更具有区分性和可匹配能力的特征描述子。D2net[76]创新性地构建了检测特征和特征描述为一体的网络结构,通过使用CNN计算特征图,然后通过将这些特征图进行切片的方式来计算描述子,并且提取关键点。CMM-Net[77]通过对D2net改进并用于多模态图像匹配中,该方法使用动态自适应欧氏距离阈值和RANSAC算法共同约束来剔除错误匹配点,在异源遥感图像的匹配上展示出优良的匹配效果。一种结合深度学习和传统局部特征由粗到精的匹配方法[78]曾被应用于多模态图像匹配中,该方法首先通过CNN提取深度特征进行粗匹配,再通过结合更精确的局部特征来调整粗匹配结果,从而产生更稳定的匹配结果。有学者设计了一种基于Siamese的多模态图像特征提取网络[79],旨在提取多模态图像之间的共同特征,该网络通过去除池化层和从Siamese网络中提取特征层进行优化,以保持特征信息的完整性和位置准确性,从而更加有效提取多模态图像之间的共同特征。也有学者通过采用最大正样本和负样本特征距离作为损失函数,基于Siamese网络结构来训练一种全卷积神经网络学习多模态图像块的描述符表示[80]。该方法在多模态匹配上展示出不错的匹配效果。通过深度学习来对待匹配图像进行预校正也是个不错的思路,一种基于深度学习和高斯特征的旋转不变多模态图像匹配方法通过训练一种名为RotNET的神经网络来预测图像间的旋转关系,再通过构建面向梯度的高斯金字塔特征(GPOG)来匹配两幅图像[81]。该方法表现出对图像旋转和非线性辐射差异有着较好的稳健性。还有些学者利用深度学习学习描述子之间更可靠的相似性度量准则等[82],代表性的方法如SuperGlue[83]构建了一个进行特征匹配以及粗差剔除的网络。SuperGlue通过将特征匹配问题视为求解可微分最优化转移问题,从而构建循环神经网络GNN来解决该问题。而且SuperGlue根据注意力机制提出了一种灵活的内容聚合机制,这使它能够同时感知潜在的3D场景并进行特征匹配。这类方法通过构建深度神经网络来学习相似性测度匹配、粗差剔除,能够灵活地与不同匹配方法结合,从而达到对不同匹配方法改进的效果。

这些方法基于深度学习强大的深度特征提取能力和高维特征表征能力,通过训练单独的网络来替代多模态图像匹配的某一环节,与其他方法结合构建整体的多模态图像匹配模型,具有较大的使用灵活度。

(2) 端到端深度网络。基于深度学习直接设计一个端到端的匹配网络,如设计一种全自动多尺度多模态图像匹配框架[84],该框架由3个神经网络结构组成,分别对应着特征空间提取、基于特征空间相关函数的匹配和离群点剔除,对于光学和SAR图像匹配具有较好的匹配效果。LoFTR[85]在粗粒度上建立图像特征的检测、描述和匹配,然后在精粒度别上细化亚像素级别的密集匹配,且借鉴Transformer使用了自注意层和互注意层来获得两幅图像的特征描述符。端到端的网络结构能够同时学习特征检测、特征描述符、相似性测度和粗差剔除,在训练时通过信息反馈能够使特征匹配全流程最优化,但单独使用这类方法学习到的特征描述符时难以保证匹配效果。

通过风格迁移的方式将不同模态的图像转化为统一模态的图像也是一种解决多模态图像匹配难题的有效途径。深度学习中的生成对抗网络(generative adversarial network, GAN)通过对抗训练的方式来使得生成网络产生的样本服从真实数据分布,为样本数据受限下的深度学习异源匹配提供了解决途径,可充分利用深度学习强大的非线性表征能力实现异源影像匹配。CGAN[86]通过融合残差网络(Resnet)和稠密网络(DenseNet)构建一种并行生成器模型,有效融合了各分支网络结构的优点,在红外—可见光图像转换中展示出优良效果。SK-GAN[87]则以动态感受野获取多尺度信息的生成结构提高了生成图像的质量。KCG-GAN[88]通过使用k-means分割作为图像生成器的输入之一,以此通过约束空间信息合成来提高生成图像的质量,在SAR和光学图像匹配上得到很好应用。

基于数据驱动的多模态图像匹配方法利用深度学习技术从数据中获取高层的语义信息进行匹配,有着很强的泛化性,更接近人类视觉先观察学习后了解掌握的原理,能有效地处理较大的辐射和几何差异,且有着较好的适应性,但同时也会对设备以及多模态图像训练数据集有着更高的需求,相比于特征驱动的方法处理流程更加复杂[89]。

4 粗差剔除在图像匹配过程中,特别是在多模态图像的匹配过程中,由于描述符的局限性和多模态图像特征的复杂性,很难精准全面地描述多模态特征,因此会产生较多错误匹配,从而影响匹配的精度。粗差剔除(外点剔除)是在粗匹配的基础上进一步滤除不符合图像变换关系的匹配点对,有效提高了匹配精度,因此粗差剔除便成为多模态匹配框架的重要组成部分[90-91],广泛应用于多模态图像匹配过程中。最具代表性的粗差剔除方法就是用于模型拟合的稳健估计器RANSAC[92],其广泛应用于包括图像匹配在内的多种计算机视觉任务。该方法通过随机采样最小点集计算出模型参数,利用该模型对所有点对进行检验得到内点集合。重复迭代该过程得到最大一致性内点集合的同时,求得几何估计参数。然而当RANSAC面对一些复杂场景的多模态匹配时(如宽基线、多视角、非刚体场景,以及粗匹配中存在大量的外点的情况),存在效率和稳健性问题。针对复杂场景匹配粗差剔除难题,国内外学者对此也展开了一些研究。GLOF[93]通过构建多粒度邻域结构,利用其定义的阈值进行正确匹配点识别来实现非刚体匹配粗差剔除,但其构建的邻域结构复杂,模型有待简化。SOCBV[94]使用KNN密度估计和空间顺序约束来估计每个匹配的后验内点类概率,通过双边邻域投票进行特征点匹配。该算法每次从有向图中删除异常值并重新计算投票,直到满足停止条件,且在每次迭代过程中,只能剔除一个错误匹配点,计算量太大。VFC(vector field consensus)[95]的主要思想是于向量场一致性逐步进行特征匹配,通过使用高斯混合模型建立图像之间的变换模型,为避免计算复杂度高,对变换进行了稀疏逼近,从而实现外点去除。上述方法在去除错误匹配点时,虽然通过多次最大匹配点集的迭代实现多模型估计,但是时间复杂度大幅提升,不能适应实时场景。随着深度学习的兴起,也有一些学者利用深度学习的方法来解决粗差剔除的问题。LMR[96]利用深度学习构建类似RANSAC的粗差剔除网络,将粗差剔除问题转化为一个二分类问题,利用深度学习网络对每个初始匹配对进行判定,从而实现粗差剔除的结果。

虽然粗差剔除方法比较多,并且取得了很好的应用效果,但是也存在以下进一步研究的问题:①多模态场景较为复杂,常会出现多传感器、多视角、多尺度、多时相共存的情况,单一的粗差剔除方法难以适应这种复杂的情况,不同的粗差剔除方法各有自己的优缺点,因此可联合多种粗差剔除方法提高外点剔除效率。②对于多模态场景,巨大的几何形变导致所有正确匹配点无法满足一个模型,多次计算单一变换模型是一种解决思路,可通过多次最大匹配点集的迭代实现多模型估计,但是时间复杂度大幅提升,难以适应实时应用场景。

5 总结与展望图像匹配问题由来已久,学者们根据实际单方面需求在理论上进行突破使得现有的方法具有一定的实际应用能力。从当前图像匹配的研究现状来说,可选的图像匹配方法种类非常多,不同方法适合不同的情况。笔者对各类算法进行简要总结,见表 1。

| 算法类型 | 代表算法 | 特点 | |

| 特征驱动的匹配方法 | 基于区域 | HOPC[43] CFOG[44] AWOG[45] ⋮ |

对于传统的基于区域的匹配方法,特别是基于相位相关的方法,这类方法由于能够有效地抵抗多模态图像之间非线性辐射差异,但对尺度和旋转比较敏感且计算效率较低,往往被用于多模态图像地图配准的工作 |

| 基于显著特征 | PSO-SIFT[62] RIFT[64] HAPCG[65] OS-SIFT[63] ⋮ |

对于传统基于显著特征的匹配方法,该类方法以图像显著特征来描述整幅图像,更加灵活高效。这类方法在一定的领域范围内展示出较好的效果,但具有一定的局限性,很难达到适应性非常广泛的效果 | |

| 数据驱动的匹配方法 | 单环节网络 | CMM-Net[77] DCFR[79] RIOS[81] SuperGlue[83] ⋮ |

深度学习的方法对多模态图像有着更加深刻的特征提取和表征能力,能够有效抵抗图像间的非线性辐射差异和几何形变,单环节网络结构通过训练单独的网络来替代多模态图像匹配的某一环节,并与其他方法结合来构建整体的多模态图像匹配模型,具有较大的灵活度 |

| 端到端网络 | DLFSO[85] LoFTR[86] CGAN[87] ⋮ |

端到端的网络结构更加整体性学习整个匹配模型,在训练时通过信息反馈能够使整个模型的全流程最优化,从而使得模型匹配效果达到最佳。但整体的训练使得消耗资源更多,模型结构同时也变得更为复杂 | |

随着遥感、人工智能、大数据等技术的不断发展和应用领域的拓展,智能化、精准化、实时化、高可靠的多模态图像匹配方法必将成为未来主流。

(1) 嵌入模型与知识的遥感图像匹配专用深度方法。目前绝大多数遥感图像匹配的深度学习模型是从计算机视觉界引申而来的,往往忽略遥感数据自身的特性,比如数据驱动的模型存在内部计算机理不明,无法解释过程的基本物理依据,容易过拟合等缺陷,较少考虑不同的成像物理模型、大幅面多模态、遥感地学知识等,在解决复杂环境下的匹配问题常常力不从心,因此融合不同模态数据的成像探测机理与遥感地学知识,设计遥感图像专用的智能深度学习网络,挖掘学习遥感图像中的深层语义信息,实现智能的多模态遥感图像匹配是未来关注重点。

(2) 大范围多维度的遥感图像自适应匹配。遥感图像匹配应用逐步从单源、单景、小范围向多源区域乃至全球大范围方向发展,覆盖同一区域的有多数据源、多尺度的各种图像数据,如何在算法上充分利用多图像特性提高精度,如何考虑大范围的并行计算方法提供处理效率值得探讨;同时,近些年来日益发展壮大的空天遥感平台敏捷成像特征及地面多手段成像,导致不同角度不同维度的遥感数据激增,比如多种空天倾斜遥感图像及激光点云和地面车/人等获取的街景图像及点云数据,多视角、多维度的遥感数据匹配将成为未来主要挑战之一。

(3) 在轨/在线的实时遥感图像匹配。很多应用情况下,比如军事应用、灾害应急、突发事件处置等,特别是未来大量无人系统的应用,都需要实时的图像匹配,但由于遥感图像的体量大、范围广、场景复杂的特点,从而导致遥感图像匹配的计算量较大。对此需要关注星载在轨、机载/车载/手持端在线实时处理,需要探讨轻量化深度学习网络模型并设计软硬一体的方法和装置,来解决应急情况下实时处理问题;另外,面向大规模应用场景,设计“云、边、端”一体化的遥感图像实时匹配计算体系和方法模型,通过平衡I/O和计算资源来实现实时匹配。

(4) 时空大数据支撑的自动高可靠匹配。全自动、高可靠的匹配方法对于很多应用场景至关重要,比如工业、安全、应急救援、国防应用等,由于实际场景的复杂性、多变性和遥感不同成像模式的局限性,单纯依靠图像数据难以实现高可信的匹配。随着时空大数据的高速发展,覆盖匹配区域的有包含地理信息和非空间数据的图像、视频、文字、表格等各种数据。如何利用这些大数据进行去伪存真、挖掘知识等来辅助图像进行高可靠的匹配值得研究。

| [1] |

贾迪, 朱宁丹, 杨宁华, 等. 图像匹配方法研究综述[J]. 中国图象图形学报, 2019, 24(5): 677-699. JIA Di, ZHU Ningdan, YANG Ninghua, et al. Image matching methods[J]. Journal of Image and Graphics, 2019, 24(5): 677-699. |

| [2] |

CHEN Lin, ROTTENSTEINER F, HEIPKE C. Feature detection and description for image matching: from hand-crafted design to deep learning[J]. Geo-Spatial Information Science, 2021, 24(1): 58-74. DOI:10.1080/10095020.2020.1843376 |

| [3] |

DAWN S, SAXENA V, SHARMA B. Remote sensing image registration techniques: a survey[C]//Proceedings of 2010 International Conference on Image and Signal Processing. Berlin, Germany: Springer, 2010: 103-112.

|

| [4] |

李德仁, 张良培, 夏桂松. 遥感大数据自动分析与数据挖掘[J]. 测绘学报, 2014, 43(12): 1211-1216. LI Deren, ZHANG Liangpei, XIA Guisong. Automatic analysis and mining of remote sensing big data[J]. Acta Geodaetica et Cartographica Sinica, 2014, 43(12): 1211-1216. |

| [5] |

ZHANG Jixian. Multi-source remote sensing data fusion: status and trends[J]. International Journal of Image and Data Fusion, 2010, 1(1): 5-24. DOI:10.1080/19479830903561035 |

| [6] |

YANG Zhuoqian, DAN Tingting, YANG Yang. Multi-temporal remote sensing image registration using deep convolutional features[J]. IEEE Access, 2018, 6: 38544-38555. DOI:10.1109/ACCESS.2018.2853100 |

| [7] |

JIANG Xingyu, MA Jiayi, XIAO Guobao, et al. A review of multimodal image matching: methods and applications[J]. Information Fusion, 2021, 73: 22-71. DOI:10.1016/j.inffus.2021.02.012 |

| [8] |

ZHANG Xinyue, LENG Chengcai, HONG Yameng, et al. Multimodal remote sensing image registration methods and advancements: a survey[J]. Remote Sensing, 2021, 13(24): 5128. DOI:10.3390/rs13245128 |

| [9] |

YAO Yongxiang, ZHANG Yongjun, WAN Yi, et al. Multi-modal remote sensing image matching considering Co-occurrence filter[J]. IEEE Transactions on Image Processing, 2022, 31: 2584-2597. DOI:10.1109/TIP.2022.3157450 |

| [10] |

XIE Xunwei, ZHANG Yongjun, LING Xiao, et al. A novel extended phase correlation algorithm based on Log-Gabor filtering for multimodal remote sensing image registration[J]. International Journal of Remote Sensing, 2019, 40(14): 5429-5453. DOI:10.1080/01431161.2019.1579941 |

| [11] |

YI K M, TRULLS E, LEPETIT V, et al. Lift: learned invariant feature transform[C]//Proceedings of 2016 European Conference on Computer Vision. Cham, Germany: Springer, 2016: 467-483.

|

| [12] |

YE Yuanxin, YANG Chao, ZHANG Jiacheng, et al. Optical-to-SAR image matching using multiscale masked structure features[J]. IEEE Geoscience and Remote Sensing Letters, 2022, 19: 1-5. |

| [13] |

CHEN H M, ARORA M K, VARSHNEY P K. Mutual information-based image registration for remote sensing data[J]. International Journal of Remote Sensing, 2003, 24(18): 3701-3706. DOI:10.1080/0143116031000117047 |

| [14] |

XIANG Yuming, TAO Rongshu, WAN Ling, et al. OS-PC: combining feature representation and 3D phase correlation for subpixel optical and SAR image registration[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020, 58(9): 6451-6466. DOI:10.1109/TGRS.2020.2976865 |

| [15] |

MA Jiayi, JIANG Xingyu, FAN Aoxiang, et al. Image matching from handcrafted to deep features: a survey[J]. International Journal of Computer Vision, 2021, 129(1): 23-79. DOI:10.1007/s11263-020-01359-2 |

| [16] |

ZITOVÁ B, FLUSSER J. Image registration methods: a survey[J]. Image and Vision Computing, 2003, 21(11): 977-1000. DOI:10.1016/S0262-8856(03)00137-9 |

| [17] |

LENG Chengcai, ZHANG Hai, LI Bo, et al. Local feature descriptor for image matching: a survey[J]. IEEE Access, 2018, 7: 6424-6434. |

| [18] |

YE Yuanxin, TANG Tengfeng, ZHU Bai, et al. A multiscale framework with unsupervised learning for remote sensing image registration[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 1-15. |

| [19] |

GÓMEZ-CHOVA L, TUIA D, MOSER G, et al. Multimodal classification of remote sensing images: a review and future directions[J]. Proceedings of the IEEE, 2015, 103(9): 1560-1584. DOI:10.1109/JPROC.2015.2449668 |

| [20] |

ARAR M, GINGER Y, DANON D, et al. Unsupervised multi-modal image registration via geometry preserving image-to-image translation[C]//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, WA, USA: IEEE, 2020: 13410-13419.

|

| [21] |

LIU Xiaoping, CHEN Shuli, ZHUO Li, et al. Multi-sensor image registration by combining local self-similarity matching and mutual information[J]. Frontiers of Earth Science, 2018, 12(4): 779-790. DOI:10.1007/s11707-018-0717-9 |

| [22] |

MA Wenping, WU Yue, LIU Shaodi, et al. Remote sensing image registration based on phase congruency feature detection and spatial constraint matching[J]. IEEE Access, 2018, 6: 77554-77567. DOI:10.1109/ACCESS.2018.2883410 |

| [23] |

ZENG Qiang, DU Jianhua, LIU Jiexin, et al. Real-time adaptive visible and infrared image registration based on morphological gradient and C_SIFT[J]. Journal of Real-Time Image Processing, 2020, 17(5): 1103-1115. DOI:10.1007/s11554-019-00858-x |

| [24] |

ZHANG Wannan. Combination of SIFT and Canny edge detection for registration between SAR and optical images[J]. IEEE Geoscience and Remote Sensing Letters, 2022, 19: 1-5. |

| [25] |

FAN Jianwei, WU Yan, LI Ming, et al. SAR and optical image registration using nonlinear diffusion and phase congruency structural descriptor[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(9): 5368-5379. DOI:10.1109/TGRS.2018.2815523 |

| [26] |

LOWE D G. Object recognition from local scale-invariant features[C]//Proceedings of the 7th IEEE International Conference on Computer Vision. Kerkyra, Greece: IEEE, 1999, 1150-1157.

|

| [27] |

BAY H, TUYTELAARS T, GOOL L V. Surf: speeded up robust features[C]//Proceedings of 2006 European Conference on Computer Vision. Berlin, Germany: Springer, 2006: 404-417.

|

| [28] |

WANG Shuang, QUAN Dou, LIANG Xuefeng, et al. A deep learning framework for remote sensing image registration[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2018, 145: 148-164. DOI:10.1016/j.isprsjprs.2017.12.012 |

| [29] |

XU Chuan, LIU Chang, LI Hongli, et al. Multiview image matching of optical satellite and UAV based on a joint description neural network[J]. Remote Sensing, 2022, 14(4): 838. DOI:10.3390/rs14040838 |

| [30] |

ZENG Liang, DU Yanlei, LIN Huiping, et al. A novel region-based image registration method for multisource remote sensing images via CNN[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020, 14: 1821-1831. |

| [31] |

XIANG Yuming, WANG Feng, WAN Ling, et al. OS-flow: a robust algorithm for dense optical and SAR image registration[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(9): 6335-6354. DOI:10.1109/TGRS.2019.2905585 |

| [32] |

USS M L, VOZEL B, LUKIN V V, et al. Multimodal remote sensing image registration with accuracy estimation at local and global scales[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(11): 6587-6605. DOI:10.1109/TGRS.2016.2587321 |

| [33] |

张祖勋. 新的核线相关算法: 跨接法[J]. 武汉测绘科技大学学报, 1988, 13(4): 19-27. ZHANG Zuxun. A new approach of epipolar-line image marching-bridging mode[J]. Journal of Wuhan Technical University of Surveying and Mapping, 1988, 13(4): 19-27. |

| [34] |

EMERY W J, BALDWIN D, MATTHEWS D. Maximum cross correlation automatic satellite image navigation and attitude corrections for open-ocean image navigation[J]. IEEE Transactions on Geoscience and Remote Sensing, 2003, 41(1): 33-42. DOI:10.1109/TGRS.2002.808061 |

| [35] |

陆和平, 高磊. 基于互相关的多源遥感图像匹配的改进算法[J]. 航天控制, 2009, 27(2): 18-21, 25. LU Heping, GAO Lei. Improved algorithm for multi-source remote sensing images based on cross correlation[J]. Aerospace Control, 2009, 27(2): 18-21, 25. |

| [36] |

MAES F, COLLIGNON A, VANDERMEULEN D, et al. Multimodality image registration by maximization of mutual information[J]. IEEE Transactions on Medical Imaging, 1997, 16(2): 187-198. DOI:10.1109/42.563664 |

| [37] |

JOHNSON K, COLE-RHODES A, ZAVORIN I, et al. Mutual information as a similarity measure for remote sensing image registration[C]//Proceedings of 2001 Geo-spatial Image and Data Exploitation Ⅱ. Orlando, FL, USA: SPIE, 2001, 4383: 51-61.

|

| [38] |

LE MOIGNE J, CAMPBELL W J, CROMP R F. An automated parallel image registration technique based on the correlation of wavelet features[J]. IEEE Transactions on Geoscience and Remote Sensing, 2002, 40(8): 1849-1864. DOI:10.1109/TGRS.2002.802501 |

| [39] |

LANCHANTIN P, PIECZYNSKI W. Unsupervised non stationary image segmentation using triplet Markov chains[C]//Proceedings of 2004 Advanced Concepts for Intelligent Vision Systems (ACVIS 04). [S. l. ]: IEEE, 2004.

|

| [40] |

蔡潇. 基于相位特征的异源图像匹配算法[J]. 光学与光电技术, 2021, 19(1): 48-53. CAI Xiao. Heterogeneous image matching algorithm based on phase feature[J]. Optics & Optoelectronic Technology, 2021, 19(1): 48-53. |

| [41] |

王新生, 孙润德, 姚统. 基于相位一致性的遥感图像匹配方法[J]. 计算机应用, 2021, 41(S1): 225-229. WANG Xinsheng, SUN Runde, YAO Tong. Remote sensing image matching algorithm based on phase congruency[J]. Journal of Computer Applications, 2021, 41(S1): 225-229. |

| [42] |

WONG A, ORCHARD J. Efficient FFT-accelerated approach to invariant optical-LiDAR registration[J]. IEEE Transactions on Geoscience and Remote Sensing, 2008, 46(11): 3917-3925. DOI:10.1109/TGRS.2008.2001685 |

| [43] |

YE Yuanxin, SHAN Jie, BRUZZONE L, et al. Robust registration of multimodal remote sensing images based on structural similarity[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(5): 2941-2958. DOI:10.1109/TGRS.2017.2656380 |

| [44] |

YE Yuanxin, BRUZZONE L, SHAN Jie, et al. Fast and robust matching for multimodal remote sensing image registration[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(11): 9059-9070. DOI:10.1109/TGRS.2019.2924684 |

| [45] |

FAN Zhongli, ZHANG Li, LIU Yuxuan, et al. Exploiting high geopositioning accuracy of SAR data to obtain accurate geometric orientation of optical satellite images[J]. Remote Sensing, 2021, 13(17): 3535. DOI:10.3390/rs13173535 |

| [46] |

MORAVEC H P. Techniques towards automatic visual obstacle avoidance[C]//Proceedings of 1997 International Joint Conference on Artificial Intelligence. [S. l. ]: IEEE, 1977: 584.

|

| [47] |

HE Wei, DENG Xiaolian. A modified SUSAN corner detection algorithm based on adaptive gradient threshold for remote sensing image[C]//Proceedings of 2010 International Conference on Optoelectronics and Image Processing. Haikou, China: IEEE, 2010: 40-43.

|

| [48] |

DURGAM U K, PAUL S, PATI U C. SURF based matching for SAR image registration[C]//Proceedings of 2016 IEEE Students's Conference on Electrical, Electronics and Computer Science. Bhopal, India: IEEE, 2016: 1-5.

|

| [49] |

FIRMENICHY D, BROWN M, SVSSTRUNK S. Multispectral interest points for RGB-NIR image registration[C]//Proceedings of the 18th IEEE International Conference on Image Processing. Brussels, Belgium: IEEE, 2011: 181-184.

|

| [50] |

ZHENG Yi, ZHENG Ping. Image matching based on Harris-affine detectors and translation parameter estimation by phase correlation[C]//Proceedings of the 4th IEEE International Conference on Signal and Image Processing. Wuxi, China: IEEE, 2019: 106-111.

|

| [51] |

LIU Xiangzeng, AI Yunfeng, ZHANG Juli, et al. A novel affine and contrast invariant descriptor for infrared and visible image registration[J]. Remote Sensing, 2018, 10(4): 658. DOI:10.3390/rs10040658 |

| [52] |

刘妍, 余淮, 杨文, 等. 利用SAR-FAST角点检测的合成孔径雷达图像配准方法[J]. 电子与信息学报, 2017, 39(2): 430-436. LIU Yan, YU Huai, YANG Wen, et al. SAR image registration using SAR-FAST corner detection[J]. Journal of Electronics & Information Technology, 2017, 39(2): 430-436. |

| [53] |

RAN Li, LIN Luo, YU Zhang. Multiframe astronomical image registration based on block homography estimation[J]. Journal of Sensors, 2020, 2020: 1-19. |

| [54] |

王峰, 尤红建, 傅兴玉. 应用于SAR图像配准的自适应SIFT特征均匀分布算法[J]. 武汉大学学报(信息科学版), 2015, 40(2): 159-163. WANG Feng, YOU Hongjian, FU Xingyu. Auto-adaptive well-distributed scale-invariant feature for SAR images registration[J]. Geomatics and Information Science of Wuhan University, 2015, 40(2): 159-163. |

| [55] |

LI Yang, LIU Lingshan, WANG Lianghao, et al. Fast SIFT algorithm based on Sobel edge detector[C]//Proceedings of the 2nd International Conference on Consumer Electronics, Communications and Networks (CECNet). Yichang, China: IEEE, 2012: 1820-1823.

|

| [56] |

GUO Qing, HE Mengmeng, LI An. High-resolution remote-sensing image registration based on angle matching of edge point features[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(8): 2881-2895. DOI:10.1109/JSTARS.2018.2844295 |

| [57] |

YU Qiuze, ZHOU Shan, JIANG Yuxuan, et al. High-performance SAR image matching using improved SIFT framework based on rolling guidance filter and ROEWA-powered feature[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2019, 12(3): 920-933. DOI:10.1109/JSTARS.2019.2897171 |

| [58] |

FAN Zhongli, LIU Yuxian, LIU Yuxuan, et al. 3MRS: an effective coarse-to-fine matching method for multimodal remote sensing imagery[J]. Remote Sensing, 2022, 14(3): 478. DOI:10.3390/rs14030478 |

| [59] |

张雍吉, 范晋湘, 段连飞. 基于区域特征的光学图像与SAR图像配准算法[J]. 合肥学院学报(自然科学版), 2008, 18(4): 37-40. ZHANG Yongji, FAN Jinxiang, DUAN Lianfei. Image registration algorithm for optical and SAR images based on image feature[J]. Journal of Hefei University (Natural Sciences Edition), 2008, 18(4): 37-40. DOI:10.3969/j.issn.1673-162X.2008.04.010 |

| [60] |

李雨谦, 皮亦鸣, 王金峰. 基于水平集的SAR图像与光学图像的配准[J]. 测绘学报, 2010, 39(3): 276-282. LI Yuqian, PI Yiming, WANG Jinfeng. The registration between SAR and optical image based on level set[J]. Acta Geodaetica et Cartographica Sinica, 2010, 39(3): 276-282. |

| [61] |

李晓明, 郑链, 胡占义. 基于SIFT特征的遥感影像自动配准[J]. 遥感学报, 2006, 10(6): 885-892. LI Xiaoming, ZHENG Lian, HU Zhanyi. SIFT based automatic registration of remotely-sensed imagery[J]. Journal of Remote Sensing, 2006, 10(6): 885-892. |

| [62] |

MA Wenping, WEN Zelian, WU Yue, et al. Remote sensing image registration with modified SIFT and enhanced feature matching[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(1): 3-7. |

| [63] |

XIANG Yuming, WANG Feng, YOU Hongjian. OS-SIFT: a robust SIFT-like algorithm for high-resolution optical-to-SAR image registration in suburban areas[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(6): 3078-3090. |

| [64] |

LI Jiayuan, HU Qingwu, AI Mingyao. RIFT: multi-modal image matching based on radiation-variation insensitive feature transform[J]. IEEE Transactions on Image Processing, 2020, 29: 3296-3310. |

| [65] |

姚永祥, 张永军, 万一, 等. 顾及各向异性加权力矩与绝对相位方向的异源影像匹配[J]. 武汉大学学报(信息科学版), 2021, 46(11): 1727-1736. YAO Yongxiang, ZHANG Yongjun, WAN Yi, et al. Heterologous images matching considering anisotropic weighted moment and absolute phase orientation[J]. Geomatics and Information Science of Wuhan University, 2021, 46(11): 1727-1736. |

| [66] |

段汕, 王小凡, 张洪. 图像相似性度量方法的研究[J]. 中南民族大学学报(自然科学版), 2016, 35(4): 121-125. DUAN Shan, WANG Xiaofan, ZHANG Hong. Research on method of similarity measure for images[J]. Journal of South-Central University for Nationalities (Natural Science Edition), 2016, 35(4): 121-125. |

| [67] |

YE Yuanxin, SHAN Jie, HAO Siyuan, et al. A local phase based invariant feature for remote sensing image matching[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2018, 142: 205-221. |

| [68] |

FAN Jianwei, WU Yan, LI Ming, et al. SAR and optical image registration using nonlinear diffusion and phase congruency structural descriptor[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(9): 5368-5379. |

| [69] |

李培, 姜刚, 马千里, 等. 结合张量与互信息的混合模型多模态图像配准方法[J]. 测绘学报, 2021, 50(7): 916-929. LI Pei, JIANG Gang, MA Qianli, et al. A hybrid model combining tensor and mutual information for multi-modal image registration[J]. Acta Geodaetica et Cartographica Sinica, 2021, 50(7): 916-929. DOI:10.11947/j.AGCS.2021.20200492 |

| [70] |

HU Han, ZHU Qing, DU Zhiqiang, et al. Reliable spatial relationship constrained feature point matching of oblique aerial images[J]. Photogrammetric Engineering & Remote Sensing, 2015, 81(1): 49-58. |

| [71] |

肖雄武, 郭丙轩, 潘飞, 等. 利用泰勒展开的点特征子像素定位方法[J]. 武汉大学学报(信息科学版), 2014, 39(10): 1231-1235. XIAO Xiongwu, GUO Bingxuan, PAN Fei, et al. Sub-pixel location of feature point based on Taylor expansion and its application[J]. Geomatics and Information Science of Wuhan University, 2014, 39(10): 1231-1235. |

| [72] |

闫利, 王紫琦, 叶志云. 顾及灰度和梯度信息的多模态影像配准算法[J]. 测绘学报, 2018, 47(1): 71-81. YAN Li, WANG Ziqi, YE Zhiyun. Multimodal image registration algorithm considering grayscale and gradient information[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(1): 71-81. DOI:10.11947/j.AGCS.2018.20170368 |

| [73] |

SUI Haigang, XU Chuan, LIU Junyi, et al. Automatic optical-to-SAR image registration by iterative line extraction and voronoi integrated spectral point matching[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(11): 6058-6072. |

| [74] |

MA Wenping, LI Na, ZHU Hao, et al. A collaborative correlation-matching network for multimodality remote sensing image classification[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 1-18. |

| [75] |

龚健雅, 季顺平. 摄影测量与深度学习[J]. 测绘学报, 2018, 47(6): 693-704. GONG Jianya, JI Shunping. Photogrammetry and deep learning[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(6): 693-704. DOI:10.11947/j.AGCS.2018.20170640 |

| [76] |

DUSMANU M, ROCCO I, PAJDLA T, et al. D2-net: a trainable CNN for joint description and detection of local features[C]//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach, CA, USA: IEEE, 2019: 8084-8093.

|

| [77] |

蓝朝桢, 卢万杰, 于君明, 等. 异源遥感影像特征匹配的深度学习算法[J]. 测绘学报, 2021, 50(2): 189-202. LAN Chaozhen, LU Wanjie, YU Junming, et al. Deep learning algorithm for feature matching of cross modality remote sensing images[J]. Acta Geodaetica et Cartographica Sinica, 2021, 50(2): 189-202. DOI:10.11947/j.AGCS.2021.20200048 |

| [78] |

MA Wenping, ZHANG Jun, WU Yue, et al. A novel two-step registration method for remote sensing images based on deep and local features[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(7): 4834-4843. |

| [79] |

南轲, 齐华, 叶沅鑫. 深度卷积特征表达的多模态遥感影像模板匹配方法[J]. 测绘学报, 2019, 48(6): 727-736. NAN Ke, QI Hua, YE Yuanxin. A template matching method of multimodal remote sensing images based on deep convolutional feature representation[J]. Acta Geodaetica et Cartographica Sinica, 2019, 48(6): 727-736. DOI:10.11947/j.AGCS.2019.20180432 |

| [80] |

ZHANG Han, NI Weiping, YAN Weidong, et al. Registration of multimodal remote sensing image based on deep fully convolutional neural network[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2019, 12(8): 3028-3042. |

| [81] |

LI Zeyi, ZHANG Haitao, HUANG Yihang. A rotation-invariant optical and SAR image registration algorithm based on deep and Gaussian features[J]. Remote Sensing, 2021, 13(13): 2628. |

| [82] |

USS M, VOZEL B, LUKIN V, et al. Exhaustive search of correspondences between multimodal remote sensing images using convolutional neural network[J]. Sensors, 2022, 22(3): 1231. |

| [83] |

SARLIN P E, DETONE D, MALISIEWICZ T, et al. SuperGlue: learning feature matching with graph neural networks[C]//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, WA, USA: IEEE, 2020: 4937-4946.

|

| [84] |

MA Jiayi, JIANG Xingyu, JIANG Junjun, et al. LMR: learning a two-class classifier for mismatch removal[J]. IEEE Transactions on Image Processing, 2019, 28(8): 4045-4059. |

| [85] |

HUGHES L H, MARCOS D, LOBRY S, et al. A deep learning framework for matching of SAR and optical imagery[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2020, 169: 166-179. |

| [86] |

SUN Jiaming, SHEN Zehong, WANG Yuang, et al. LoFTR: detector-free local feature matching with transformers[C]//Proceedings of 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Nashville, TN, USA: IEEE, 2021: 8918-8927.

|

| [87] |

余佩伦, 施佺, 王晗. 并行生成网络的红外-可见光图像转换[J]. 中国图象图形学报, 2021, 26(10): 2346-2356. YU Peilun, SHI Quan, WANG Han. Infrared-to-visible image translation based on parallel generator network[J]. Journal of Image and Graphics, 2021, 26(10): 2346-2356. |

| [88] |

尹梦晓, 林振峰, 杨锋. 基于动态感受野的自适应多尺度信息融合的图像转换[J]. 电子与信息学报, 2021, 43(8): 2386-2394. YIN Mengxiao, LIN Zhenfeng, YANG Feng. Adaptive multi-scale information fusion based on dynamic receptive field for image-to-image translation[J]. Journal of Electronics & Information Technology, 2021, 43(8): 2386-2394. |

| [89] |

DU Wenliang, ZHOU Yong, ZHAO Jiaqi, et al. K-means clustering guided generative adversarial networks for SAR-optical image matching[J]. IEEE Access, 2020, 8: 217554-217572. |

| [90] |

郭正胜, 李参海. 基于深度学习的遥感图像匹配方法[J]. 测绘与空间地理信息, 2019, 42(1): 138-141, 146. GUO Zhengsheng, LI Canhai. Remote sensing image matching method based on depth learning[J]. Geomatics & Spatial Information Technology, 2019, 42(1): 138-141, 146. |

| [91] |

MA Jiayi, JIANG Junjun, ZHOU Huabing, et al. Guided locality preserving feature matching for remote sensing image registration[J]. IEEE Transactions on Geoscience and Remote Sensing, 2018, 56(8): 4435-4447. |

| [92] |

WANG G, CHEN Y. Robust feature matching using guided local outlier factor[J]. Pattern Recognition, 2021, 117(2): 107986. |

| [93] |

FISCHLER M A, BOLLES R C. Random sample consensus[J]. Communications of the ACM, 1981, 24(6): 381-395. |

| [94] |

WANG Gang, CHEN Yufei. Robust feature matching using guided local outlier factor[J]. Pattern Recognition, 2021, 117: 107986. |

| [95] |

MENG Fanyang, LI Xia, PEI Jihong. A feature point matching based on spatial order constraints bilateral-neighbor vote[J]. IEEE Transactions on Image Processing, 2015, 24(11): 4160-4171. |

| [96] |

MA Jiayi, MA Yong, ZHAO Ji, et al. Image feature matching via progressive vector field consensus[J]. IEEE Signal Processing Letters, 2015, 22(6): 767-771. |