2. 二十一世纪空间技术应用股份有限公司, 北京 100096;

3. 湘潭大学数学与计算机科学学院, 湖南 湘潭 411105;

4. 湖南国家应用数学中心, 湖南 湘潭 411105

2. Twenty First Century Aerospace Technology Co., Ltd., Beijing 100096, China;

3. School of Mathematics and Computational Science, Xiangtan University, Xiangtan 411105, China;

4. National Center for Applied Mathematics in Hunan, Xiangtan 411105, China

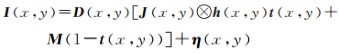

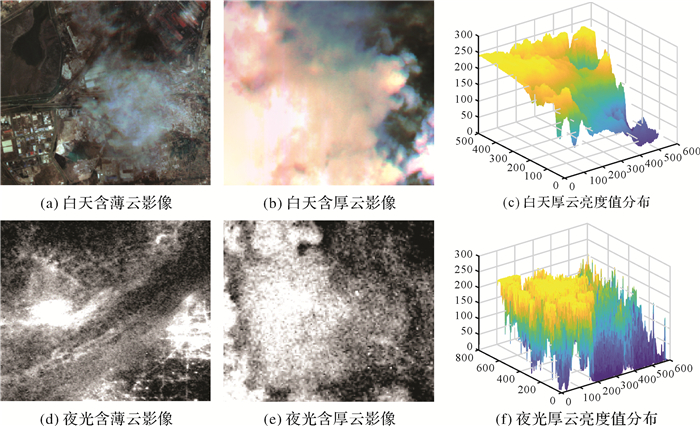

随着遥感技术的不断发展,遥感数据的种类越来越丰富。其中夜光(nighttime light, NTL)遥感卫星能够获得与人类活动有关的城市灯光、自然界物体发光、舰船灯光和油井燃烧发光等信息[1],在反映人类社会活动方面具有独特的能力,因此它被广泛应用于社会经济领域的空间数据挖掘问题中[2-4]。夜光遥感影像属于夜晚低照度拍摄环境下的成像,被拍摄场景是不均匀的亮度信息[5],成像时受环境(如大气光、云雾)、目标辐射、光学成像系统等方面的影响更为突出,往往在影像上表现出模糊、分辨率降低等综合降质现象,如图 1(c)所示。影像的模糊主要表现为由于大气散射产生的辉光模糊(图 1(a))和由云雾产生的模糊(图 1(b));影像的分辨率降低主要是受成像硬件的影响。对于这些降质问题目前通常采用各种软件处理方法进行去除或者减弱,如一般用影像复原方法去除模糊,用超分辨率重建方法提高影像的分辨率,从而达到影像质量提升的目的。

|

| 图 1 夜光遥感影像的降质现象 Fig. 1 Degradation of nighttime light remote sensing image |

影像的去模糊、去云雾、超分辨率重建是影像质量提升领域里的经典问题,总的来说可以分为传统方法和学习方法。在传统方法方面,关于去模糊和去云雾问题,有基于PSF估计的方法[6]、基于影像增强的方法[7]、基于高斯滤波器和照明频率的方法[8]、基于统计先验的方法[9]、基于暗通道先验方法[10]等。关于超分辨率重建问题,有基于插值的方法[11-12]、基于重建的模型方法[13-15]等。

在学习方法方面,可以分为基于样例学习的方法[16-18]和基于深度学习的方法[19-20]。关于去模糊和去云雾问题,有先计算降质参数然后再去模糊的方法,如DehazeNet[21]网络、DCPDN[22]网络;在此之后又发展出了端到端的处理方法,如AOD-Net[23]、GFN[24]、改进的CGAN[25]、GCANet[26]方法等;但是目前关于网络构建的研究较多,关于夜间数据集的构建研究较少[27]。关于超分辨率重建问题,有通过加深网络卷积层深度提升网络特征提取能力的方法,如SRCNN[28]、FSRCNN[29]、ESPCN[30]等;也有利用上下层信息的残差网络方法,如RED[31]、VDSR[32]、EDSR[33]、DenseSR[34]方法;还有改进上采样方式、激活函数、损失函数的方法,如DRRN[35]、RDN[36]、IKC[37]等。

与上述方法不同,SRGAN[38]、ESRGAN[39]在SRGAN的基础上进一步使用了密集残差块来改善超分结果的感知质量,得到了较好的效果。

在影像质量提升问题中,传统方法在求解模型中可以直接加入先验约束,适用于非线性和线性成像模型,但是模型求解困难,存在解不唯一的情况。深度学习方法利用网络学习降质过程,避免模型构建、求解的复杂性,具有特征学习能力强、处理效果好的优点。目前关于可见光影像的深度学习方法研究较多,针对夜光遥感影像的研究较少;现有方法往往只针对单一降质类型,且可用数据集极少,当影像中多种降质同时存在时处理效果不佳。针对这些问题,本文以珞珈一号夜光遥感影像为研究对象,首先从成像模型角度对影像的多种降质特征进行理论分析与模型推导;然后依据此模型设计有针对性的深度学习网络和数据集,并进行试验验证。

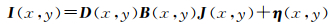

1 夜光遥感影像降质模型一般情况下,若退化是线性、空间不变的过程,则影像的退化/成像模型为[40]

(1)

(1)

式中,I(x, y)表示观测的退化影像;J(x, y)为原始的清晰影像;h(x, y)为影像的点扩散函数;⊗代表卷积运算;η(x, y)为噪声。通常情况下h(x, y)一般表示为下采样、模糊等降质因素,因此,影像退化模型可进一步表示为[19-20]

(2)

(2)

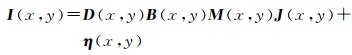

式中,D(x, y)表示下采样算子;B(x, y)表示模糊矩阵;M(x, y)表示几何运动矩阵。实际上夜光影像的主要降质表现为模糊,这些模糊主要是由于辉光和云雾影响产生的。辉光现象是指成像时大气中的粒子对光产生多散射作用,表现为影像中光源周围的模糊现象,如图 1(a)所示。辉光现象产生的原因是,人造光在穿过一些大气成分时,由于散射和吸收作用,部分光线向多方面改变传播方向,导致强度减小,卫星传感器沿着光传播的方向观察将其归因于一个错误的位置[41-42](图 2),表现在影像中为光源显著的时空变异性[43-44]、亮度值衰减。辉光现象在影像中普遍存在,有云雾的阴天该现象更明显。

|

| 图 2 辉光现象的成像原理 Fig. 2 Schematic diagram of imaging principle of glow phenomenon |

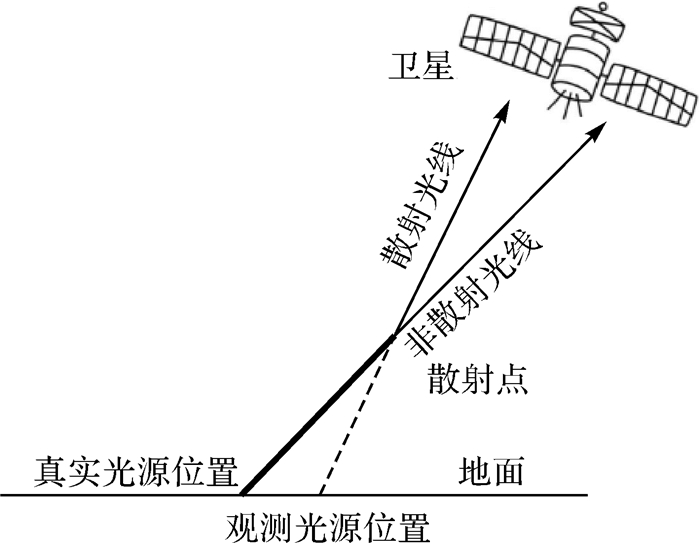

云雾的影响是指大气中的云使影像产生的模糊。当云雾较厚时传感器无法记录到云雾覆盖下的光源信息;当云雾较薄时,薄云对光的吸收、散射、反射作用对成像造成了干扰,使像素值包含了光源信息和云雾反射的信息,如图 1(b)所示。光传递过程中的退化系数与距离相关,在不考虑冰、雪和其他高反射表面的反射影响的情况下,地表反射的月光亮度极小可以忽略不计[45-46],云雾反射主要发生在云层顶部(图 3)。云雾反射的亮度信息与月光强度相关,图 4展示了不同月光条件下珞珈一号拍摄的含云影像,上排影像代表成像时月光强度,下排表示该月光照射下包含明显厚云雾信息的影像,图 4中标注了成像时间以及厚云区域的亮度均值。因此,月光强度越大云雾亮度越高,对影像质量的影响越明显。

|

| 图 3 夜光遥感影像云雾噪声降质 Fig. 3 Schematic diagram of cloud and fog noise degradation of nighttime light remote sensing image |

|

| 图 4 不同程度的云雾和月光对影像质量的影响 Fig. 4 Effects of different degrees of cloud and moonlight on image quality |

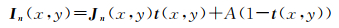

在实际影像中B(x, y)是辉光和云雾等多种复杂因素综合影响的结果,卫星运行姿态稳定的情况下,M(x, y)的影响可以不考虑,则影像降质可表达为

(3)

(3)

在不考虑噪声的情况下,地面拍摄的自然影像的云雾/大气散射退化模型[47-48]为

(4)

(4)

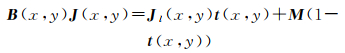

式中,In(x, y)表示观测的自然影像;Jn(x, y)表示无云雾的影像;t(x, y)为云雾对光的透射率;A为大气光强度,夜晚条件下A相当于月光影响强度M。Jn(x, y)可以进一步精确表示为含有点扩散影响的Jl(x, y),因此结合式(3)和式(4),B(x, y)J(x, y)可表达为

(5)

(5)

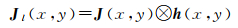

Jl(x, y)可进一步表示为无任何降质影响的影像J(x, y)和点扩散函数h(x, y)的卷积[40]如式(6)所示

(6)

(6)

因此,结合式(3)、式(5)、式(6),得到珞珈一号夜光遥感影像受辉光和云雾影响的退化模型为

(7)

(7)

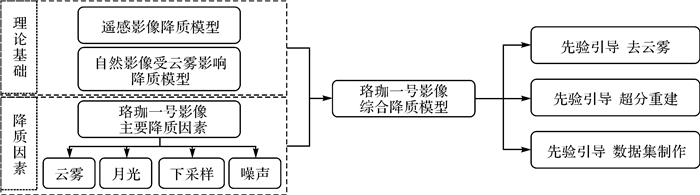

由式(7)可以看出,夜光影像的降质包括大气辉光、云雾、降采样的影响,首先,依据该退化模型,分析出夜光影像的主要降质因素;然后,根据先验知识,引导设计网络结构和制作相应的数据集,本文方法的思路如图 5所示。

|

| 图 5 本文方法的分析思路 Fig. 5 Algorithm analysis ideas in this paper |

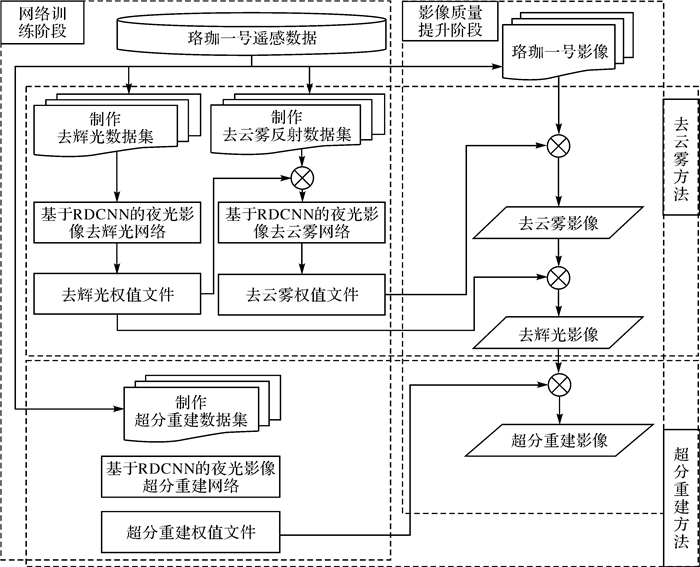

本文方法的技术路线如图 6所示,整体上分为训练和质量提升两个部分。训练部分包括去辉光、去云雾和影像超分辨率重建3个部分,首先,根据降质特征制作以上3类数据集,按照8∶2的比例分配训练集和验证集。然后,设计去辉光、去云雾、超分辨率重建的深度学习网络。在训练阶段,去辉光和去云雾网络结构相同。先训练去辉光任务,在网络收敛后,利用网络的可迁移性[49],将训练好的权值作为去云雾网络的预训练参数,进一步提取云雾网络特征。在影像质量提升阶段,处理过程为先去云雾再去辉光,最后进行超分辨率重建,主要原因为:①依据退化模型表达式(7),在不考虑D(x, y)和η(x, y)的情况下,去云雾相当于去除M(1-t(x, y))、t(x, y)的影响,去辉光相当于去除h(x, y)的影响。由于云雾距离成像传感器较近,辉光的程度相对地面光源的辉光程度不同,这种差异是很难模拟的;②从影像的主要降质表现来看,云雾是主要的降质因素,但不是所有成像区域都有云雾,而辉光却是普遍存在的,若先整体去除辉光h(x, y),云雾也会被作为光源信息参与到辉光网络中,处理后必然会对云雾的纹理特征产生影响,从而导致后面的学习网络对云雾信息处理有偏差;③从模拟数据集构建角度考虑,如果先去云雾再去辉光,模拟云雾数据集需要考虑透射率t(x, y)、月光强度M及噪声,而含辉光的数据集仅需考虑h(x, y)。如果先去辉光再去云雾,构建去辉光数据集时不仅需要模拟h(x, y),还需要增加云雾反射等信息,而这两项同时考虑非常复杂,增加了构建数据集的难度;④从目前的试验来看,如果先去除辉光,网络会将云雾信息识别为光源,从而改变云雾噪声的特征,使去云雾更加困难。

|

| 图 6 本文方法技术路线 Fig. 6 Technical roadmap of this method |

2.2 数据集构建

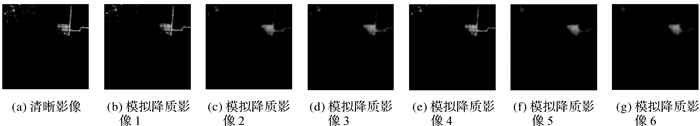

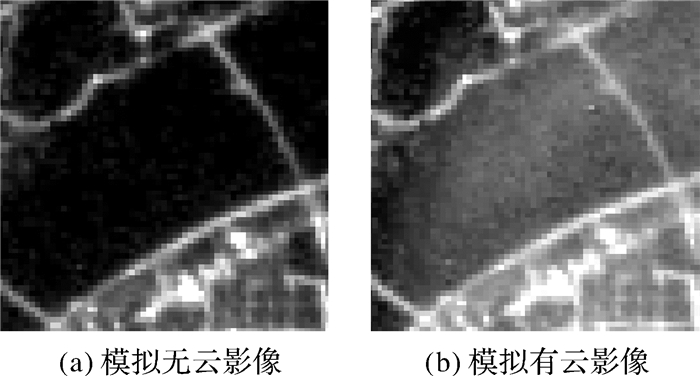

深度学习方法的效果依赖于训练集含有降质的类型[50],本文构建了云雾、辉光、超分辨率重建3类数据集。由于无法获得无降质影像,且已知夜光影像的模糊降质呈现对称高斯点扩散函数型[51],因此,本文采用添加不同参数的高斯模糊来模拟辉光影像。制作数据集的影像见表 1。选用晴天无云条件下成像质量好的影像为基准影像,使用6组不同参数的高斯模糊核,随机模拟辉光现象,构成数据集A,模拟降质影像如图 7所示。该数据集包含1519对影像,影像大小为128×128,并通过旋转、翻转等手段扩增数据量。

| 地区 | 晴天成像时间 | 阴天成像时间 |

| 北京市及周边 | 2018-07-31 | 2018-07-15 |

| 南京市及周边 | 2018-07-15 | 2018-07-31 |

| 宁波市及周边 | 2018-06-16 | 2018-10-14 |

| 上海市及周边 | 2018-10-29 | 2018-08-20 |

| 天津市及周边 | 2018-10-29 | 2018-09-26 |

| 武汉市及周边 | 2018-06-13 | 2018-10-30 |

|

| 图 7 数据集1清晰影像与模拟降质影像 Fig. 7 Clear image and simulated degraded image of dataset 1 |

在云雾数据集制作方面,本文制作了有云和无云影像对的数据集。晴天影像一般无云雾,阴天影像含有云雾,因此利用真实晴天、阴天影像对构建数据集B1。不同成像时间、成像环境内的地表实际灯光亮度分布往往不同,因此,选取成像时间间隔小、成像角度接近、成像天气相差明显的影像制作数据集。按上述方法制作数据集1006对,影像大小为128×128,数据集影像对如图 8所示。

|

| 图 8 数据集B1 Fig. 8 Dataset B1 |

由于真实同一地区的晴天、阴天影像对数据有限,所以构建含云雾的模拟数据集B2。由于云层形状与浓度的实时变化对遥感影像造成的污染难以推演和预测,所以分析影像中云层的空间分布特性与成像特征是构建数据集的必要前提。这里对比分析了含有云雾的白天影像和夜光遥感影像的差异,并绘制其厚云雾亮度值三维曲线,如图 9所示。

|

| 图 9 含云雾影像及云雾亮度值分布 Fig. 9 Cloud image and cloud brightness value distribution |

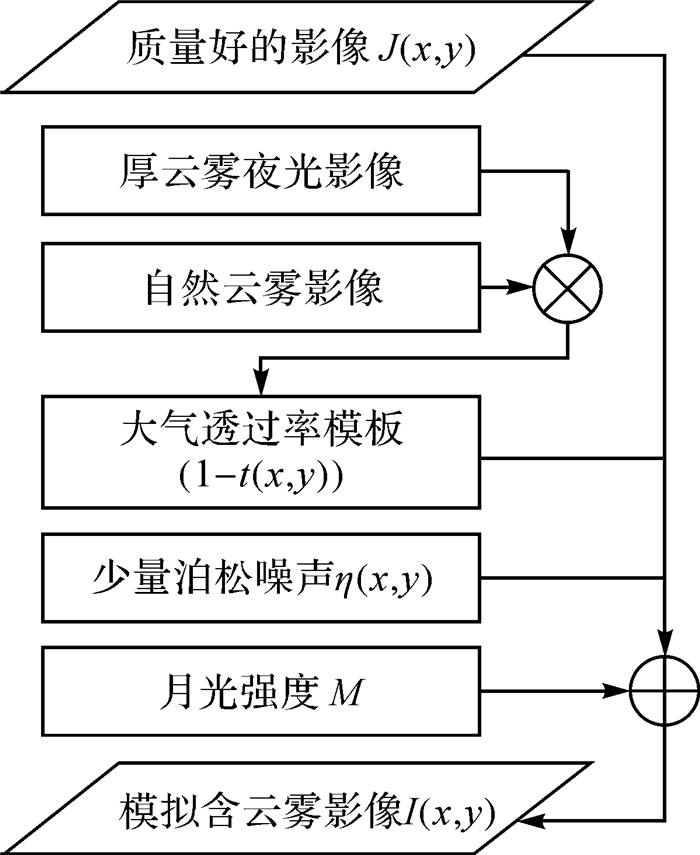

对比图 9可发现,白天影像的云雾亮度信息变化较平滑,夜光影像的云雾信息连续性差、亮度值波动较大、无规则噪声多,依据这两类影像的特点制作模拟数据集。用云雾完全覆盖地面光源信息的影像模拟云雾亮度值不连续、波动大的特点,用随机的自然云雾图片制作掩膜,模拟云雾的分布形态,将全云雾影像与掩膜点乘,生成的矩阵作为模拟夜间大气透过率模板(1-t(x, y))。然后,选取质量较好的无云夜光影像为理想影像J(x, y),模拟加入少量泊松噪声。最后,给出月光强度经验值M,将以上信息代入式(7),且不考虑辉光现象(即h(x, y)=1)以及下采样因子(即D(x, y)=1),模拟出含云雾的影像I(x, y),与无云影像共同构成数据集B2,数据集制作流程如图 10所示。数据集B2包含1509对影像,影像大小为128×128,构建的数据集如图 11所示。

|

| 图 10 模拟云雾影像制作流程 Fig. 10 Production process of simulated cloud image |

|

| 图 11 数据集B2模拟的有云、无云影像块 Fig. 11 Dataset B2 simulate cloud and clear image |

目前公开的自然影像超分辨率重建数据集较多,但还没有夜光影像的数据集。图 12为夜晚和白天的影像直方图,由图 12可以看出两者亮度动态变化差异较大。所以,夜光影像超分辨率重建需要构建专属数据集。鉴于重建对噪声比较敏感[52],所以选用成像质量好、噪声少的高分辨率影像构建超分数据集,数据集中的低分辨率影像通过高分辨率影像降采样得到。该数据集包含1509对影像,高低分影像对尺对分别128×128和64×64,数据集C如图 13所示。

|

| 图 12 夜光影像和白天影像的亮度值分布 Fig. 12 Luminance value distribution of night light image and day image |

|

| 图 13 数据集C模拟的影像对 Fig. 13 Images pairs simulated by dataset C |

2.3 网络结构和损失函数

根据式(7)对降质模型的分析,针对辉光、云雾、超分辨率重建问题,本文提出了顾及多特征降质的夜光影像深度学习方法,即残差密连卷积神经网络(residual dense convolutional neural network,RDCNN)框架。该方法分为去云雾网络、去辉光网络和超分辨率重建网络。

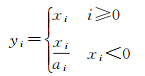

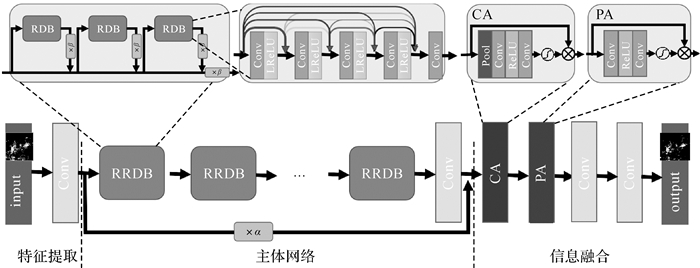

在去辉光、云雾网络中,整个网络分为特征提取、主体网络、信息融合3个部分,网络结构如图 14所示。云雾特征的提取部分利用卷积层实现,首先,用3×3×64大小的卷积提取周围像素的特征信息。然后,主体部分由残差密连模块(residual-in-residual dense block,RRDB)实现。RRDB将残差块(residual block,RB)和密度块(dense block,DB)结合起来,形成了残差密集块(residual dense block,RDB),再将3个RDB进行跨层连接,残差连接部分乘以缩放值β。RDB在端到端的多层连接中自然的集成了更多的低、中、高层次特征和分类器,并具有更强大的特征提取和映射能力。为了避免CNN网络的退化和梯度消失/爆炸问题,在深层CNNs中将残差网络结构与密集网络结构结合来解决这些问题。在网络主体部分连接若干RRDB,并将特征提取层的特征乘以缩放值α,缩放后连接到网络结尾的信息融合部分,此处的α可以防止云雾信息过量引入。主体网络部分采用泄露修正线性单元(leaky ReLU[53-54])激活,用于增加网络的非线性;它对输入小于0部分的反应有所变化,减轻了激活函数ReLU的稀疏性。Leaky ReLU表示为

(8)

(8)

|

| 图 14 RDCNN夜光影像去云雾网络结构 Fig. 14 RDCNN nighttime light remote sensing image cloud removal network structure |

式中,xi为激活前特征图i点的值;yi为激活后该点的值;ai为(1,+∞)区间内固定参数。

在网络的信息融合部分,针对影像中不同区域云雾浓度不同的问题,引用像素注意力模块(pixel attention, PA)和通道注意力模块(channel attention, CA)[55]。PA根据影像不同的像素特征,自适应学习不同的加权信息,CA根据云雾信息在不同特征通道上表现程度的不同,通过自适应学习为不同的通道特征提供不同的加权信息,这为处理不同类型的云雾信息提供了额外的灵活性,并扩展了CNNs的表示能力。

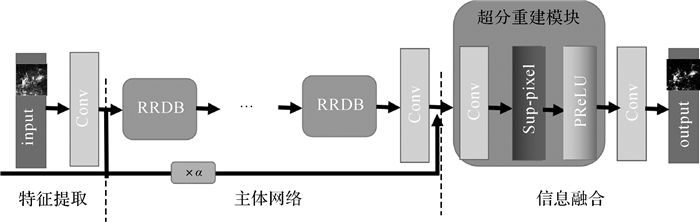

在超分辨率重建网络中,去除RDCNN网络后端的PA、CA模块,在网络结尾部分增加超分辨率重建模块。在超分模块中使用亚像素卷积,能将低分辨的特征图和多通道间重组,得到高分辨率的特征图,具体结构如图 15所示。

|

| 图 15 基于RDCNN的夜光影像超分重建网络结构 Fig. 15 Structure diagram of nighttime light remote sensing imagesuper-resolution network based on RDCNN |

在损失函数方面,目前经常使用L2范数,但当影像降质复杂时容易使影像的高频信息丢失。为避免上述问题本文提出一种比值型范数的稀疏约束[56]损失函数,损失函数为

(9)

(9)

式中,∂为损失函数;F代表整个卷积神经网络;I(x, y)为输入的观测的退化影像;J(x, y)为清晰的标签影像。

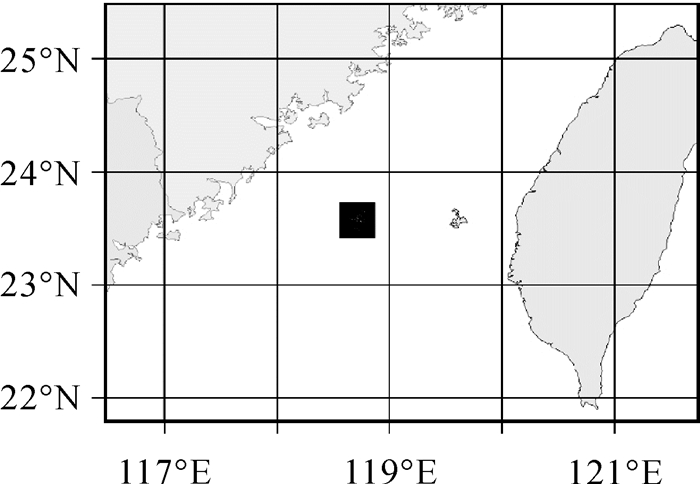

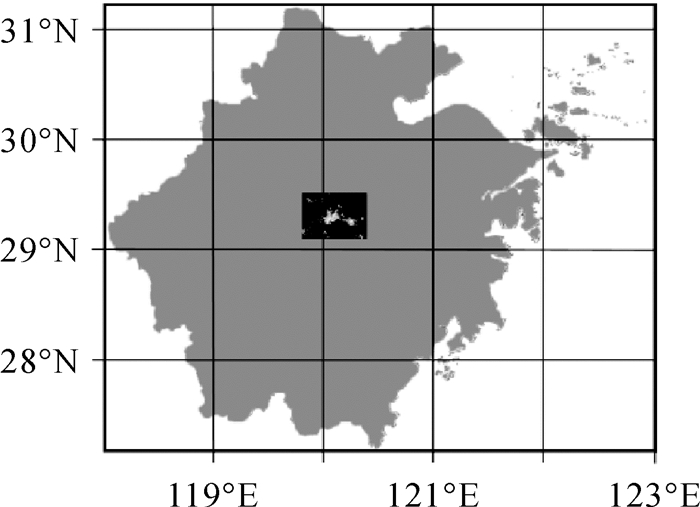

3 试验及讨论 3.1 试验数据试验数据选择珞珈一号台湾海峡、浙江省东阳市的影像,影像成像参数见表 2。夜光影像主要记录地面的光源信息,当光源分布较稀疏时,在影像中呈现出类似点状发光信息;当光源分布较密集时,在影像中呈现出线状或近似面状的光源信息。一般城市的夜光影像中分布着面状、线状、点状光源,且光源位置相对固定;海面上船只呈现点状光源。孤立点状光源影像中的辉光及云雾信息更容易辨别,因此,选择含有类似点状光源的海上渔船的影像作为试验区1,选择城市地区作为试验区2,验证本文方法对含有不同类型光源区域的处理效果。试验区域的地理位置分布如图 16、图 17所示。

| 影像 | 成像时间 | 分辨率 | 数据格式 | 地区 |

| 试验区1测试影像 | 2018-11-29 | 130 m | Tiff | 台湾海峡 |

| 对比的无云影像 | 2018-08-21 | |||

| 试验区2测试影像 | 2018-06-16 | 浙江省东阳市 | ||

| 对比的无云影像 | 2018-10-29 |

|

| 图 16 试验1台湾海峡影像分布 Fig. 16 Image distribution map of Taiwan Strait in experiment 1 |

|

| 图 17 试验2浙江地区影像分布 Fig. 17 Image distribution map of Zhejiang in experiment 2 |

3.2 试验过程及结果

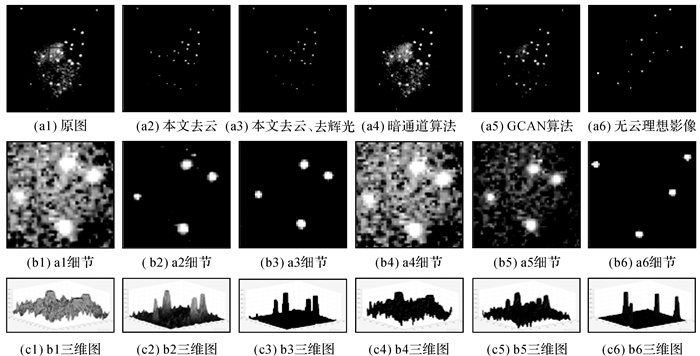

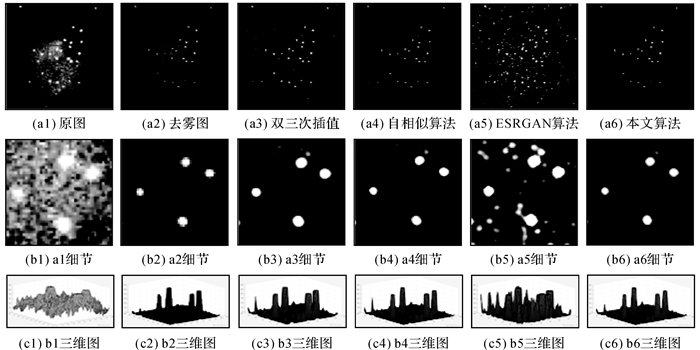

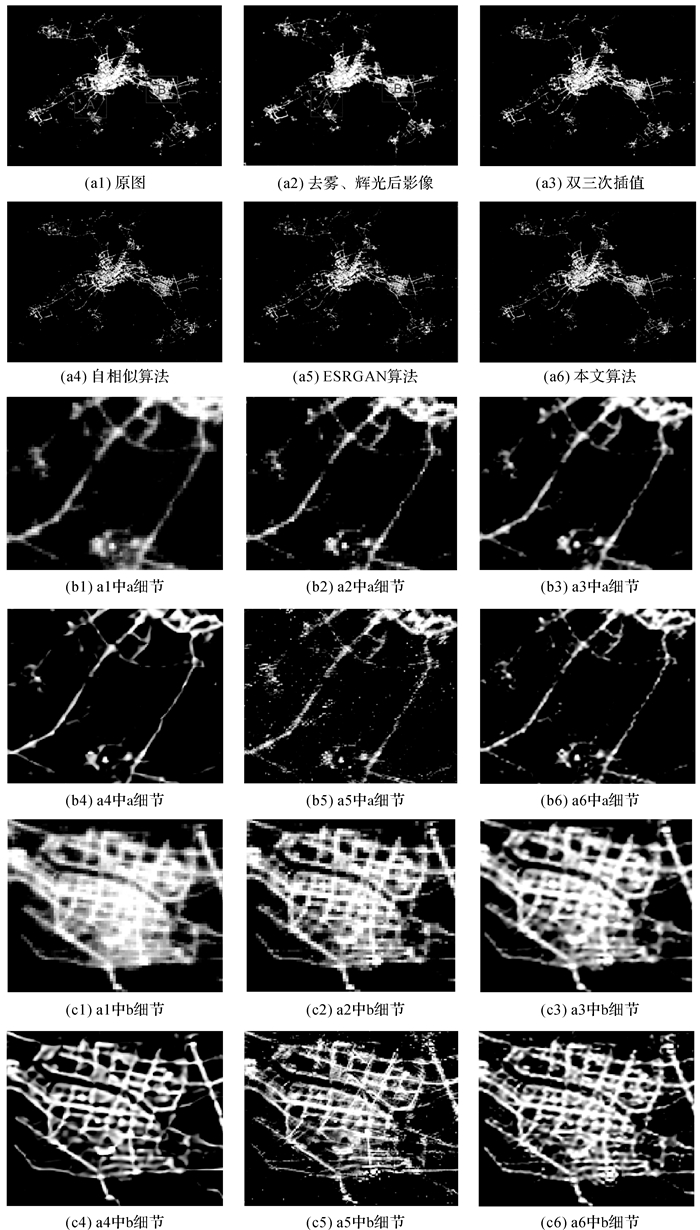

试验中将本文方法去云雾、去辉光的结果与暗通道方法、GCAN方法进行对比,将超分辨率重建的结果与双三次插值、自相似方法、ESRGAN方法进行对比。试验中GCAN、ESRGAN方法在公开的权值文件的基础上训练。由于对比的超分方法没有去云雾的效果,直接比较没有可比性,因此,此部分试验将本文方法去云雾、辉光后的影像作为其他重建方法的输入影像。

试验的训练过程是先利用数据集A训练去辉光网络,并将得到的权值文件作为去云雾网络的初始值;然后利用数据集B1和数据集B2训练去云雾网络,得到去云雾的权值文件;最后利用数据C训练超分辨率重建网络,得到超分辨率重建网络的权值文件。试验中,RRDB层设置为23层,滤波器大小设置为3×3,卷积过程中采用0值填充影像,步长设置为1,特征通道数设置为64,RDB块中间滤波器输出特征通道数设置为32,主体部分输出通道数设置为64。特征提取层的特征缩放因子α和残差连接部分缩放因子β均设置为0.2,学习率设定为1×10-5,优化器使用Adam,指数衰减率系数分别设置为β1=0.9,β2=0.999。

试验的测试过程是先输入原始低分辨率影像,用训练好的去云雾权值对影像去云雾,然后用去辉光权值对影像去辉光,最后用超分辨重建权值提升分辨率,最终得到质量提升后的影像。试验平台采用PyTorch框架,使用NVIDIA GeForce GTX 1080Ti GPU进行训练。图 18—图 21为试验结果对比图。

|

| 图 18 试验1不同算法的去云雾结果对比 Fig. 18 Comparison of cloud removal results of different algorithms in experiment 1 |

|

| 图 19 试验1区域不同算法超分重建结果对比 Fig. 19 Comparison of the results of different algorithms in the experiment 1 region |

|

| 图 20 试验2区域不同算法超分重建结果对比 Fig. 20 Comparison of the results of different algorithms in the experiment 2 area |

|

| 图 21 试验2区域的无云影像 Fig. 21 Cloudless image of experiment 2 area |

3.3 讨论

对比图 18中试验区1的去云雾、去辉光结果。由图 18(c1)—(c6)可以看出,图 18(c4)与(c1)相差不大,图 18(c5)比原图略好,图 18(c2)主要灯光点的周围没有过多的小峰值杂波,图 18(c3)最好。对比图 18(a1)—(a6)和图 18(b1)—(b6),图 18(a4)、(b4)与原图相差不大,图 18(a5)、(b5)略好于原图,但没有图 18(a2)、(a3)处理效果好。以上对比说明暗通道算法和GCAN算法处理夜光影像效果欠佳。本文方法处理后的影像云雾和辉光信息明显减少,影像上的模糊扩散范围缩减,夜光信息更加清晰。

进一步对去除了云雾和辉光的影像进行超分辨率重建处理,处理结果如图 19所示。对比图 19(c1)—(c6)可以看出,图 19(c5)比(c2)柱状波峰多,对比原图可知这些信息是伪信息,图 19(c3)、(c4)比原图好,但没有图 19(c6)效果明显。

对比图 19(a1)—(a6)、图 19(b1)—(b6),图 19(a3)、(b3)的点状光源轻微扩散,少量噪声信息被放大;图 19(a4)、(b4)的点状光源边界清晰,但少量噪声信息也被放大,灯光内部无梯度变化;图 19(a5)、(b5)的点状光源扩散严重,目标所占像元增大,增大了扰动范围且噪声信息放大严重,许多噪声被作为信息重建。这些说明双三次插值方法、自相似方法和ESRGAN方法对噪声比较敏感,噪声信息放大比较严重。与其他方法相比,图 19(a6)、(b6)的点状光源边缘更加清晰,灯光信息也更加“聚拢”,噪声信息明显减少,这说明超分辨重建处理提高了影像质量。

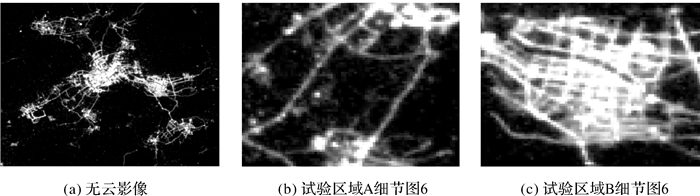

试验2是针对城区及郊区的夜光影像超分辨率重建试验。试验流程及参数设置与试验1相同。在该区域的去云雾、去辉光也取得了较好的结果,如图 20(a2)及其相应细节所示,并以此为超分辨率重建的输入影像,最后的重建结果影像如图 20所示,该区域的无云影像如图 21所示。对比观察图 20(a3)、(b3)、(c3)可以看出,插值后的影像平滑,灯光边缘模糊严重;图 20(a4)、(b4)、(c4)中的灯光边缘过平滑现象严重,地物信息产生了变形,部分点状灯光信息平滑为线状信息;图 20(a5)、(b5)、(c5)中的灯光密集区域出现假信息和噪声信息;图 20(a6)、(b6)、(c6)中的模糊云雾信息明显减少,与图 21对比可以看出,复杂城区灯光的辉光扩散效应明显减弱,灯光信息更聚拢,细节、边缘更加清晰。说明3种对比方法都没有本文方法有效。

利用评价指标进一步说明本文方法的处理效果。由于夜光影像中只有灯光亮度信息和黑色背景信息,相比于其他影像纹理较单一,现有的光学影像评价指标不太适用。本文算法处理的目的是减少云雾的影响、减少亮点目标的点扩散效应,这与SAR影像减少旁瓣效应很相似。因此,本文借鉴SAR影像的3 dB指标,采用平均意义上的3 dB主瓣宽度进行度量[57],即目标区域所有散射中心3 dB主瓣宽度的平均值。为说明选用指标的有效性,将本文指标与清晰度评价指标Tenengrad进行对比。Tenengrad的计算方法如式(10)所示

(10)

(10)

式中,DT(f)为Tenengrad值;f(x, y)表示图像f在像素点(x, y)的灰度值,一般情况下该指标越大说明图像越清晰。

评价结果如表 3、表 4所示。对比试验1去云雾阶段的指标,从3 dB指标来看,本文方法指标提升明显,去辉光后的指标也有提升,但仍没有无云影像质量好。暗通道算法、GCAN算法指标比原图好,但提升幅度不大,这与无云理想影像相差较大,与主观视觉效果评价结果一致。对比Tenengrad值发现,去云雾处理后的指标都有所提升,但提升幅度不大,说明影像质量都比原图好。仅从指标来看,暗通道方法的指标最优,但从视觉效果来看,只是比原图云雾略好,整体上改变不大。产生这种相反结论的原因是,该指标衡量的是影像的梯度差异,但夜光影像中的梯度信息主要来自于发光点的边缘,如果云雾去除不好,会把一些非光源信息作为影像的边缘信息计算,从而出现指标提升但是视觉效果不佳的结果,因此该指标不适合夜光图像的评价。对比表 4的3 dB指标,可以看出双三次插值方法、自相似方法和ESRGAN方法处理后影像的平均3 dB值都比原影像的值小,说明处理后的影像的空间分辨率都有所提高,影像质量有所改善;ESRGAN方法的3 dB值最大,说明处理效果最差。以上主观和客观的分析说明本文方法处理后的光源信息比原图更清晰,光源更聚拢、界限更明显,评价指标也最优。说明本文方法在去辉光、去云雾,提高影像分辨率方面有效,可以提高夜光影像的质量。

| 处理方法 | 原图 | 本文去云 | 本文去云后去辉光 | 暗通道 | GCAN | 无云影像 |

| Tenengrad | 0.000 6 | 0.001 0 | 0.001 1 | 0.003 42 | 0.002 42 | 0.000 5 |

| 3 dB | 76.670 0 | 18.810 0 | 14.844 9 | 69.577 4 | 53.456 2 | 11.878 1 |

| 试验 | 评价指标 | 原图 | 去云后去辉光 | 双三次插值 | 自相似 | ESRGAN | 本文方法 |

| 试验1 | Tenengrad | 0.000 6 | 0.001 1 | 0.001 4 | 0.002 0 | 0.480 7 | 0.001 7 |

| 3 dB | 76.670 0 | 14.844 9 | 17.500 0 | 13.574 5 | 19.241 1 | 12.613 5 | |

| 试验2 | Tenengrad | 0.002 3 | 0.002 7 | 0.003 8 | 0.006 1 | 1.810 0 | 0.005 5 |

| 3 dB | 2.181 6 | 2.091 2 | 2.210 7 | 1.974 4 | 2.006 4 | 1.703 1 |

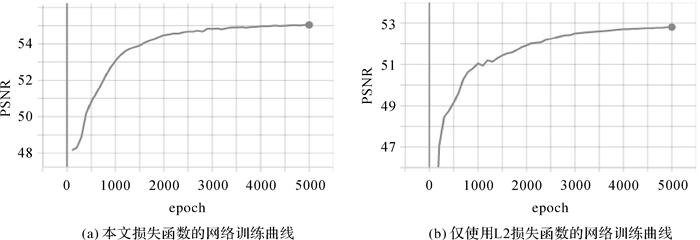

为了验证本文损失函数的作用,以超分辨率网络为例,采用控制变量方法进行测试。测试中只改变本文超分重建网络中的损失函数(即比值约束的损失函数和L2损失函数),原始网络结构和超参数等变量相同,网络主体RRDB模块数量设置为6,在上述条件下进行对比试验。训练过程中监测PSNR值并绘制曲线图,如图 22所示。使用本文网络结构和损失函数可以有效提高网络收敛速度,在训练大约3.5k epoch即可收敛,训练过程更稳定,未出现过拟合现象,训练结果精度更高,影像质量评价指标提升更快。

|

| 图 22 超分重建训练过程中PSNR值监测曲线对比 Fig. 22 Comparison of PSNR value monitoring curves during super-resolution training |

4 结论

本文针对珞珈一号夜光影像的云雾、辉光、分辨率降低的综合降质问题,研究了可解释性先验引导的多降质特征夜光影像质量提升方法,提出了基于成像降质模型分析的深度学习超分辨率重建方法。主要的工作包括:①本文从传感器成像类型、成像中多种降质因素方面讨论了珞珈一号夜光影像的降质模型公式,发展了以日间影像为主、仅考虑单一降质的问题,扩宽了夜光影像成像降质模型的研究思路;②针对遥感影像无法获得同一传感器真实的高、低分影像对的问题,从珞珈一号夜光影像数据集制作入手,结合成像降质模型,设计了考虑辉光、云雾模型的数据集制作方法,为解决目前缺少夜光影像数据集问题提供了参考方法;③针对深度学习方法可解释性差的问题,本文在训练网络、提升网络、损失函数等方面考虑了夜光影像成像降质模型的先验信息,使网络更具有可解释性。而且本文设计的深度学习网络模型复杂度低,并通过增加训练数据、使用带有正则化项的损失函数等方法尽量避免过拟合现象。用试验验证了本文方法,通过和传统方法、深度学习方法的对比可以看出,有先验引导的数据集有较好的训练效果,本文方法具备去云雾、去辉光、提升影像分辨率的能力,能够明显改善影像的质量,为了扩展该网络的迁移性,后期将会进一步研究其他类型的夜光数据(如SDGSAT、启明星等)的质量提升,为夜光数据的定量反演更提供更高质量的数据。

| [1] |

李德仁, 李熙. 论夜光遥感数据挖掘[J]. 测绘学报, 2015, 44(6): 591-601. LI Deren, LI Xi. An overview on data mining of nighttime light remote sensing[J]. Acta Geodaetica et Cartographica Sinica, 2015, 44(6): 591-601. DOI:10.11947/j.AGCS.2015.20150149 |

| [2] |

LI Xi, LI Deren, XU Huimin, et al. Intercalibration between DMSP/OLS and VⅡRS night-time light images to evaluate city light dynamics of Syria's major human settlement during Syrian Civil War[J]. International Journal of Remote Sensing, 2017, 38(21): 5934-5951. DOI:10.1080/01431161.2017.1331476 |

| [3] |

BENNETT M M, SMITH L C. Advances in using multitemporal night-time lights satellite imagery to detect, estimate, and monitor socioeconomic dynamics[J]. Remote Sensing of Environment, 2017, 192: 176-197. DOI:10.1016/j.rse.2017.01.005 |

| [4] |

JIANG Wei, HE Guojin, LONG Tengfei, et al. Potentiality of using Luojia 1-01 nighttime light imagery to investigate artificial light pollution[J]. Sensors (Basel, Switzerland), 2018, 18(9): 2900. DOI:10.3390/s18092900 |

| [5] |

张洋. 微纳卫星低照度成像像质提升研究[D]. 长春: 中国科学院长春光学精密机械与物理研究所, 2017. ZHANG Yang. The improvement of micro-satellite's low-light remote sensing image quality[D]. Changchun: Changchun Institute of Optics, Fine Mechanics and Physics, Chinese Academy of Sciences, 2017. |

| [6] |

董慧颖, 王欣威, 沈凤龙, 等. 基于多散射模型的光源退化图像复原方法及应用[J]. 沈阳理工大学学报, 2010, 29(3): 9-12, 34. DONG Huiying, WANG Xinwei, SHEN Fenglong, et al. A method of restoring light source degradation image based on multiple scattering model and its application[J]. Journal of Shenyang Ligong University, 2010, 29(3): 9-12, 34. DOI:10.3969/j.issn.1003-1251.2010.03.003 |

| [7] |

ABRAHAMS A, ORAM C, LOZANO-GRACIA N. Deblurring DMSP nighttime lights: a new method using Gaussian filters and frequencies of illumination[J]. Remote Sensing of Environment, 2018, 210: 242-258. DOI:10.1016/j.rse.2018.03.018 |

| [8] |

KARAM G S. Blurred image restoration with unknown point spread function[J]. Al-Mustansiriyah Journal of Science, 2018, 29(1): 189-194. DOI:10.23851/mjs.v29i1.335 |

| [9] |

CHAVEZ P. Radiometric calibration of Landsat thematic and mapper multispectral images[J]. Photogrammetric Engineering and Remote Sensing, 1989, 55: 1285-1294. |

| [10] |

HE K, SUN J, TANG X. Single image haze removal using dark channel prior[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(12): 2341-2353. DOI:10.1109/TPAMI.2010.168 |

| [11] |

PARK S C, PARK M K, KANG M G. Super-resolution image reconstruction: a technical overview[J]. IEEE Signal Processing Magazine, 2003, 20(3): 21-36. DOI:10.1109/MSP.2003.1203207 |

| [12] |

AL ISMAEIL K, AOUADA D, OTTERSTEN B, et al. Multi-frame super-resolution by enhanced shift and add[C]//Proceedings of the 8th International Symposium on Image and Signal Processing and Analysis (ISPA). Trieste, Italy: IEEE, 2014: 171-176.

|

| [13] |

NASROLLAHI K, MOESLUND T B. Super-resolution: a comprehensive survey[J]. Machine Vision and Applications, 2014, 25(6): 1423-1468. DOI:10.1007/s00138-014-0623-4 |

| [14] |

FARSIU S, ROBINSON M D, ELAD M, et al. Fast and robust multiframe super resolution[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2004, 13(10): 1327-1344. DOI:10.1109/TIP.2004.834669 |

| [15] |

苏衡, 周杰, 张志浩. 超分辨率图像重建方法综述[J]. 自动化学报, 2013, 39(8): 1202-1213. SU Heng, ZHOU Jie, ZHANG Zhihao. Survey of super-resolution image reconstruction methods[J]. Acta Automatica Sinica, 2013, 39(8): 1202-1213. |

| [16] |

FREEMAN W T, JONES T R, PASZTOR E C. Example- based super-resolution[J]. IEEE Computer Graphics and Applications, 2002, 22(2): 56-65. DOI:10.1109/38.988747 |

| [17] |

CHANG Hong, YEUNG D Y, XIONG Yimin. Super-resolution through neighbor embedding[C]//Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington, DC, USA: IEEE, 2004: I.

|

| [18] |

YANG Jianchao, WRIGHT J, HUANG T S, et al. Image super-resolution via sparse representation[J]. IEEE Transactions on Image Processing, 2010, 19(11): 2861-2873. DOI:10.1109/TIP.2010.2050625 |

| [19] |

LECUN Y, BENGIO Y, HINTON G. Deep learning[J]. Nature, 2015, 521(7553): 436-444. DOI:10.1038/nature14539 |

| [20] |

GONG Jianya, JI Shunping. Photogrammetry and deep learning[J]. Journal of Geodesy and Geoinformation Science, 2018(1): 1-15. |

| [21] |

CAI Bolun, XU Xiangmin, JIA Kui, et al. DehazeNet: an end-to-end system for single image haze removal[J]. IEEE Transactions on Image Processing, 2016, 25(11): 5187-5198. DOI:10.1109/TIP.2016.2598681 |

| [22] |

ZHANG He, PATEL V M. Densely connected pyramid dehazing network[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA: IEEE, 2018: 3194-3203.

|

| [23] |

LI Boyi, PENG Xiulian, WANG Zhangyang, et al. AOD-net: all-in-one dehazing network[C]//Proceedings of 2017 IEEE International Conference on Computer Vision (ICCV). Venice, Italy: IEEE, 2017: 4780-4788.

|

| [24] |

REN Wenqi, MA Lin, ZHANG Jiawei, et al. Gated fusion network for single image dehazing[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA: IEEE, 2018: 3253-3261.

|

| [25] |

BHARATH RAJ N, VENKETESWARAN N. Single image haze removal using a generative adversarial network[C]//Proceedings of 2020 International Conference on Wireless Communications Signal Processing and Networking (WiSPNET). Chennai, India: IEEE, 2020: 37-42.

|

| [26] |

CHEN Dongdong, HE Mingming, FAN Qingnan, et al. Gated context aggregation network for image dehazing and deraining[C]//Proceedings of 2019 IEEE Winter Conference on Applications of Computer Vision (WACV). Waikoloa, HI, USA: IEEE, 2019: 1375-1383.

|

| [27] |

LIAO Yinghong, SU Zhuo, LIANG Xiangguo, et al. HDP- net: haze density prediction network for nighttime dehazing[C]//Proceedings of 2018 PCM Advances in Multimedia Information. Cham, Germany: Springer International Publishing, 2018: 469-480.

|

| [28] |

DONG Chao, LOY C C, HE Kaiming, et al. Learning a deep convolutional network for image super-resolution[C]// Proceedings of 2014 Computer Vision. Cham, Germany: Springer International Publishing, 2014: 184-199.

|

| [29] |

DONG Chao, LOY C C, TANG Xiaoou. Accelerating the super-resolution convolutional neural network[C]//Proceedings of Computer Vision-ECCV 2016. Cham, Germany: Springer International Publishing, 2016: 391-407.

|

| [30] |

SHI Wenzhe, CABALLERO J, HUSZÁR F, et al. Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA: IEEE, 2016: 1874-1883.

|

| [31] |

MAO Xiaojiao, SHEN Chunhua, YANG Yubin. Image restoration using convolutional autoencoders with symmetric skip connections[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR). [S. l. ]: IEEE, 2016.

|

| [32] |

KIM J, LEE J K, LEE K M. Accurate image super-resolution using very deep convolutional networks[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, NV, USA: IEEE, 2016: 1646-1654.

|

| [33] |

LIM B, SON S, KIM H, et al. Enhanced deep residual networks for single image super-resolution[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Honolulu, HI, USA: IEEE, 2017: 1132-1140.

|

| [34] |

ZHANG Yulun, TIAN Yapeng, KONG Yu, et al. Residual dense network for image super-resolution[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA: IEEE, 2018: 2472-2481.

|

| [35] |

TAI Ying, YANG Jian, LIU Xiaoming. Image super-resolution via deep recursive residual network[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA: IEEE, 2017: 2790-2798.

|

| [36] |

ZHANG Yulun, TIAN Yapeng, KONG Yu, et al. Residual dense network for image super-resolution[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, UT, USA. IEEE, 2018: 2472-2481.

|

| [37] |

GU Jinjin, LU Hannan, ZUO Wangmeng, et al. Blind super-resolution with iterative kernel correction[C]//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach, CA, USA: IEEE, 2020: 1604-1613.

|

| [38] |

LEDIG C, THEIS L, HUSZáR F, et al. Photo-realistic single image super-resolution using a generative adversarial network[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, HI, USA: IEEE, 2017: 105-114.

|

| [39] |

WANG Xintao, YU Ke, WU Shixiang, et al. ESRGAN: enhanced super-resolution generative adversarial networks[M]. Cham: Springer International Publishing, 2019: 63-79.

|

| [40] |

冈萨雷斯, 理查德·伍兹. 数字图像处理(MATLAB版)[M]. 北京: 电子工业出版社, 2005: 103-104. GONZALEZ RAFAEL C., Woods RICHARD E.. Digial image processing using MATLAB[M]. Beijing: Publishing House of Electronics Industry, 2005: 103-104. |

| [41] |

AUBÉ M. Physical behaviour of anthropogenic light propagation into the nocturnal environment[J]. Philosophical Transactions of the Royal Society of London Series B, Biological Sciences, 2015, 370(1667): 194-199. |

| [42] |

KYBA C C, RUHTZ T, FISCHER J, et al. Cloud coverage acts as an amplifier for ecological light pollution in urban ecosystems[J]. PLoS One, 2011, 6(3): e17307. DOI:10.1371/journal.pone.0017307 |

| [43] |

SANCHEZ DE MIGUEL A, KYBA C C M, ZAMORANO J, et al. The nature of the diffuse light near cities detected in nighttime satellite imagery[J]. Scientific Reports, 2020, 10(1): 7829. DOI:10.1038/s41598-020-64673-2 |

| [44] |

LI Xuecao, ZHOU Yuyu. Urban mapping using DMSP/ OLS stable night-time light: a review[J]. International Journal of Remote Sensing, 2017, 38(21): 6030-6046. DOI:10.1080/01431161.2016.1274451 |

| [45] |

ZHANG J, REID J S, MILLER S D, et al. Strategy for studying nocturnal aerosol optical depth using artificial lights[J]. International Journal of Remote Sensing, 2008, 29(16): 4599-4613. DOI:10.1080/01431160802020528 |

| [46] |

MILLER S D, TURNER R E. A dynamic lunar spectral irradiance data set for NPOESS/VⅡRS day/night band nighttime environmental applications[J]. IEEE Transactions on Geoscience and Remote Sensing, 2009, 47(7): 2316-2329. DOI:10.1109/TGRS.2009.2012696 |

| [47] |

HE Kaiming, SUN Jian, TANG Xiaoou. Single image haze removal using dark channel prior[C]//Proceedings of 2010 IEEE Transactions on Pattern Analysis and Machine Intelligence. [S. l. ]: IEEE, 2010: 2341-2353.

|

| [48] |

FATTAL R. Single image dehazing[J]. ACM Transactions on Graphics, 2008, 27(3): 1-9. |

| [49] |

YOSINSKI J, CLUNE J, BENGIO Y, et al. How transferable are features in deep neural networks?[C]//Proceedings of the 27th International Conference on Neural Information Processing Systems-Volume 2. Montreal, Canada. ACM Press, 2014: 3320-3328.

|

| [50] |

ERHAN D, BENGIO Y, COURVILLE A, et al. Why does unsupervised pre-training help deep learning[J]. Journal of Machine Learning Research, 2010, 11(3): 625-660. |

| [51] |

ABRAHAMS A, ORAM C, LOZANO-GRACIA N. Deblurring DMSP nighttime lights: a new method using Gaussian filters and frequencies of illumination[J]. Remote Sensing of Environment, 2018, 210: 242-258. DOI:10.1016/j.rse.2018.03.018 |

| [52] |

李欣. 基于深度学习的单幅遥感图像超分辨重建[D]. 北京: 中国科学院大学, 2018. LI Xin. Super-resolution reconstruction of single remote sensing image based on deep learning[D]. Beijing: Chinese Academy of Sciences, 2018. |

| [53] |

LIU Shuying, DENG Weihong. Very deep convolutional neural network based image classification using small training sample size[C]//Proceedings of the 3rd IAPR Asian Conference on Pattern Recognition (ACPR). Kuala Lumpur, Malaysia: IEEE, 2016: 730-734.

|

| [54] |

BUŠTA M, NEUMANN L, MATAS J. Deep TextSpotter: an end-to-end trainable scene text localization and recognition framework[C]//Proceedings of 2017 IEEE International Conference on Computer Vision (ICCV). Venice, Italy: IEEE, 2017: 2223-2231.

|

| [55] |

QIN Xu, WANG Zhilin, BAI Yuanchao, et al. FFA-net: feature fusion attention network for single image dehazing[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(7): 11908-11915. DOI:10.1609/aaai.v34i07.6865 |

| [56] |

卜欣彤. 基于PSF优化估计的图像盲复原方法研究[D]. 阜新: 辽宁工程技术大学, 2017. BU Xintong. Research on image blind restoration based on PSF optimization estimation[D]. Fuxin: Liaoning Technical University, 2017. |

| [57] |

王正明, 朱炬波, 谢美华, 等. SAR图像提高分辨率技术[M]. 北京: 科学出版社, 2006: 23-24. WANG Zhengming, ZHU Jubo, XIE Meihua, et al. SAR image resolution improvement technology[M]. Beijing: Science Press, 2006: 23-24. |