2. 中国地质大学(武汉)地理与信息工程学院, 武汉 430078;

3. 中国地质大学(武汉)计算机学院, 武汉 430078;

4. 武汉科技大学计算机科学与技术学院, 武汉 430081

2. School of Geography and Information Engineering, China University of Geosciences, Wuhan 430078, China;

3. School of Computer Science, China University of Geosciences, Wuhan 430078, China;

4. School of Computer Science and Technology, Wuhan University of Science and Technology, Wuhan 430081, China

遥感影像是进行地球资源探索和环境分析的重要手段,并作为重要的地理信息数据而被广泛研究和应用[1-2]。然而,由于遥感设备的性能的限制,采集的遥感影像在质量上都有所差别[3],低分辨率的遥感影像为需要高精度地物解译的研究带来干扰。对遥感影像进行超分辨重建成为高精度解译应用前不可或缺的预处理过程。因此,无法对获取过程中完全损失的信息进行重建和恢复。当前图像超分辨率重建研究的算法可归类为3种:基于像素插值的算法、基于模型重建的算法和基于特征学习的算法。

基于像素插值的重建算法是利用信号处理的算法提高图像分辨率,传统的像素插值算法[4-10]可分为最邻近插值、线性插值和双三次插值方法。基于像素插值的重建方法简单易行,但不能对更远距离纹理进行分析和计算,因此,专家和学者又提出了基于模型重建的超分辨率重建方法,该方法以修复图像中的纹理细节为目的,主要包括迭代反投影法[11-12]、凸集投影法[13]和最大后验概率估计法[14-15]。基于模型重建的方法需要大量的先验信息,为复杂场景下超分辨率重建任务带来难度,因此,学者提出基于特征学习的重建方法。随着深度学习模型生成对抗网络[16](generative adversarial networks, GAN)的提出,基于生成对抗网络的超分辨率重建研究也成为改善遥感影像质量的重要手段。基于生成对抗网络的超分辨率重建算法(super-resolution generative adversarial networks,SRGAN)[17]首次将GAN引入超分辨率重建研究,实现了低分辨率图像的4倍重建。ESRGAN(enhanced super-resolution generative adversarial networks)[18]方法则以SRGAN为基础,设计残差密集模块(residual in residual dense block, RRDB)代替原始的基础模块以增强生成网络的特征学习能力。

基于深度学习的重建研究已能实现低分辨率图像的清晰恢复,但在遥感影像地物重建上仍存在局限性:①由于卷积神经网络的“局部感知”特性导致大规模场景下较远距离的相似性参考地物信息被忽略,扩展到全局的遥感地物信息没有被重视和利用;②遥感解译应用中,地物纹理细节的恢复是精细化遥感影像的关键因素。

因此,本文提出一种顾及全局特征和纹理特征的遥感图像超分辨率重建方法。一方面,地物全局特征增强部分在生成网络中引入自注意力模块(self-attention model)[19],该模块与生成网络中上采样块相连接,以获取全局地物注意力图的方式将遥感影像中相距较远地物信息作为重建过程的参考。另一方面,纹理增强部分在损失函数中引入纹理损失以生成符合地物特征的纹理信息。另外,本文采用权值归一化(weight normalization, WN)[20]代替批量归一化(batch normalization,BN)[21]以避免重建结果中的色彩不一致的现象。

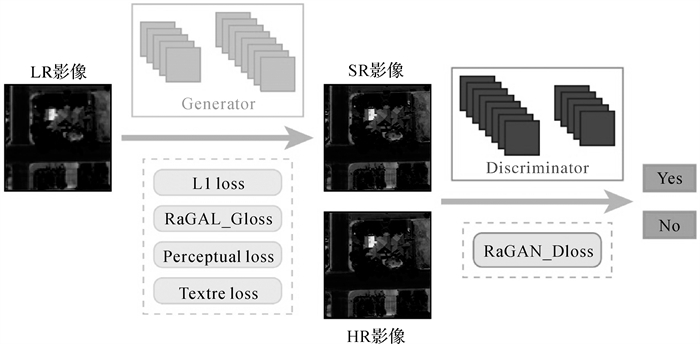

1 超分辨率重建网络模型本文提出的遥感影像超分辨率重建方法从增强地物全局部分和纹理特征出发,对模型的网络结构和损失函数进行改进。一方面,在生成网络中引入自注意力模块获取较远的地物全局特征。另一方面,在网络优化过程中引入纹理损失函数,对地物纹理细节进行增强。本文提出的遥感影像超分辨重建方法结构由生成网络和判别网络组成,在全局特征增强部分对生成网络结构和判别网络结构进行了详细介绍。本文提出的超分辨率重建算法结构如图 1所示。

|

| 图 1 遥感影像超分辨率重建算法结构 Fig. 1 The structure of remote sensing image super-resolution reconstruction |

1.1 地物全局特征增强方法

为更好地提取低分辨率遥感影像的特征,本文超分辨率重建方法以ESRGAN框架为基础,采用在生成网络中利用RRDB模块提取低分辨率影像地物特征信息。RRDB改进了原始的残差模块并将其与稠密连接模块结合以增加各卷积层间的连接以更好地保存浅层特征信息。然而,由于卷积模块中“局部感知”特性限制了其特征提取的范围,导致较远距离全局特征无法参与。因此,本文在原有生成网络的上采样层后引入自注意力模块。自注意力模块能通过遥感影像下地物间的关联信息而获得全局几何特征。特征映射过程包括两个注意映射计算过程f(x)和g(x)以及卷积特征映射计算过程h(x)。首先,f(x)特征图和g(x)特征图将被以矩阵相乘的方式进行运算。然后,softmax函数将得到的注意力图处理为归一化特征信息。最后,h(x)特征图部分与注意图进行乘法运算,以增强全局相关性特征。在注意力图中,每个像素都表示与其他部分的相关性。自注意力模块结构如图 2所示。

|

| 图 2 自注意力模块结构 Fig. 2 The structure of the self-attention block |

批处理归一化会对图像进行拉伸,引导色彩和对比度分布趋于规范化,其对比度信息会被破坏,进而影响了超分辨率重建影像的质量。因此,BN的引入会影响重建结果,出现“伪影”(本文中“伪影”指原始低分辨率图像中不存在,但由于重建过程在超分辨率影像中生成的模糊图斑)现象。深度学习模型中BN算法用于解决模型难以收敛的问题。因此,不能通过去除BN模块解决“伪影”现象。为避免这一问题,在本文的超分辨率重建网络中采用权值归一化方法代替传统的批量归一化方法,来改善结果中出现的“伪影”问题。

权值归一化方法是对网络权重进行归一化,不受训练过程中模型最小批量(mini batch)数据大小的影响,且不需要计算批量数据的均值和方法值,因此其计算复杂度要低于批量归一化方法。对于需要大量计算的遥感影像超分辨率重建研究,权值归一化方法更适应于构建超分辨率重建网络。由于权值归一化方法不在特征图上进行规范化,因此能完整地保存图中对比度信息而不对地物特征进行破坏,因而也能避免重建影像中的“伪影”问题。

在本文超分辨率重建模型中,替换批量归一化的权值归一化方法被用于对卷积层后的网络参数进行规范化,生成网络的特征提取过程可表示为

(1)

(1)

式中,x代表上一个网络操作后的特征图;w和b分别代表卷积层的卷积核参数;f则代表非线性处理过程。

对卷积层的权值归一化方法的计算过程可表示为

(2)

(2)

式中,w代表卷积层中的网络参数值;v是w的同维度向量,是欧氏范数,也是单位向量,它代表w的方向性;g是标量,决定了w的长度。

因此,在训练过程中,权值归一化方法后的卷积网络参数可表示为

(3)

(3)

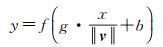

在本文的遥感影像超分辨率重建模型中,为获取遥感影像地物特征的全局信息,在上采样特征层前引入自注意力模块,对遥感影像的远距离地物信息进行学习以解决卷积模块中“局部感知”带来的特征提取局限。为避免重建结果出现不必要的“伪影”而影响遥感解译应用,本文利用权值归一化方法代替批量归一化方法。本文提出的超分辨率重建模型的生成网络进行了更适应遥感影像超分辨率重建任务的优化过程。本文的超分辨率重建网络的网络结构如图 3所示。

|

| 图 3 遥感影像超分辨率重建生成网络结构 Fig. 3 The generate network of the remote sensing image super-resolution reconstruction |

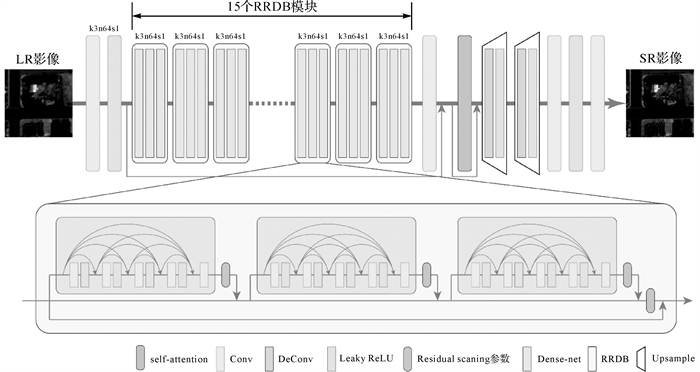

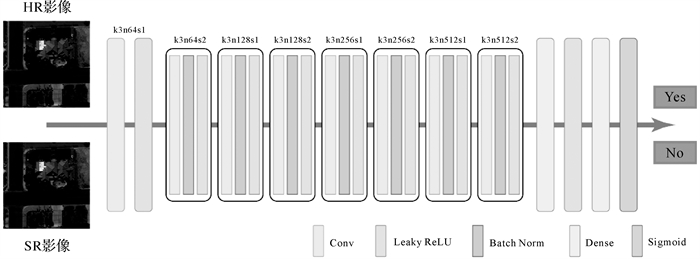

本文判别网络的作用是判别生成网络中重建出的超分辨率遥感影像和真值高分辨率遥感影像的相似程度,因此,判别网络为二分类模型。判别网络以卷积神经网络为基础,以卷积操作、批量归一化和激活函数构成小模块,并引入多个小模块以串联的形式对遥感影像特征进行学习,再连接两个全连接层,最后通过Sigmoid函数得到的超分辨率遥感影像和真值高分辨率遥感影像是真实高分辨率遥感影像的概率。本文判别网络结构如图 4所示。

|

| 图 4 遥感影像超分辨率重建判别网络结构 Fig. 4 The discriminate network of the remote sensing image super-resolution reconstruction |

1.2 遥感影像纹理增强方法

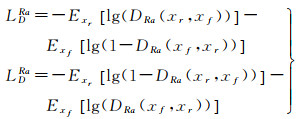

在生成对抗网络的图像处理模型中,对抗损失是确保生成网络和判别网络对抗训练收敛,以及模型性能好坏的关键。针对原GAN中对抗损失的局限性,原ESRGAN中引入的相对对抗损失[22]则具有更稳定的性能。相对生成对抗网络以真实高分辨率遥感影像比重建出的超分辨率影像要真实的概率作为生成网络和判别网络的优化目标。相对生成对抗损失可表示为

(4)

(4)

式中,xr为高分辨率影像;xf为重建出的超分辨率影像;DRa为判别网络。

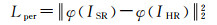

在超分辨率重建任务中,优化像素级损失能得到平滑的纹理信息,但高维视觉特征的缺失将导致重建结果对色彩、纹理和形状信息的缺失。在原ESRGAN模型中,本文引入感知损失对原始高分辨率遥感影像和重建后的高分辨率遥感影像进行判别,对重建后的地物高维特征相似性进行衡量。遥感影像的高维视觉特征涵盖了遥感场景中色彩、纹理和形状特征,而感知损失的引入通过对重建后遥感影像地物高维视觉特征的约束,通过计算生成图像与原始图像间的高维特征映射误差,对生成网络进行高维特征生成的指导,从而解决因缺乏高维特征导致的遥感影像模糊的问题。

VGG16网络在图像分类任务中具有较强的分类能力,该模型具备从大量的复杂场景中提取图像特征信息的特性。因此,本文选取由ImageNet公共数据集预训练得到的VGG16模型对重建后的超分辨率遥感影像和真实高分辨率遥感影像的高维特征图进行计算。本文在感知损失中提取的高维特征信息为VGG16层中特征差的平均值,其特征提取过程出现在激活过程之前,该步骤能够更有效防止提取的特征变稀疏以保留更多的特征细节。遥感影像感知损失的计算过程为

(5)

(5)

式中,ISR代表生成的超分辨率遥感影像;IHR代表原始的高分辨率遥感影像;φ代表VGG16网络提取特征图操作。

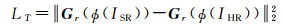

相较于高分辨率遥感影像中丰富的地物细节,低分辨率遥感影像存在显著的地物纹理不足的问题,这也是遥感影像超分辨率重建研究存在的关键问题。尽管感知损失在一定程度上解决了像素级损失无法优化高维特征信息的问题,但超分辨率重建模型仍然不能对遥感影像中地物纹理细节进行精确重建。在遥感影像超分辨率重建任务中,相较于高分辨率遥感影像,低分辨率遥感影像中存在显著的地物纹理信息丢失现象。因此,从低分辨率遥感影像中重建出与高分辨率遥感影像一致的纹理细节成为超分辨率重建任务的研究重点。为增强本文对遥感影像中地物纹理细节的增强能力引入了纹理损失函数,对超分辨率重建模型的优化函数进行优化以恢复真实的高分辨率图像纹理信息。纹理损失函数计算了超分辨率遥感影像和高分辨率遥感影像间分块图像中的纹理差异。在生成网络中,自注意力模块保留了低分辨率遥感影像的全局信息,而纹理损失则能极大地学习其局部纹理细节。

与感知损失不同的是,本文引入的纹理损失在感知损失中仅利用较深层次的特征提取结果进行误差衡量的基础上,对影像的浅层特征提取结果也进行了考虑。感知损失采用VGG16模型中的第16层卷积层后的特征图以提取地物的高维信息,而本文纹理损失则利用VGG16模型中的第5层卷积后的特征层,并在该特征层上计算Gram矩阵值。浅层的特征层进一步体现了遥感影像中地物的位置信息,而Gram矩阵则能从整体上度量重建出的超分辨率遥感影像和原高分辨率遥感影像间各处纹理和风格的相似性,在感知损失的基础上进一步增强模型对地物纹理细节的约束性。

本文通过计算Gram矩阵[23]来计算遥感影像间的纹理损失,以评估特征映射通道之间的关系。Gram矩阵通过计算特征映射的内积来突出遥感影像地物纹理特征。同时,Gram的对角线元素还体现了每个特征在影像中出现的频率,对当前遥感场景的主要地物类别进行重点优化。在本文纹理损失中,通过将超分辨率遥感影像和原始高分辨率遥感影像的特征图进行Gram矩阵内积操作,再将其误差通过反向传播算法(backpropagation algorithm, BP)对生成网络参数进行优化,生成网络能通过纹理特征的学习去模拟低分辨率遥感影像的纹理信息。本文的特征提取模型是VGG19[24]网络通过ImageNet[25]公开数据集训练得到的。本文的纹理损失函数为

(6)

(6)

式中,Gr代表格拉姆矩阵(Gram矩阵),具有Gr(F)=FFT的性质;ϕ(I)代表预训练模型提取的特征图。

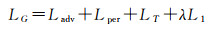

综上所述,本文提出的遥感影像超分辨率重建生成模型的总损失函数为

(7)

(7)

本文的超分辨率重建算法解决了现有重建算法中存在的全局遥感地物信息和纹理信息不足的问题,为验证本文算法在全局地物信息预测和纹理信息恢复方面的能力,在试验验证部分本文使用的遥感影像数据集对不同分辨率下影像色彩、亮度和地物倾斜度等差异进行去除。另一方面,由于试验条件的限制,同一地理坐标下成对高分辨率影像和低分辨率影像无法直接获取,故为获取成对的低分辨率和高分辨率遥感影像训练数据集,将高分辨率遥感影像利用双三次插值法降低其像素大小得到低分辨率遥感影像。本文的试验数据集为高分2号卫星下的清晰遥感影像,获取的遥感影像通过正射校正和大气校正,将4 m多光谱影像和1 m全色影像融合为可用于训练的1 m RGB遥感影像,而后将其每一景遥感影像切割为300×300像素的高分辨率遥感影像数据集。为验证本文提出的超分辨率重建方法对复杂场景的特征增强能力,本文的训练数据集采用具有复杂地物的建筑物城市区域,以验证本文算法对复杂和多样化纹理信息的恢复能力。为避免测试结果受遥感影像中地物种类与训练数据集地物种类差异的影响,本文试验验证中使用的遥感数据集地物种类在训练数据集和测试数据集中的比例一致,均为建筑物密集的人工地物场景。在本文的超分辨率重建试验中,训练数据集包括大小为300×300的49 257张高分辨率遥感影像和大小为75×75的49 257张低分辨率遥感影像,测试数据为大小为75×75的743张低分辨率遥感影像。为了保障本文方法的可靠性,本文展示的重建效果的定量评价指标均为743张测试结果的平均值。

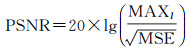

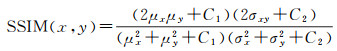

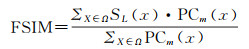

2.2 评价指标在图像超分辨率重建研究中,以峰值信噪比(peak signal to noise ratio, PSNR)、结构相似性(structural similarity, SSIM)、特征相似度(feature similarity, FAIM)为主要的评价手段。在进行超分辨率重建试验结果定量分析时,PSNR、SSIM和FSIM计算的对象为重建后的超分辨率遥感影像与原始高分辨率遥感影像。PSNR是通过图像的均方误差(mean squared error, MSE)定义的,是基于误差敏感的图像质量评价指标。PSNR的计算公式可表示为

(8)

(8)

式中,MAXI代表图像中最大的像素值,在本文试验中试验数据是RGB图像,因此MAXI的最大值为255;MSE是两张图片的均方误差值。

SSIM是用于测量两幅图像在噪声或失真情况下相似性的指标,其计算过程可表示为

(9)

(9)

式中,μx和μy分别为两张图片中所有像素值的平均值;σx和σy分别为两张图像的方差值。

FSIM为SSIM评价方法的优化算法,根据图像中特征的不同将图像像素给予不同的权值,并针对图像特征的相似度对图像进行相似性判别,计算过程可表示为

(10)

(10)

式中,PCm(x)为所有相位一致性特征中的最大值;SL(x)为相位一致性和梯度特征的相似性耦合。

2.3 试验环境及参数设置本文提出的顾及全局特征的遥感影像超分辨率重建网络网络结构包含生成网络和判别网络。在网络训练过程中本文使用Adam[26]方法进行参数优化,学习率分别设置为0.9和0.99。在本文的超分辨率重建模型训练中,由于通过自注意力机制优化了重建网络中的生成模型,以获取全局的遥感影像特征,因此改善了卷积神经网络中局部感受野的特征学习限制。本文的代码实现框架为TensorFlow,并将训练数据集由jpeg的格式转换为占更轻量存储空间的tfrecorders格式,以确保训练效率。在试验设备上,使用了Intel Core i9-9900K处理器,64 GB DDR4的内存,配备11 GB GDDR6显存的NVIDIA GeForce RTX 2080 Ti显卡的图形工作站。

本文提出的遥感影像超分辨率重建方法为重建出具有更精确地物特征的遥感影像,在生成网络中加入自注意力模块,对遥感影像中全局地物细节特征进行学习和重建。另外,为了改善原始生成网络中去除批量归一化带来的梯度消失问题,本文引入权值归一化方法,不仅解决了模型不使用归一化方法带来的梯度消失问题,也完善了原批量归一化方法带来的重建遥感影像中存在的“伪影”现象。为清晰呈现本文提出的遥感影像超分辨率重建模型细节,在生成网络(图 3)和判别网络(图 4)结构图基础上,本文将其网络参数进行展示。本文提出的遥感影像超分辨率重建方法的生成网络和判别网络的结构见表 1、表 2。

| 操作 | 卷积核大小 | 步数 | 卷积核数 | 归一化 | 激活函数 | ||

| conv | 3×3 | 1×1 | 64 | 无 | 无 | ||

| RRDB1 | denseRRDB1_1 | conv1_1_1 | 3×3 | 1×1 | 32 | WN | Leaky_relu |

| ⋮ | |||||||

| conv1_1_5 | 3×3 | 1×1 | 32 | WN | Leaky_relu | ||

| denseRRDB1_3 | conv1_3_1 | 3×3 | 1×1 | 32 | WN | Leaky_relu | |

| ⋮ | |||||||

| conv1_3_5 | 3×3 | 1×1 | 32 | WN | Leaky_relu | ||

| ⋮ | |||||||

| RRDB15 | denseRRDB15_1 | conv15_1_1 | 3×3 | 1×1 | 32 | WN | Leaky_relu |

| ⋮ | |||||||

| conv15_1_5 | 3×3 | 1×1 | 32 | WN | Leaky_relu | ||

| denseRRDB15_3 | conv15_3_1 | 3×3 | 1×1 | 32 | WN | Leaky_relu | |

| ⋮ | |||||||

| conv15_3_5 | 3×3 | 1×1 | 32 | WN | Leaky_relu | ||

| conv | 3×3 | 1×1 | 64 | 无 | 无 | ||

| attention | - | - | - | - | - | ||

| upsample: conv_transpose | 3×3 | 2×2 | 64 | 无 | Leaky_relu | ||

| upsample: conv_transpose | 3×3 | 2×2 | 64 | 无 | Leaky_relu | ||

| conv | 3×3 | 1×1 | 64 | 无 | Leaky_relu | ||

| conv | 3×3 | 1×1 | 3 | 无 | 无 | ||

| 操作 | 卷积核大小 | 步数 | 卷积核数 | 归一化 | 激活函数 | |

| conv | 3×3 | 1×1 | 64 | 无 | Leaky_relu | |

| conv | 3×3 | 1×1 | 64 | BN | Leaky_relu | |

| conv_block1 | conv1_1 | 3×3 | 1×1 | 128 | BN | Leaky_relu |

| conv1_2 | 4×4 | 2×2 | 128 | BN | Leaky_relu | |

| conv_block2 | conv2_1 | 3×3 | 1×1 | 256 | BN | Leaky_relu |

| conv2_2 | 4×4 | 2×2 | 256 | BN | Leaky_relu | |

| conv_block3 | conv3_1 | 3×3 | 1×1 | 512 | BN | Leaky_relu |

| conv3_2 | 4×4 | 2×2 | 512 | BN | Leaky_relu | |

| conv_block4 | conv4_1 | 3×3 | 1×1 | 512 | BN | Leaky_relu |

| conv4_2 | 4×4 | 2×2 | 512 | BN | Leaky_relu | |

| flatten | - | - | - | - | 无 | 无 |

| dense | - | 100 | - | - | 无 | Leaky_relu |

| dense | - | 1 | - | - | 无 | Leaky_relu |

2.4 试验过程和结果分析

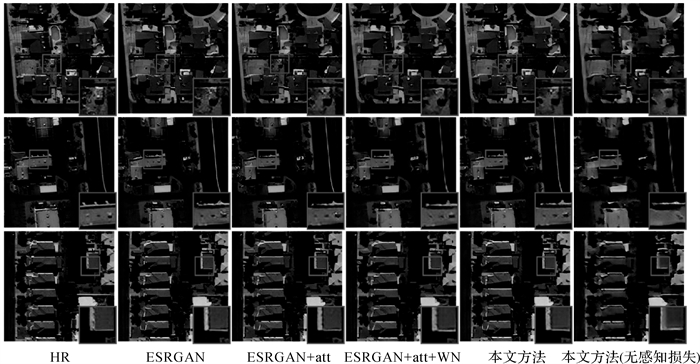

本文提出的遥感影像超分辨率重建方法根据当前低分辨率遥感影像中存在的地物细节不足的问题,从全局和局部特征的信息增强出发,提出了通过加入自注意力机制模块、权值归一化模块和纹理损失3个方法对原超分辨率重建方法进行优化。为了验证本文3个创新点对重建方法的有效性,对本文3个优化方法进行了消融试验,并对试验结果进行了定性和定量评价。其次,为了展示本文提出的遥感影像纹理损失函数和原有感知损失对遥感影像超分辨率重建方法的优化作用,在试验验证中也加入了本文方法在不进行感知损失优化后的重建结果展示。图 5展示了本文创新点消融试验的6张重建结果,依次为高分辨率遥感影像、ESRGAN方法重建结果、ESRGAN方法经自注意力机制优化后的重建结果、ESRGAN方法经自注意力机制和权值归一化方法优化后的重建结果、本文提出的超分辨率重建结果和本文提出的超分辨率重建方法不经过感知损失优化的重建结果。由图 5的结果分析可知,加入自注意力机制后重建方法的重建结果有效改善了原EARGAN模型重建结果中地物细节的恢复,对于低分辨率遥感影像中地物细节不足的问题有了较大改善。而加入权值归一化方法后的遥感影像在地物细节中的“伪影”现象得到解决,在建筑物屋顶中清晰的轮廓线也得到重建。在此基础上的模型通过纹理损失的进一步优化,也增强了感知损失优化后的地物问题细节,建筑物等地物轮廓都重建出真实而清晰的线条轮廓。而不经过感知损失优化的重建结果中建筑物轮廓较为模糊,其规则特征不能得到恢复。

|

| 图 5 各创新点优化后的超分辨率重建结果 Fig. 5 The results of each improved super-resolution reconstruction methods |

由表 3可知,本文提出的超分辨率重建方法在自注意力机制、权值归一化和纹理损失的优化下,PSNR、SSIM和FSIM评价指标均达到了最大值。特别地,为增强遥感影像中地物纹理信息,本文提出的遥感影像超分辨率重建方法引入了增强全局特征的自注意力机制模块和增强局部纹理细节的纹理损失,从对图像特征相似性进行评价的FSIM结果上看,本文优化后的超分辨重建方法在特征信息的增强上存在明显改进。

| 方法 | ESRGAN | ESRGAN+att | ESRGAN+att+WN | 本文方法 | 本文方法(无感知损失) |

| SSIM | 0.741 | 0.742 | 0.745 | 0.756 | 0.638 |

| FSIM | 0.592 | 0.593 | 0.593 | 0.595 | 0.500 |

| PSNR | 25.657 | 25.786 | 25.801 | 26.005 | 24.067 |

本文试验选用经典的深度学习超分辨率重建网络ESPCN(efficient sub pixel convolutional neural network)[27]、EDSR(enhanced deep residual networks super-resolution)[28]、SRGAN、HSENet[29]作为试验对比算法去验证本文提出的遥感影像超分辨率重建方法的有效性。其中,ESPCN算法和EDSR算法是经典的卷积神经网络,并在图像超分辨率重建任务中取得了很好的效果。SRGAN算法是以生成对抗网络为基础框架的经典超分辨率重建模型。HSENet为基于深度学习方法对遥感影像进行超分辨率重建的经典算法,该方法以增强遥感影像中特征信息为研究目的,并构建了相应的单一尺度自相关提取模型(single-scale self-similarity exploitation module, SSEM)和混合尺度自相关提取模型(hybrid-scale self-similarity exploitation module, HSEM)。

为验证本文超分辨率重建方法在视觉上信息增强能力,试验对经典卷积神经网络重建算法和基于生成对抗网络框架的算法重建结果均进行了展示。图 6为5张低分辨率遥感影像的重建结果,分别对低分辨率遥感影像、高分辨率遥感影像、本文方法的重建结果、双三次插值法重建结果、EDSR方法的重建结果、ESPCN方法的重建结果、SRGAN方法的重建结果及遥感影像超分辨率重建方法HSENet方法的重建结果进行了展示。总体而言,本文的超分辨率重建结果视觉效果明显优于其他重建方法,甚至在视觉感知上与真实高分辨率影像达到了同一水平。双三次插值方法重建出的遥感影像中地物要素较为模糊,缺乏纹理信息和边缘细节。EDSR方法和SRGAN算法的重建结果都出现了“伪影”问题,且EDSR方法的重建结果中“伪影”带来了建筑物边缘发散的问题。ESPCN的重建结果中地物纹理信息都较为平滑,与低分辨率影像相比,其地物细节没有得到有效提升。HSENet方法为恢复遥感影像中地物特征的经典算法,从重建结果的视觉效果上可知,它重建出了清晰的遥感影像地物边缘信息,对建筑物边缘细节的重建尤为明显。然而,由于本文试验所使用的数据集中地物类别较为复杂,而HSENet方法则侧重于对单一尺度和混合尺度中地物特征的提取,导致重建出的遥感影像中存在规则的纹理信息。与其他方法相比,本文方法重建的图像地物纹理细节清晰,没有出现“伪影”,且重建结果的色彩空间与原图也能达到一致,证明了本文方法在重建过程中对地物纹理细节恢复上的有效性。同时,相较于其他超分辨率重建方法像素值增加但地物信息模糊的问题,本文超分辨率重建方法恢复了高频细节和真实纹理。

|

| 图 6 各方法超分辨率重建结果 Fig. 6 The results of each super-resolution reconstruction methods |

为对本文超分辨率重建方法进行定量评价,本文试验对上述重建结果进行定量比较,分别计算真实高分辨率遥感影像与本文超分辨率重建方法恢复的超分辨率遥感影像、经典深度学习算法重建的超分辨率遥感影像的SSIM、FSIM和PSNR值,结果见表 4。本文超分辨率重建方法在FSIM值中达到了最高值,在模糊的低分辨率遥感影像中重建出了具有最少特征误差的超分辨率结果。由于本文超分辨率重建方法以感知损失和纹理损失为指导,利用VGG19网络模型对遥感影像中地物高维特征进行重建和约束,并考虑到了遥感影像重建结果对解译任务的优化作用,使用了评价高分辨率遥感影像和超分辨率遥感影像的感知损失和纹理损失,因此,较高的FSIM值也验证了本文提出的超分辨率重建方法有效增加了低分辨率影像中纹理生成过程,并有效增强了地物目标的特征。

| 方法 | 双三次插值 | 本文方法 | EDSR | ESPCN | SRGAN | HSENet |

| SSIM | 0.739 | 0.756 | 0.748 | 0.781 | 0.684 | 0.753 |

| FSIM | 0.503 | 0.595 | 0.576 | 0.581 | 0.568 | 0.580 |

| PSNR | 25.492 | 26.005 | 24.448 | 26.760 | 23.178 | 26.223 |

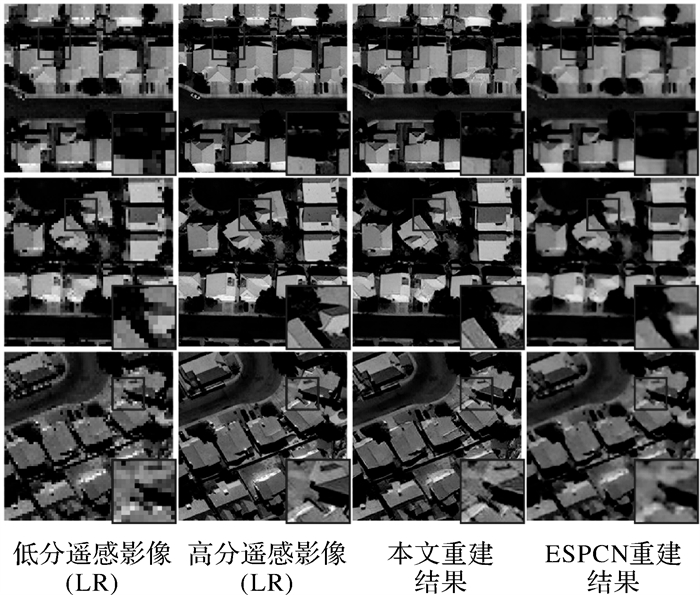

如表 4所示,经典的卷积神经网络超分辨率重建方法ESPCN达到了最高的SSIM和PSNR值。为验证本文超分辨率重建方法与ESPCN方法在实际重建效果上的有效性,试验将低分辨率遥感影像,原始高分辨率遥感影像,本文超分辨率重建方法恢复的超分辨率遥感影像和ESPCN方法恢复的遥感影像在细节上进行对比,其对比结果如图 7所示。

|

| 图 7 各方法超分辨率重建结果细节对比 Fig. 7 Comparison of details of each super-resolution reconstruction results |

在重建结果中,通过方框选取了结果图中部分细节进行放大,本文超分辨率重建方法在地物纹理特征与原图基本保持一致,且边缘细节信息也能很好地恢复出来,在增多像素点数量的同时,还能去除锯齿,保持地物的锐化,高度还原地物基本特征,不存在“伪影”现象。但ESPCN方法则得到了更为平滑的地物纹理细节,这与高精度遥感解译研究的要求是不符合的。SSIM评价指标以两张评价图像的像素误差为基础,并未考虑人眼的视觉特性和遥感影像中地物结构特性,这与本文超分辨率重建方法的目的是有明显偏差的。因此,表 4中所示的ESPCN方法较高的SSIM评价指标也验证了其重建结果地物的平滑现象。

3 结论本文提出了一个顾及地物全局特征和纹理细节的遥感影像超分辨率重建模型。为改进当前超分辨率重建后的超分辨率图像地物特征和纹理细节不足的问题,本文的遥感影像超分辨率重建方法从全局特征和纹理细节这两个部分进行了优化。在模型的全局特征参考方面,在生成网络的上采样层后引入自注意力机制模块以提取低分辨率遥感影像中较远距离地物的全局特征,并利用权值归一化代替批量归一化,以去除遥感影像中多余的“伪影”。在模型的纹理细节增强方面,本文方法引入纹理损失对生成网络的重建过程进行约束,对地物纹理特征进行增强。试验结果表明,本文方法能较好地增强低分辨率遥感影像中的全局特征和纹理细节信息,并对超分辨率重建结果中的“伪影”问题进行了优化。由于试验条件和试验目标的限制,本文采用的试验数据集为通过双三次插值降采样得到的成对低分辨率影像和高分辨率影像,相比于通过不同分辨率遥感影像采集设备获取的遥感影像来说,双三次插值降采样所代表的影像质量退化规律过于片面,在以后的研究中也将充分克服试验数据的片面性,对真实场景下的低分辨率遥感影像进行质量重建和恢复。由于SSIM评价指标对纹理平滑的遥感影像结果更为友好,但本文遥感影像超分辨率重建的研究目的是更好地恢复遥感影像中地物特征。因此,本文的超分辨率重建结果的SSIM评价指标没能达到最高值,在以后的研究中也将充分考虑对遥感影像重建结果的像素点误差优化,进一步提升模型性能。

| [1] |

WANG Kexian, ZHENG Shunyi, LI Rui, et al. A deep double-channel dense network for hyperspectral image classification[J]. Journal of Geodesy and Geoinformation Science, 2021, 4(4): 46-62. |

| [2] |

WANG Yanjun, LI Shaochun, WANG Mengjie, et al. A simple deep learning network for classification of 3D mobile LiDAR point clouds[J]. Journal of Geodesy and Geoinformation Science, 2021, 4(3): 49-59. |

| [3] |

YAO Jiaqi, LI Guoyuan, CHEN Jiyi, et al. Cloud detection and centroid extraction of laser footprint image of GF-7 satellite laser altimetry[J]. Journal of Geodesy and Geoinformation Science, 2021, 4(3): 1-12. |

| [4] |

吴俊斌, 吴晟, 吴兴蛟. 矢量填充和插值算法的图像放大[J]. 计算机与数字工程, 2016, 44(6): 1146-1150, 1166. WU Junbin, WU Sheng, WU Xingjiao. Vector filling and interpolation algorithms of image magnification[J]. Computer & Digital Engineering, 2016, 44(6): 1146-1150, 1166. DOI:10.3969/j.issn.1672-9722.2016.06.034 |

| [5] |

龙四春, 周威, 文佳胜, 等. 雷达地形测绘DEM空洞插补方法研究[J]. 遥感信息, 2015, 30(4): 20-24, 36. LONG Sichun, ZHOU Wei, WEN Jiasheng, et al. SRTM DEM voids interpolation method based on Matlab[J]. Remote Sensing Information, 2015, 30(4): 20-24, 36. DOI:10.3969/j.issn.1000-3177.2015.04.004 |

| [6] |

边刚, 金绍华, 夏伟, 等. 线性插值的海洋磁力测量测线布设评价方法[J]. 测绘学报, 2014, 43(7): 675-680, 697. BIAN Gang, JIN Shaohua, XIA Wei, et al. Evaluating method of the survey line layout based on the linear interpolation in marine magnetic survey[J]. Acta Geodaetica et Cartographica Sinica, 2014, 43(7): 675-680, 697. |

| [7] |

秦彦平, 张军, 多化琼, 等. 木材节子图像增强的小波变换与双三次插值融合方法[J]. 西北林学院学报, 2021, 36(5): 183-189. QIN Yanping, ZHANG Jun, DUO Huaqiong, et al. Fusion method of wavelet transform and bicubic interpolation for wood knot image enhancement[J]. Journal of Northwest Forestry University, 2021, 36(5): 183-189. |

| [8] |

汪智易. 基于流形学习的图像超分辨率重建研究[D]. 西安: 西安电子科技大学, 2014. WANG Zhiyi. Research on image super-resolution reconstruction based on manifold learning[D]. Xi'an: Xidian University, 2014. |

| [9] |

陶志强, 李海林, 张红兵. 基于新边缘指导插值的迭代反投影超分辨率重建算法[J]. 计算机工程, 2016, 42(6): 255-260. TAO Zhiqiang, LI Hailin, ZHANG Hongbing. Iterative back projection super resolution reconstruction algorithm based on new edge directed interpolation[J]. Computer Engineering, 2016, 42(6): 255-260. |

| [10] |

苏锦程, 胡勇, 巩彩兰. 一种混合红外云图超分辨率重建算法[J]. 红外, 2018, 39(8): 34-39. SU Jincheng, HU Yong, GONG Cailan. A super-resolution reconstruction algorithm for hybrid infrared cloud images[J]. Infrared, 2018, 39(8): 34-39. |

| [11] |

郭桐宇. 基于导向滤波与迭代反向投影的遥感影像超分辨率重建[J]. 测绘与空间地理信息, 2019, 42(1): 195-197, 205. GUO Tongyu. Super resolution reconstruction of remote sensing image based on improved iterative back projection algorithm[J]. Geomatics & Spatial Information Technology, 2019, 42(1): 195-197, 205. |

| [12] |

杨琇卿. 基于Lanczos插值的迭代反投影图像超分辨率算法[D]. 济南: 山东大学, 2018. YANG Xiuqing. An iterative back-projection image super-resolution algorithm based on Lanczos interpolation[D]. Jinan: Shandong University, 2018. |

| [13] |

许丽娜, 何鲁晓. 基于凸集投影的高分四号卫星影像超分辨率重建[J]. 测绘学报, 2017, 46(8): 1026-1033. XU Lina, HE Luxiao. GF-4 images super resolution reconstruction based on POCS[J]. Acta Geodaetica et Cartographica Sinica, 2017, 46(8): 1026-1033. DOI:10.11947/j.AGCS.2017.20170070 |

| [14] |

陈波. 自适应光学图像复原理论与算法研究[D]. 郑州: 信息工程大学, 2008. CHEN Bo. The theory and algorithms of adaptive optics image restoration[D]. Zhengzhou: Information Engineering University, 2008. |

| [15] |

武兴睿. 基于PSF重构和改进的最大后验估计的自适应光学图像复原算法[J]. 液晶与显示, 2019, 34(9): 921-927. WU Xingrui. Adaptive optical image restoration method based on PSF reconstruction and improved maximum posteriori estimation[J]. Chinese Journal of Liquid Crystals and Displays, 2019, 34(9): 921-927. |

| [16] |

GOODFELLOW I, POUGET-ABADIE J, MIRZA M, et al. Generative adversarial networks[J]. Communications of the ACM, 2020, 63(11): 139-144. |

| [17] |

CAO Hangpu, MI Sicheng. Weighted SRGAN and reconstruction loss analysis for accurate image super resolution[C]//Proceedings of 2021 Modelling and Intelligent Computing Conference. Guilin, China: CAMMIC, 2021.

|

| [18] |

WANG X, YU K, WU S, et al. Esrgan: enhanced super- resolution generative adversarial networks[C]//Proceedings of 2018 European Conference on Computer Vision (ECCV) Workshops. Munich, Germany: Springer: 2018.

|

| [19] |

ZHANG H, GOODFELLOW I, METAXAS D, et al. Self- attention generative adversarial networks[C]//Proceedings of 2019 International Conference on Machine Learning. [S. l. ]: PMLR, 2019: 7354-7363.

|

| [20] |

SALIMANS T, KINGMA D P. Weight normalization: a simple reparameterization to accelerate training of deep neural networks[C]//Proceedings of the 30th International Conference on Neural Information Processing Systems. Barcelona, Spain: ACM Press, 2016: 901-909.

|

| [21] |

IOFFE S, SZEGEDY C. Batch normalization: accelerating deep network training by reducing internal covariate shift[C]//Proceedings of the 32nd International Conference on International Conference on Machine Learning. New York, NY, USA: ACM Press, 2015, 37: 448-456.

|

| [22] |

JOLICOEUR-MARTINEAU A. The relativistic discriminator: a key element missing from standard GAN[EB/OL]. [2022-01-01]. https://arxiv.org/abs/1807.00734.

|

| [23] |

余志凡, 李昊, 李登实, 等. 基于Gram矩阵和卷积神经网络的风格迁移算法[J]. 江汉大学学报(自然科学版), 2020, 48(3): 62-68. YU Zhifan, LI Hao, LI Dengshi, et al. Style transfer algorithm based on gram matrix and convolutional[J]. Journal of Jianghan University (Natural Science Edition), 2020, 48(3): 62-68. |

| [24] |

SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[EB/OL]. [2021-11-20]. https://arxiv.org/abs/1409.1556.

|

| [25] |

DENG J, DONG W, SOCHER R, et al. ImageNet: a large- scale hierarchical image database[C]//Proceedings of 2009 IEEE Conference on Computer Vision and Pattern Recognition. Miami, USA: IEEE, 2009: 248-255.

|

| [26] |

KINGMA D P, BA J. Adam: a method for stochastic optimization[EB/OL]. [2021-11-20]. https://arxiv.org/abs/1412.6980.

|

| [27] |

SHI W, CABALLERO J, HUSZÁR F, et al. Real-time single image and video super-resolution using an efficient sub-pixel convolutional neural network[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, USA: IEEE, 2016: 1874-1883.

|

| [28] |

LIM B, SON S, KIM H, et al. Enhanced deep residual networks for single image super-resolution[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Honolulu, USA: IEEE, 2017: 136-144.

|

| [29] |

LEI Sen, SHI Zhenwei. Hybrid-scale self-similarity exploitation for remote sensing image super-resolution[J]. IEEE Transactions on Geoscience and Remote Sensing, 2022, 60: 1-10. |