2. 北京建筑大学测绘与城市空间信息学院, 北京 102616

2. School of Geomatics and Urban Spatial Informatics, Beijing University of Civil Engineering and Architecture, Beijing 102616, China

SLAM技术作为一种即时汇集未知环境几何、拓扑、语义等信息的前沿科技,逐渐成为一种集导航定位、地图构建、目标检测和场景识别为一体的测绘技术,在自动驾驶、智能机器人、增强现实等领域发挥了重要作用[1-5],逐渐形成了以激光和相机为主的激光SLAM、视觉SLAM两种技术模式,其中前者起步早、发展相对成熟,后者正处于快速发展与完善阶段[6]。通常情况下, 人类从外界获得的信息约90%来自眼睛,而视觉SLAM具有类似特点,可以从周边环境中获取海量、冗余纹理等测绘要素,并拥有优异的场景辨别能力,配合其优异的性价比,受到诸多学者的青睐。为此,本文重点围绕视觉SLAM环境感知技术及其在测绘方面的应用进行论述。

视觉SLAM环境感知技术是指搭载视觉传感器的载体在没有环境先验信息的情况下,在运动过程中建立环境模型,同时估计载体运动[7-9],先后经历了传统时代(1986—2004)、算法分析时代(2004—2015)、稳健性-预测性时代(2015至今) 3个发展阶段[10],形成了VO(visual odometry)、VIO(visual-inertial odometry)、SLAM等典型算法模型,涌现出了适用于单目、双目、RGB-D等多种传感器的视觉SLAM环境感知技术路线,促进了视觉SLAM环境感知技术在导航、定位和制图等方面的快速发展,并在自动驾驶、航空摄影测量、地面移动测量、信息提取与场景重建等测绘业务中的得到应用[11-13]。

当今,人类社会正逐渐向智能化时代迈进。我国在《2019年政府工作报告》中将人工智能升级为“智能+”,美国、欧盟等全球38个国家、地区制定了国家层面的人工智能战略和政策,推动了人工智能技术研究不断走向深入。随着大数据、人工智能、物联网等新一代信息技术更新发展,推动智能化测绘技术进步和事业转型升级, 已成为测绘业界关心的热门话题[14]。视觉SLAM技术可以实时获取位置、地图、纹理、语义和文字等环境信息,成为环境感知的主要途径之一,但如何通过新一代信息技术的加持,深入探索基于视觉SLAM的环境感知“眼睛”、深度学习算法的“大脑”和众包地理信息的“课堂教学”之间的耦合发展方式,攻克基于视觉SLAM环境感知技术的地理信息环境感知、知识汇聚和智能化应用技术,进一步提高测绘生产力和生产要素的智能化水平,成为当前亟待解决的技术难题。

为了深入探讨基于视觉SLAM环境感知技术支持的智能化测绘发展,需要厘清视觉SLAM环境感知技术概念、理论、技术发展动态,以及当前的测绘应用特点。为此,笔者分析了视觉SLAM环境感知技术的发展现状,探讨了智能化时代的视觉SLAM环境感知技术发展方向,进而提出了智能化时代基于视觉SLAM环境感知技术的智能化测绘应用模式。

1 视觉SLAM环境感知技术研究进展经过30多年的发展,视觉SLAM环境感知技术的理论框架已经逐渐清晰,包括前端、后端、回环检测和制图4个主要的技术环节。前端的任务是估算相邻图像采集时相机的运动和计算局部地图;后端主要是基于回环检测信息对图像位姿和地图信息进行优化;回环检测则是根据图像信息识别已经出现的场景或位置,如果检测到回环,然后把信息提供给后端进行处理;制图环节主要根据估计的轨迹,建立对应的地图[7]。近年来,随着4个主要环节技术的不断发展变化,逐渐形成了以特征点法SLAM、直接法SLAM、视觉指纹库SLAM、语义SLAM和类脑SLAM等为主体的视觉SLAM技术框架和算法模型,并在智慧交通、场景测绘、防灾减灾、虚拟(增强)现实和智慧医疗等领域开展了产业化应用探索。表 1列举了30多年来典型的实时视觉SLAM环境感知算法模型。

| 技术框架 | 典型算法模型 | 技术特点 |

| 特征点法视觉SLAM | MonoSLAM[16] | 基于EKF优化;首次实时SLAM |

| PTAM[17] | 首次采用非线性优化;跟踪与制图并行 | |

| ORB-SLAM系列[3, 19-20] | 典型技术框架,支持多种传感器 | |

| 直接法视觉SLAM | DTAM[24] | 首个完整直接法SLAM框架 |

| LSD-SLAM[25] | 首个大尺度直接法单目视觉SLAM方法 | |

| DVO-SLAM[26] | RGB-D相机SLAM | |

| 视觉指纹库SLAM | FAB-Map[27] | 大范围场景识别与定位算法的重要研究基础 |

| SeqSLAM[28] | 被认为是最成功的环路闭合检测算法 | |

| 语义视觉SLAM | SLAM++[29] | 较早整合语义信息进行定位和制图的算法 |

| CNN-SLAM[30] | 深度学习支持的语义SLAM技术典范 | |

| 类脑视觉SLAM | Rat SLAM[31] | 开创了类脑SLAM算法的先河 |

| NeuroSLAM[32] | 三维脑感知SLAM |

1.1 特征点法视觉SLAM

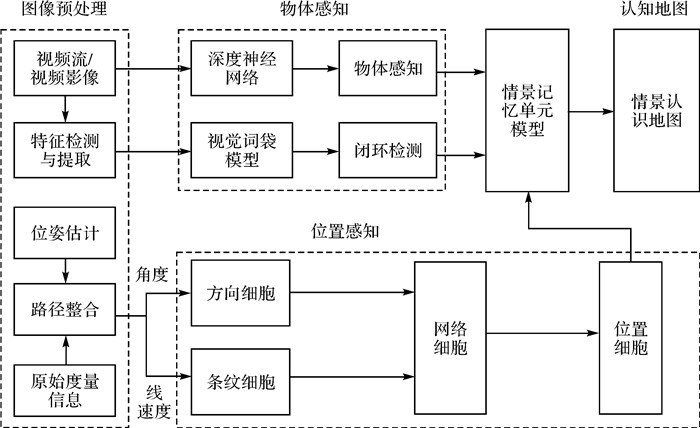

特征点法视觉SLAM技术是建立在图像特征信息处理基础上,基于同名像点之间的最小欧氏距离或者像平面重投影误差(reprojection error)最小化原理进行估算相邻图像间相机的运动、定位信息和构建局部地图的技术[7, 15],是视觉SLAM发展较早的一种方法。文献[16]首次实现了基于滤波算法的实时SLAM技术,文献[17]发展了基于非线性优化的多线程并行处理PTAM(parallel tracking and mapping)算法。文献[18]提出S-PTAM(stereo PTAM)算法,将姿态估计与地图构建等并行处理。文献[19]提出ORB-SLAM算法,并经过ORB-SLAM2[3]和ORB-SLAM3[20]算法的完善和提升,发展成了一套适用单目、双目和RGB-D相机,且可实时处理的特征点法视觉SLAM技术框架,在精度方面,ORB-SLAM2算法可以实现百米距离内优于1%的相对定位精度和0.21°的姿态测量精度[3]。滤波和非线性优化是早期两种不同后端处理方式的技术框架,前者计算效率高,后者计算精度高,目前二者逐渐朝着相向的方向发展[21-22]。随着S-PTAM、ORB-SLAM、ORB-SLAM2和ORB-SLAM3等特征点法典型模型的提出,特征点法视觉SLAM的技术框架基本确定,其中ORB-SLAM系列凭借支持多种传感器、优异的计算性能和精度、有效的回环检测算法和并行计算等特点,成为特征点法视觉SLAM的基础参考,图 1展示了特征点法视觉SLAM的技术框架[3, 19-20, 23]。

|

| 图 1 特征点法视觉SLAM技术框架 Fig. 1 The technical framework of feature-based visual SLAM |

特征点法视觉SLAM技术是多种方法中研究时间较久,较为成熟的方案之一,美国“机遇号”“勇气号”和“好奇号”火星探测车,以及中国的“月兔号”月球车采用光束法平差(bundle adjustment,BA)方法进行着陆过程中的位置和姿态解算,支撑了探测车安全避障与路径规划所需的基础地图制作[33],而BA方法也是视觉SLAM位姿估计和图优化的重要方法之一。文献[34—35]实现了基于无人机视觉SLAM技术的DOM(数字正射影像)、DSM(数字表面模型)和DEM(数字高程模型)等测绘产品的实时制作。文献[36]采用单目SLAM技术实时构造不同高度的网格地图,为无人机平台动态选择合适的着陆区域,为交互式路径规划技术提供了支撑。由于受稀疏的纹理环境、复杂的光照和高动态场景影响比较严重,且在特征提取、描述和匹配等方面需要较大的计算资源,特征点法视觉SLAM技术的产业应用受到了一定限制,尤其是构建稠密地图受到影响更甚。

1.2 直接法视觉SLAM为了降低图像特征处理时间和计算资源的消耗,直接法视觉SLAM技术应运而生。直接法视觉定位技术假设两帧图像中的匹配像素的灰度值不变,构建光度误差函数,基于图像间光度误差(photometric error)最小化原理进行位姿变化计算。过程中仅需特征提取,无须特征描述与匹配[37]。相比于特征点法只能构建稀疏点云地图(构建半稠密或稠密需要采取其他技巧),直接法可以利用图像上全部像素信息,具备构建半稠密和稠密地图的能力,在纹理稀疏场景具有一定优势。

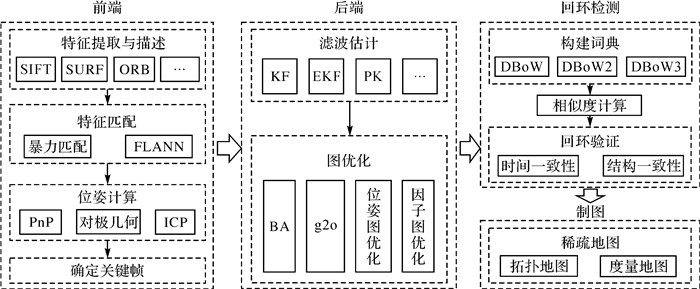

直接法视觉SLAM是建立在图像亮度一致性假设和光流法基础上发展起来的。文献[15, 24]提出了完整的直接法SLAM框架DTAM(dense tracking and mapping),通过稠密、亚像素和精确多视立体重建等进行轨迹跟踪和三维模型重建。LSD-SLAM(large scale direct SLAM)的问世,成为第一个大尺度直接法单目视觉SLAM方法[25, 38],利用图像中像素梯度显著的区域进行位姿跟踪和深度重构,可以恢复半稠密的三维场景地图,文献[38]将其拓展到双目与大视角相机,实现了手机端的AR应用等其他功能,成为了直接法中最具代表性的技术框架[39]。文献[26]在2013年基于图像中全部像素光度误差和深度误差最小化原理提出了DVO-SLAM(dense visual odometry SLAM)算法框架,定位精度可达0.19 m,成为了基于RGB-D相机进行视觉SLAM技术的基础。作为视觉SLAM的前端技术,DSO(direct sparse odometry)视觉里程计出现和发展,凭借良好的运算速度与跟踪精度,将直接法视觉SLAM技术推向了一个新的高度[40-41]。文献[40] 提出了半直接法(semi-direct monocular visual odometry,SVO),利用直接法估计相机运动及特征点位置,又对关键帧影像的路标点进行了优化,该方法可以获得更精确、稳健和高效的结果,也被广泛研究。图 2展示了直接法视觉SLAM算法的技术框架,不同于特征点法视觉SLAM技术的是前端和制图两部分内容,其中前端主要基于图像灰度信息进行位姿估计和跟踪,建图部分半稠密和稠密地图是直接法的特色和亮点。

|

| 图 2 直接法视觉SLAM简要技术框架 Fig. 2 The brief technical framework of direct-based visual SLAM |

直接法视觉SLAM无须计算特征描述子,结合像素梯度计算结果即可完成跟踪和半稠密或稠密地图的构建,对计算资源要求低,消耗时间短,成为近年来应用研究的重点。意大利Leonardo军工公司在无人机军用编队项目中将LSD-SLAM(large-scale direct monocular SLAM)算法与无人机集成,开展障碍物识别工作[42]。地平线公司采用StereoDSO算法进行稠密地图重建、3D环境感知与语义重建,研制了系列适用图像处理的自动驾驶应用芯片,推动了视觉SLAM技术的智能化发展[43]。直接法SLAM由于存在图像灰度一致性假设、较小运动场景适用和图像块相关性计算等问题,在一定程度上限制了直接法SLAM的发展,为此未来需要进一步地攻克上述问题。

1.3 视觉指纹库SLAM人类可以通过回忆判断曾经到达过的位置,而视觉指纹库SLAM技术赋予了机器人构建地图和场景识别的能力。该技术根据预先构建的物理世界视觉指纹库[44]与当前位置的视觉词袋模型进行匹配,利用场景外观概率识别算法,确定机器人位置,并基于环境信息更新指纹库。

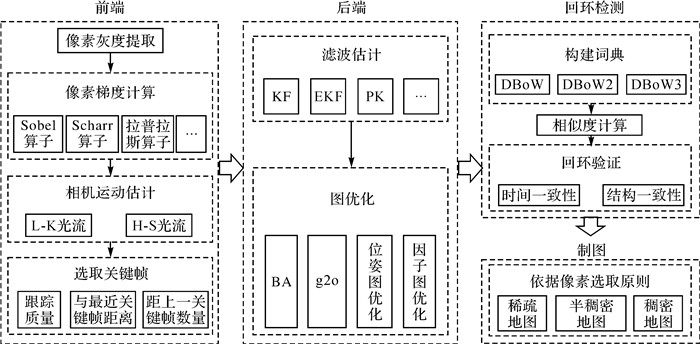

早期基于整体或者局部特征相似度的视觉指纹库SLAM方法虽然得到了大量的研究和尝试,但是在应用方面仍然存在较大的局限性。文献[45]提出了视觉词袋模型(bag of words,BoW), 推动了基于BoW和回环检测结合的视觉指纹库SLAM技术得到快速发展。文献[27, 46]提出了FAB-MAP算法,其2.0版本的模型在1000 km的路线测试中被证明是一种成功的场景识别算法,在100%的精度下,召回率为6.5%,足以支持一个好的尺度SLAM系统,成为了基于视觉指纹库SLAM方法的城市或者更大尺度场景定位和建模的重要基础。图 3展示了简要的技术框架:首先对物理世界进行建模,构建物理世界的视觉指纹库,也即先验地图;其次将感知的图像信息转换成视觉单词;然后计算视觉单词与视觉指纹库的相似度,进而实现位置确定,并将物理世界的信息更新至视觉指纹库中[27]。具有类似原理的视觉场景识别(visual place recognition, VPR)技术也是视觉指纹库SLAM感知技术的一种重要形式,得到了广泛的研究和应用[47-48]。

|

| 图 3 视觉指纹库SLAM技术框架 Fig. 3 The technical framework of fingerprint-based visual SLAM |

视觉指纹库SLAM技术属于一种长时间序列、大空间尺度的视觉SLAM感知方法。文献[49]提出了SeqSLAM(sequence SLAM)算法,即使存在因季节、天气、昼夜变化等因素引起的极端环境变化导致基于特征的算法失败时,该方法仍然能够以100%的准确率和60%的召回率实现轨迹匹配,被认为是最成功的环路闭合检测算法。为了降低计算资源消耗和大型地图的处理,文献[50]提出了Fast-SeqSLAM算法,进一步降低了计算复杂度,提高了计算效率。文献[51]采用混合紧凑型神经网络模型进行视觉位置识别,取得了比SeqSLAM更加优异的结果。文献[52]基于改进的VPR提出更具潜力的适用于自动驾驶需求的大范围场景识别技术。当前视觉指纹库SLAM技术已经解决了物理视觉的数据表达、关联和搜索等问题,被广泛应用于大范围场景的定位和识别,通过与无人机、无人车、无人潜航器等智能化装备结合应用[48],成为推动人工智能技术发展的重要因素。

1.4 语义视觉SLAM语义视觉SLAM是一种汇聚语义和SLAM技术的具有尺度、拓扑和语义地图构建功能为一体的视觉环境感知技术,可以基于典型的SLAM技术结合物体类别、目标检测、语义分割等语义信息,实现物理环境几何、拓扑和语义信息的获取和地图构建,并用于导航定位等功能,是当前视觉SLAM领域的一个热点研究方向[10, 53]。

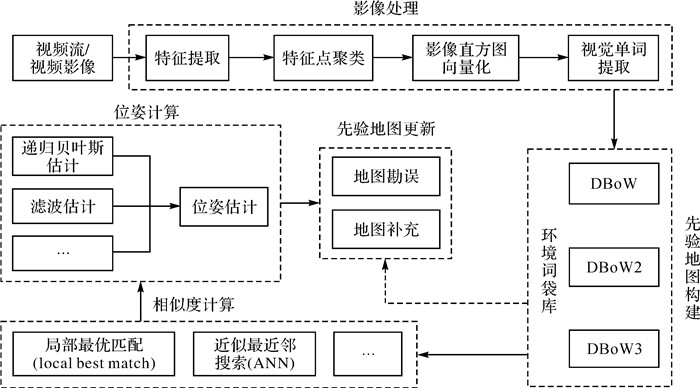

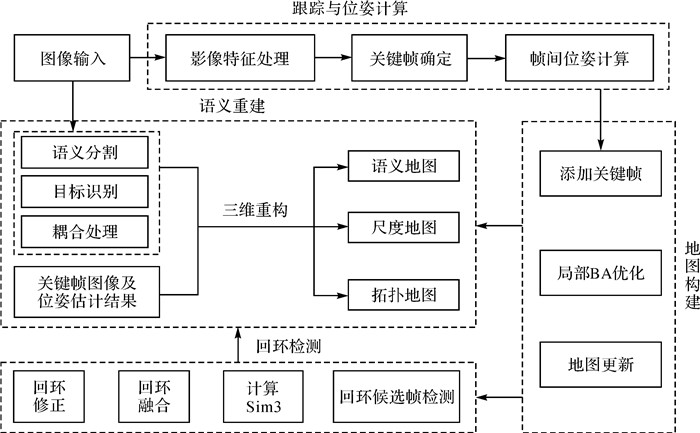

20世纪中叶美国心理学家E·C·托尔曼提出了认知地图(cognitive map)的概念,拉开了语义地图相关技术研究的序幕,到了70年代语义地图和机器人技术紧密结合起来[54]。然而,语义视觉SLAM则是近年来随着典型SLAM技术发展而来的新技术[55]。按照算法集成模式划分,可以分为两类处理方式,一类是独立的SLAM与目标识别算法结合方式。文献[54]提出空间和语义结合,到文献[29]提出的SLAM+ +算法,是比较早期整合语义信息进行定位和制图的算法,其中YOLO(you only look once)系列目标识别算法被广泛用于语义视觉SLAM技术研究[56-57]。另一类是将语义与SLAM耦合处理的方式。文献[58]首次将几何、语义和IMU(inertial measurement unit)信息统一到单个优化框架中,用语义信息辅助提高定位精度,取得比单目ORB-SLAM更加优异的结果。按照模型中语义作用划分,可以分为服务于特征选择算法,获得对光照和视角变化稳健性更好的特征点[59];服务于减弱图像中动态物体影响,提高系统的稳健性[60];服务于单目视觉SLAM尺度恢复[61];服务于长时间序列定位[62]和定位精度提高[57]等方面。近年来随着深度学习算法的发展,如文献[30]提出的CNN-SLAM(convolutional neural network SLAM)算法,深度估计误差低于真实值10%,位姿估计精度优于LSD-SLAM方法,推动了深度学习支持的语义视觉SLAM技术成为了研究热点[63]。图 4展示了语义视觉SLAM算法的技术框架,包括跟踪与位姿计算、地图构建、回环检测和语义重建等部分[64]。其中前3部分是传统SLAM的技术框架,语义重建部分通常结合本文归纳的两种处理方式实现。

|

| 图 4 语义视觉SLAM技术框架 Fig. 4 The technical framework of semantic visual SLAM |

语义视觉SLAM环境感知技术目前处于快速发展的阶段,逐渐成为了推动智能装备从被动规划式环境感知技术向主动交互式环境感知技术发展的重要力量。文献[60]利用语义视觉SLAM技术在高动态环境中克服了传统视觉SLAM技术静态环境假设的应用前提,提高了车辆导航时与动态环境的交互性。文献[65]开展了道路环境下的快速3D语义地图构建技术研究,能够识别道路、人行道、墙体、地形、植被、交通标识和汽车等物体。文献[66]利用语义和粒子滤波技术自动构建了城市场景车道级高精度地图,伴随该方向的深入研究,相关成果可以为自动驾驶车辆提供地图支撑。文献[67]详细地描述了语义视觉SLAM环境感知技术在动态环境理解与制图、静态场景理解、与人类和环境的交互,以及机器人改善工作能力等方面的作用,进一步为语义视觉SLAM环境感知技术的应用拓展指明了方向。未来,随着语义视觉SLAM技术在目标检测、数据关联准确性方面的提高,以及复杂算法与计算资源之间矛盾的优化,将会进一步促进该技术在语义地图、场景解译、高精度导航定位等领域的应用。

1.5 类脑视觉SLAM人类和动物在陌生环境的导航能力,吸引了对类脑导航与空间认知结合的仿生导航技术的不断探索。随着视觉SLAM技术的发展,采用脑科学、人工智能有机结合的类脑视觉SLAM技术开始崭露头角,成为近年来的研究热点。类脑视觉SLAM指智能设备依靠视觉传感器,依赖大脑导航机制,具有自主学习进化、环境感知、认知地图构建于一体的一种新型视觉SLAM技术方法[68]。

自1971年O̓Keefe和Dostrovsky发现啮齿动物具有方向细胞和导航细胞,到2014年O̓Keefe等人发现“构成大脑定位系统的细胞”获得诺贝尔医学奖。研究发现哺乳动物海马体中的“位置”细胞(place cell)、“网格”细胞(grid cell)、“方向”细胞(head direction cell)、“边界”细胞(boundary vector cell)和“条纹”细胞(band cell)等是哺乳动物感知环境、构建环境认知地图和导航的主要支撑[69]。相关研究人员基于哺乳动物海马体对环境的认知和导航机理,提出了仿生导航概念,类脑视觉SLAM技术逐渐开展起来[70]。文献[31, 71—72]利用相关支撑条件,提出RatSLAM算法模型,并不断发展完善,实现了2D郊区地图绘制和超过2周时间的办公环境导航功能,开创了类脑SLAM算法的先河,为众多改进型算法模型的研究奠定了基础。文献[70]基于3D网格细胞和方向细胞提出了适用3D环境下的NeuroSLAM算法,在大型、非结构化、不可预测的环境中推动了脑感知SLAM的进一步发展。另外,基于仿生眼技术的视觉SLAM解决方案,能够在纹理稀疏环境主动搜索丰富的纹理环境,提升视觉SLAM的稳健性,也为类脑视觉SLAM提供一种新的解决方案[73]。图 5展示了脑感知SLAM的简要技术框架,主要由4部分内容组成。首先,图像预处理部分基于图像信息进行图像特征或视觉单词提取、位姿估计和路径整合等;其次,物体感知部分进行物体感知和闭环检测,服务于过往场景识别或新场景补充;然后,位置感知部分利用相关定位细胞进行位姿计算;最后,利用物体感知和位置感知的结果构建具备环境拓扑和局部度量的环境地图,也即情景认知地图[32, 74]。

作为新兴的仿生导航技术,类脑视觉SLAM环境感知技术仍然处于发展的初级阶段,众多学者围绕定位、制图等方面进行研究,但是在赋予机器人自主交互能力和算法应用等方面仍然面临着较大的挑战。随着类脑视觉SLAM技术与传感、认知、学习和控制等技术的深度融合,将会赋予下一代机器人智能感知、自我学习与认知、与人类和环境交互的能力[75],推动机器人环境感知技术更加拟人化[76]。

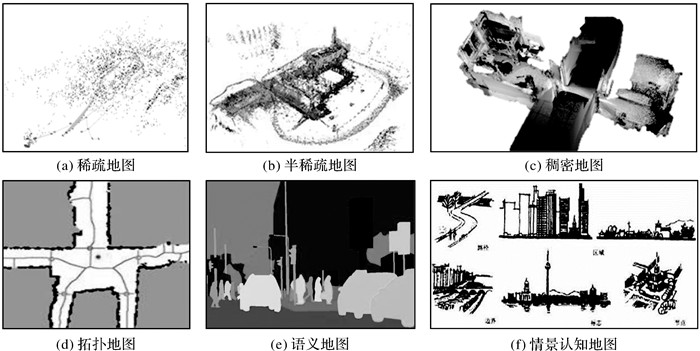

制图是视觉SLAM的重要功能之一,图 6展示了视觉SLAM方法可以形成的6种地图形式。其中图 6(a)、(b)、(c)是尺度地图的3种表示形式,也即根据地图的稀疏程度精确地表示了地图中物体的位置关系;拓扑地图不具备真实的物理尺寸,只表示不同地点的连通关系和距离,常用于路径规划和定位约束;语义地图是加标签的尺度地图,常用于人机交互,可提供目标物体类型、空间形态及位置等信息;情景认知地图(cognitive maps of city)是人脑中再现的环境意象,由路径、标志、节点、区域、边界5个基本要素组成。上述地图类型覆盖了尺度、拓扑、语义等环境信息,是测绘全息要素的重要组成部分。

|

| 图 6 视觉SLAM地图表达形式 Fig. 6 The map representation of visual SLAM |

综上,特征点法视觉SLAM发展较早,相对成熟和完善,但是受光照、纹理等环境特征影响较大;直接法视觉SLAM回避了特征点法中的特征处理环节,在稠密地图重建方面更具优势,但是受到图像灰度一致性假设的限制;视觉指纹库SLAM借助词袋模型优势,更加适应大场景的应用需求,但需对物理世界预先建模,且易受到季节、昼夜、天气等因素影响;语义视觉SLAM技术,立足上述算法,引入了基于深度学习算法的环境语义提取,提升了对环境的理解和交互能力;类脑视觉SLAM采用仿生机理建立的一种新型SLAM方法,在拟人化方面具有较大的发展潜力。然而,面向智能化时代特点,单一的视觉SLAM方法难以满足复杂的应用需求,而建立在新一代信息技术基础之上的多种视觉SLAM方法融合更具发展优势。

2 智能化时代视觉SLAM环境感知发展趋势视觉SLAM技术对比激光SLAM技术具有成本低、语义信息丰富、可实时传输,以及符合人类的感知习惯等特点[77],成为近年来的研究热点,通过与物联网、5G、云计算、深度学习等技术的结合,将会进一步促进当前的技术进步,在智能化环境交互感知、众包化数据汇聚、网络化实时处理、大数据知识服务和多样化应用等方面快速发展,呈现出智能化时代视觉SLAM环境感知技术的新特点和新面貌。

2.1 智能化环境感知交互随着视觉SLAM技术与智能芯片、深度学习算法的融合不断加深,利用智能芯片和算法赋能视觉SLAM技术,提升在环境感知、交互响应等方面的智能化水平成为视觉SLAM技术的重要发展方向。在环境感知方面,基于视觉SLAM几何环境信息获取手段,深入研究基于深度学习算法支持的环境语义信息同步感知技术,实现时空属性与物体属性同步认知的功能;在交互响应方面,利用脑感知视觉SLAM、语义视觉SLAM等主动性地判别场景物体,自主跟踪有效目标,对环境观测信息进行有效的综合和取舍,并做出相应的执行动作,推动现在的“眼观六路”感知技术,向未来的“所见即所得”感知与交互融合方向发展,即在观测信息的支持下,对环境情况做出即时的理解和响应。

2.2 即时众包化信息处理视频作为一种流媒体数据[78],为视觉SLAM技术在即时、众包信息感知处理方面发展奠定了基础。在即时信息处理方面,研究视觉SLAM与互联网、物联网、移动通信网等手段深度耦合方式,攻克基于即时通讯手段支撑的云-边-端协同的位置、制图、几何、拓扑、语义等实时处理技术,打造“感知-信息”联动的在线应用模式,提升视觉SLAM技术的即时服务能力;在众包感知处理方面,利用视觉SLAM的即时处理能力,攻克基于网联汽车、无人车、无人机、机器人、手机等设备云-机交互反馈的众包信息处理技术,满足大众化智能装备在线导航、定位、避障、路径规划等需求,同步构建基于云端的测绘产品[79],打破传统依赖专业团队获取与处理数据的局面,推动众包化环境物联感知技术发展,进一步地解放生产力,提高工作效率。

2.3 多样化感知数据服务视频蕴含着纹理、颜色、几何、位置、拓扑、语义、POI(point of interest)等众多信息,是测绘地理信息产品的重要构成。通过培育视觉SLAM新型数据服务技术,能够为测绘行业发展提供新动能。通过研究视觉SLAM、GNSS、IMU、超声波雷达等多模态集成算法,有助于推动攻克自动驾驶领域及未知环境区域的导航定位、路径规划、障碍物规避等难点;探索基于视觉SLAM的DOM、DSM、DEM和实景模型在线处理技术,构建新型遥感制图和实景三维的服务模式,为应急测绘等对时效性要求强的应用场景提供支撑;攻克语义视觉SLAM技术支撑的众包POI获取、在线地表变化研判等技术,支撑导航地图更新和自然资源监测等需求。未来可以进一步利用大数据技术,深入挖掘视觉SLAM环境感知成果中蕴藏的丰富地理信息,有效发挥视频数据的潜在价值。

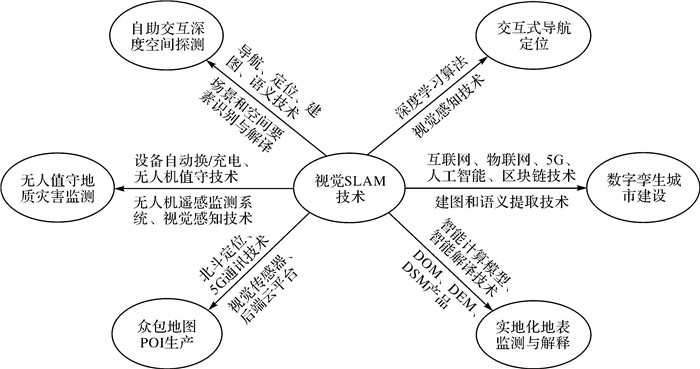

3 视觉SLAM智能化测绘应用模式展望在新一代信息技术快速发展的形式下,视觉SLAM环境感知技术将会不断取得突破和进展,推动其与传统测绘技术的深度融合,有助于打造基于视觉SLAM环境感知技术的导航定位、地图制图、实景三维、遥感解译等智能化测绘应用模式,促进传统测绘服务方式向智慧化、精准化方向发展。图 7基于视觉SLAM技术在位置、制图和语义等方面的优势和发展延伸,提出了6种测绘应用方式。

|

| 图 7 智能化测绘应用展望 Fig. 7 Prospect of intelligent surveying and mapping application scenarios |

3.1 交互式导航定位

智能装备通过集成视觉、激光、超声波等多种传感器,以及深度学习芯片等,具备了较强的环境感知能力和一定的认知能力,如大疆无人机采用视觉和超声波组合进行避障等。当前视觉SLAM技术多以环境感知的方式使用,随着语义SLAM、脑感知SLAM等技术的不断发展,基于深度学习算法的视觉感知与SLAM技术不断融合,推动智能装备朝着感知与自主决策方向发展,类似火星车自主判断与选择降落点、自动驾驶车辆自动感知周围静态和动态的物体和属性做出行动决策、智能机器人根据环境信息自主决策下一步的行动计划等,基于视觉SLAM和深度学习算法的交互式导航定位技术将会得到进一步的发展。

3.2 数字孪生城市建设数字孪生城市建设是未来城市发展方向之一,三维地理空间数据是数字孪生的基础。基于视觉SLAM的制图和语义提取技术,可以采用KinectFusion[80]、Openrealm[12]等算法对室内外、地上下空间及附属设施构建BIM/CIM(building/city information modeling)模型,并基于CNN-SLAM赋之真实的语义属性,实现现实世界与虚拟世界的精准映射。融合互联网、物联网、5G、人工智能、区块链等数字技术,构建城市智能运行的数字底座,催生城市治理思维和方式的转变与范式重塑。

3.3 实时化地表监测与解译视频流从无人机、视频卫星等平台传输至地面或者云服务平台,利用TerrainFusion[35]等视觉SLAM技术获取实时的DOM、DEM、DSM等测绘产品。利用云-边-端等跨终端协同处理技术,结合深度学习、迁移学习、强化学习等多种智能计算模型和专家经验,开展地表空间遥感数据要素智能提取、“数据-模型-知识”驱动的地表要素智能解译、自然资源要素画像和图谱构建技术,实现自然资源要素、场景、知识的快速智能提取和表达[81],推动传统数据服务向知识服务的转变,服务于国土普查与动态监测等业务[82]。

3.4 众包地图POI生产视觉感知技术是地图POI数据获取的主要手段之一,基于深度学习算法支持的语义视觉SLAM、词袋模型等技术,可与高德等厂商的STR(自然场景文字识别)技术结合,实现实时获取地图POI数据。通过智能手机、智能网联汽车等在使用过程中的视觉传感器采集到的图像、位置等数据,通过5G等通讯网络传输到后端云平台,可以实时的转换为POI数据,推动地图POI数据感知的众包化,革新地图POI数据获取的技术方法,打破专业人员人机交互获取的模式,提升地图POI数据获取的智能化、实时化程度。

3.5 无人值守地质灾害监测艰险山区崩滑地质灾害突发性强、危害性大,基于GNSS变形监测技术对地质灾害监测的实景展示稍显不足。基于Openrealm等视觉SLAM与设备自动换/充电、无人值守[83]等技术的发展与融合,无人机遥感监测系统可以根据GNSS等预警预报信息联动自主观测灾害体,并实时回传数据构建灾害体实景三维模型,且可以利用视觉感知技术规避三维空间的障碍物,保障飞行安全,实现地质灾害的无人机值守监测与孪生展示。

3.6 深度空间自主交互探测面向深空、深海、深地等深度空间的探索已成为人类科技竞争的焦点之一,针对陌生甚至未知的深度空间,类似祝融号火星车、玉兔号月球车[33]等智能装备对其环境感知、深度交互和主动决策能力的需求愈发凸显。利用视觉SLAM的导航、定位、制图和语义等技术可以实现对深度空间地形、地貌获取,以及场景和空间要素的识别与解译,并可解决探索过程中的障碍物检测与规避等问题,提高智能装备在深度空间探测过程中的自主性。

4 结语随着智能化、云计算、大数据时代的来临,测绘行业面临着重要的转型升级的发展机遇,对测绘装备、数据感知和数据应用模式的发展提出了更高的要求。视觉SLAM环境感知技术经过30多年的快速发展,在定位技术方面形成了多种稳健、可靠的技术框架、算法模型和测绘应用工艺,在大场景制图、语义和类脑技术支持的交互式主动服务等方面取得了较大突破和进展。随着视觉SLAM环境感知技术与人工智能、深度学习、大数据、云-边-端计算等技术的深度交叉发展,将会推动视觉SLAM环境感知技术朝着智能化、众包化、即时化等方向快速发展,进一步推动测绘生产方式和生产力的变革与提升。

位置、几何、拓扑、语义等信息是赋能未来测绘业务智能化发展的重要基础,在当前的新发展格局下,单一的视觉SLAM方法存在巨大应用挑战,需要与新一代信息技术融合发展,研究与完善复杂场景多方法融合的视觉SLAM环境感知技术理论、算法框架,突破实时主动环境感知、场景深度交互自主导航与路径规划、全息要素地图构建与要素识别等关键技术,打造基于行业与大众结合的开放、创新测绘技术服务模式,满足新形势下的测绘应用需求。

| [1] |

杨元喜, 李晓燕. 微PNT与综合PNT[J]. 测绘学报, 2017, 46(10): 1249-1254. YANG Yuanxi, LI Xiaoyan. Micro-PNT and comprehensive PNT[J]. Acta Geodaetica et Cartographica Sinica, 2017, 46(10): 1249-1254. DOI:10.11947/j.AGCS.2017.20170249 |

| [2] |

刘经南, 郭文飞, 郭迟, 等. 智能时代泛在测绘的再思考[J]. 测绘学报, 2020, 49(4): 403-414. LIU Jingnan, GUO Wenfei, GUO Chi, et al. Rethinking ubiquitous mapping in the intelligent age[J]. Acta Geodaetica et Cartographica Sinica, 2020, 49(4): 403-414. DOI:10.11947/j.AGCS.2020.20190539 |

| [3] |

MUR-ARTAL R, TARDÓS J D. ORB-SLAM2:an open-source SLAM system for monocular, stereo, and RGB-D cameras[J]. IEEE Transactions on Robotics, 2017, 33(5): 1255-1262. DOI:10.1109/TRO.2017.2705103 |

| [4] |

DI Kaichang, LIU Zhaoqin, WAN Wenhui, et al. Geospatial technologies for Chang'e-3 and Chang'e-4 lunar rover missions[J]. Geo-Spatial Information Science, 2020, 23(1): 87-97. DOI:10.1080/10095020.2020.1718002 |

| [5] |

李德仁. 论时空大数据的智能处理与服务[J]. 地球信息科学学报, 2019, 21(12): 1825-1831. LI Deren. The intelligent processing and service of spatiotemporal big data[J]. Journal of Geo-Information Science, 2019, 21(12): 1825-1831. |

| [6] |

WANG Sufang, WU Zheng, ZHANG Weicun. An overview of SLAM[C]//Proceedings of 2018 Chinese Intelligent Systems Conference. Singapore: Springer, 2018: 673-681.

|

| [7] |

高翔, 张涛, 刘毅. 视觉SLAM十四讲: 从理论到实践[M]. 北京: 电子工业出版社, 2017. GAO Xiang, ZHANG Tao, LIU Yi. Fourteen lectures on visual SLAM: from theory to practice[M]. Beijing: Publishing House of Electronics Industry, 2017. |

| [8] |

DURRANT-WHYTE H, BAILEY T. Simultaneous localization and mapping: part Ⅰ[J]. IEEE Robotics & Automation Magazine, 2006, 13(2): 99-110. |

| [9] |

BAILEY T, DURRANT-WHYTE H. Simultaneous localization and mapping (SLAM): part Ⅱ[J]. IEEE Robotics & Automation Magazine, 2006, 13(3): 108-117. |

| [10] |

CADENA C, CARLONE L, CARRILLO H, et al. Past, present, and future of simultaneous localization and mapping: toward the robust-perception age[J]. IEEE Transactions on Robotics, 2016, 32(6): 1309-1332. DOI:10.1109/TRO.2016.2624754 |

| [11] |

龚健雅. 人工智能时代测绘遥感技术的发展机遇与挑战[J]. 武汉大学学报(信息科学版), 2018, 43(12): 1788-1796. GONG Jianya. Chances and challenges for development of surveying and remote sensing in the age of artificial intelligence[J]. Geomatics and Information Science of Wuhan University, 2018, 43(12): 1788-1796. |

| [12] |

KERN A, BOBBE M, KHEDAR Y, et al. OpenREALM: real-time mapping for unmanned aerial vehicles[C]//Proceedings of 2020 International Conference on Unmanned Aircraft Systems (ICUAS). Athens: IEEE, 2020: 902-911.

|

| [13] |

LIU Fei, ZHANG Jixian, WANG Jian, et al. An UWB/vision fusion scheme for determining pedestrians'indoor location[J]. Sensors (Basel, Switzerland), 2020, 20(4): 1139. DOI:10.3390/s20041139 |

| [14] |

陈军, 刘万增, 武昊, 等. 智能化测绘的基本问题与发展方向[J]. 测绘学报, 2021, 50(8): 995-1005. CHEN Jun, LIU Wanzeng, WU Hao, et al. Smart surveying and mapping: fundamental issues and research agenda[J]. Acta Geodaetica et Cartographica Sinica, 2021, 50(8): 995-1005. DOI:10.11947/j.AGCS.2021.20210235 |

| [15] |

李云天, 穆荣军, 单永志. 无人系统视觉SLAM技术发展现状简析[J]. 控制与决策, 2021, 36(3): 513-522. LI Yuntian, MU Rongjun, SHAN Yongzhi. A survey of visual SLAM in unmanned systems[J]. Control and Decision, 2021, 36(3): 513-522. DOI:10.13195/j.kzyjc.2019.1149 |

| [16] |

DAVISON A J, REID I D, MOLTON N D, et al. MonoSLAM: real-time single camera SLAM[J]. IEEE Transactionson Pattern Analysis and Machine Intelligence, 2007, 29(6): 1052-1067. DOI:10.1109/TPAMI.2007.1049 |

| [17] |

KLEIN G, MURRAY D. Parallel tracking and mapping for small AR workspaces[C]//Proceedings of the 6 th IEEE and ACM International Symposium on Mixed and Augmented Reality. Nara: IEEE, 2007.

|

| [18] |

PIRE T, FISCHER T, CIVERA J, et al. Stereo parallel tracking and mapping for robot localization[C]//Proceedings of 2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Hamburg: IEEE, 2015.

|

| [19] |

MUR-ARTAL R, MONTIEL J M M, TARDOS J D. ORB-SLAM: a versatile and accurate monocular SLAM system[J]. IEEE Transactions on Robotics, 2015, 31(5): 1147-1163. DOI:10.1109/TRO.2015.2463671 |

| [20] |

CAMPOS C, ELVIRA R, RODRÍGUEZ J J G, et al. ORB-SLAM3:an accurate open-source library for visual, visual-inertial, and multimap SLAM[J]. IEEE Transactionson Robotics, 2021, 37(6): 1874-1890. DOI:10.1109/TRO.2021.3075644 |

| [21] |

LEUTENEGGER S, LYNEN S, BOSSE M, et al. Keyframe-based visual-inertial odometry using nonlinear optimization[J]. The International Journal of Robotics Research, 2015, 34(3): 314-334. DOI:10.1177/0278364914554813 |

| [22] |

BLOESCH M, OMARI S, HUTTER M, et al. Robust visual inertial odometry using a direct EKF-based approach[C]//Proceedings of 2015 IEEE/RSJ International Conference on Intelligent Robots and Systems. Hamburg: IEEE, 2015.

|

| [23] |

刘飞. 多传感器融合的高精度无缝定位模型与方法研究[D]. 徐州: 中国矿业大学, 2020. LIU Fei. Research on high-precision seamless positioning model and method based on multi-sensor fusion[D]. Xuzhou: China University of Mining and Technology, 2020. |

| [24] |

NEWCOMBE R A, LOVEGROVE S J, DAVISON A J. DTAM: dense tracking and mapping in real-time[C]//Proceedings of 2012 International Conference on Computer Vision. Barcelona: IEEE, 2012: 2320-2327.

|

| [25] |

ENGEL J, SCHÖPS T, CREMERS D. LSD-SLAM: large-scale direct monocular SLAM[C]//Proceedings of 2014 European Conference on Computer Vision. Cham: Springer International Publishing, 2014: 834-849.

|

| [26] |

KERL C, STURM J, CREMERS D. Dense visual SLAM for RGB-D cameras[C]//Proceedings of 2013 IEEE/RSJ International Conference on Intelligent Robots and Systems. Tokyo: IEEE, 2014: 2100-2106.

|

| [27] |

CUMMINS M, NEWMAN P. FAB-MAP: probabilistic localization and mapping in the space of appearance[J]. The International Journal of Robotics Research, 2008, 27(6): 647-665. DOI:10.1177/0278364908090961 |

| [28] |

MILFORD M J, WYETH G F. SeqSLAM: visual route-based navigation for sunny summer days and stormy winter nights[C]//Proceedings of 2012 IEEE International Conference on Robotics and Automation. Saint Paul: IEEE, 2012: 1643-1649.

|

| [29] |

SALAS-MORENO R F, NEWCOMBE R A, STRASDAT H, et al. SLAM: simultaneous localisation and mapping at the level of objects[C]//Proceedings of 2013 IEEE Conference on Computer Vision and Pattern Recognition. Portland: IEEE, 2013: 1352-1359.

|

| [30] |

TATENO K, TOMBARI F, LAINA I, et al. CNN-SLAM: real-time dense monocular SLAM with learned depth prediction[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE, 2017.

|

| [31] |

MILFORD M J, WYETHG F, PRASSERD. RatSLAM: a hippocampal model for simultaneous localization and mapping[C]//Proceedings of 2004 IEEE International Conference on Robotics and Automation. New Orleans: IEEE, 2004.

|

| [32] |

YU Fangwen, SHANG Jianga, HU Youjian, et al. Neuro SLAM: a brain-inspired SLAM system for 3D environments[J]. Biological Cybernetics, 2019, 113(5): 515-545. |

| [33] |

邸凯昌, 万文辉, 赵红颖, 等. 视觉SLAM技术的进展与应用[J]. 测绘学报, 2018, 47(6): 770-779. DI Kaichang, WAN Wenhui, ZHAO Hongying, et al. Progress and applications of visual SLAM[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(6): 770-779. DOI:10.11947/j.AGCS.2018.20170652 |

| [34] |

BU Shuhui, ZHAO Yong, WAN Gang, et al. Map2 DFusion: Real-time incremental UAV image mosaicing based on monocular SLAM[C]//Proceedings of 2016 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Daejeon: IEEE, 2016: 4564-4571.

|

| [35] |

WANG Wei, ZHAO Yong, HAN Pengcheng, et al. TerrainFusion: real-time digital surface model reconstruction based on monocular SLAM[C]//Proceedings of 2019 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Macau: IEEE, 2020: 7895-7902.

|

| [36] |

YANG Tao, LI Peiqi, ZHANG Huiming, et al. Monocular vision SLAM-based UAV autonomous landing in emergencies and unknown environments[J]. Electronics, 2018, 7(5): 73. DOI:10.3390/electronics7050073 |

| [37] |

潘林豪, 田福庆, 应文健, 等. 基于直接法的视觉同时定位与地图构建技术综述[J]. 计算机应用研究, 2019, 36(4): 961-966. PAN Linhao, TIAN Fuqing, YING Wenjian, et al. Survey on direct-method visual simultaneous localization and mapping[J]. Application Research of Computers, 2019, 36(4): 961-966. DOI:10.19734/j.issn.1001-3695.2018.01.0123 |

| [38] |

ENGEL J, STÜCKLER J, CREMERS D. Large-scale direct SLAM with stereo cameras[C]//Proceedings of 2015 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Hamburg: IEEE, 2015: 1935-1942.

|

| [39] |

RAGOT N, KHEMMAR R, POKALA A, et al. Benchmark of visual SLAM algorithms: ORB-SLAM2 vs RTAB-map[C]//Proceedings of the 8 th International Conference on Emerging Security Technologies (EST). Colchester: IEEE, 2019: 1-6.

|

| [40] |

FORSTER C, PIZZOLI M, SCARAMUZZA D. SVO: fast semi-direct monocular visual odometry[C]//Proceedings of 2014 IEEE International Conference on Robotics and Automation (ICRA). Hong Kong: IEEE, 2014: 15-22.

|

| [41] |

WANG Rui, SCHWÖRER M, CREMERS D. Stereo DSO: large-scale direct sparse visual odometry with stereo cameras[C]//Proceedings of 2017 IEEE International Conference on Computer Vision (ICCV). Venice: IEEE, 2017: 3923-3931.

|

| [42] |

MESSINA L, MAZZARO S, FIORILLA A E, et al. Industrial implementation and performance evaluation of LSD-SLAM and map filtering algorithms for obstacles avoidance in a cooperative fleet of unmanned aerial vehicles[C]//Proceedings of the 3 rd International Conference on Intelligent Robotic and Control Engineering (IRCE). Oxford: IEEE, 2020: 117-122.

|

| [43] |

王敏, 付建宽, 宗岩, 等. 高级别自动驾驶汽车计算平台综述[J]. 时代汽车, 2021(22): 30-32. WANG Min, FU Jiankuan, ZONG Yan, et al. Overview of computing platforms for high-level self-driving vehicles[J]. Auto Time, 2021(22): 30-32. |

| [44] |

LIU Fei, ZHANG Jixian, WANG Jian, et al. The indoor localization of a mobile platform based on monocular vision and coding images[J]. ISPRS International Journal of Geo-Information, 2020, 9(2): 122. DOI:10.3390/ijgi9020122 |

| [45] |

SIVIC J, ZISSERMAN A. Video Google: a text retrieval approach to object matching in videos[C]//Proceedings of the 9 th Computer Vision, IEEE International Conference. Nice: IEEE, 2008: 1470-1477.

|

| [46] |

CUMMINS M, NEWMAN P. Appearance-only SLAM at large scale with FAB-MAP 2. 0[J]. The International Journal of Robotics Research, 2011, 30(9): 1100-1123. DOI:10.1177/0278364910385483 |

| [47] |

LOWRY S, SÜNDERHAUF N, NEWMAN P, et al. Visual place recognition: a survey[J]. IEEE Transactions on Robotics, 2016, 32(1): 1-19. DOI:10.1109/TRO.2015.2496823 |

| [48] |

GARG S, FISCHER T, MILFORD M. Where is your place, visual place recognition?[EB/OL]. [2022-04-20]. https://arxiv.org/abs/2103.06443.

|

| [49] |

MILFORD M J, WYETH G F. SeqSLAM: visual route-based navigation for sunny summer days and stormy winter nights[C]//Proceedings of 2012 IEEE International Conference on Robotics and Automation. Saint Paul: IEEE, 2012: 1643-1649.

|

| [50] |

SIAM S M, ZHANG Hong. Fast-SeqSLAM: a fast appearance based place recognition algorithm[C]//Proceedings of 2017 IEEE International Conference on Robotics and Automation (ICRA). Singapore: IEEE, 2017: 5702-5708.

|

| [51] |

CHANCÁN M, HERNANDEZ-NUNEZ L, NARENDRA A, et al. A hybrid compact neural architecture for visual place recognition[J]. IEEE Robotics and Automation Letters, 2020, 5(2): 993-1000. DOI:10.1109/LRA.2020.2967324 |

| [52] |

DOAN D, LATIF Y, CHIN T J, et al. Scalable place recognition under appearance change for autonomous driving[C]//Proceedings of 2019 IEEE/CVF International Conference on Computer Vision (ICCV). Seoul: IEEE, 2020: 9318-9327.

|

| [53] |

KOSTAVELIS I, GASTERATOS A. Semantic mapping for mobile robotics tasks: a survey[J]. Robotics and Autonomous Systems, 2015, 66: 86-103. DOI:10.1016/j.robot.2014.12.006 |

| [54] |

GALINDO C, SAFFIOTTI A, CORADESCHI S, et al. Multi-hierarchical semantic maps for mobile robotics[C]//Proceedings of 2005 IEEE/RSJ International Conference on Intelligent Robots and Systems. Edmonton: IEEE, 2005: 2278-2283.

|

| [55] |

GANTI P. SIVO: semantically informed visual odometry and mapping[D]. Waterloo: University of Waterloo, 2018.

|

| [56] |

ZHONG Fangwei, WANG Sheng, ZHANG Ziqi, et al. Detect-SLAM: making object detection and SLAM mutually beneficial[C]//Proceedings of 2018 IEEE Winter Conference on Applications of Computer Vision (WACV). Lake Tahoe: IEEE, 2018: 1001-1010.

|

| [57] |

YANG Shichao, SCHERER S. CubeSLAM: monocular 3 D object detection and SLAM without prior models[EB/OL]. [2022-03-15]. https://arxiv.org/abs/1806.00557.

|

| [58] |

BOWMAN S L, ATANASOV N, DANIILIDIS K, et al. Probabilistic data association for semantic SLAM[C]//Proceedings of 2017 IEEE International Conference on Robotics and Automation (ICRA). Singapore. IEEE: 2017: 1722-1729.

|

| [59] |

LIANG H J, SANKET N J, FERMÜLLER C, et al. SalientDSO: bringing attention to direct sparse odometry[J]. IEEE Transactions on Automation Science and Engineering, 2019, 16(4): 1619-1626. DOI:10.1109/TASE.2019.2900980 |

| [60] |

BRASCH N, BOZIC A, LALLEMAND J, et al. Semantic monocular SLAM for highly dynamic environments[C]//Proceedings of 2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Madrid: IEEE, 2019: 393-400.

|

| [61] |

FROST D, PRISACARIU V, MURRAY D. Recovering stable scale in monocular SLAM using object-supplemented bundle adjustment[J]. IEEE Transactions on Robotics, 2018, 34(3): 736-747. DOI:10.1109/TRO.2018.2820722 |

| [62] |

STENBORG E, TOFT C, HAMMARSTRAND L. Long-term visual localization using semantically segmented images[C]//Proceedings of 2018 IEEE International Conference on Robotics and Automation (ICRA). Brisbane: IEEE, 2018: 6484-6490.

|

| [63] |

邓晨, 李宏伟, 张斌, 等. 基于深度学习的语义SLAM关键帧图像处理[J]. 测绘学报, 2021, 50(11): 1605-1616. DENG Chen, LI Hongwei, ZHANG Bin, et al. Research on key frame image processing of semantic SLAM based on deep learning[J]. Acta Geodaetica et Cartographica Sinica, 2021, 50(11): 1605-1616. DOI:10.11947/j.AGCS.2021.20210251 |

| [64] |

李琳辉, 张溪桐, 连静, 等. 结合道路结构化特征的语义SLAM算法[J]. 哈尔滨工业大学学报, 2021, 53(2): 175-183. LI Linhui, ZHANG Xitong, LIAN Jing, et al. Semantic SLAM algorithm combined with road structured features[J]. Journal of Harbin Institute of Technology, 2021, 53(2): 175-183. |

| [65] |

LI Xuanpeng, WANG Dong, AO Huanxuan, et al. Fast 3 D semantic mapping in road scenes[J]. Applied Sciences, 2019, 9(4): 631. DOI:10.3390/app9040631 |

| [66] |

ZHOU Yiyang, TAKEDA Y, TOMIZUKA M, et al. Automatic construction of lane-level HD maps for urban scenes[C]//Proceedings of 2021 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Prague: IEEE, 2021: 6649-6656.

|

| [67] |

GARG S, SÜNDERHAUF N, DAYOUB F, et al. Semantics for robotic mapping, perception and interaction: a survey[J]. Foundations and Trends® in Robotics, 2020, 8(1-2): 1-224. |

| [68] |

晁丽君, 熊智, 杨闯, 等. 无人飞行器三维类脑SLAM自主导航方法[J]. 飞控与探测, 2020, 3(5): 35-43. CHAO Lijun, XIONG Zhi, YANG Chuang, et al. Autonomous navigation method of three-dimension brain-like SLAM for the UAV[J]. Flight Control & Detection, 2020, 3(5): 35-43. |

| [69] |

陈孟元. 鼠类脑细胞导航机理的移动机器人仿生SLAM综述[J]. 智能系统学报, 2018, 13(1): 107-117. CHEN Mengyuan. Overview of mobile robot bionic slam based on navigation mechanism of mouse brain cells[J]. CAAI Transactions on Intelligent Systems, 2018, 13(1): 107-117. |

| [70] |

张潇. 基于RatSLAM的微惯性/视觉仿生导航算法研究[D]. 长沙: 国防科学技术大学, 2015. ZHANG Xiao. Research on micro-inertial/visual bionic navigation algorithm based on RatSLAM[D]. Changcha: National University of Defense Technology, 2015. |

| [71] |

MILFORD M J, WYETH G F. Mapping a suburb with a single camera using a biologically inspired SLAM system[J]. IEEE Transactions on Robotics, 2008, 24(5): 1038-1053. DOI:10.1109/TRO.2008.2004520 |

| [72] |

MILFORD M, WYETH G. Persistent navigation and mapping using a biologically inspired SLAM system[J]. The International Journal of Robotics Research, 2010, 29(9): 1131-1153. DOI:10.1177/0278364909340592 |

| [73] |

LIU Yanqing, ZHU Dongchen, PENG Jingquan, et al. Real-time robust stereo visual SLAM system based on bionic eyes[J]. IEEE Transactions on Medical Robotics and Bionics, 2020, 2(3): 391-398. DOI:10.1109/TMRB.2020.3011981 |

| [74] |

蒋晓军. 基于鼠脑海马的情景认知地图构建及导航方法研究[D]. 北京: 北京工业大学, 2018. JIANG Xiaojun. Research on the construction of situational cognitive map and navigation method based on rat brain horse[D]. Beijing: Beijing University of Technology, 2018. |

| [75] |

LI Junjun, LI Zhijun, CHEN Fei, et al. Combined sensing, cognition, learning, and control for developing future neuro-robotics systems: a survey[J]. IEEE Transactions on Cognitive and Developmental Systems, 2019, 11(2): 148-161. DOI:10.1109/TCDS.2019.2897618 |

| [76] |

焦李成, 侯彪, 唐旭. 人工智能、类脑计算与图像解译前沿[M]. 西安: 西安电子科技大学出版社, 2020. JIAO Licheng, HOU Biao, TANG Xu. Frontier of artifical intelligence, brain-like computation, and image processing[M]. Xi'an: Xidian University Press, 2020. |

| [77] |

毛军, 付浩, 褚超群, 等. 惯性/视觉/激光雷达SLAM技术综述[J]. 导航定位与授时, 2022, 9(4): 17-30. MAO Jun, FU Hao, CHU Chaoqun, et al. A review of simultaneous localization and mapping based on inertial-visual-LiDAR fusion[J]. Navigation Positioning and Timing, 2022, 9(4): 17-30. |

| [78] |

张继贤, 刘飞, 王坚. 轻小型无人机测绘遥感系统研究进展[J]. 遥感学报, 2021, 25(3): 708-724. ZHANG Jixian, LIU Fei, WANG Jian. Review of the light-weighted and small UAV system for aerial photography and remote sensing[J]. Journal of Remote Sensing, 2021, 25(3): 708-724. |

| [79] |

宋红霞, 张继贤, 韩文立, 等. 基于移动测量系统的导航电子地图质检方法研究[J]. 测绘地理信息, 2021, 46(2): 83-87. SONG Hongxia, ZHANG Jixian, HAN Wenli, et al. Quality inspection of navigation electronic map based on mobile mapping system[J]. Journal of Geomatics, 2021, 46(2): 83-87. |

| [80] |

NEWCOMBE R A, IZADI S, HILLIGES O, et al. KinectFusion: real-time dense surface mapping and tracking[C]//Proceedings of the 10 th IEEE International Symposium on Mixed and Augmented Reality. Basel: IEEE, 2012: 127-136.

|

| [81] |

党宇, 张继贤, 邓喀中, 等. 基于深度学习AlexNet的遥感影像地表覆盖分类评价研究[J]. 地球信息科学学报, 2017, 19(11): 1530-1537. DANG Yu, ZHANG Jixian, DENG Kazhong, et al. Study on the evaluation of land cover classification using remote sensing images based on AlexNet[J]. Journal of Geo-Information Science, 2017, 19(11): 1530-1537. |

| [82] |

张继贤, 顾海燕, 杨懿, 等. 高分辨率遥感影像智能解译研究进展与趋势[J]. 遥感学报, 2021, 25(11): 2198-2210. ZHANG Jixian, GU Haiyan, YANG Yi, et al. Research progress and trend of high-resolution remote sensing imagery intelligent interpretation[J]. Journal of Remote Sensing, 2021, 25(11): 2198-2210. |

| [83] |

杨启帆, 李志茹, 马宏忠, 等. 无人机蜂巢综合系统设计及应用[J]. 机械研究与应用, 2020, 33(6): 167-169. YANG Qifan, LI Zhiru, MA Hongzhong, et al. The UAV honeycomb empowers power inspection[J]. Mechanical Research & Application, 2020, 33(6): 167-169. |