2. 人工智能与数字经济广东省实验室(深圳), 广东 深圳 518060;

3. 武汉大学测绘遥感信息工程国家重点实验室, 湖北 武汉 430079

2. Guangdong Laboratory of Artificial Intelligence and Digital Economy (Shenzhen), Shenzhen 518060, China;

3. State Key Laboratory of Information Engineering in Surveying, Mapping and Remote Sensing, Wuhan University, Wuhan 430079, China

无人机具有高时效性、高灵活性和数据采集的高分辨率等特性,已成为摄影测量和计算机视觉领域的重要遥感平台[1-2]。集成普通相机的无人机倾斜摄影系统可获取多视角的高分辨率影像,实现精细三维模型重建,在输电线路巡检、考古现场挖掘及智慧农业等领域得到了广泛应用[3-4]。由于有限的载荷限制,无人机平台往往没有集成高精度的POS(positioning and orientation system)系统,其应用很大程度依赖精确影像定位定向。鉴于不依赖未知数初值和高精度平差处理能力,增量式运动恢复结构(structure from motion,SfM)是当前无人机影像定位定向的关键技术[5-6],其处理流程包括影像匹配和几何解算两个部分。其中,特征匹配的目的是找到两视或多视影像的同名点,包括特征提取、特征匹配和粗差剔除3个步骤。特征匹配是SfM几何解算的基础,决定其精度和稳健性。

在摄影测量和计算机视觉领域,特征匹配得到了广泛关注,从早期的角点检测算子(Harris角点)到最近的尺度不变特征变换SIFT算子[7]及变体(RootSIFT[8]和DSPSIFT[9])。由于对尺度、旋转、光照变化,以及视角变化的高容忍度,SIFT算法成为学术界和工业界最受欢迎的宽基线图像匹配方法之一。为了应对航空影像的特点和提高局部特征的性能,摄影测量和遥感领域的学者也提出了SIFT算法的改进方案,比如处理大幅面航空影像的L2-SIFT[10]和提高特征点分布均匀性的AB-SIFT[11]。除了这类手工特征,近年来也涌现出大量数据驱动的深度学习特征[12-13]。根据网络模型的关注点,现有深度学习模型可分为3类。第1类模型利用卷积神经网络(convolutional neural network, CNN)强大的表征学习能力[14],计算关键点局部影像块的强可区分性特征描述子,包括早期的浅层网络模型TFeat[15],到最近的深层网络模型L2-Net[16]、HardNet[17]和GeoDesc[18]等。第2类模型直接处理输入影像对,并检测关键点和生成描述子,实现特征检测子和描述子的端到端学习。典型的网络模型包括自监督学习模型SuperPoint[19],先描述再检测模型D2-Net[20],及其改进模型ASLFeat[21]等。除了上述聚焦于特征提取的模型,第3类模型则主要解决特征匹配和粗差剔除。与经典最近邻匹配策略不用,这类深度学习模型聚合了更多上下文信息,可以提高特征匹配的数量和可靠性。经典模型包括基于注意力机制的SuperGlue[22]和基于密集预测的LoFTR[23]。

当前,深度学习特征在公开数据集上表现出比手工特征更好的性能,但是其用于无人机影像SfM三维重建的性能依然有待检验,主要原因包括:①这类深度学习模型往往采用计算机视觉近景图片训练,比如HPatches数据集[24],模型的泛化性需要验证;②现有评价指标聚焦在影像块验证和分类,与图像匹配的目的本质上不同;③特征匹配只是SfM三维重建的一个环节,其单独评价指标并不能保证SfM三维重建性能。因此,本文在研究典型深度学习网络模型的基础上,利用无人机影像的特征匹配和SfM三维重建指标进行性能评估,以分析深度学习特征对于无人机影像SfM三维重建的有效性。

1 对比方法根据网络的主要功能,本文选择6个典型的网络模型进行无人机影像特征匹配和SfM三维重建性能评价。选择的6个模型包括面向影像块描述的L2-Net、HardNet和GeoDesc,面向影像对特征检测和描述的D2-Net和ASLFeat,以及面向特征点匹配的SuperGlue。同时,本文选择了RootSIFT作为经典手工算法。

1.1 手工特征RootSIFT经典的SIFT匹配算法利用影像灰度梯度直方图统计进行特征描述,并基于描述子欧氏距离最近准则实现特征匹配。RootSIFT对SIFT特征进行扩展,使用平方根内核代替欧氏距离,度量SIFT描述子的相似性。试验结果表明,RootSIFT的匹配性能优于SIFT[8]。因此,本文选择RootSIFT作为手工特征提取和匹配的评估基准。

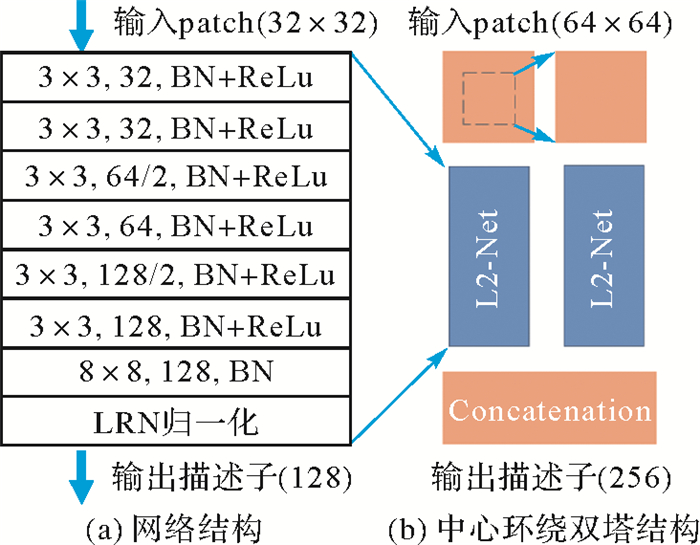

1.2 深层神经网络L2-NetL2-Net网络[16]共由7个卷积层组成(图 1),所有卷积层采用padding补0(除最后一层卷积)以保证图像尺寸不变。为了保证描述符的性能,网络采用步距为2的空洞卷积实现影像降采样。除最后一层无激活层外,每个卷积层后接ReLU函数和BN(batch normalization)层,并且BN层的参数在训练过程中不变。网络最后使用LRN(local response normalization)层输出128维的特征向量。在训练数据构建时随机加入部分学习过的数据,让网络有机会回顾已经学过的内容。训练中的负样本来自正样本输出的描述符距离矩阵,且所有非对角线元素作为负样本。L2-Net的损失函数包含3个误差项:描述符相似度、描述符紧凑度和中间特征图相似度;在度量描述子相似性时,使用相对距离划分匹配和不匹配的图像块对。另外,为了学习多尺度特性,L2-Net也提供了中心环绕双塔结构,输出256维特征向量。

|

| 图 1 L2-Net网络结构及中心环绕双塔结构 Fig. 1 Network structure of L2-Net and its central-surround structure with two towers |

1.3 难负样本挖掘网络HardNet

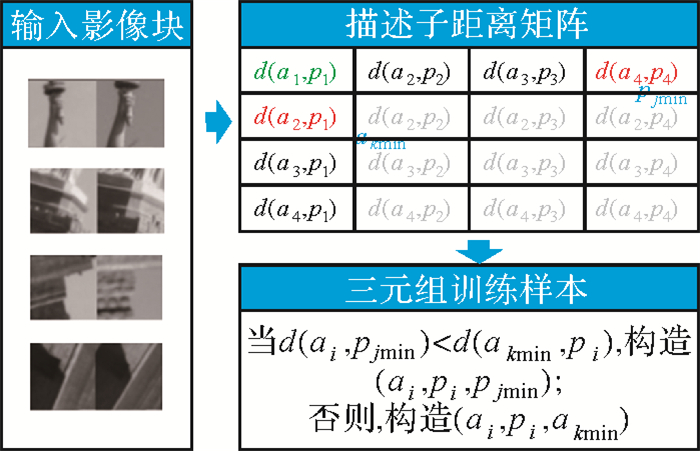

除了网络模型设计,训练样本采样和Loss函数设计直接决定了网络模型的学习性能。早期的深度网络常采用影像块对{p1, p2, l}和对比度损失函数(contrastive loss)实现对远距离正样本和近距离负样本惩罚。然而,大部分负样本距离明显大于正样本,导致网络无法高效学习高可区分的特征描述。受到SIFT匹配中比值测试启发,HardNet[17]提出难负样本采样(hard negative sampling)和三元组边界损失函数(triplet margin loss),如图 2所示。与L2-Net类似,HardNet根据正样本对构建的描述符距离矩阵,为每个正样本对{ai, pi}选择一个距离最小的负样本ni,即最难区分的非匹配对,构建三元组样本{ai, pi, ni}。然后,利用三元组边界损失函数进行网络训练,其目的是增加网络对正样本及其对应最难区分负样本对之间的相对距离,进一步提升网络区分正负样本的判别能力。HardNet采用L2-Net的网络架构。

|

| 图 2 HardNet难负样本采样策略 Fig. 2 Hard negative sampling for HardNet |

1.4 几何约束网络GeoDesc

为了提高深度学习描述子在三维重建任务中的性能,GeoDesc[18]集成了多视图重建的几何约束,从训练样本生成、采样到loss函数设计3个方面提升网络的学习和泛化能力。采用传统SfM三维重建方法建立三维物方点及其关联二维影像块的对应关系,并对得到的三维点采用Delaunay三角剖分方法过滤错误匹配点,将保留的三维点及其二维影像块作为训练样本。GeoDesc进一步设计了影像块对的几何相似度和影像对的几何相似度,用来量化影像块对匹配的难易程度,以便选取对网络训练更有用的样本。GeoDesc的损失函数包含两项:结构损失函数和几何损失函数。其中,结构损失函数能够保证非匹配点到匹配点的距离足够远;几何损失函数保证匹配点的描述子足够近。GeoDesc采用L2-Net的网络结构。

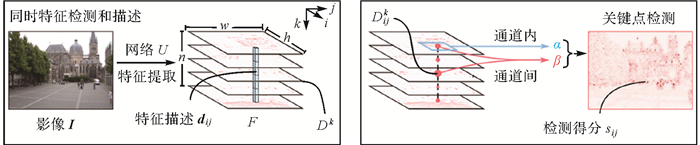

1.5 同时检测描述网络D2-Net由于特征检测子所依赖的局部底层信息(比如影像灰度)受到环境光照变化的影响明显,导致传统先检测再描述特征提取算法的可重复性显著降低。为此,D2-Net网络[20]采用同时检测描述的思路进行特征提取(图 3),其最大的特点是“一图两用”,即网络生成的特征图既代表特征检测结果又代表特征描述结果。对于输入CNN网络U的影像I,可得到3D特征图F=U(I), F∈Rh×w×n。其中n是特征图的通道数;h×w是特征图的高和宽。因此,从通道维度看,F可看作h×w个n维特征向量dij;从空间维度看,F可看作n个特征检测子输出的响应图Dk。为了实现特征点提取,D2-Net设计了类似SIFT关键点检测方法,即从空间维度和通道维度同时计算像素点的检测得分sij。D2-Net采用VGG16网络conv4_3前的部分,并在triplet margin ranking loss基础上加入了提升特征点检测可重复性的优化目标:利用检测得分对triplet loss加权,保证显著性描述子具有更高的检测得分。D2-Net在网络训练时使用了低分辨率特征图,测试时将分辨率提升到原图的1/4,以提高特征定位能力。

|

| 图 3 D2-Net同时检测描述策略 Fig. 3 Detect-and-describe strategy in D2-Net |

1.6 特征精确定位网络ASLFeat

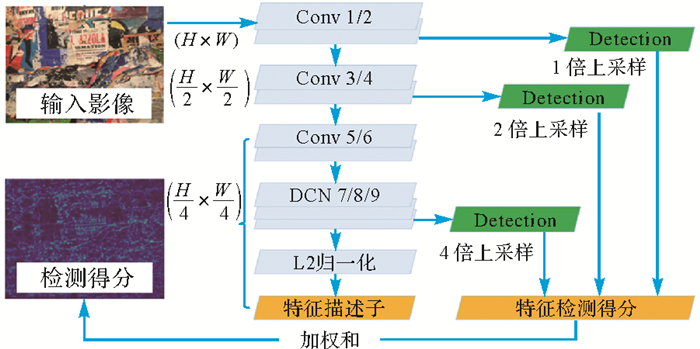

现有端到端学习的特征检测和描述网络忽略了特征点支撑域几何变形和定位精度低的问题,导致深度特征难以用于影像配准、三维重建等高精度几何应用。因此,在D2-Net提出的同时检测描述网络模型的基础上,ASLFeat[21]针对上述两个问题进行优化(图 4)。对于特征点支撑域几何变形的问题,提出利用可变形卷积网络(deformable convolutional network, DCN)学习预测特征点局部区域的几何变换,得到具有视角不变的特征点支撑域。考虑到影像局部区域几何变形的有限复杂度,ASLFeat分别利用相似、仿射和单应变换约束局部几何变形。对于特征点定位精度低的问题,ASLFeat提出利用卷积网络内在的金字塔分层特征,实现多尺度的特征点检测,避免D2-Net在低分辨率特征图上特征检测所造成的低定位精度。另外,ASLFeat采用L2-Net的轻量化网络:仅将L2-Net最后的8×8卷积层替换为3个3×3的DCN卷积层,并利用第2、4和9层输出的特征图实现多尺度特征检测。

|

| 图 4 ASLFeat网络架构 Fig. 4 Network structure for ASLFeat |

1.7 可靠特征匹配网络SuperGlue

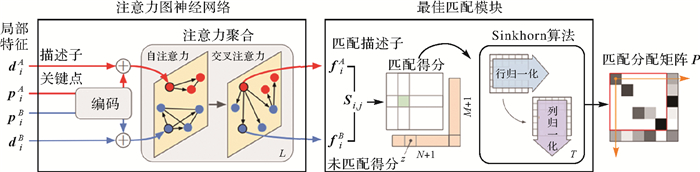

与现有大部分网络聚焦于特征点检测和描述所不同,SuperGlue[22]利用神经网络学习如何进行特征匹配。其基本出发点是:网络模型可以学习提取高可重复性、高可区分性的特征点。但是,弱纹理区域或重复结构往往导致常规的特征匹配策略并不能得到足够数量的匹配点,比如结合描述子欧氏距离和比值测试的匹配策略。受到Transformer和图匹配思想的启发,SuperGlue提出结合注意力机制和图神经网络的深度学习匹配方法,如图 5所示。整个网络架构包括注意力图神经网络和最佳匹配模块。其中,注意力图神经网络模拟人寻找匹配点的过程:将输入的关键点pi=(x, y, c)和描述子di编码为高维向量,并迭代利用自注意力和交叉注意力增强描述子的匹配性能,得到模块输出的匹配描述子fi。最佳匹配模块则模拟图匹配过程:利用匹配描述子fi构造匹配得分矩阵,将特征匹配问题转化为最优传输问题,并基于Sinkhorn算法迭代求解最佳的匹配分配矩阵P(其行列元素和为1),实现特征点匹配。

|

| 图 5 注意力图神经网络SuperGlue架构 Fig. 5 The framework of attentional GNN based SuperGlue |

2 验证框架与评价指标 2.1 验证框架

本文设计图 6所示融合深度特征的SfM验证框架。对于输入无人机影像,首先进行特征提取和匹配,得到可靠同名点;然后,基于SfM进行三维重建处理,生成影像位姿和三维点。根据上述网络的不同功能在特征提取和匹配阶段进行不同处理。其中,影像块描述网络仅生成特征点局部patch的描述子。特征检测描述网络的输入为影像对,无须依赖手工特征提取模块。特征匹配网络的输入为手工算法或网络模型提取的特征点及其描述子。

|

| 图 6 融合深度特征的SfM验证框架 Fig. 6 Learned feature embedded SfM framework |

上述验证框架的关键步骤为:①利用RootSIFT算法提取特征点,并将生成的影像块作为影像块描述网络的输入或将特征点及其对应描述子作为特征匹配网络的输入。RootSIFT是SIFT算法的改进,使用平方根内核代替标准欧氏距离测度,研究表明其性能优于SIFT。②无人机影像数据量大一方面导致穷举匹配高计算代价,另一方面不便于算法对比分析。本文利用Oxford 5k数据集[25]训练词汇树,并基于影像检索技术生成每张影像最相似的20张影像,作为影像对选择结果。③在检索影像对的引导下,对于第1类和第2类网络基于描述子欧氏距离最近测度(nearest neighbor,NN)进行特征匹配,并结合比值测试和交叉验证剔除粗差。然后,利用RANSAC的基本矩阵估计进行优化,得到最终匹配结果。为了保证SfM三维重建精度,RANSAC的外点阈值为1个像素。④得到的同名点作为SfM输入,进行影像位姿和三维点平差解算。本文选择COLMAP[26]作为SfM平差模块。

2.2 评价指标本文选择特征匹配和SfM三维重建的关键技术指标作为对比方法的评价指标,见表 1。这些评价指标主要分为3类,分别代表特征提取和匹配、SfM三维重建和算法效率对比,可评估算法在上述验证框架中的处理性能。通过使用这些评价指标,可以综合评估特征提取与匹配的性能、SfM三维重建的完整性和精度。

| 类别 | 名称 | 说明 |

| 1 | 影像匹配对 | 特征匹配内点数大于15的图像对数量 |

| 内点率 | 内点数与初始匹配数的比值 | |

| 匹配率 | 匹配点数与提取特征数的比值 | |

| 2 | 连接影像数 | SfM三维重建后连接影像数量 |

| 稀疏三维点 | SfM三维重建后的三维点数量 | |

| 重投影误差 | BA平差的RMSE(单位:像素) | |

| 3 | 时间消耗 | 单张影像特征提取和匹配的时间消耗 |

3 试验与结果分析 3.1 试验数据

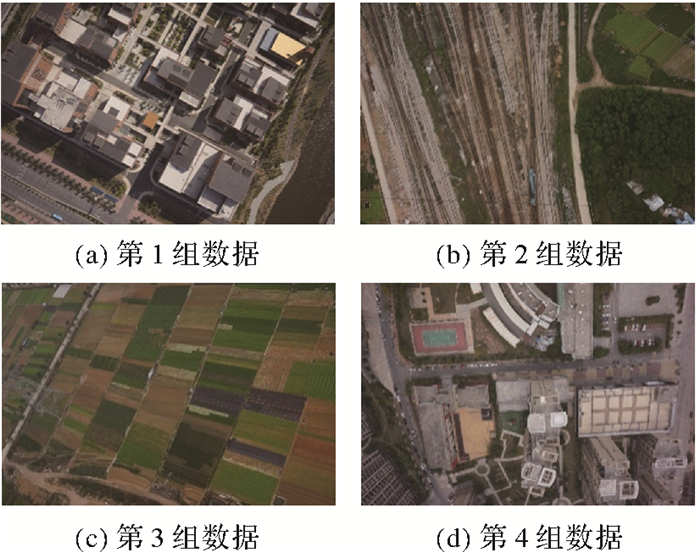

试验数据包含4组多旋翼无人机影像。第1组数据包含低矮建筑和裸地,如图 7(a)所示。在300 m飞行高度下,采用分辨率为7360×4912像素的索尼ILCE-7R相机,共采集了157张影像,其地面采样间隔(ground sampling distance,GSD)约为4.2 cm。第2组数据来自城市郊区,包含交叉的铁轨,如图 7(b)所示。采用一架搭载SONY RX1R双相机倾斜摄影系统的多旋翼无人机,在165 m飞行高度下,共采集320张分辨率为6000×4000像素的影像,其GSD为5.1 cm。第3组数据沿着输电线路进行采集,如图 7(c)所示,采用双相机倾斜成像系统采集了390张影像。第4组数据来自城区住宅区,如图 7(d)所示。使用五镜头倾斜摄影系统,在175 m飞行高度采集了750张影像,分辨率为6000×4000像素,GSD为4.3 cm。

|

| 图 7 4组试验数据示例影像 Fig. 7 Illustration images of the four datasets |

对于上述待评估的网络模型,本文直接使用开放的预训练模型,不再对其进行重新训练。主要原因包括3个方面:①现有的基准数据集,比如Brown,能够反映宽基线无人机影像的特点,包括视角差异和光照变化;②部分预训练模型采用无人机数据集训练,比如基于GL3D数据集的GeoDesc;③不同网络模型依赖不同的训练数据类型,比如Patch数据集和图像数据集。所有待评估模型均使用默认参数。另外,本文试验在CPU为3.6 GHz Intel Core i7-7700,显卡为8 GB NVIDIA GeForce GTX 1080的Windows系统开展。

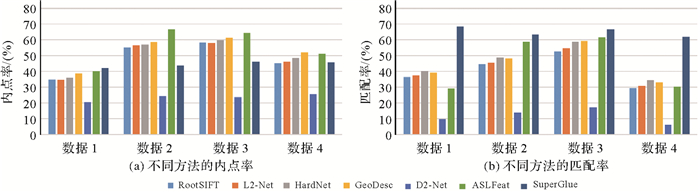

3.2 特征匹配本文分析网络模型在特征匹配方面的性能。对于每组无人机影像,利用RooSIFT算法提取特征点,并基于词汇树检索获取每张影像最相似的20张影像,组成影像匹配对,用于引导后续特征匹配。表 2统计了特征匹配结果。其中,最佳性能分别用红色、绿色和蓝色突出。图 8是不同方法内点率和匹配率的对比图。

| 算法 | 影像匹配对数 | 内点率/(%) | 匹配率/(%) | |||||||||||

| 数据1 | 数据2 | 数据3 | 数据4 | 数据1 | 数据2 | 数据3 | 数据4 | 数据1 | 数据2 | 数据3 | 数据4 | |||

| RootSIFT | 1317 | 3129 | 3338 | 5794 | 34.8 | 55.2 | 58.2 | 45.1 | 36.3 | 44.4 | 52.4 | 29.4 | ||

| L2-Net | 1336 | 3140 | 3420 | 5899 | 34.6 | 56.6 | 57.8 | 46.1 | 37.3 | 45.3 | 54.4 | 30.7 | ||

| HardNet | 1430 | 3190 | 3507 | 6147 | 35.9 | 56.9 | 59.6 | 48.4 | 40.1 | 48.8 | 58.8 | 34.1 | ||

| GeoDesc | 1418 | 3218 | 3517 | 6103 | 38.9 | 58.6 | 61.4 | 51.9 | 39.2 | 48.3 | 59.3 | 33.1 | ||

| D2-Net | 852 | 1448 | 1634 | 3385 | 20.5 | 24.2 | 23.7 | 25.8 | 9.8 | 13.7 | 17.0 | 6.0 | ||

| ASLFeat | 1060 | 2134 | 2363 | 4859 | 39.9 | 66.8 | 64.4 | 51.1 | 29.2 | 58.7 | 61.6 | 30.3 | ||

| SuperGlue | 1301 | 2178 | 2493 | 5309 | 42.0 | 43.6 | 46.3 | 45.6 | 68.4 | 63.3 | 66.8 | 61.9 | ||

|

| 图 8 不同方法的内点率和匹配率对比 Fig. 8 Illustration of inlier and matching ratios |

试验结果表明,以RooSIFT为手工特征匹配基准,L2-Net、HardNet和GeoDesc所代表的影像块描述网络均能提升特征匹配性能,其表现在提高影像匹配对、内点率和匹配率3项指标。HardNet和GeoDesc均采用L2-Net网络架构,并在此基础上分别增加难负样本采样策略和顾及几何约束的损失函数设计,其在内点率和匹配率方面的性能也是逐步提升。对于4组试验数据,内点率和匹配率最大提升分别达到了6.8%和6.9%。

另外,D2-Net和ASLFeat的网络输入为影像对,实现联合特征检测和描述。但是由于在1/4原始影像分辨率的特征图上进行关键点检测,导致D2-Net特征点的定位精度低,在3项评价指标上均远低于其他对比方法。进而,ASLFeat采用多尺度特征检测来提升特征点的定位精度,获得所有对比方法的最佳性能。4组数据的内点率分别提升至39.9%、66.8%、64.4%和51.1%。尽管采用可变性卷积网络DCN提升描述子的仿射不变性,但是ASLFeat依然不能很好地处理大倾角无人机影像,其最直接的表现是在数据1和数据4上的匹配率分别为29.2%和30.3%,明显低于RootSIFT和3个影像块描述网络。

对于SuperGlue所代表的特征匹配网络,能够利用全局上下文信息区分正确和错误匹配点,显著地提升了4组数据的匹配率,分别达到了68.4%、63.3%、66.8%和61.9%。对于影像匹配对和内点率两项指标,SuperGlue在数据1和数据4上能够达到与RootSIFT相当的性能。但是,对于数据2和数据3,其性能缺显著降低。本文认为数据2和数据3属于纹理和结构都相似的场景,给SuperGlue的特征提取和匹配造成困难。

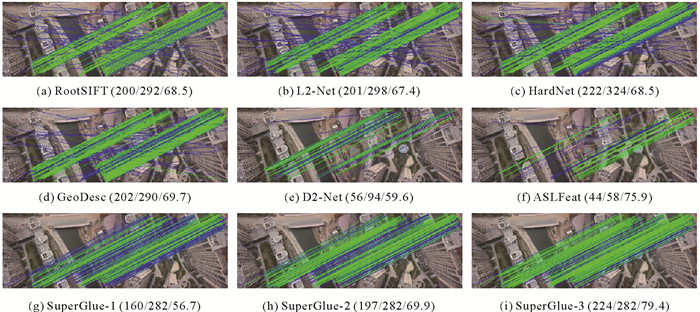

为了进一步分析不同方法的特征匹配性能,选取数据4中的两个影像对进行特征匹配,并统计了内点数、初始匹配数和内点率3个评价指标。试验结果如图 9和图 10所示。其中,正确匹配和错误匹配分别利用绿线和蓝线表示。第1个影像对视角差异较小。可以看出,RootSIFT与L2-Net,HardNet和GeoDesc的性能相当;由于仅利用欧氏距离测度,这4类方法的初始匹配包含了大量的错误匹配。采用联合特征检测和描述模型,D2-Net和ASLFeat可以显著减少错误匹配。但是,受限于特征点定位精度和对于大倾角透视变形的影响,导致提取的匹配点数量显著降低,如图 9(e)和(f)所示。相反,SuperGlue可以显著减少明显错误匹配点,如图 9(g)所示。考虑到SuperGlue采用SuperPoint进行特征提取,仅具有像素级的特征点定位精度。本文进一步设定RANSAC的外点阈值为2、3个像素进行匹配,其内点率快速提升至69.9%和79.4%。可以看出,SuperGlue的特征匹配策略能够显著提升匹配内点率。但是,当影像对视角差异较大时,联合特征检测描述网络和特征匹配网络的性能显著下降,直接导致无法得到匹配点,如图 10(e)—(i)所示。这也导致D2-Net,ASLFeat和SuperGlue获取的影像匹配对数量相对较少,见表 2。

|

| 图 9 特征匹配对比结果(内点数/初始匹配数/内点率) Fig. 9 The result of feature matching (inlier number/initial match number/inlier ratio) |

|

| 图 10 特征匹配对比结果(内点数/初始匹配数/内点率) Fig. 10 The result of feature matching (inlier number/initial match number/inlier ratio) |

3.3 SfM重建

利用上述匹配结果,本文进一步分析不同特征提取和匹配方法对SfM三维重建的影响。表 3统计了不同方法在SfM三维重建的完整性和精度方面的评价指标。试验结果表明,在考虑连接影像数时,基于RootSIFT手工特征的匹配方法,包括L2-Net、HardNet和GeoDesc能够重建更多的影像;与特征匹配类似,这类方法的性能也逐渐提升。由于特征点定位精度低或对大视角变形敏感等原因,D2-Net和ASLFeat重建的影像数最少,特别是数据1和数据4。受到重建影像数影响,对比方法在稀疏三维点方面的表现类似。其中,HardNet和GeoDesc整体上性能最优。值得注意的是,对于数据1和数据4,由于具有最高的匹配率,SuperGlue生成稀疏三维点数量明显多余其他方法,相比次优结果增幅达到41.6%和71.9%。

| 方法 | 连接影像数 | 稀疏三维点数 | 重投影误差/像素 | |||||||||||

| 数据1 | 数据2 | 数据3 | 数据4 | 数据1 | 数据2 | 数据3 | 数据4 | 数据1 | 数据2 | 数据3 | 数据4 | |||

| RootSIFT | 157 | 281 | 386 | 750 | 85 888 | 186 819 | 285 249 | 276 428 | 0.96 | 0.89 | 0.66 | 0.97 | ||

| L2-Net | 157 | 293 | 387 | 750 | 88 626 | 195 142 | 298 311 | 308 465 | 0.97 | 0.88 | 0.66 | 1.01 | ||

| HardNet | 157 | 295 | 387 | 750 | 97 009 | 210 262 | 321 728 | 348 320 | 1.00 | 0.91 | 0.69 | 1.05 | ||

| GeoDesc | 157 | 297 | 390 | 750 | 93 462 | 204 797 | 321 396 | 337 234 | 0.99 | 0.91 | 0.69 | 1.05 | ||

| D2-Net | 48 | 119 | 87 | 152 | 20 307 | 88 927 | 41 953 | 49 935 | 1.35 | 1.39 | 1.33 | 1.35 | ||

| ASLFeat | 48 | 277 | 24 | 229 | 16 260 | 193 872 | 164 712 | 66 761 | 0.93 | 1.00 | 1.01 | 1.05 | ||

| SuperGlue | 157 | 281 | 234 | 750 | 137 378 | 205 246 | 164 051 | 598 830 | 0.96 | 1.10 | 0.98 | 1.19 | ||

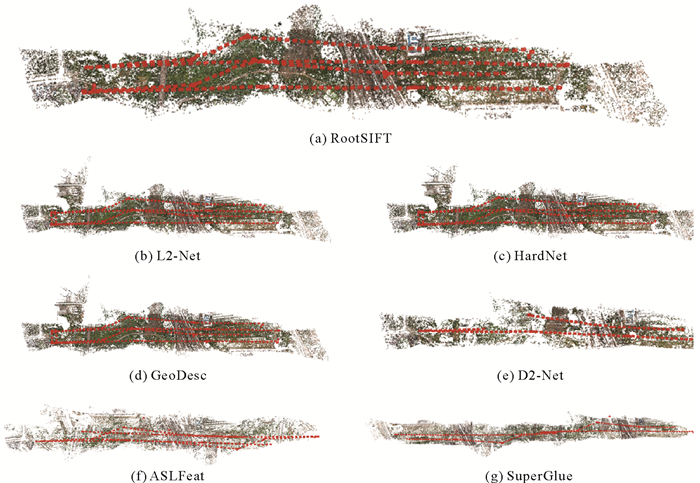

考虑重投影误差指标,得益于RootSIFT的高精度定位能力,L2-Net、HardNet和GeoDesc的重投影误差基本上达到1个像素的精度,特别是对于倾角较小的数据2和数据3。与特征匹配类似,D2-Net的精度最低,4组试验数据的重投影误差均大于1.3像素。另外,基于多尺度特征点检测,ASLFeat和SuperGlue的SfM三维重建精度相当。对于数据2数据,图 11显示了基于不同方法特征匹配点的SfM三维重建结果。

|

| 图 11 SfM三维重建结果 Fig. 11 SfM-based 3D reconstruction |

3.4 效率对比

本文进一步分析了各个算法特征提取和匹配的时间消耗,统计结果如表 4所示。其中,RootSIFT、D2-Net和ASLFeat的特征提取时间包括关键点检测和描述子生成;由于输入影像块,L2-Net、HardNet和GeoDesc的特征提取时间仅涉及描述子生成;SuperGlue输入特征点和描述子,没有对应的特征提取时间。另外,除了SuperGlue通过网络学习特征匹配,其余算法则基于描述子最近测度进行匹配。结果表明,由于采用SIFTGPU加速库,RootSIFT的特征提取效率最高。联合特征检测描述网络D2-Net和ASLFeat的时间消耗更高。对于特征匹配效率,D2-Net的描述子维度为512,导致时间消耗高于其他算法。另外,SuperGlue采用网络学习特征匹配,其单张影像匹配时间消耗达到34.01 s。由此可见,与深度学习模型相比,RootSIFT的效率能够更好满足高分辨无人机影像处理需求。

| 算法 | 特征提取 | 特征匹配 |

| RootSIFT | 0.51 | 1.08 |

| L2-Net | 0.82 | 1.13 |

| HardNet | 1.06 | 1.09 |

| GeoDesc | 1.21 | 1.04 |

| D2-Net | 3.18 | 5.57 |

| ASLFeat | 1.53 | 1.05 |

| SuperGlue | - | 34.01 |

4 结论

本文以经典手工特征RooSIFT为基准,深入研究了最新提取出的深度学习网络模型,涵盖影像块描述网络、联合特征检测描述网络和特征匹配网络3个类别。同时,利用4组无人机数据集,从特征匹配和SfM三维重建两个方面对比和分析了所选取的6个代表性网络。结果表明,与手工特征相比,深度学习网络模型能够提取具有更高重复性、区分性的特征描述子;结合手工特征的高精度定位和深度学习的特征描述能力,可实现更准确和完整的特征匹配,取得与SIFT等手工特征相当,甚至更优的性能。尽管当前的研究集中在端到端网络架构设计,以实现联合特征检测和描述。但是,这类网络依然存在关键点定位精度低的问题,导致影像匹配和SfM重建精度差。因此,后续研究将需要进一步提高特征点的定位精度。此外,本文使用预训练模型进行性能评估,以验证网络模型对无人机影像的泛化能力。为了进一步提升性能,后续将考虑构建无人机训练集对模型进行微调。

| [1] |

JIANG San, JIANG Wanshou, WANG Lizhe. Unmanned aerial vehicle-based photogrammetric 3D mapping: a survey of techniques, applications, and challenges[J]. IEEE Geoscience and Remote Sensing Magazine, 2022, 10(2): 135-171. DOI:10.1109/MGRS.2021.3122248 |

| [2] |

陈武, 姜三, 李清泉, 等. 无人机影像增量式运动恢复结构研究进展[J]. 武汉大学学报(信息科学版), 2022, 47(10): 1662-1674. CHEN Wu, JIANG San, LI Qingquan, et al. Recent research of incremental structure from motion for unmanned aerial vehicle images[J]. Geomatics and Information Science of Wuhan University, 2022, 47(10): 1662-1674. |

| [3] |

JIANG San, JIANG Wanshou, HUANG Wei, et al. UAV-based oblique photogrammetry for outdoor data acquisition and offsite visual inspection of transmission line[J]. Remote Sensing, 2017, 9(3): 278. DOI:10.3390/rs9030278 |

| [4] |

ZHENG J, FU H, LI W, et al. Growing status observation for oil palm trees using unmanned aerial vehicle (UAV) images[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2021, 173: 95-121. DOI:10.1016/j.isprsjprs.2021.01.008 |

| [5] |

姜三, 许志海, 张峰, 等. 面向无人机倾斜影像的高效SfM重建方案[J]. 武汉大学学报(信息科学版), 2019, 44(8): 1153-1161. JIANG San, XU Zhihai, ZHANG Feng, et al. Solution for efficient SfM reconstruction of oblique UAV images[J]. Geomatics and Information Science of Wuhan University, 2019, 44(8): 1153-1161. |

| [6] |

张力, 刘玉轩, 孙洋杰, 等. 数字航空摄影三维重建理论与技术发展综述[J]. 测绘学报, 2022, 51(7): 1437-1457. ZHANG Li, LIU Yuxuan, SUN Yangjie, et al. A review of developments in the theory and technology of three-dimensional reconstruction in digital aerial photogrammetry[J]. Acta Geodaetica et Cartographica Sinica, 2022, 51(7): 1437-1457. DOI:10.11947/J.AGCS.2022.20220130 |

| [7] |

LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91-110. DOI:10.1023/B:VISI.0000029664.99615.94 |

| [8] |

ARANDJELOVIC R, ZISSERMAN A. Three things everyone should know to improve object retrieval[C]//Proceedings of 2012 IEEE Conference on Computer Vision and Pattern Recognition. New York: ACM Press, 2012: 2911-2918.

|

| [9] |

DONG Jingming, SOATTO S. Domain-size pooling in local descriptors: DSP-SIFT[C]//Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015: 5097-5106.

|

| [10] |

SUN Yanbiao, ZHAO Liang, HUANG Shoudong, et al. 2-SIFT: sift feature extraction and matching for large images in large-scale aerial photogrammetry[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014, 91: 1-16. DOI:10.1016/j.isprsjprs.2014.02.001 |

| [11] |

SEDAGHAT A, EBADI H. Remote sensing image matching based on adaptive binning SIFT descriptor[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(10): 5283-5293. DOI:10.1109/TGRS.2015.2420659 |

| [12] |

范大昭, 董杨, 张永生. 卫星影像匹配的深度卷积神经网络方法[J]. 测绘学报, 2018, 47(6): 844-853. FAN Dazhao, DONG Yang, ZHANG Yongsheng. Satellite image matching method based on deep convolution neural network[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(6): 844-853. DOI:10.11947/J.AGCS.2018.20170627 |

| [13] |

蓝朝桢, 卢万杰, 于君明, 等. 异源遥感影像特征匹配的深度学习算法[J]. 测绘学报, 2021, 50(2): 189-202. LAN Chaozhen, LU Wanjie, YU Junming, et al. Deep learning algorithm for feature matching of cross modality remote sensing images[J]. Acta Geodaetica et Cartographica Sinica, 2021, 50(2): 189-202. DOI:10.11947/J.AGCS.2021.20200048 |

| [14] |

JIN Yuhe, MISHKIN D, MISHCHUK A, et al. Image matching across wide baselines: from paper to practice[J]. International Journal of Computer Vision, 2021, 129(2): 517-547. DOI:10.1007/s11263-020-01385-0 |

| [15] |

BALNTAS V, RIBA E, PONSA D, et al. Learning local feature descriptors with triplets and shallow convolutional neural networks[C]//Proceedings of 2016 British Machine Vision Conference 2016. York: British Machine Vision Association, 2016: 3.

|

| [16] |

TIAN Yurun, FAN Bin, WU Fuchao. L2-net: deep learning of discriminative patch descriptor in euclidean space[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 661-669.

|

| [17] |

MISHCHUK A, MISHKIN D, RADENOVIĆ F, et al. Working hard to know your neighbor's margins: local descriptor learning loss[C]//Proceedings of the 31st International Conference on Neural Information Processing Systems. New York: ACM Press, 2017: 4829-4840.

|

| [18] |

LUO Zixin, SHEN Tianwei, ZHOU Lei, et al. GeoDesc: learning local descriptors by integrating geometry constraints[EB/OL]. [2023-12-30]. https://arxiv.org/abs/1807.06294.pdf.

|

| [19] |

DETONE D, MALISIEWICZ T, RABINOVICH A. SuperPoint: self-supervised interest point detection and description[C]//Proceedings of 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. Salt Lake City: IEEE, 2018: 224-236.

|

| [20] |

DUSMANU M, ROCCO I, PAJDLA T, et al. D2-net: a trainable CNN for joint description and detection of local features[C]//Proceedings of 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach: IEEE, 2019: 8092-8101.

|

| [21] |

LUO Zixin, ZHOU Lei, BAI Xuyang, et al. ASLFeat: learning local features of accurate shape and localization[C]//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020: 6589-6598.

|

| [22] |

SARLIN P E, DETONE D, MALISIEWICZ T, et al. SuperGlue: learning feature matching with graph neural networks[C]//Proceedings of 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle: IEEE, 2020: 4938-4947.

|

| [23] |

SUN Jiaming, SHEN Zehong, WANG Yuang, et al. LoFTR: detector-free local feature matching with transformers[C]//Proceedings of 2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville: IEEE, 2021: 8922-8931.

|

| [24] |

BALNTAS V, LENC K, VEDALDI A, et al. HPatches: a benchmark and evaluation of handcrafted and learned local descriptors[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 5173-5182.

|

| [25] |

PHILBIN J, CHUM O, ISARD M, et al. Object retrieval with large vocabularies and fast spatial matching[C]//Proceedings of 2007 IEEE Conference on Computer Vision and Pattern Recognition. Minneapolis: IEEE, 2007: 1-8.

|

| [26] |

SCHONBERGER J L, FRAHM J M. Structure-from-motion revisited[C]//Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 4104-4113.

|